비지도학습(Unsupervised Learning)이란?

지도학습과 달리 훈련 데이터(Training Data)로 정답(Label)이 없는 데이터가 주어지는 학습방법으로 정답을 알려주지 않기 때문에 데이터셋의 특징(Feature) 및 패턴을 기반으로 모델 스스로가 판단하는 학습과정을 말한다.

군집화(Clustering)

명확한 분류 기준이 없는 상황에서도 데이터들을 분석하여 가까운 것들끼리 묶어주는 작업

1. K-means

k값이 주어져 있을 때, 주어진 데이터들을 k개의 클러스터로 묶는 알고리즘으로 명확한 분류 기준이 없는 상태에서 임의로 k개의 그룹으로 뭉치고 k개의 기준점을 중심으로 가장 가까운 데이터들을 뭉치는 방식이다.

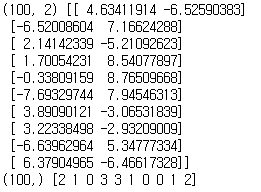

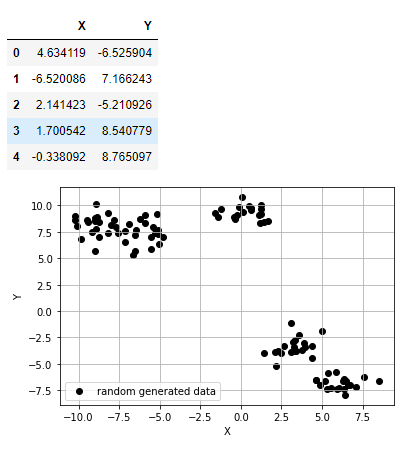

1-1) 모듈을 importa하고 5개의 중심점을 기준으로 무작귀 점 데이터를 100개 생성

%matplotlib inline from sklearn.datasets import make_blobs import pandas as pd import numpy as np import matplotlib.pyplot as plt import random # 중심점이 5개인 100개의 점 데이터를 무작위로 생성합니다. points, labels = make_blobs(n_samples=100, centers=5, n_features=2, random_state=135) print(points.shape, points[:10]) # 무작위로 생성된 점의 좌표 10개 출력 print(labels.shape, labels[:10]) # 10개의 점들이 각각 대응하는 중심점(label) 값 출력

📄Output

💡 ( Tip ) 비지도학습에는 정답(Label)이 없지만 K-means는 임의로 지정한 k개의 중심점이 새로운 정답 역할을 한다.

1-2) 위에서 생성한 좌표를 시각화

# 축 그리기 fig = plt.figure() ax = fig.add_subplot(1, 1, 1) # 위에서 생성한 점 데이터들을 pandas DataFrame 형태로 변환하기 points_df = pd.DataFrame(points, columns=['X', 'Y']) display(points_df.head()) # 점 데이터를 X-Y grid에 시각화하기 ax.scatter(points[:, 0], points[:, 1], c='black', label='random generated data') # 축 이름을 라벨에 달고, 점 데이터 그리기 ax.set_xlabel('X') ax.set_ylabel('Y') ax.legend() ax.grid()

📄Output

1-3) 생성한 데이터에 K-means 알고리즘 적용

💡 ( Tip ) K-means 알고리즘 순서

- 원하는 클러스터의 수(k)를 결정

- 무작위로 클러스터의 수와 같은 k개의 중심점(대표 클러스터)을 선정

- 나머지 점들과 모든 중심점 간의 유클리드 거리를 계산 후 가장 가까운 거리를 가지는 중심점의 클러스터에 배정

- 각 k개의 클러스터의 중심점을 재조정하고 특정 클러스터에 속하는 모든 점들의 평균값이 해당 클러스터의 다음 Iteration의 중심점이 된다.

- 재조정된 중심점을 바탕으로 모든 점들과 새로 조정된 중심점 간의 유클리드 거리를 다시 계산 후 가장 가까운 거리를 가지는 클러스터에 해당 점을 재배정

- 4번과 5번을 반복 수행 (반복 횟수는 사용자가 조절하고 특정 Iteration 이상이 되면 수렴(중심점이 더 이상 바뀌지 않음)하게 됨)

from sklearn.cluster import KMeans # 1), 2) 위에서 생성한 무작위 점 데이터(points)에 클러스터의 수(K)가 5인 K-means 알고리즘을 적용 kmeans_cluster = KMeans(n_clusters=5) # 3) ~ 6) 과정이 전부 함축되어 있는 코드입니다. points에 대하여 K가 5일 때의 K-means iteration을 수행 kmeans_cluster.fit(points) print(type(kmeans_cluster.labels_)) print(np.shape(kmeans_cluster.labels_)) print(np.unique(kmeans_cluster.labels_))

📄Output

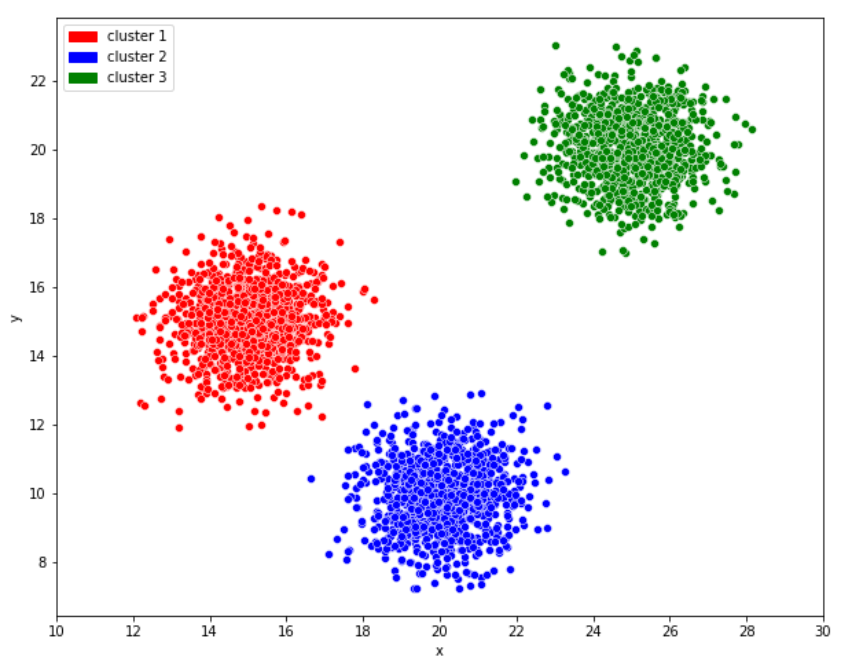

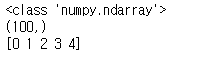

1-4) K-means 결과 시각화

# n 번째 클러스터 데이터를 어떤 색으로 도식할 지 결정하는 color dictionary color_dict = {0: 'red', 1: 'blue', 2:'green', 3:'brown', 4:'indigo'} # 점 데이터를 X-Y grid에 시각화합니다. fig = plt.figure() ax = fig.add_subplot(1, 1, 1) # K-means clustering의 결과대로 색깔별로 구분하여 점에 색칠한 후 도식 for cluster in range(5): cluster_sub_points = points[kmeans_cluster.labels_ == cluster] # 전체 무작위 점 데이터에서 K-means 알고리즘에 의해 군집화된 sub data를 분리합니다. ax.scatter(cluster_sub_points[:, 0], cluster_sub_points[:, 1], c=color_dict[cluster], label='cluster_{}'.format(cluster)) # 해당 sub data를 plot합니다. # 축 이름을 라벨에 달고, 점 데이터 그리기 ax.set_xlabel('X') ax.set_ylabel('Y') ax.legend() ax.grid()

📄Output

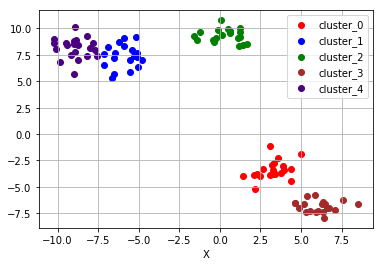

1-5) K-means 알고리즘이 잘 작동하지 않는 경우

아래와 같은 상황에서는 적합하지 않은 군집화가 이루어진다.

💡 ( Tip ) 군집의 개수(K 값)를 미리 지정해야 하기 때문에 이를 알거나 예측하기 어려운 경우에는 사용하기 어렵고 유클리드 거리가 가까운 데이터끼리 군집이 형성되기 때문에 데이터의 분포에 따라 유클리드 거리가 멀면서 밀접하게 연관되어 있는 데이터들의 군집화를 성공적으로 수행하지 못할 수 있다.# K-means algorithm이 잘 동작하지 않는 예시 (1) 원형 분포 from sklearn.datasets import make_circles # 원형 분포 데이터 생성 circle_points, circle_labels = make_circles(n_samples=100, factor=0.5, noise=0.01) # 원형 분포를 가지는 점 데이터 100개를 생성합니다. # 캔버스 생성 fig = plt.figure() ax = fig.add_subplot(1, 1, 1) # 원형 분포에 대해 K-means 수행 circle_kmeans = KMeans(n_clusters=2) circle_kmeans.fit(circle_points) color_dict = {0: 'red', 1: 'blue'} for cluster in range(2): cluster_sub_points = circle_points[circle_kmeans.labels_ == cluster] ax.scatter(cluster_sub_points[:, 0], cluster_sub_points[:, 1], c=color_dict[cluster], label='cluster_{}'.format(cluster)) ax.set_title('K-means on circle data, K=2') ax.set_xlabel('X') ax.set_ylabel('Y') ax.legend() ax.grid() # K-means algorithm이 잘 동작하지 않는 예시 (2) 달 모양 분포 from sklearn.datasets import make_moons # 달 모양 분포의 데이터 생성 moon_points, moon_labels = make_moons(n_samples=100, noise=0.01) # 달 모양 분포를 가지는 점 데이터 100개를 생성합니다. # 캔버스 생성 fig = plt.figure() ax = fig.add_subplot(1, 1, 1) # 달 모양 분포 데이터 plot moon_kmeans = KMeans(n_clusters=2) moon_kmeans.fit(moon_points) color_dict = {0: 'red', 1: 'blue'} for cluster in range(2): cluster_sub_points = moon_points[moon_kmeans.labels_ == cluster] ax.scatter(cluster_sub_points[:, 0], cluster_sub_points[:, 1], c=color_dict[cluster], label='cluster_{}'.format(cluster)) ax.set_title('K-means on moon-shaped data, K=2') ax.set_xlabel('X') ax.set_ylabel('Y') ax.legend() ax.grid() # K-means algorithm이 잘 동작하지 않는 예시 (3) 대각선 모양 분포 from sklearn.datasets import make_circles, make_moons, make_blobs # 대각선 모양 분포의 데이터 생성 diag_points, _ = make_blobs(n_samples=100, random_state=170) #대각선 분포를 가지는 점 데이터 100개를 생성합니다.(현재는 무작위 분포) transformation = [[0.6, -0.6], [-0.4, 0.8]] #대각선 변환을 위한 대각 행렬 diag_points = np.dot(diag_points, transformation) #본 과정을 통해 무작위 분포의 점 데이터를 대각선 분포로 변환합니다. # 캔버스 생성 fig = plt.figure() ax = fig.add_subplot(1, 1, 1) # 대각선 모양 분포 데이터 plot diag_kmeans = KMeans(n_clusters=3) diag_kmeans.fit(diag_points) color_dict = {0: 'red', 1: 'blue', 2: 'green'} for cluster in range(3): cluster_sub_points = diag_points[diag_kmeans.labels_ == cluster] ax.scatter(cluster_sub_points[:, 0], cluster_sub_points[:, 1], c=color_dict[cluster], label='cluster_{}'.format(cluster)) ax.set_title('K-means on diagonal-shaped data, K=2') ax.set_xlabel('X') ax.set_ylabel('Y') ax.legend() ax.grid()

📄Output

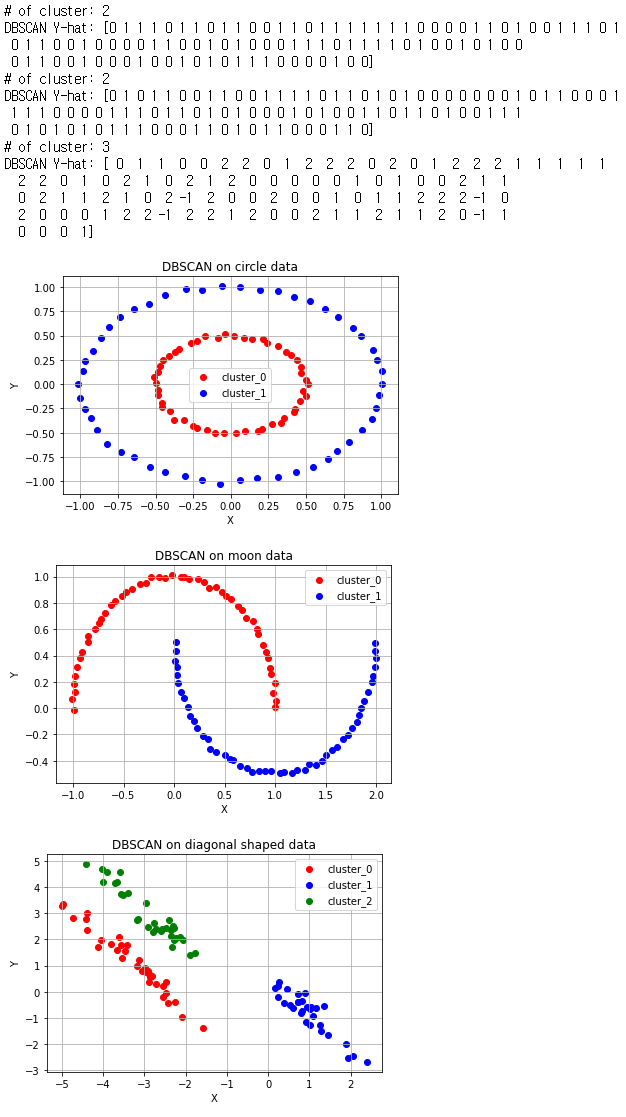

2. DBSCAN(Density Based Spatial Clustering of Applications with Noise)

밀도 기반의 군집 알고리즘으로 K-means를 사용하여 해결하기 어려웠던 문제들을 DBSCAN 알고리즘을 활용해 해결할 수 있다. DBSCAN의 가장 큰 특징 중 하나는 군집의 개수, 즉 K-means에서의 k값을 미리 지정할 필요가 없다는 점이다. 또한 유클리드 거리 기반의 K-means 방식과 달리 조밀하게 몰려있는 클러스터를 군집화하는 방식을 사용하기 때문에 원 모양의 군집이 아닌 불특정한 형태의 군집도 찾을 수 있다.

💡 ( Tip ) DBSCAN의 시각적 이해

2-1) DBSCAN 알고리즘 동작

💡 ( Tip ) DBSCAN을 이해하기 위한 변수와 용어

- epsilon : 클러스터의 반경

- minPts : 클러스터를 이루는 개체의 최솟값

- core point : 반경 epsilon 내에 minPts 개 이상의 점이 존재하는 중심점

- border point : 군집의 중심이 되지는 못하지만, 군집에 속하는 점

- noise point : 군집에 포함되지 못하는 점

💡 ( Tip ) DBSCAN의 알고리즘 순서

1. 임의의 점 p를 설정하고, p를 포함하여 주어진 클러스터의 반경(elipson) 안에 포함되어 있는 점들의 개수를 계산

2. 만일 해당 원에 minPts 개 이상의 점이 포함되어 있으면 해당 점 p를 core point로 간주하고 원에 포함된 점들을 하나의 클러스터로 군집화

3. 해당 원에 minPts 개 미만의 점이 포함되어 있으면 pass 로 지정

4. 모든 점에 대하여 돌아가면서 1~3 번의 과정을 반복하며 만일 새로운 점 p'가 Core Point가 되고 이 점이 기존의 클러스터(p를 Core Point로 하는)에 속한다면 두 개의 클러스터는 연결되어 있다고 하며 하나의 클러스터로 군집화

5.모든 점에 대하여 클러스터링 과정을 끝내고 어떤 점을 중심으로 하더라도 클러스터에 속하지 못하는 점이 있으면 이를 Noise Point로 지정 또한 특정 군집에는 속하지만 Core Point가 아닌 점들을 Border Point라고 지정# DBSCAN으로 circle, moon, diagonal shaped data를 군집화한 결과 from sklearn.cluster import DBSCAN fig = plt.figure() ax= fig.add_subplot(1, 1, 1) color_dict = {0: 'red', 1: 'blue', 2: 'green', 3:'brown',4:'purple'} # n 번째 클러스터 데이터를 어떤 색으로 도식할 지 결정하는 color dictionary # 원형 분포 데이터 plot epsilon, minPts = 0.2, 3 # 2)와 3) 과정에서 사용할 epsilon, minPts 값을 설정 circle_dbscan = DBSCAN(eps=epsilon, min_samples=minPts) # 위에서 생성한 원형 분포 데이터에 DBSCAN setting circle_dbscan.fit(circle_points) # 3) ~ 5) 과정을 반복 n_cluster = max(circle_dbscan.labels_)+1 # 3) ~5) 과정의 반복으로 클러스터의 수 도출 print(f'# of cluster: {n_cluster}') print(f'DBSCAN Y-hat: {circle_dbscan.labels_}') # DBSCAN 알고리즘의 수행결과로 도출된 클러스터의 수를 기반으로 색깔별로 구분하여 점에 색칠한 후 도식 for cluster in range(n_cluster): cluster_sub_points = circle_points[circle_dbscan.labels_ == cluster] ax.scatter(cluster_sub_points[:, 0], cluster_sub_points[:, 1], c=color_dict[cluster], label='cluster_{}'.format(cluster)) ax.set_title('DBSCAN on circle data') ax.set_xlabel('X') ax.set_ylabel('Y') ax.legend() ax.grid() # 달 모양 분포 데이터 plot - 위와 같은 과정 반복 fig = plt.figure() ax= fig.add_subplot(1, 1, 1) color_dict = {0: 'red', 1: 'blue', 2: 'green', 3:'brown',4:'purple'} # n 번째 클러스터 데이터를 어떤 색으로 도식할 지 결정하는 color dictionary epsilon, minPts = 0.4, 3 moon_dbscan = DBSCAN(eps=epsilon, min_samples=minPts) moon_dbscan.fit(moon_points) n_cluster = max(moon_dbscan.labels_)+1 print(f'# of cluster: {n_cluster}') print(f'DBSCAN Y-hat: {moon_dbscan.labels_}') for cluster in range(n_cluster): cluster_sub_points = moon_points[moon_dbscan.labels_ == cluster] ax.scatter(cluster_sub_points[:, 0], cluster_sub_points[:, 1], c=color_dict[cluster], label='cluster_{}'.format(cluster)) ax.set_title('DBSCAN on moon data') ax.set_xlabel('X') ax.set_ylabel('Y') ax.legend() ax.grid() # 대각선 모양 분포 데이터 plot - 위와 같은 과정 반복 fig = plt.figure() ax= fig.add_subplot(1, 1, 1) color_dict = {0: 'red', 1: 'blue', 2: 'green', 3:'brown',4:'purple'} # n 번째 클러스터 데이터를 어떤 색으로 도식할 지 결정하는 color dictionary epsilon, minPts = 0.7, 3 diag_dbscan = DBSCAN(eps=epsilon, min_samples=minPts) diag_dbscan.fit(diag_points) n_cluster = max(diag_dbscan.labels_)+1 print(f'# of cluster: {n_cluster}') print(f'DBSCAN Y-hat: {diag_dbscan.labels_}') for cluster in range(n_cluster): cluster_sub_points = diag_points[diag_dbscan.labels_ == cluster] ax.scatter(cluster_sub_points[:, 0], cluster_sub_points[:, 1], c=color_dict[cluster], label='cluster_{}'.format(cluster)) ax.set_title('DBSCAN on diagonal shaped data') ax.set_xlabel('X') ax.set_ylabel('Y') ax.legend() ax.grid()

📄Output

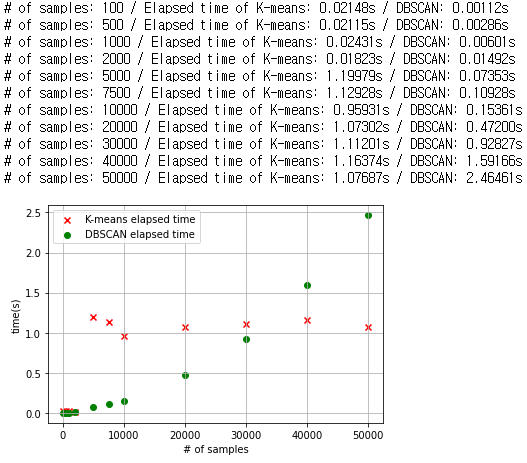

2-2) DBSCAN 알고리즘의 단점은 데이터 수가 많을수로 시간이 기하급수적으로 많이 소요된다는 점이다.

# DBSCAN 알고리즘과 K-means 알고리즘의 시간을 비교하는 코드 import time n_samples= [100, 500, 1000, 2000, 5000, 7500, 10000, 20000, 30000, 40000, 50000] kmeans_time = [] dbscan_time = [] x = [] for n_sample in n_samples: dummy_circle, dummy_labels = make_circles(n_samples=n_sample, factor=0.5, noise=0.01) # 원형의 분포를 가지는 데이터 생성 # K-means 시간을 측정 kmeans_start = time.time() circle_kmeans = KMeans(n_clusters=2) circle_kmeans.fit(dummy_circle) kmeans_end = time.time() # DBSCAN 시간을 측정 dbscan_start = time.time() epsilon, minPts = 0.2, 3 circle_dbscan = DBSCAN(eps=epsilon, min_samples=minPts) circle_dbscan.fit(dummy_circle) dbscan_end = time.time() x.append(n_sample) kmeans_time.append(kmeans_end-kmeans_start) dbscan_time.append(dbscan_end-dbscan_start) print("# of samples: {} / Elapsed time of K-means: {:.5f}s / DBSCAN: {:.5f}s".format(n_sample, kmeans_end-kmeans_start, dbscan_end-dbscan_start)) # K-means와 DBSCAN의 소요 시간 그래프화 fig = plt.figure() ax = fig.add_subplot(1, 1, 1) ax.scatter(x, kmeans_time, c='red', marker='x', label='K-means elapsed time') ax.scatter(x, dbscan_time, c='green', label='DBSCAN elapsed time') ax.set_xlabel('# of samples') ax.set_ylabel('time(s)') ax.legend() ax.grid()

📄Output

차원 축소(Dimensionality Reduction)

차원 축소는 수많은 정보 속에서 우리에게 더 중요한 요소가 무엇인지를 알게 해주는 방법으로 비지도학습에서는 데이터를 나타내는 여러 특징들 중에서 어떤 특징이 가장 그 데이터를 잘 표현 하는지를 알게해주는 특징을 추출하는 것이다.

1. PCA

PCA는 데이터 분포의 주성분(데이터의 분산이 가장 큰 방향벡터)을 찾아주는 방법으로 데이터들의 분산을 최대로 보존하면서 서로 직교(Orthogonal)하는 기저(Basis : 분산이 큰 방향벡터의 축)들을 찾아 고차원 공간을 저차원 공간으로 사영(Projection)한다. 또한 기존 특징중 중요한 것을 선택하는 방식이 아닌 기존 특징을 선형 결합(Linear Combination) 하는 방식을 사용한다.

💡 ( Tip ) 주로 선형적인 데이터의 분포(키, 몸무게 등)를 가지고 있을 때 정보가 가장 잘 보존된다.

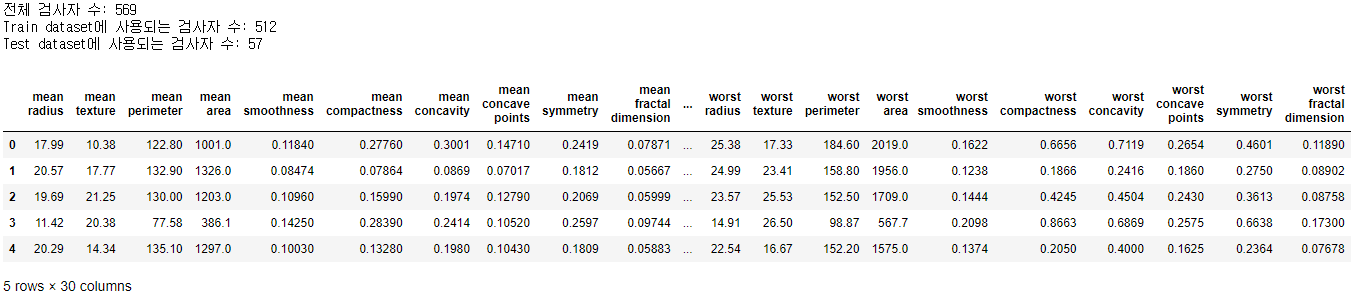

1-1)데이터 생성

# 차원 축소 예제: 유방암 데이터셋 from sklearn.datasets import load_breast_cancer from sklearn.model_selection import train_test_split # 데이터 로드 cancer=load_breast_cancer() # y=0(Malignant:악성 종양), y=1(Benign:양성 종양) cancer_X, cancer_y= cancer.data, cancer['target'] train_X, test_X, train_y, test_y = train_test_split(cancer_X, cancer_y, test_size=0.1, random_state=10) # train 데이터셋과 test 데이터셋으로 나눔 print("전체 검사자 수: {}".format(len(cancer_X))) print("Train dataset에 사용되는 검사자 수: {}".format(len(train_X))) print("Test dataset에 사용되는 검사자 수: {}".format(len(test_X))) cancer_df = pd.DataFrame(cancer_X, columns=cancer['feature_names']) cancer_df.head()

📄Output

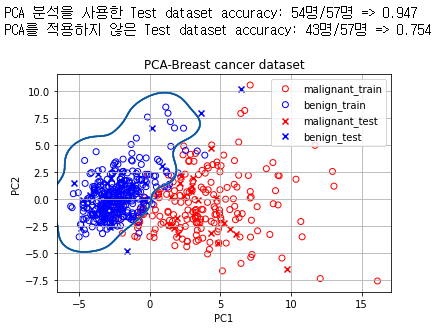

1-2)생성된 데이터셋에 PCA알고리즘 적용

from sklearn.preprocessing import StandardScaler from sklearn.decomposition import PCA from sklearn import svm from sklearn.metrics import accuracy_score from collections import Counter # color dictionary color_dict = {0: 'red', 1: 'blue', 2:'red', 3:'blue'} target_dict = {0: 'malignant_train', 1: 'benign_train', 2: 'malignant_test', 3:'benign_test'} #Train data에 PCA 알고리즘 적용 train_X_ = StandardScaler().fit_transform(train_X) # 불러온 데이터에 대한 정규화 -> 각 column의 range of value가 전부 다르기 때문에 정규화를 진행해 주어야 합니다. train_df = pd.DataFrame(train_X_, columns=cancer['feature_names']) pca = PCA(n_components=2) # 주성분의 수를 2개, 즉 기저가 되는 방향벡터를 2개로 하는 PCA 알고리즘 수행 pc = pca.fit_transform(train_df) #Test data에 PCA 알고리즘 적용 test_X_ = StandardScaler().fit_transform(test_X) # normalization test_df = pd.DataFrame(test_X_, columns=cancer['feature_names']) pca_test = PCA(n_components=2) pc_test = pca_test.fit_transform(test_df) # 훈련한 classifier의 decision boundary를 그리는 함수 def plot_decision_boundary(X, clf, ax): h = .02 # step size in the mesh # create a mesh to plot in x_min, x_max = X[:, 0].min() - 1, X[:, 0].max() + 1 y_min, y_max = X[:, 1].min() - 1, X[:, 1].max() + 1 xx, yy = np.meshgrid(np.arange(x_min, x_max, h), np.arange(y_min, y_max, h)) Z = clf.predict(np.c_[xx.ravel(), yy.ravel()]) Z = Z.reshape(xx.shape) ax.contour(xx, yy, Z, cmap='Blues') # PCA를 적용한 train data의 classifier 훈련: classfier로 Support Vector Machine(SVM) 사용 clf = svm.SVC(kernel = 'rbf', gamma=0.5, C=0.8) # 여기서는 classifier로 SVM을 사용한다는 정도만 알아둡시다! clf.fit(pc, train_y) # train data로 classifier 훈련 # PCA를 적용하지 않은 original data의 SVM 훈련 clf_orig = svm.SVC(kernel = 'rbf', gamma=0.5, C=0.8) # 여기서는 classifier로 SVM을 사용한다는 정도만 알아둡시다! clf_orig.fit(train_df, train_y) # 캔버스 도식 fig = plt.figure() ax = fig.add_subplot(1, 1, 1) # malignant와 benign의 SVM decision boundary 그리기 plot_decision_boundary(pc, clf, ax) #Train data 도식 for cluster in range(2): sub_cancer_points = pc[train_y == cluster] ax.scatter(sub_cancer_points[:, 0], sub_cancer_points[:, 1], edgecolor=color_dict[cluster], c='none', label=target_dict[cluster]) #Test data 도식 for cluster in range(2): sub_cancer_points = pc_test[test_y == cluster] ax.scatter(sub_cancer_points[:, 0], sub_cancer_points[:, 1], marker= 'x', c=color_dict[cluster+2], label=target_dict[cluster+2]) ax.set_xlabel('PC1') ax.set_ylabel('PC2') ax.set_title('PCA-Breast cancer dataset') ax.legend() ax.grid() # Scoring pca_test_accuracy_dict = Counter(clf.predict(pc_test) == test_y) orig_test_accuracy_dict = Counter(clf_orig.predict(test_df) == test_y) print("PCA 분석을 사용한 Test dataset accuracy: {}명/{}명 => {:.3f}".format(pca_test_accuracy_dict[True], sum(pca_test_accuracy_dict.values()), clf.score(pc_test, test_y))) print("PCA를 적용하지 않은 Test dataset accuracy: {}명/{}명 => {:.3f}".format(orig_test_accuracy_dict[True], sum(orig_test_accuracy_dict.values()), clf_orig.score(test_df, test_y)))

📄Output

2. T-SNE(T-Stochastic Neighbor Embedding)

시각화에 많이 쓰이는 알고리즘으로 PCA와 달리 방사형적, 비선형적 데이터에서 많이 사용되며 기존 차원의 공간에서 가까운 점들은 차원 축소된 공간에서도 여전히 가깝게 유지되는 것을 목표로 하는 알고리즘이다.

3. PCA와 T-SNE 알고리즘의 비교

3-1)데이터 생성

print("실행 중입니다... 시간이 다소 걸릴 수 있어요. :)\n===") from sklearn.datasets import fetch_openml # 784 pixel로 이뤄진 mnist 이미지 데이터 호출 mnist = fetch_openml("mnist_784",version=1) X = mnist.data / 255.0 y = mnist.target print("X shape: ",X.shape) print("Y shape: ",y.shape) n_image = X.shape[0] n_image_pixel = X.shape[1] pixel_columns = [ f"pixel{i}" for i in range(1, n_image_pixel + 1) ] # 픽셀정보가 있는 칼럼의 이름을 담은 목록 #데이터를 판다스를 이용해 데이터프레임으로 생성 import pandas as pd df = pd.DataFrame(X,columns=pixel_columns) df['y'] = y df['label'] = df['y'].apply(lambda i: str(i)) # 숫자 라벨을 스트링으로 만드는 함수를 파이썬 람다 문법으로 전체 데이터에 적용합니다. X, y = None, None

📄Output

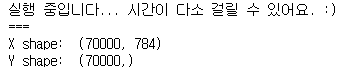

3-2) 데이터 셈플링 및 확인

import numpy as np # 결과가 재생산 가능하도록 랜덤 시드를 지정합니다. np.random.seed(30) # 이미지 데이터의 순서를 랜덤으로 뒤바꾼(permutation) 배열을 담습니다. rndperm = np.random.permutation(n_image) # 랜덤으로 섞은 이미지 중 10,000개를 뽑고, df_subset에 담습니다. n_image_sample = 10000 random_idx = rndperm[:n_image_sample] df_subset = df.loc[random_idx,:].copy() %matplotlib inline import seaborn as sns import matplotlib.pyplot as plt plt.gray() fig = plt.figure( figsize=(10,6) ) n_img_sample = 15 width,height = 28,28 # 15개 샘플을 시각화해 봅니다. for i in range(0,n_img_sample): row = df_subset.iloc[i] ax = fig.add_subplot(3,5,i+1, title=f"Digit: {row['label']}") ax.matshow(row[pixel_columns] .values.reshape((width,height)) .astype(float)) plt.show()

📄Output

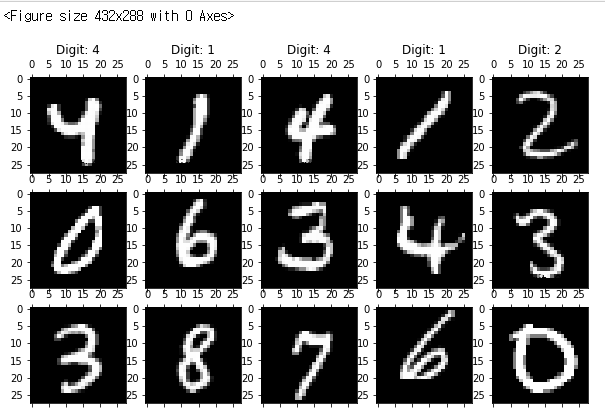

3-3) PCA를 이용한 MNIST 차원축소

💡 ( Tip ) 차원을 축소하면서 정보량의 일부만 남게되며 sklearn의 PCA 모듈을 PC축 마다 보존하는 정보량의 비율을 제시해준다.from sklearn.decomposition import PCA print("df_subset의 shape: {}".format(df_subset.shape)) n_dimension = 2 # 축소시킬 목표 차원의 수 pca = PCA(n_components=n_dimension) pca_result = pca.fit_transform(df_subset[pixel_columns].values) # 차원을 축소한 결과 df_subset['pca-one'] = pca_result[:,0] # 축소한 결과의 첫 번째 차원 값 df_subset['pca-two'] = pca_result[:,1] # 축소한 결과의 두 번째 차원 값 print("pca_result의 shape: {}".format(pca_result.shape)) print(f"pca-1: {round(pca.explained_variance_ratio_[0],3)*100}%") print(f"pca-2: {round(pca.explained_variance_ratio_[1],3)*100}%") print("축소 후 남은 데이터량 : ",round(pca.explained_variance_ratio_[0],3)*100+round(pca.explained_variance_ratio_[1],3)*100,"%") plt.figure(figsize=(10,6)) sns.scatterplot( x="pca-one", y="pca-two", hue="y", palette=sns.color_palette("hls", 10), data=df_subset, # 2개의 PC축만 남은 데이터프레임 df_subset 을 시각화해 보자. legend="full", alpha=0.4 )

📄Output

💡 ( Tip ) PCA로 784차원을 2차원으로 줄인 결과 벡터를 그래프화 한 것이며 같거나 모양이 비슷한 숫자 이미지가 유사한 벡터값을 갖는 것을 색상으로 확인할 수 있다.

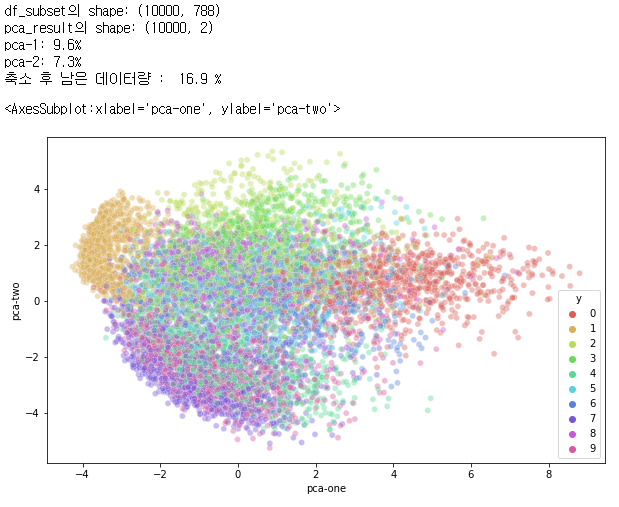

3-4) T-SNE를 이용한 MNINST 차원축소

from sklearn.manifold import TSNE print("df_subset의 shape: {}".format(df_subset.shape)) data_subset = df_subset[pixel_columns].values n_dimension = 2 tsne = TSNE(n_components=n_dimension) tsne_results = tsne.fit_transform(data_subset) print("tsne_results의 shape: {}".format(tsne_results.shape)) # tsne 결과를 차원별로 추가합니다. df_subset['tsne-2d-one'] = tsne_results[:,0] df_subset['tsne-2d-two'] = tsne_results[:,1] # 시각화해 봅니다. plt.figure(figsize=(10,6)) sns.scatterplot( x="tsne-2d-one", y="tsne-2d-two", hue="y", palette=sns.color_palette("hls", 10), data=df_subset, legend="full", alpha=0.3 )

📄Output

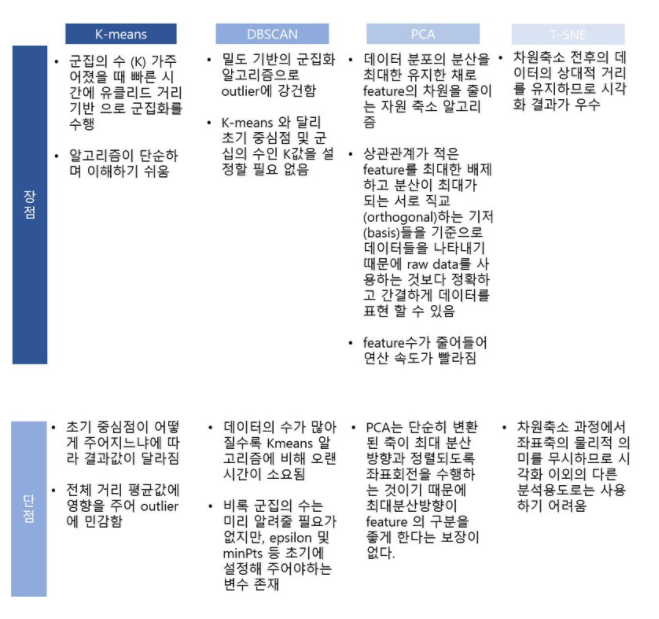

마무리 요약