X-Mesh: Towards Fast and Accurate Text-driven 3D Stylization via Dynamic Textual Guidance [ICCV 2023]

3D Mesh를 Text prompt에 맞게 꾸미는 기술입니다.

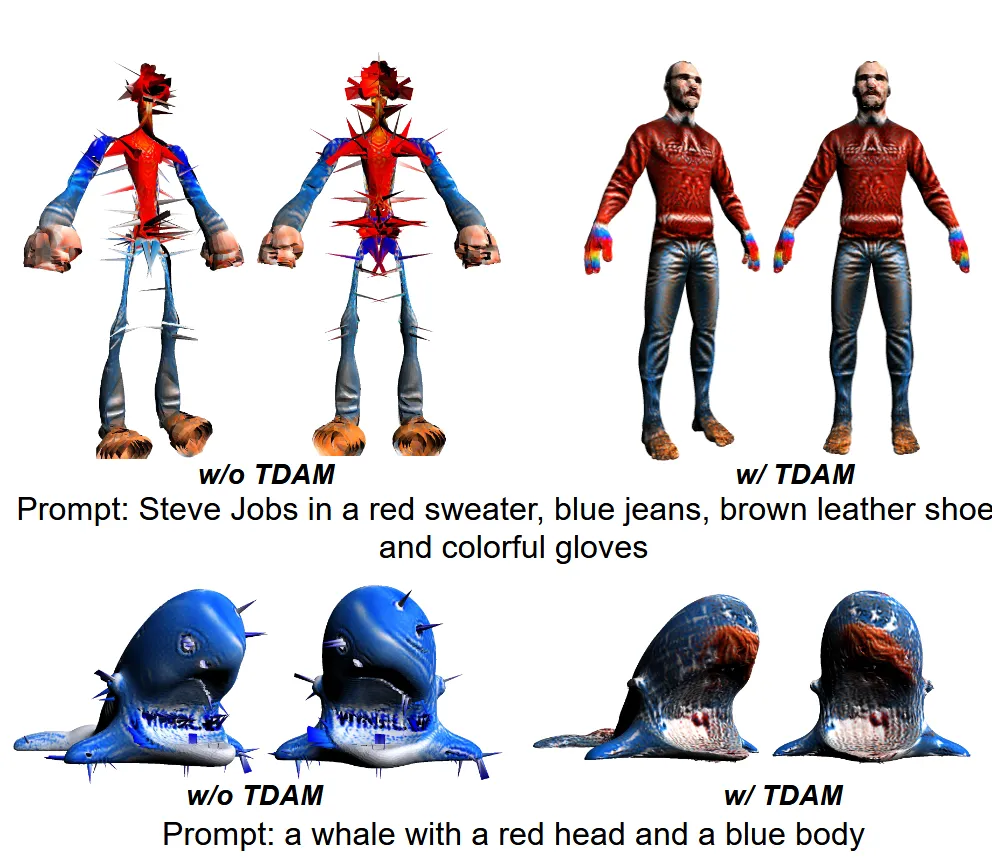

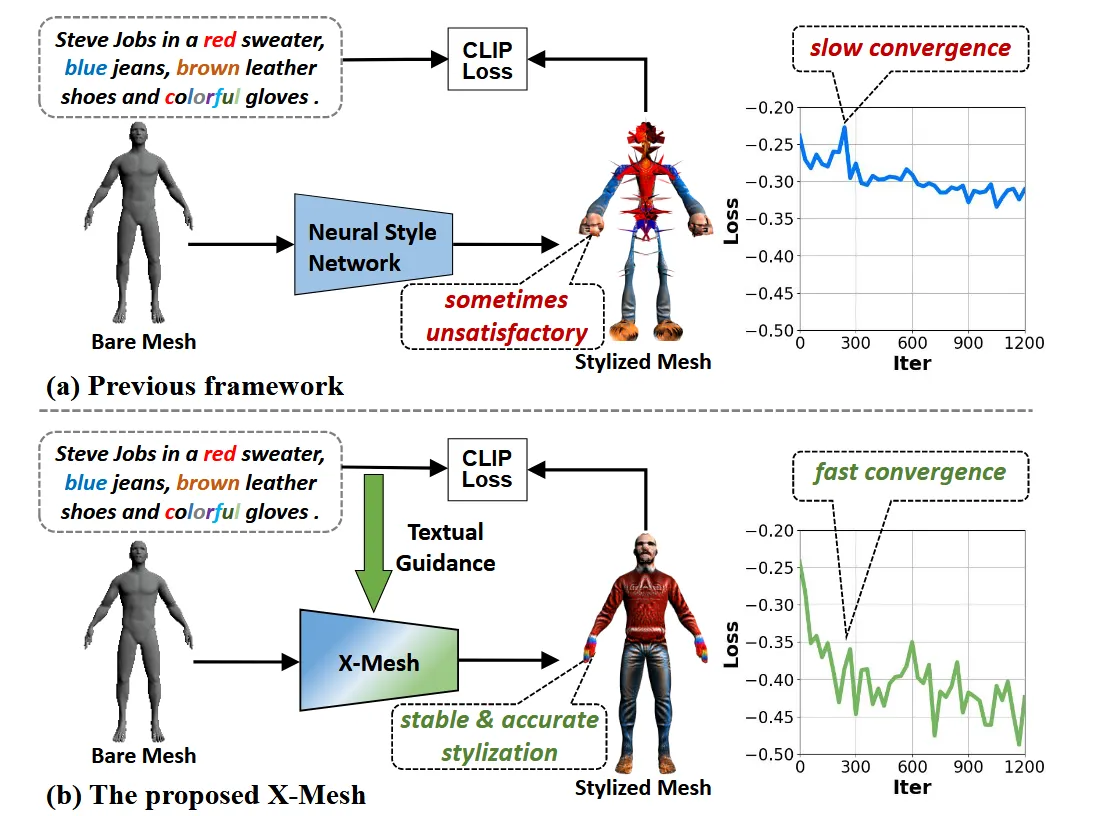

a가 일반적인 기존의 text기반의 3D 변형 모델이고, b가 해당 모델의 아키텍처입니다. MLP와 CLIP Loss에 의존할 경우 디테일을 살리지 못하는데 논문에서는 TDAM(Text-guided Dynamic Attention Module) 방식을 사용해서 빠른 속도로 디테일한 결과를 생성할 수 있도록 했습니다.

Approach

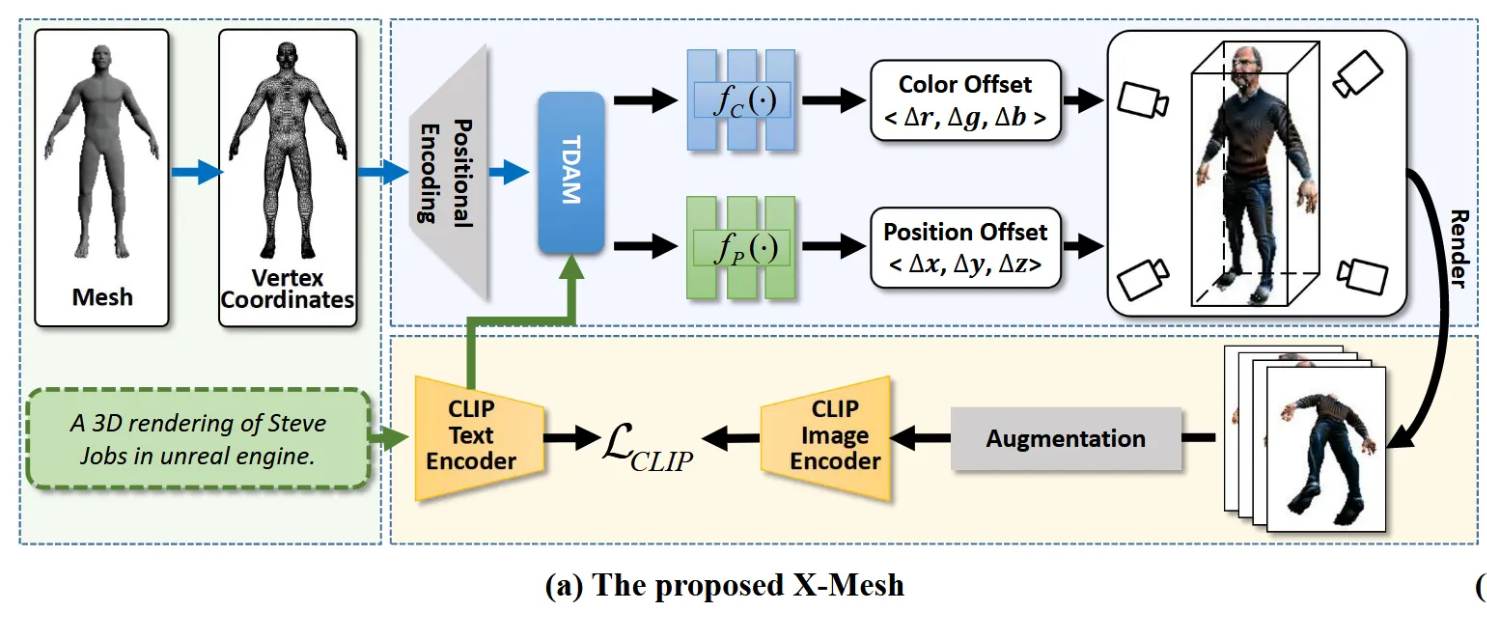

Architecture

이전 방식들(Text2Mesh)처럼 입력으로 들어오는 3D Mesh의 구조는 고정되고(face는 변하지 않는다) 각 점의 색상과 위치만 수정합니다. 입력 Mesh의 초기 색상은 (0.5, 0.5, 0.5) 즉 회색을 갖고, 위치는 모두 정규화 해서 단위 큐브 안에 들어오게 합니다. 이후 이전 방식들처럼 Fourier positional encoding을 사용해서 고주파 세부 정보를 담습니다.

이렇게 생성한 임베딩 값을 TDAM에 넣습니다. TDAM은 text를 기반으로 color offset과 position offset 값을 MLP에 전달합니다. 이때 위치 이동은 너무 과하게 되지 않게 하기 위해서 제곱값이 0.1을 넘지 않도록 설정합니다.

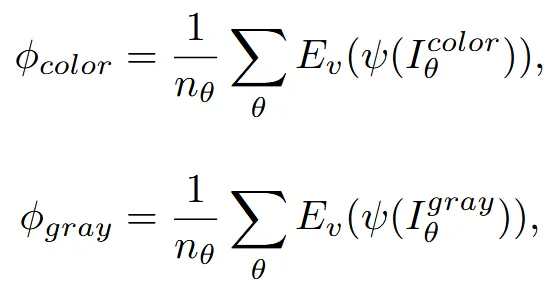

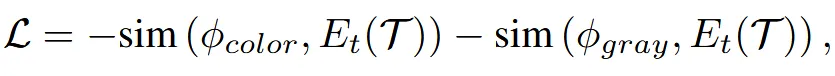

MLP를 통해서 나온 결과는 크게 컬러까지 적용된 와, 위치 변화만 적용된 2개가 나옵니다. 각각을 렌더링 한 결과를 , 를 augmentation해서 CLIP image encoder에 통과시켜 text clip encoder의 결과와 유사하게 cosine similarity로 학습합니다.

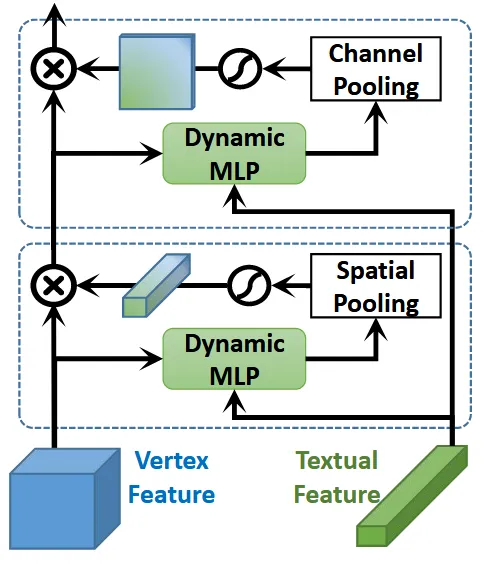

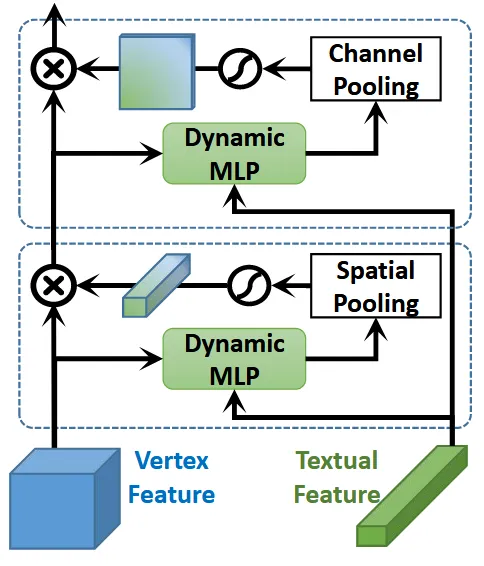

Text-guided Dynamic Attention Module

TDAM은 텍스트를 이해해서 각 vertex의 색과 위치를 바꿀 때 어디에 집중해야 하는지 알려주는 모듈입니다. TDAM은 dynamic linear layer를 기반으로 text 기반 dynamic과 spatial attention을 계산합니다. 그림을 보면 Textural Feature(Text)가 MLP에 반영돼서 Vertex Feature가 변형되는 것을 확인할 수 있습니다.

Dynamic Linear Layer

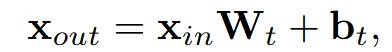

Dynamic Linear Layer를 한마디로 정의하면 텍스트에 따라 MLP 파라미터를 조절하는 서브 네트워크입니다.

기존의 MLP는 text prompt가 바껴도 MLP의 Weight는 학습된 고정값을 사용했습니다. Dynamic Linear layer는 target textual feature (차원은 )를 기반으로 동적으로 생성하도록 변경했습니다.

Dynmaic linear layer는 위와 같이 정의 할 수 있습니다. 입력 차원이 , 출력 차원이 일 때 의 차원은 , 의 차원은 입니다.

가장 직관적인 방식은 위와 같은 방식으로 dynamic linear layer를 설계하는 것입니다. 하지만 이럴 경우 계산량이 이 으로 엄청나게 많아집니다.

계산량을 줄이기 위해서 matrix decomposition을 사용합니다. 의 차원을 으로 설정하기 위해 U를 차원, V를 으로 설정합니다. K는 하이퍼파라미터값으로 설정할 수 있습니다. 여기서 U는 에 의해 동적으로 바뀌고, V는 고정된 matrix를 사용합니다.

동적으로 변환되는 U는 위와 같은 수식을 갖습니다. 은 차원을 갖고, 은 차원을 갖습니다.

이렇게 matrix decomposition을 진행하면 전체 차원이 → 으로 계산량을 줄일 수 있습니다. 한마디로 K개 을 넘도록만 설정하지 않으면 계산량이 감소합니다.

Dynamic Channel and Spatial Attention

이번에는 attention을 어떻게 channel과 spatial에 적용할 수 있는지 확인해보도록 하겠습니다.

위의 그림을 다시 가져왔는데 아래 부분에서는 Spatial attention을 위의 부분에서는 Channel attention을 진행하는 것을 확인할 수 있습니다. Vertex Feature 의 차원은 인데 여기서 는 vertex의 개수, 는 vertex의 차원입니다. 여기서 주의해야될게 는 3차원이 아닌 positional encoding을 거친 결과 2C입니다.

Channel Attention

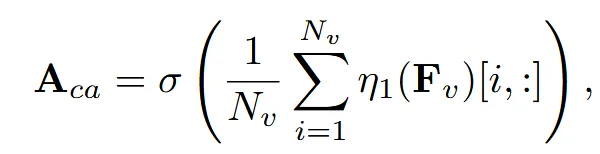

Channel Attention을 어떻게 하는지 먼저 확인해보도록 하겠습니다. 우선 spatial dimension을 average pooling을 진행해서 차원을 로 변환합니다. 이후 Sigmoid를 이용해서 값을 0부터 1을 갖도록 합니다. 설명한 과정이 위의 수식입니다.

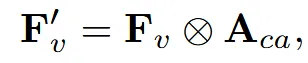

이후 기존 vertex feuatre와 element-wise product를 진행해서 어느 특성에 집중해야 될지를 알 수 있습니다.

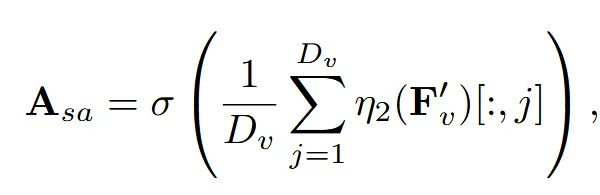

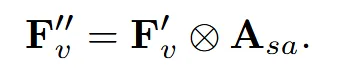

Spatial Attention

마찬가지의 과정을 진행하는데 차원이 로만 변환됩니다. 그리고 이부분에서는 어떤 점에 집중하는지를 알 수 있습니다.

Benchmarks and Metrics

해당 부분은 새로운 지표를 제시한 부분인데 생략하도록 하겠습니다.

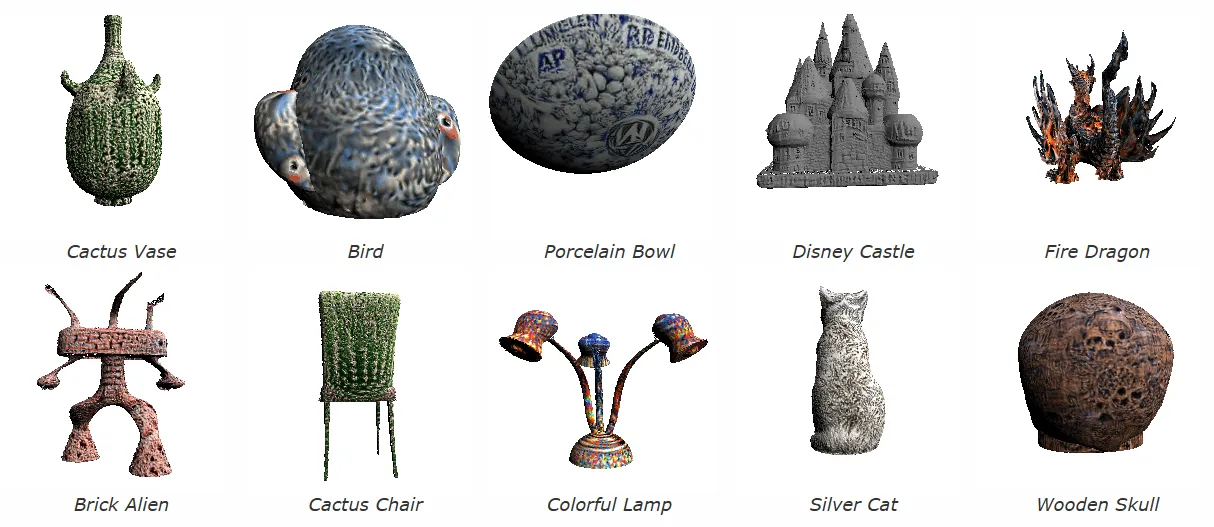

Experiments

Ablation