윈도우 10에서 pyspark를 설치하여 local 개발 환경을 구축 가이드를 적어봅니다.

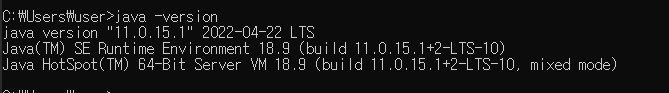

윈도우에서 spark를 설치하기 위해서는 java, python이 기본적으로 설치되어 있어야합니다. python 개발환경은 기본적으로 구축이 되어 있다고 가정하고 java 버전 확인부터 시작하겠습니다. spark는 scala로 짜여있는데 scala는 JVM(자바 가상 머신)에서 동작합니다. 그러므로 java 설치와 버전 확인은 필수 입니다.

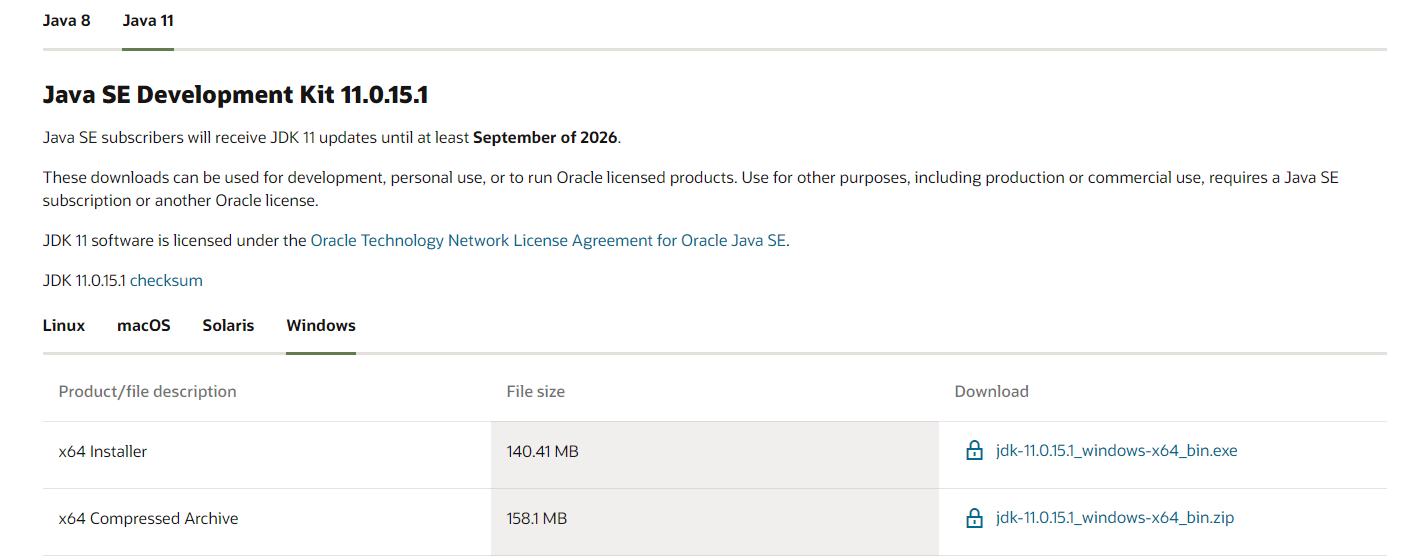

오늘 설치할 spark의 버전은 3.2.1입니다. 현재 기준으로 spark 3.0.0 이상부터 java가 11버전 이상을 요구하기 때문에 JDK 11을 설치합니다.

1. JAVA 버전 확인 및 설치

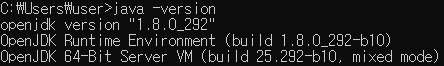

1-1. cmd 창을 열고 java 버전을 확인합니다.

java -version

저는 1.8.0 버전입니다.... JDK 11을 설치해주겠습니다.

1-2. JDK 11 설치

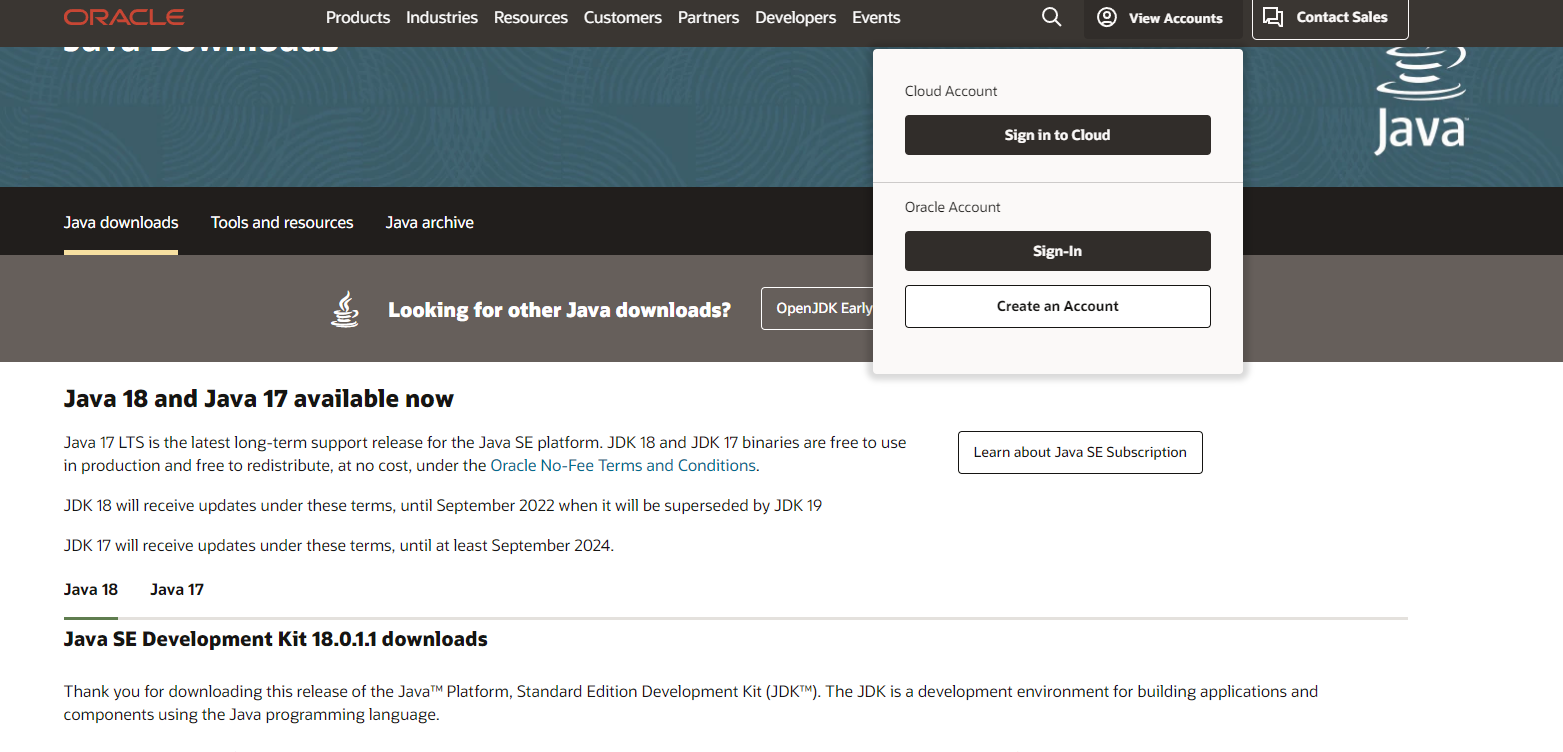

JDK를 설치하려면 oracle 계정이 있어야 합니다. 세상 귀찮아 죽겠지만 그래도 계정을 만들거나 로그인해줍니다...

다운로드 링크 : https://www.oracle.com/java/technologies/downloads/

상단의 "view accounts"에서 로그인 또는 회원가입을 진행합니다.

로그인 후, 페이지를 쭉 내리면 중간 쯤에 JAVA 11이 있습니다.

windows를 클릭하고 x64 instller를 다운 받습니다.

exe 파일을 실행하고 계속 next를 눌러 설치를 완료합니다.

1-3. 환경변수 설정

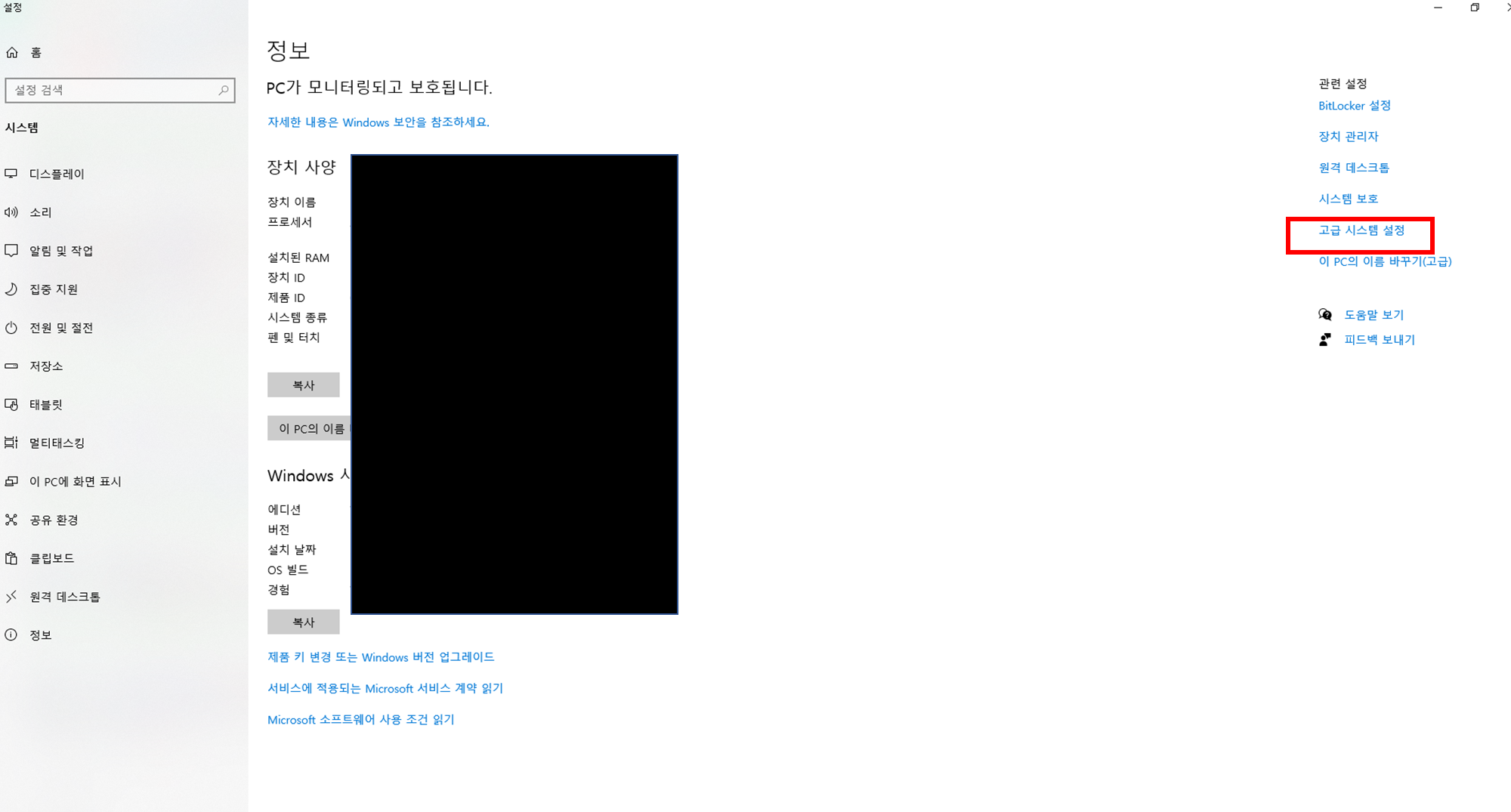

환경변수 설정을 위해 탐색기?에서 "내 PC" 선택 후 우클릭하여 "속성"을 눌러주세요.

우측에 "고급 시스템 설정"을 클릭

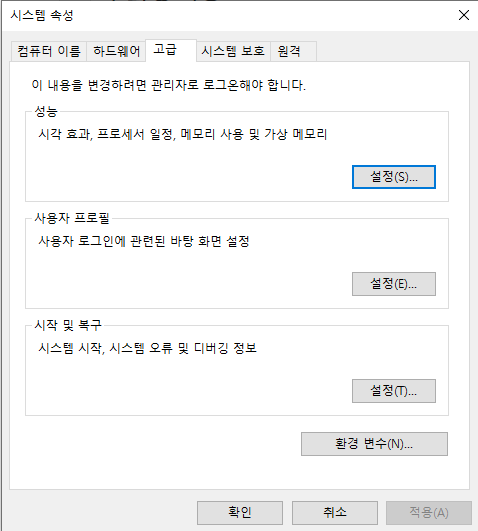

하단에 "환경변수" 클릭

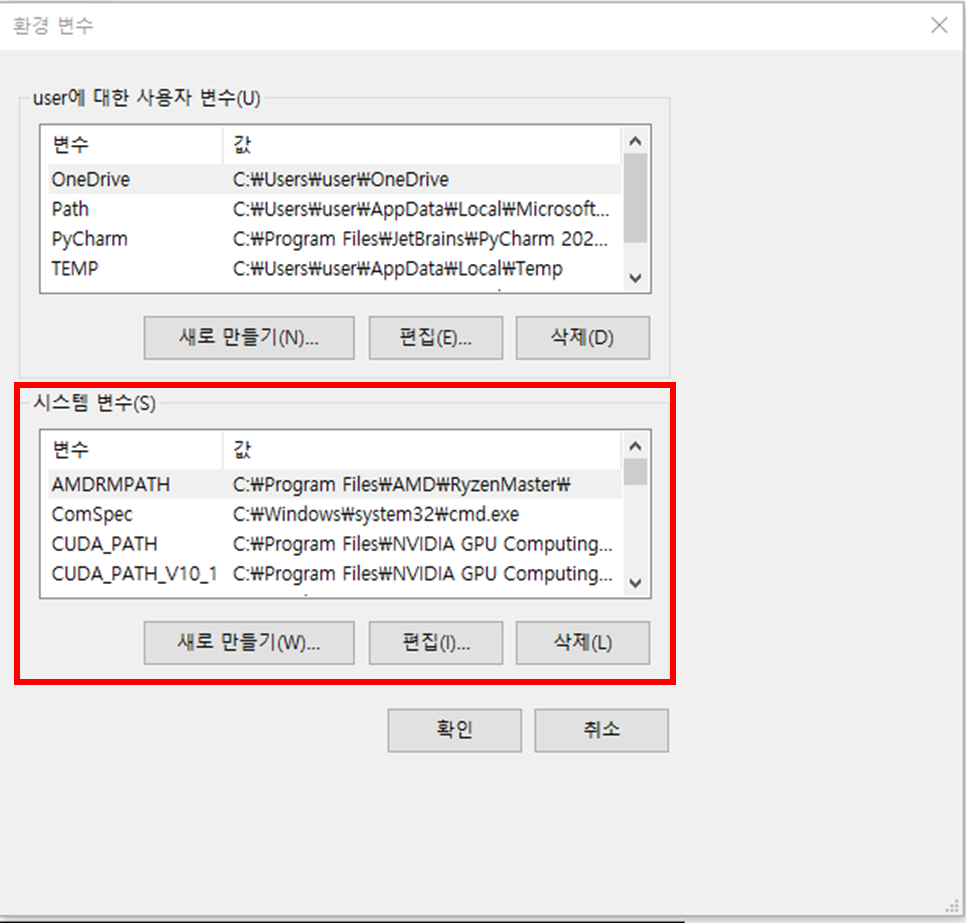

빨간색 박스(시스템 변수)에서 "새로 만들기" 클릭

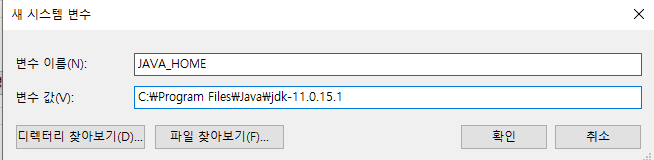

아래 그림처럼 채워넣기

변수 값은 java가 설치된 디렉토리를 입력해주시면 됩니다. 일반적으로 Program Files/java 폴더에 있습니다. 방금 설치한 버전의 디렉토리를 적어주세요. 그리고 확인 클릭

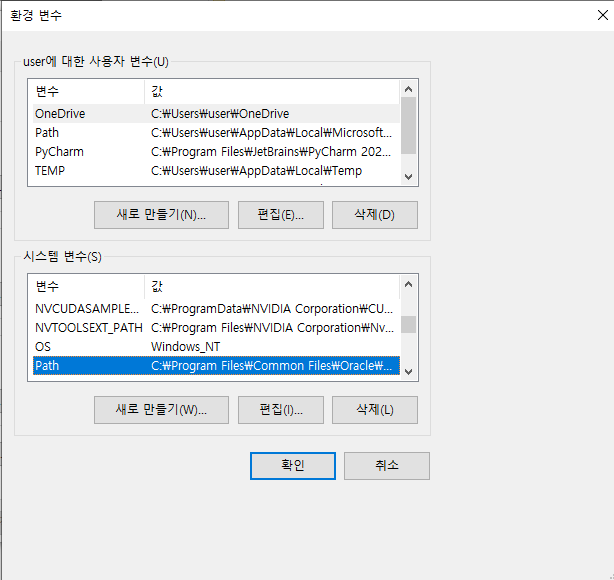

path를 찾아 "편집 클릭"

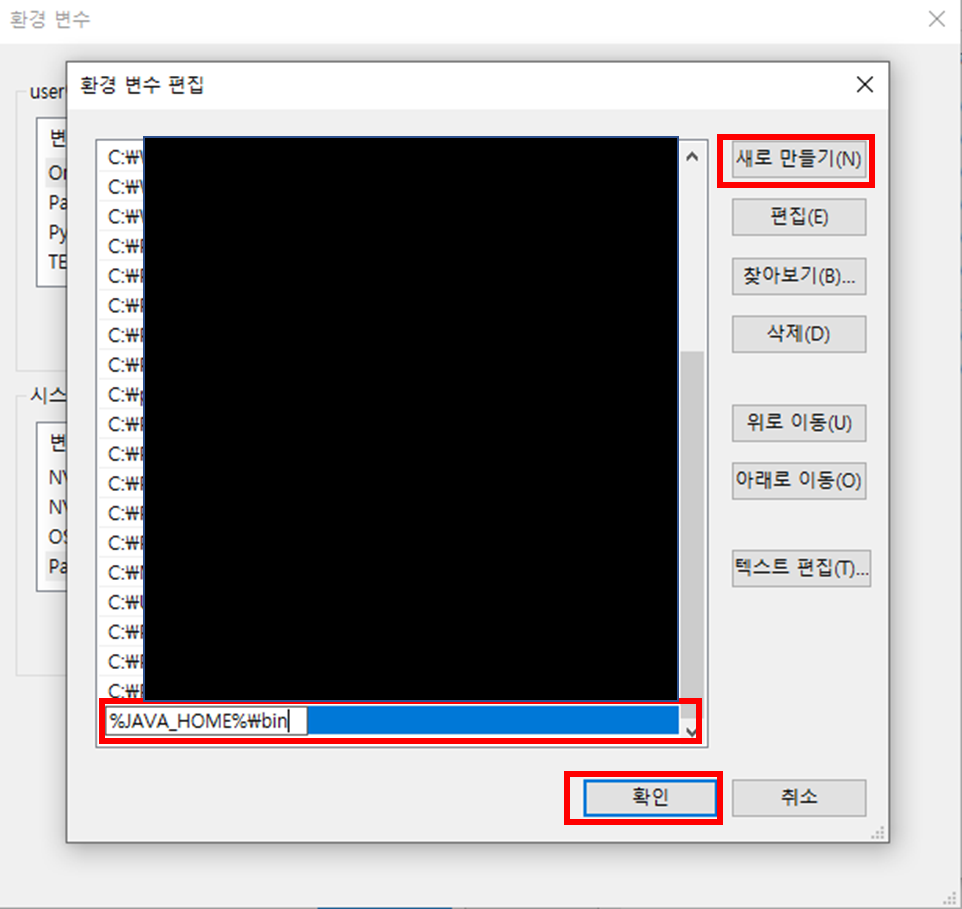

"새로 만들기" - %JAVA_HOME%\bin 입력 -"확인"을 클릭합니다.

cmd 창을 열고 java 버전을 확인합니다.

java -version

버전이 업그레이드 되지 않은 분들은 반드시 재부팅해주세요

이제 pyspark 설치를 위한 기초가 끝났습니다.

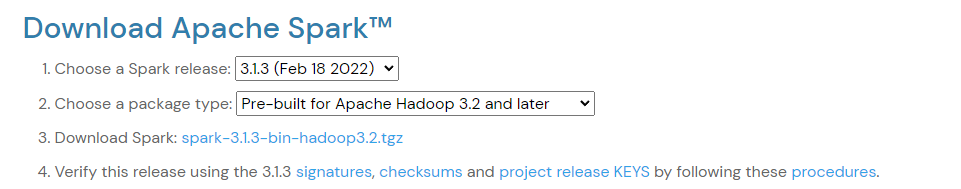

2. 스파크 다운로드

https://spark.apache.org/downloads.html

저는 3.1.3 버전을 설치하겠습니다.

1번에서 다운 받을 버전을 선택. 2번에서 하둡의 버전 선택. 3번에서 tgz파일을 다운로드해줍니다.

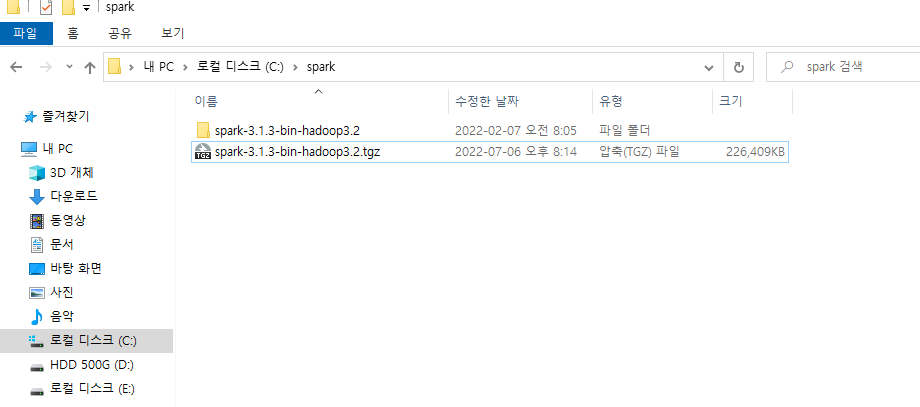

c:/에서 spark 디렉토리를 하나 생성하고 다운받은 tgz파일을 이동시켜줍니다. 압축도 해제해주세요

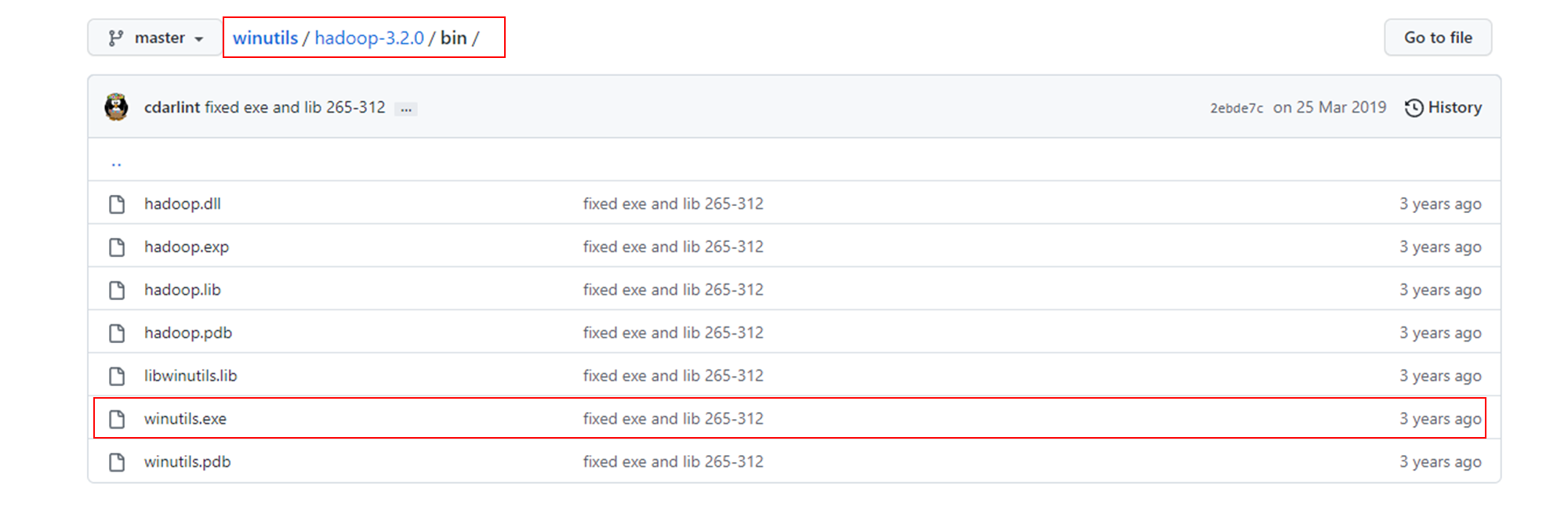

3. Winutils 다운로드

https://github.com/cdarlint/winutils

윈도우에서 spark를 실행하기 위해서는 하둡(winutils)를 다운받아야 합니다. .

자신이 설치한 하둡 버전에 맞는 것은 다운 받습니다. 저는 하둡 3.2 버전이니 3.2.0을 선택하겠습니다.

주의!! 스파크 버전이 아니라 하둡 버전에 맞춰야 합니다

winutils.exe 파일만 다운 받습니다. (winutils.exe에서 우클릭하여 "다른 이름으로 링크 저장"을 눌러 다운받거나, winutils.exe 클릭하고 "Download" 버튼을 눌러 다운받습니다)

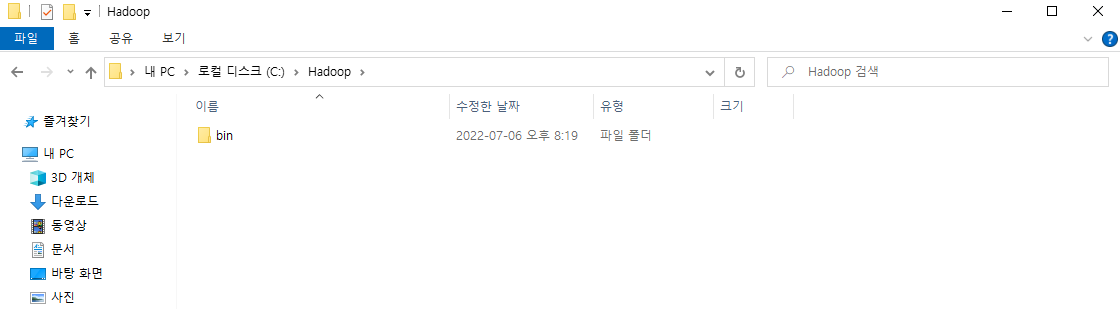

c:/에 Hadoop이라는 디렉토리를 하나 만들어 주고 내부에 bin 디렉토리를 하나 더 만들어 줍니다.

4. 환경변수 등록

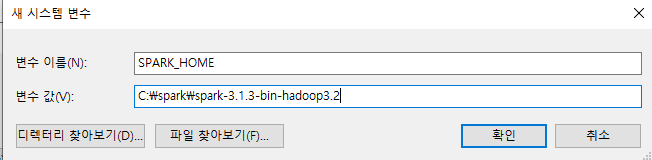

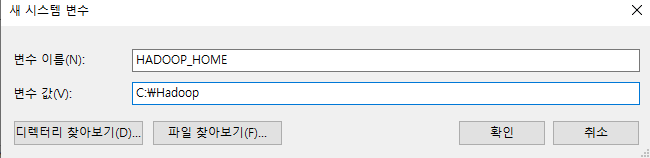

JAVA 설치했던 방법 그래도 "시스템 변수"-"새로 만들기"를 클릭하여 아래와 같이 환경변수를 등록합니다.

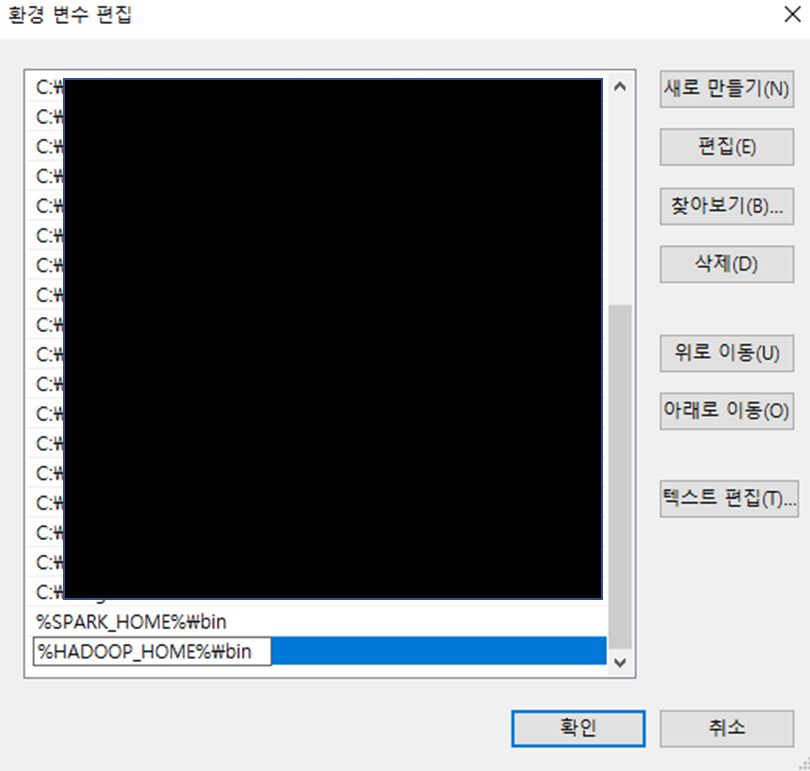

그리고 path에 아래처럼 환경변수를 등록해줍니다.

환경변수 등록 완료 후에 재부팅합니다.

5. pyspark 실행

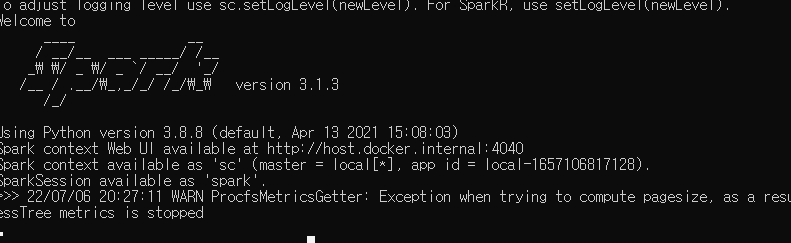

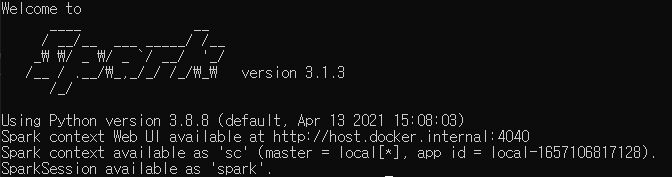

재부팅하고 바로 cmd를 켜서 pyspark를 입력해줍니다.

이렇게 뜨면 설치 성공입니다.

6. pyspark 설치

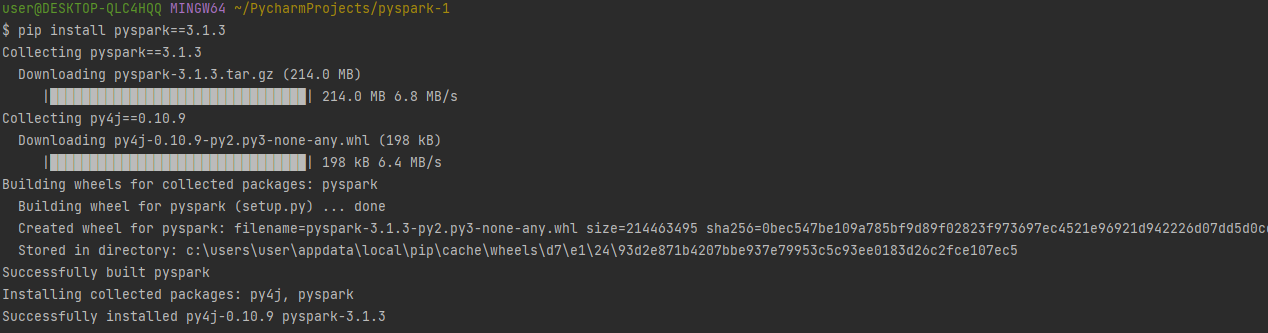

자신이 사용하는 IDE를 켜고 pyspark를 설치합니다.

pip install pyspark==3.1.3

pyspark 테스트

import pyspark

from pyspark import SparkConf

myconf = SparkConf()

spark = pyspark.sql.SparkSession.builder.getOrCreate()

test = [("1","kim","1993"),("2","park","1995")]

rdd = spark.sparkContext.parallelize(test)

print(rdd.collect())위 코드가 정상적으로 실행된다면, pyspark 로컬 개발 환경 구축을 완료!

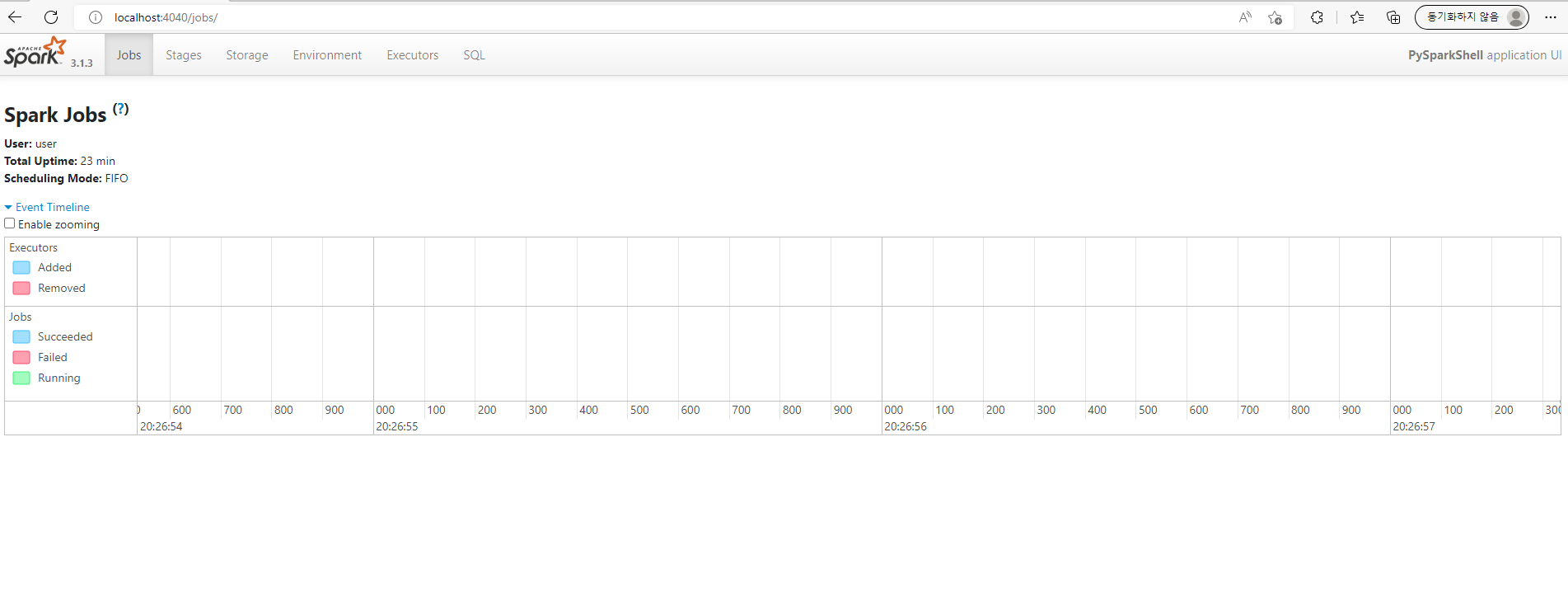

7. UI 접속

localhost:4040으로 접속하면 UI로 접속할 수 있습니다. 별도 설치 없이 자동으로 설치됩니다.