[Paper Review] TimeXer: Empowering Transformers for Time Series Forecasting with Exogenous Variables

Paper Review

목록 보기

1/1

Time Series Transformer with eXogenous variables

(외생 변수를 활용한 시계열 예측을 위한 트랜스포머 모델의 강화)

외생변수를 처음부터 잘못 이해해서 생각보다 오래걸렸다,,

Abstract

- 외생 변수는 내생 변수에 유용한 외부 정보를 제공할 수 있음

- 따라서 모든 변수를 동일하게 취급하거나 외생 정보를 무시하는 기존의 방식과는 달리, 해당 논문에서는 외생 변수를 사용한 시계열 예측에 초점을 맞춤

Introduction

- 외생변수 측면에서 외부 요인을 통합하면 다양한 변수간의 상관관계와 인과관계를 보다 포괄적으로 이해할 수 있음

- 외생변수는 정보를 제공하기 위한 목적으로 도입, 따라서 예측할 필요X

외생변수를 통한 효과를 보려면

- 내생 변수 내 시간적 종속성 파악

- 내생 변수와 외생 변수 간의 상관관계 파악

따라서 TimeXer에서는

- endogenous patch-level tokens을 적용하여 temporal dependecies 포착

- 불규칙한 외생 변수를 처리하기 위해 variate-level representations 채택

-> 내생 변수에 대한 외부 요인의 영향 수집 - 각 dendogenous series에 대해 학습 가능한 global tokens 도입

-> patch-level endogenous tokens와 variate-level exogenous tokens이 동시에 상호작용하는 거시적 정보 반영

(inspired by Vision Transforemr)

정리해보면

- 외생 변수의 보편성과 중요성에 착안하여, 표준 Transformer가 외생변수와 내생변수를 동시에 모델링 할 수 있도록 함

- patch-level and variate-level representations을 사용하는 TimeXer 제안

- 다리 역할을 하는 endogenous global token 사용

- 내생 변수 내 temporal dependencies와 외생 변수 간의 correlations을 함께 포착 가능

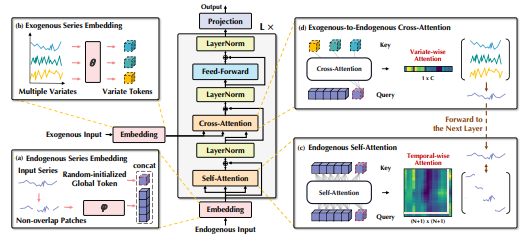

Structure Overview

- 구성요소를 수정하지 않고, 표준 Transformer의 용도를 변경

- 내생 변수와 외생 변수는 다양한 embedding 전략으로 조작

- temporal-wise와 variate-wise dependencies를 포착하기 위해 self-attention과 cross-attention을 채택

(a) : 내생 변수에 대해 여러 개의 temporal token과 하나의 global token 생성

(b) : 각 외생 변수는 variate token 생성

(c) : patch-wise dependencies를 포착하기 위해 내생 temporal tokens와 global token을 동시에 self-attention

(d) : 외부 정보를 통합하기 위해 내생변수와 외생변수를 cross-attention