- GFLOP(Giga Floating-point Operations Per Second)는

- 수십억(10^9) 개의 부동 소수점 연산을 의미하며,

- 초당 수행할 수 있는 부동 소수점 연산의 수를 나타냅니다.

부동 소수점 연산(Floating-Point Operation)

- 부동 소수점 연산에는 덧셈, 뺄셈, 곱셈, 나눗셈과 같은 실수 연산이 포함됩니다.

- 예를 들어, (a * b + c) 같은 연산이 부동 소수점 연산에 해당합니다.

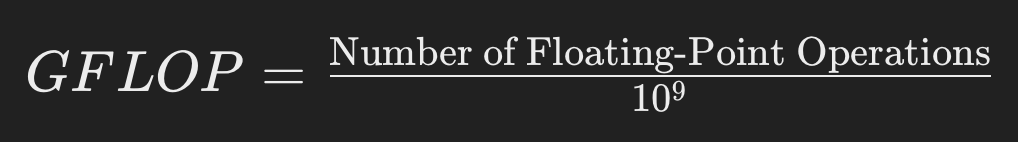

GFLOP 수식

GFLOP는 다음과 같은 수식으로 정의됩니다:

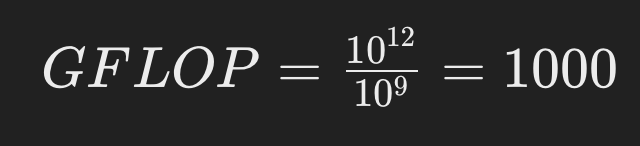

예시

어떤 딥러닝 모델이 10^12번의 부동 소수점 연산을 수행해야 한다고 가정해보겠습니다. 이 경우의 GFLOP는 다음과 같이 계산됩니다:

즉, 1000 GFLOP는 1조 번의 부동 소수점 연산을 의미합니다.

딥러닝에서의 GFLOP

딥러닝 모델의 훈련과 추론 과정에서는 대규모의 매트릭스 곱셈 및 기타 수치 연산이 포함되므로 GFLOP가 모델의 복잡도와 계산 비용을 평가하는 중요한 지표가 됩니다. 예를 들어, 하나의 합성곱 신경망(CNN)의 단일 합성곱 레이어에서 수행되는 연산량을 계산할 때 다음과 같은 요소들이 포함됩니다:

- 입력 텐서의 크기

- 커널(필터)의 크기

- 출력 텐서의 크기

- 스트라이드 및 패딩과 같은 추가적인 파라미터들

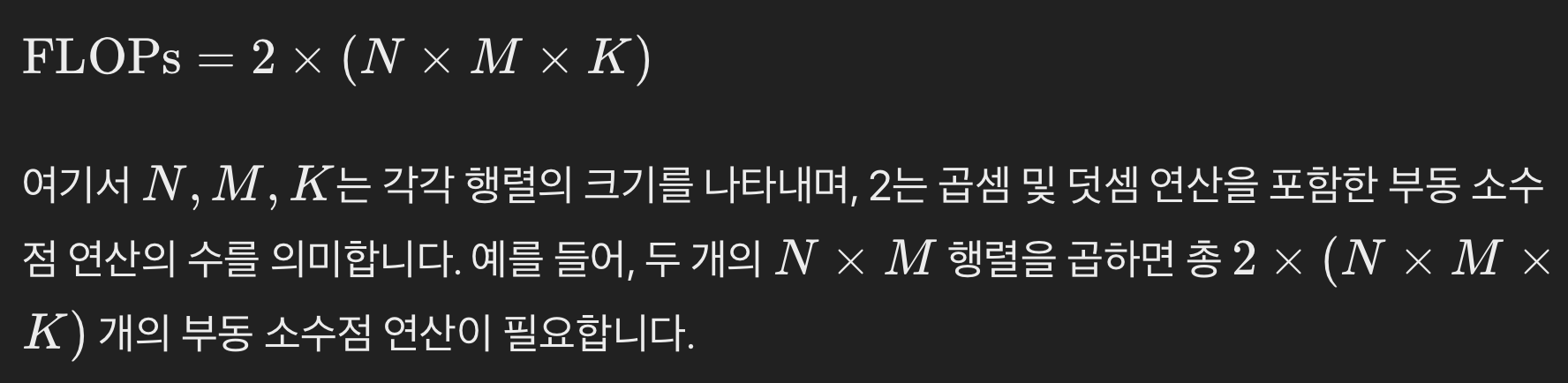

전문적인 설명

부동 소수점 연산의 수는 일반적으로 다음 수식으로 나타낼 수 있습니다:

이러한 연산이 GFLOP 단위로 변환될 때, 해당 연산을 10^9으로 나누어 성능 지표로 사용됩니다. 딥러닝 연구와 개발에서 GFLOP는 모델 최적화, 하드웨어 요구사항 분석 및 성능 평가에 필수적인 역할을 합니다.