1. Masked Modeling

딥러닝 분야에서 "Masked Modeling"은 주로 자연어 처리(NLP) 분야에서 사용되는 학습 기법입니다. 이 방법은 특히 비지도 학습(unsupervised learning)의 형태로, 텍스트 데이터에서 일부 단어나 토큰을 '마스킹(가리기)'한 후, 이 마스킹된 부분을 모델이 예측하도록 하는 과정을 말합니다. Masked Modeling은 언어 모델의 컨텍스트 이해 능력을 향상시키는 데 사용됩니다.

Masked Modeling의 주요 개념

-

데이터 준비:

- 텍스트 데이터에서 무작위로 일부 단어나 토큰을 선택하여 마스킹합니다. 예를 들어, 문장 "I like to eat apples"에서 "eat"를 마스킹하면, "I like to [MASK] apples"가 됩니다.

-

모델 학습:

- 마스킹된 단어를 예측하기 위해, 모델은 주변 단어들의 컨텍스트를 이해해야 합니다. 모델은 마스킹된 단어가 무엇인지 예측하려고 합니다.

-

컨텍스트 기반 학습:

- 이 학습 방식은 모델이 단어의 전후 문맥을 모두 고려하여 단어의 의미를 파악하도록 돕습니다. 이는 모델이 더 풍부한 언어 이해를 개발하는 데 중요합니다.

Masked Modeling의 예시

- BERT (Bidirectional Encoder Representations from Transformers):

- BERT는 Masked Modeling을 사용하는 가장 유명한 예시 중 하나입니다. BERT는 텍스트의 양방향 컨텍스트를 학습하며, 이를 통해 문맥상의 의미를 더 잘 이해할 수 있습니다.

Masked Modeling의 장점

-

양방향 컨텍스트 이해:

- 전통적인 언어 모델은 텍스트를 한 방향(왼쪽에서 오른쪽 또는 그 반대)으로만 처리합니다. Masked Modeling은 모델이 양방향 컨텍스트를 고려하도록 하여, 더 정확한 언어 이해를 가능하게 합니다.

-

풍부한 언어 표현 학습:

- 다양한 문맥에서 단어의 사용법을 학습함으로써, 모델은 단어와 구문의 의미를 더 깊이 있게 파악할 수 있습니다.

-

유연한 응용:

- Masked Modeling으로 학습된 모델은 다양한 NLP 태스크(예: 텍스트 분류, 질문 응답, 기계 번역 등)에 적용될 수 있습니다.

Masked Modeling은 NLP 분야에서 매우 중요한 기법으로, 모델이 텍스트를 보다 정교하게 이해하고 처리할 수 있도록 하는 데 기여합니다.

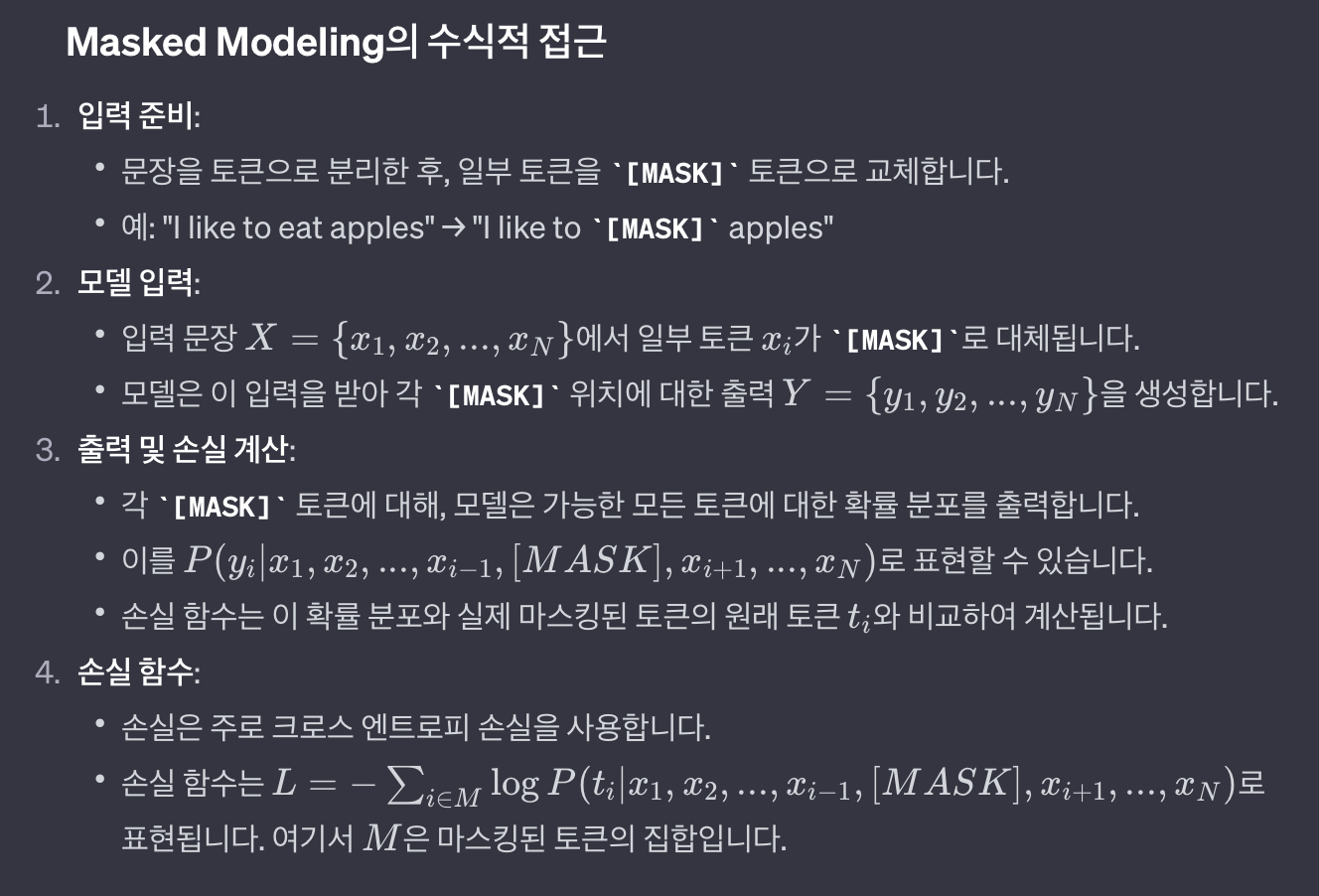

2. Masked Modeling의 수학적 설명

Masked Modeling, 특히 자연어 처리(NLP) 분야에서 사용되는 BERT와 같은 모델에서, 수학적으로 정확한 공식을 제공하기는 어렵습니다. 왜냐하면, 이러한 모델들은 주로 복잡한 신경망 구조와 알고리즘을 기반으로 하며, 그들의 동작을 단순한 수학적 공식으로 축약하기 어렵기 때문입니다. 그러나, Masked Modeling의 기본 원리를 간략하게 수식적으로 설명할 수는 있습니다.

Masked Modeling의 수식적 접근

주의점

- 이러한 과정은 매우 단순화된 설명입니다. 실제로 BERT와 같은 모델은 Transformer 구조를 사용하며, 각 토큰의 표현은 인코더의 여러 층을 통해 계산됩니다.

- 또한, 실제 구현에서는 마스킹된 토큰, 랜덤한 다른 토큰, 원래 토큰을 유지하는 등 다양한 전략이 사용됩니다.

Masked Modeling은 모델이 텍스트의 복잡한 구조와 문맥을 이해하도록 돕는 고급 기술입니다. 이는 특히 텍스트의 양방향 컨텍스트를 파악하는 데 중요한 역할을 합니다.

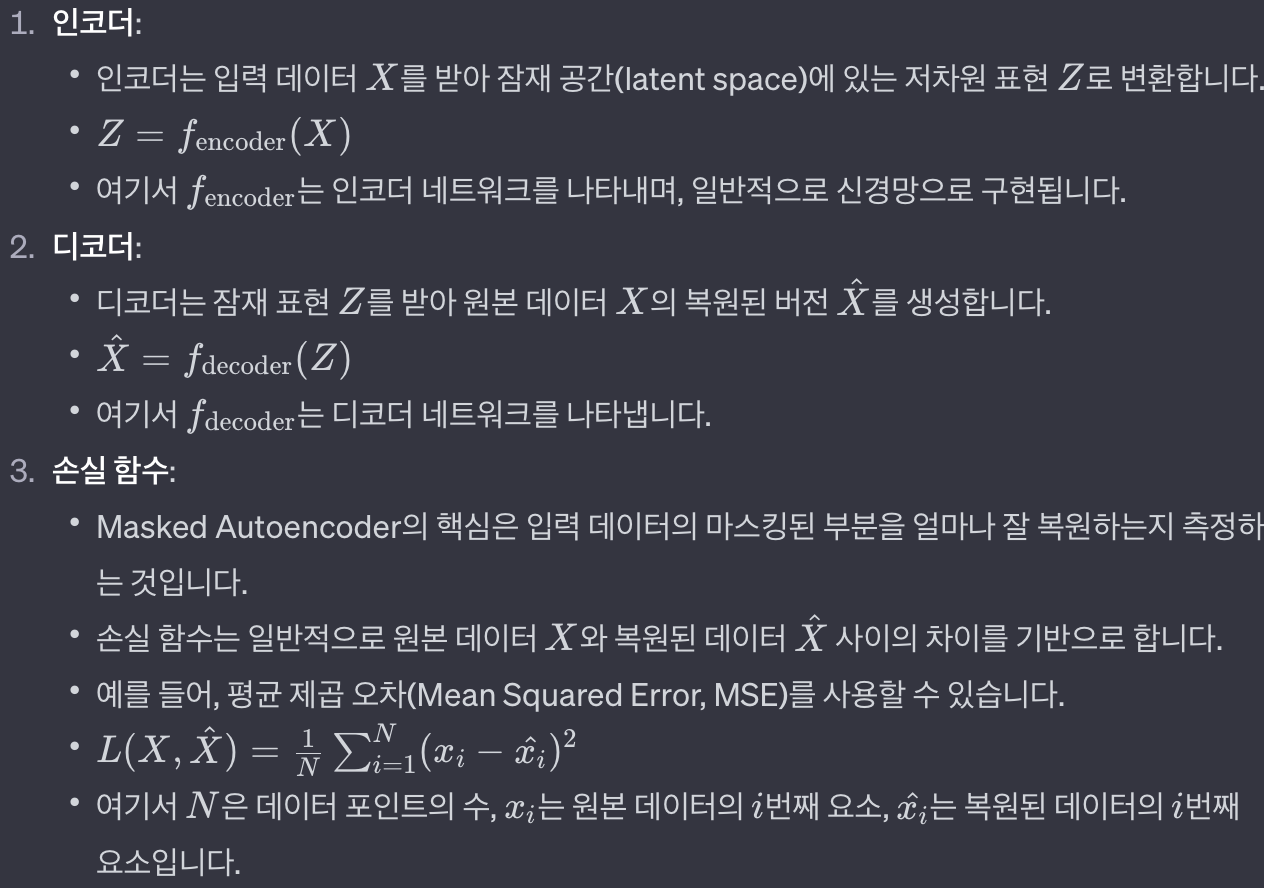

3. Masked AutoEncoder의 수학적 설명

- Masked Autoencoder (오토인코더)는 딥러닝에서 입력 데이터의 중요한 특징을 학습하기 위해 사용되는 네트워크 구조입니다. 이 구조는 일반적으로 두 부분으로 나뉩니다: 인코더(encoder)와 디코더(decoder). Masked Autoencoder의 경우, 입력 데이터의 일부가 마스킹(가림)되어 있으며, 네트워크의 목표는 마스킹된 부분을 복원하는 것입니다.

Masked Autoencoder의 수학적 표현

Masked Autoencoder의 특징

- 마스킹: 입력 데이터의 일부를 의도적으로 가림(마스킹)하여, 네트워크가 데이터의 중요한 특징을 학습하고, 이를 바탕으로 가려진 부분을 추측하도록 합니다.

- 자기 지도 학습: 이 방법은 레이블이 없는 데이터를 사용하여 모델을 학습시키는 자기 지도 학습의 한 예입니다. 모델은 입력 데이터 자체에서 학습 목표를 추출합니다.

Masked Autoencoder는 특히 데이터의 중요한 특징을 추출하고, 이를 사용하여 데이터를 압축하거나 재구성하는 데 유용합니다. 이러한 방식은 이미지 처리, 음성 인식, 그리고 텍스트 데이터의 표현 학습 등 다양한 분야에서 응용됩니다.

4. Masked Modeling과 MAE의 관계

- 딥러닝 분야에서 "Masked Modeling"과 "Masked Auto Encoding"은 서로 관련된 개념이지만, 몇 가지 중요한 차이점이 있습니다. 이 둘은 모두 입력 데이터의 일부를 마스킹(가리기)하고 이를 모델을 통해 복원하려는 시도를 포함합니다. 이러한 접근 방식은 주로 자연어 처리(NLP)와 이미지 처리 분야에서 볼 수 있습니다.

Masked Modeling

- 주 사용 분야: 주로 NLP에서 사용됩니다.

- 작동 원리: 문장에서 무작위로 단어를 마스킹하고, 모델이 이 마스킹된 단어를 문맥 정보를 바탕으로 예측하도록 합니다.

- 대표적인 예: BERT(Bidirectional Encoder Representations from Transformers) 모델이 이 기법을 사용합니다. BERT는 마스킹된 단어를 주변 단어의 양방향 컨텍스트를 사용하여 예측합니다.

- 목적: 문장에서 마스킹된 단어의 정확한 예측을 통해, 모델이 언어의 복잡한 구조와 의미를 더 잘 이해하도록 돕습니다.

Masked Auto Encoding

- 주 사용 분야: NLP뿐만 아니라 이미지 처리에서도 사용됩니다.

- 작동 원리: 데이터의 일부를 마스킹하고, 오토인코더(autoencoder) 구조를 사용하여 원본 데이터를 복원합니다.

- 예시: 이미지 처리에서 마스킹된 픽셀을 복원하거나, NLP에서 마스킹된 단어를 복원하는 작업이 여기에 해당합니다.

- 목적: 모델이 데이터의 중요한 특징을 학습하고, 데이터 복원을 통해 이러한 특징을 보다 효과적으로 표현할 수 있도록 하는 것입니다.

두 기법의 관계

- 유사점: 두 방법 모두 마스킹 기법을 사용하여 모델이 데이터의 중요한 특징을 학습하고 이해하도록 합니다. 이 과정은 모델이 데이터의 내재된 구조와 패턴을 인식하게 하며, 결과적으로 더 나은 표현 학습을 가능하게 합니다.

- 차이점: 주된 차이점은 그들이 사용되는 컨텍스트와 구체적인 목적에 있습니다. Masked Modeling은 주로 문맥적 언어 이해에 초점을 맞추고, BERT와 같은 언어 모델에 사용됩니다. 반면, Masked Auto Encoding은 데이터 복원의 관점에서 접근하며, 오토인코더 구조를 사용하는 다양한 응용 분야에서 활용됩니다.

이 두 접근 방식은 딥러닝에서 데이터의 복잡한 특징을 추출하고 이해하는 데 중요한 역할을 합니다.

5. Masked Modeling과 MAE를 비디오 인풋에 적용하는 방법

- 비디오 데이터셋에 Masked Modeling과 Masked Autoencoder를 적용하는 것은 비디오의 시간적 및 공간적 특성을 이해하는 데 중요한 역할을 합니다. 비디오 데이터는 단순한 이미지보다 더 복잡한 구조를 가지고 있기 때문에, 이를 처리하기 위해서는 시간적 연속성과 공간적 특성을 모두 고려해야 합니다.

1. Masked Modeling in Video Dataset

Masked Modeling은 주로 자연어 처리에 사용되지만, 비디오 데이터에도 응용될 수 있습니다.

-

데이터 준비:

- 비디오를 프레임(이미지)의 시퀀스로 분해합니다.

- 각 프레임에서 일부 영역(예: 픽셀 블록)을 임의로 마스킹합니다. 또는, 전체 프레임을 마스킹할 수도 있습니다.

-

모델 학습:

- Masked Modeling을 위한 모델(예: 3D 컨볼루션 신경망)을 사용하여, 마스킹된 영역을 예측하도록 합니다.

- 모델은 마스킹된 프레임의 시각적 컨텍스트와 인접 프레임의 정보를 활용하여 마스킹된 영역을 복원하려고 시도합니다.

-

목적:

- 이 방식은 모델이 비디오 내의 시간적 및 공간적 컨텍스트를 이해하도록 돕습니다.

2. Masked Autoencoder in Video Dataset

Masked Autoencoder는 비디오 데이터의 공간적 및 시간적 특성을 압축하고 복원하는 데 사용될 수 있습니다.

-

데이터 준비:

- 비디오를 프레임 시퀀스로 분해합니다.

- 각 프레임이나 일부 프레임에서 픽셀을 임의로 마스킹합니다.

-

인코더와 디코더:

- 인코더는 마스킹된 비디오 프레임을 입력받아 저차원의 잠재 표현으로 변환합니다.

- 디코더는 이 잠재 표현을 사용하여 원본 프레임을 복원합니다.

-

모델 학습:

- 손실 함수(예: 평균 제곱 오차)를 사용하여, 원본 프레임과 복원된 프레임 간의 차이를 최소화하도록 학습합니다.

-

목적:

- Masked Autoencoder는 비디오 데이터의 중요한 특징을 학습하고, 이를 통해 고품질의 복원을 달성하는 데 목적이 있습니다.

응용 분야

- 비디오 복원 및 개선: 손상된 비디오의 품질을 향상시키거나, 누락된 부분을 복원하는 데 사용됩니다.

- 압축: 비디오의 중요한 정보를 보존하면서 데이터를 압축합니다.

- 이상 탐지: 정상적인 패턴에서 벗어난 프레임이나 시퀀스를 식별하는 데 활용될 수 있습니다.

비디오 데이터셋에 Masked Modeling과 Masked Autoencoder를 적용하는 것은 모델이 복잡한 시간적 및 공간적 정보를 이해하고, 이를 기반으로 예측 및 복원 작업을 수행할 수 있도록 돕습니다.