[2020 CVPR] AugFPN: Improving Multi-scale Feature Learning for Object Detection

Paper Info.

Abstract

-

SOTA detectors들은 일반적으로 feature pyramid를 활용하여 다양한 scales의 object를 detect한다.

그러나 FPN의 design defects로 인해 multi-scale features를 충분히 활용하는 데 한계가 존재한다. -

본 논문에서,

우리는 FPN의 the design defects of feature pyramid를 분석하고,

a new feature pyramid architecture named AugFPN을 제안한다. -

AugFPN은 three components로 구성된다:

- Consistent Supervision:

AugFPN은 Consistent Supervision을 통해 feature fusion 전 서로 다른 scales 간의 features 사이의 semantic gaps을 줄인다. - Residual Feature Augmentation

feature fusion에서, highest pyramid level에서 feature map의 information loss를 줄이기 위해

Residual Feature Augmentation에 의해 ratio-invaraint context information이 추출된다. - Soft RoI Selection

마지막으로, feature fusion 이후에 a better RoI feature를 adaptively 학습하기 위해 RoI Selection이 사용된다.

- Consistent Supervision:

1. Introduction

-

FPN은 ConvNet의 inherent feature hierarchy 하에

high levels로 부터 얻은 semantically strong features로부터 features at lower levels로 propagating함으로써

구성된다.

multi-scale features with strong semantics을 향상시킴으로써, OD의 성능이 향상되지만 -

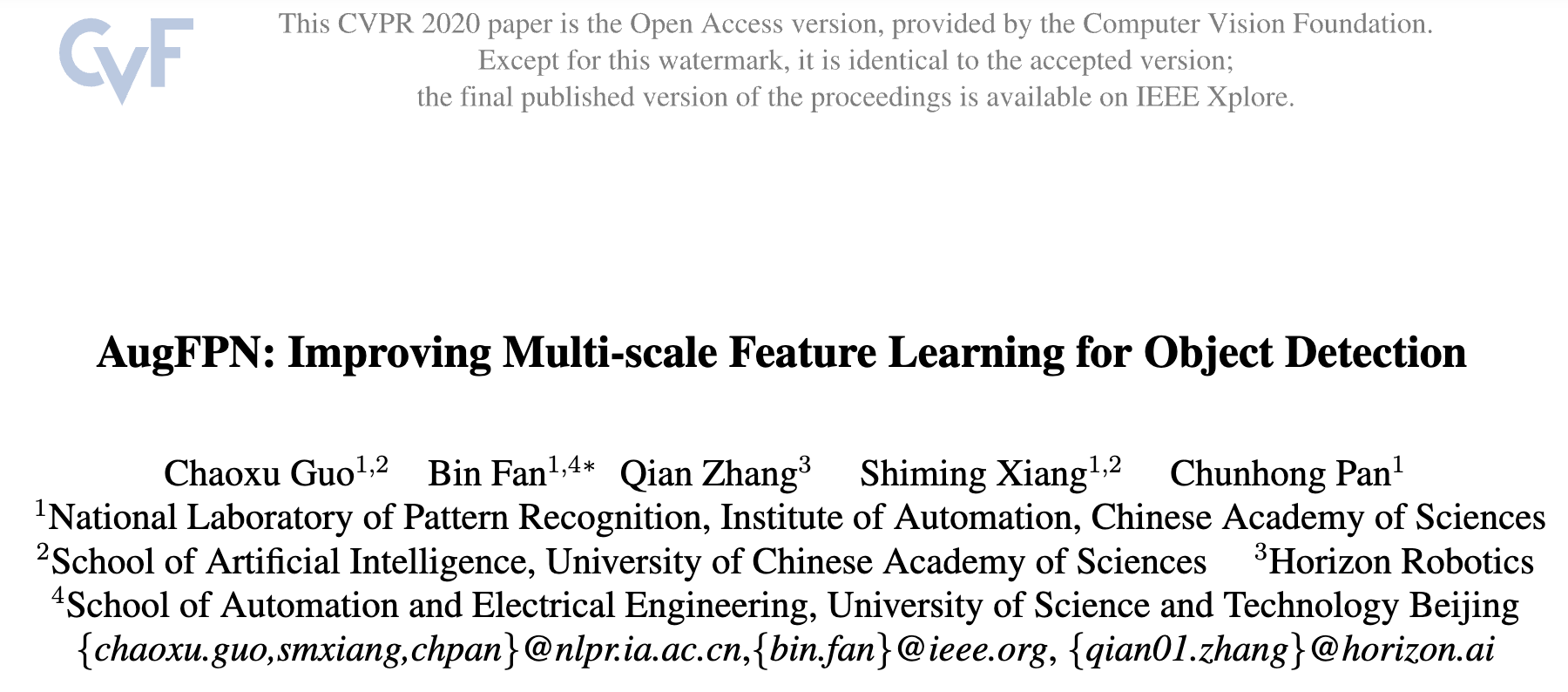

there exist some design defects within the feature pyramid in FPN

기본적으로, FPN의 feature pyramid는 3가지 stages로 구분할 수 있다.

- stage 1: before feature fusion

- stage 2: top-down feature fusion

- stage 3: after feature fusion

-

우리는 각 stage에서 intrinstic flaw가 있다는 것을 발견했다.

- Semantic gaps between features at different levels

- Information loss of the highest-level feature map

- Heuristic assignmment strategy of RoIs

문제1: Semantic gaps between features at different levels

- before feature fusion,

features at different levels는 feature channels을 줄이기 위해 1x1 conv layer를 독립적으로 수행한다.

그런데, these features들 간의 the large semantic gaps은 고려되지 않는다.

these features들을 directly fusing하는 것은 inconcsistnet semantic information 때문에 multi-scale feature representation의 power가 degrade될 수 있다.

문제2: Information loss of the highest-level feature map

-

In feature fusion,

higher-level features의 stronger semnatic information이 low-level features로 전달되면서 features는 improved될 수 있다.

하지만 그 대신에 the feature at the highest pyramid level은 the reduced channels로 인해 information을 lose하게 된다. -

이를 완화하기 위해 global pooling을 이용하여 global context feature [30]를 combining하는 방법이 있다.

하지만 이러한 strategy는 하나의 feature map을 one single vector로 fusing하기 때문에,

spatial relation and details이 lose될 수 있다.

문제3: Heuristic assignmment strategy of RoIs

- after feature fusion,

각 object proposal은 하나의 feature level에서 pooled된 feature grids를 기반으로 refine된다.

이때, 선택된 feature level은 제안된 objects의 scales에 따라 heuristically 결정된다.

그러나 다른 levels에서 무시된 features들 또한 object classification or regression에 유용할 수 있다.

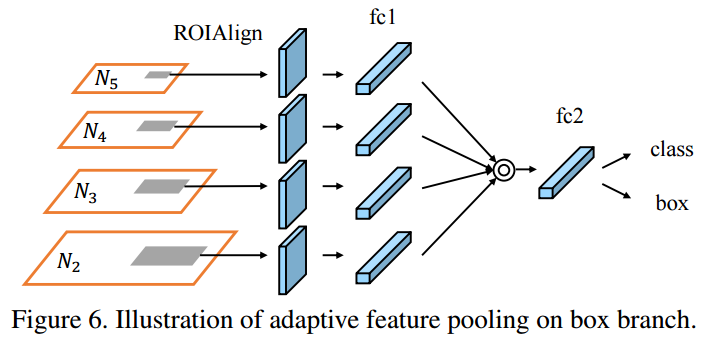

이를 해결하기 위해 PANet [25]은 모든 pyramid level에서 RoIs features를 pools한 후, independent fc layers를 거쳐 max operation을 fuse하는 방식을 사용한다.

하지만 max fusion은 smaller response를 갖는 features를 무시할 수 있으며, 무시된 features들은 helpful할 수도 있다.

또한, 여전히 다른 levels의 정보를 완전히 활용하지 못하는 문제가 존재한다.

한편, the extra fc layers는 model의 #params을 크게 증가시키는 단점도 있다.

2. Related Work

Deep Object Detectors

- two-stage detectors, one-stage detectors 설명과 비교

(생략)

Deep Supervision

- we apply the instance-level supervision signals on features at all pyramid levels after lateral connection,

aiming to narrow the semantic gaps between them and make the features more suitable for subsequent feature summation.

Context Exploitation

-

Deeplab-v2는 multi-scale context를 extract하기 위해 atrous conv를 제안했고

PSPNet은 hierarchical global context를 얻기 위해 pyramid pooling을 사용했다.

두 방법은 the quality of semantic segmentation을 크게 향상시켰다. -

그들과 다르게, 우리는 diverse spatial context information을 생성하기 위한 ratio-invariant adaptive pooling을 수행하고

the highest pyramid level에서 feature의 channels의 information loss를 residual way로 줄였다.

Strategy of RoI Assignment

- FPN은 the scales of RoIs에 따라, one certain pyramid level로부터 RoI features를 pool한다.

그러나 two proposals with a similar scale은 이 strategy 하에서 서로 다른 feature levels에 할당될 수 있어서 sub-optimal results를 만들지도 모른다.

- 이를 해결하기 위해 PANet은 모든 pyramid level에서 RoI features를 pool한 후,

fc layers로 adapting을 통해 max operation으로 fuse한다. (?)- 몰랐던 점:

PANet은 원래 adaptive feature pooling을 제안하며,

이를 통해 feature grid와 모든 feature level을 연결하여 가 level의 유용한 정보가 직접 proposal subnetworks로 propagate 도록 하는게 목적.

(아래 그림 출처: https://deep-learning-study.tistory.com/637)

(아래 그림 출처: https://deep-learning-study.tistory.com/637)

- 몰랐던 점:

- PANet과 우리 연구의 주요 차이점은,

우리는 data-dependent way로 adpative weights를 생성하여 모든 level에서 feature를 흡수하도록 설계했다.

이를 통해 다양한 levels의 features를 더욱 효과적으로 활용할 수 있다.

또한, 우리 방법은 RoI features를 adapt하기 위해 필요한 extra fc layers를 사용하지 않기 때문에 rewer parameters만 요구된다.

- 몰랐던 점:

PANet은 원래 adaptive feature pooling을 제안하며,

이를 통해 feature grid와 모든 feature level을 연결하여 가 level의 유용한 정보가 직접 proposal subnetworks로 propagate되도록 하는게 목적.

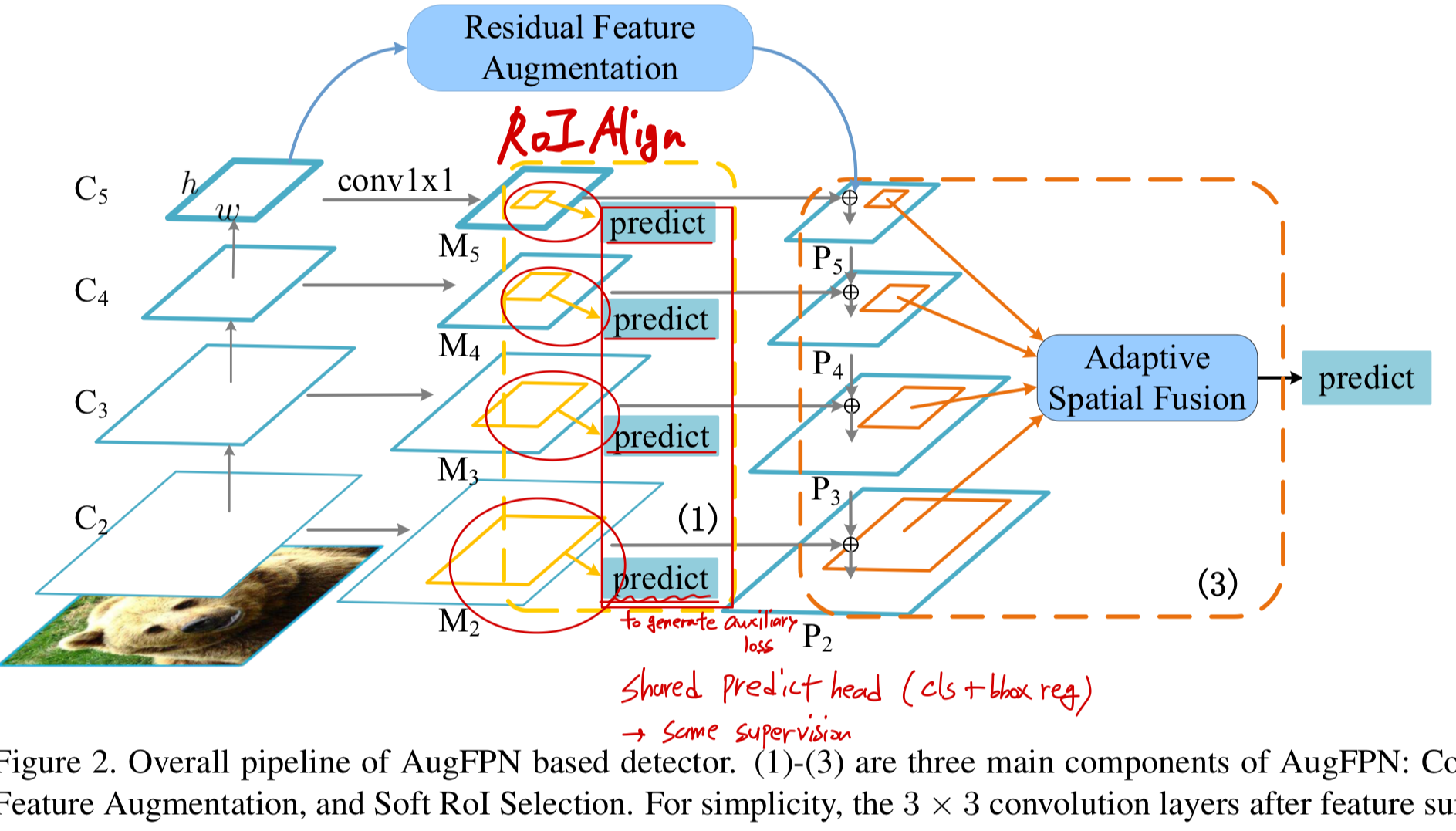

3. Methodology

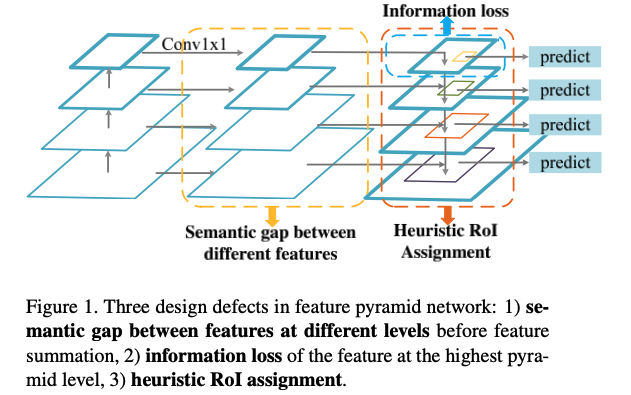

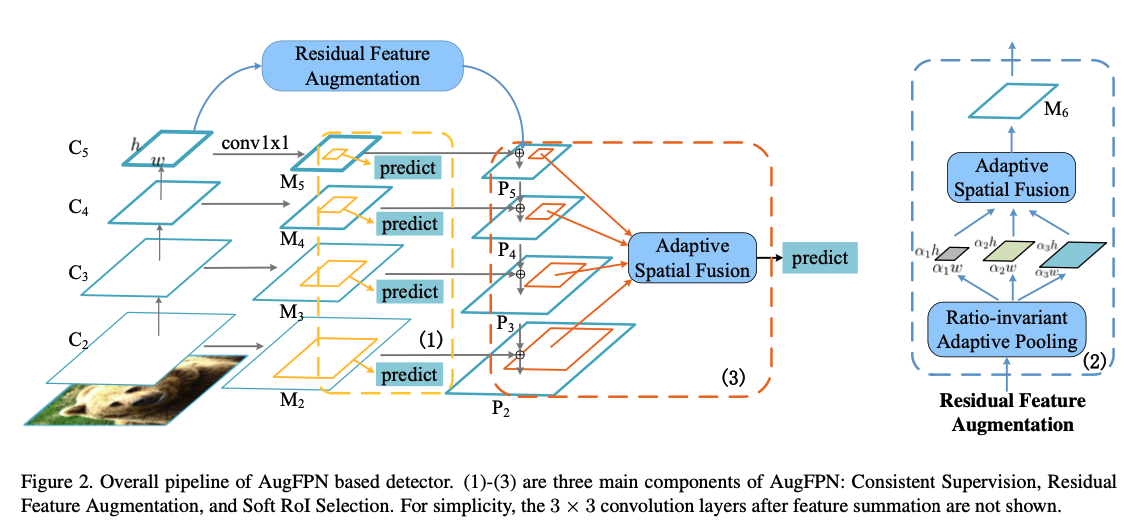

- The overall framework of AugFPN.

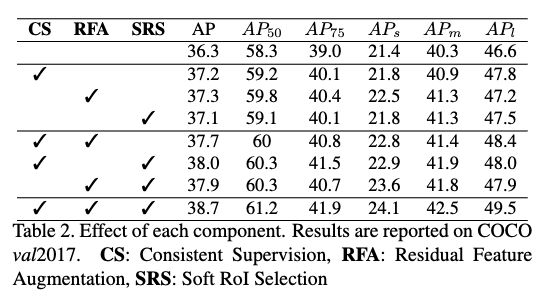

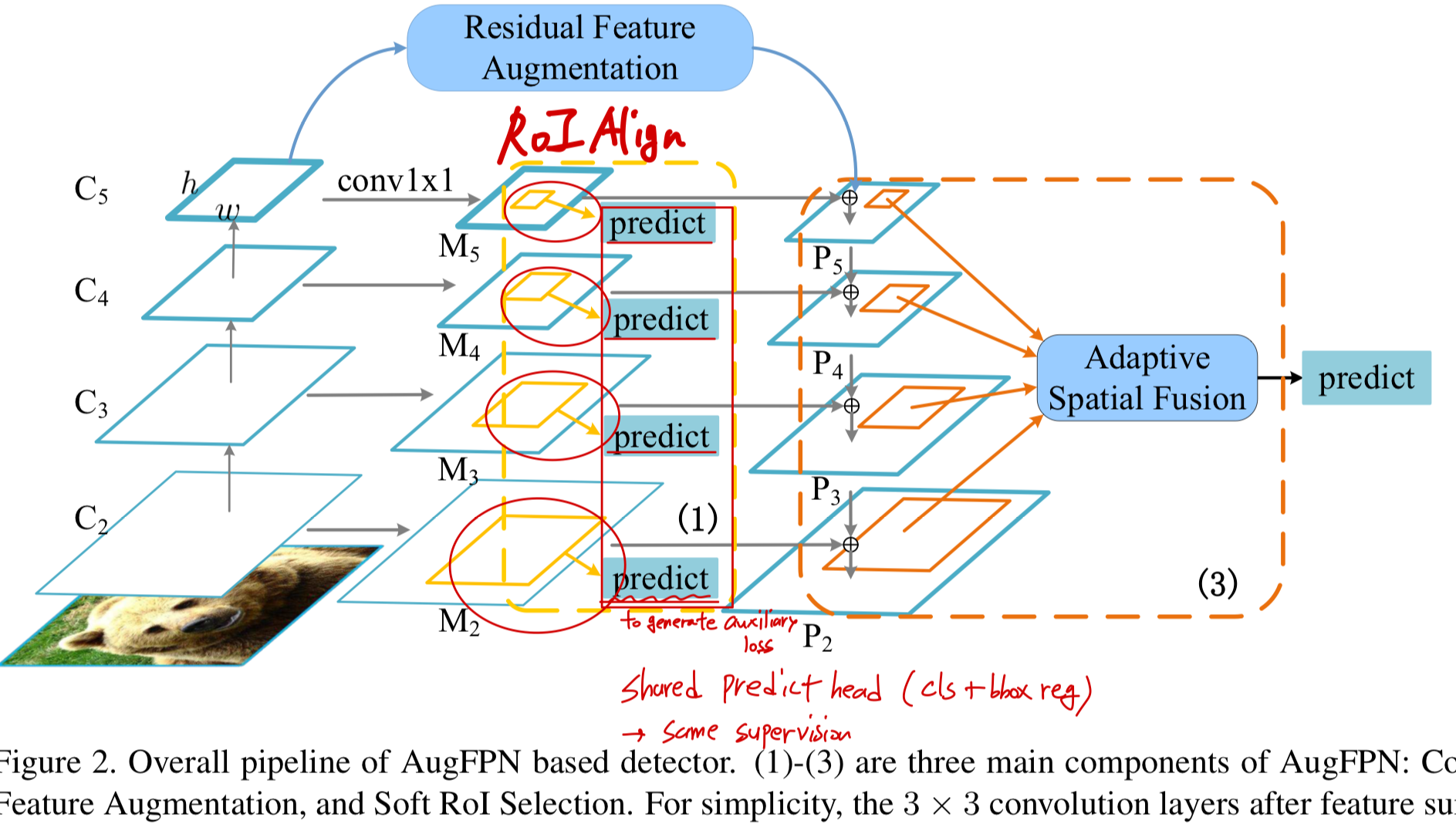

3.1. Consistent Supervision

(문제점)

- the features with different scales contain information at different abstract levels

and there exist large semantic gaps between them.

fusing multiple features with large semantic gaps would lead to a sub-optimal feature pyramid.

(아이디어)

- 위 문제로 인해 fusion 이전에 multi-scale features에 대한 the same supervision signals을 도입하는 Consistent Supervision을 제안한다.

(내 생각: 위 문제로 인해 multi-scale features에 같은 supervision signals을 도입하는게 어떤 의미? 그러면 large semantic gap이 사라지나?)

(detail)

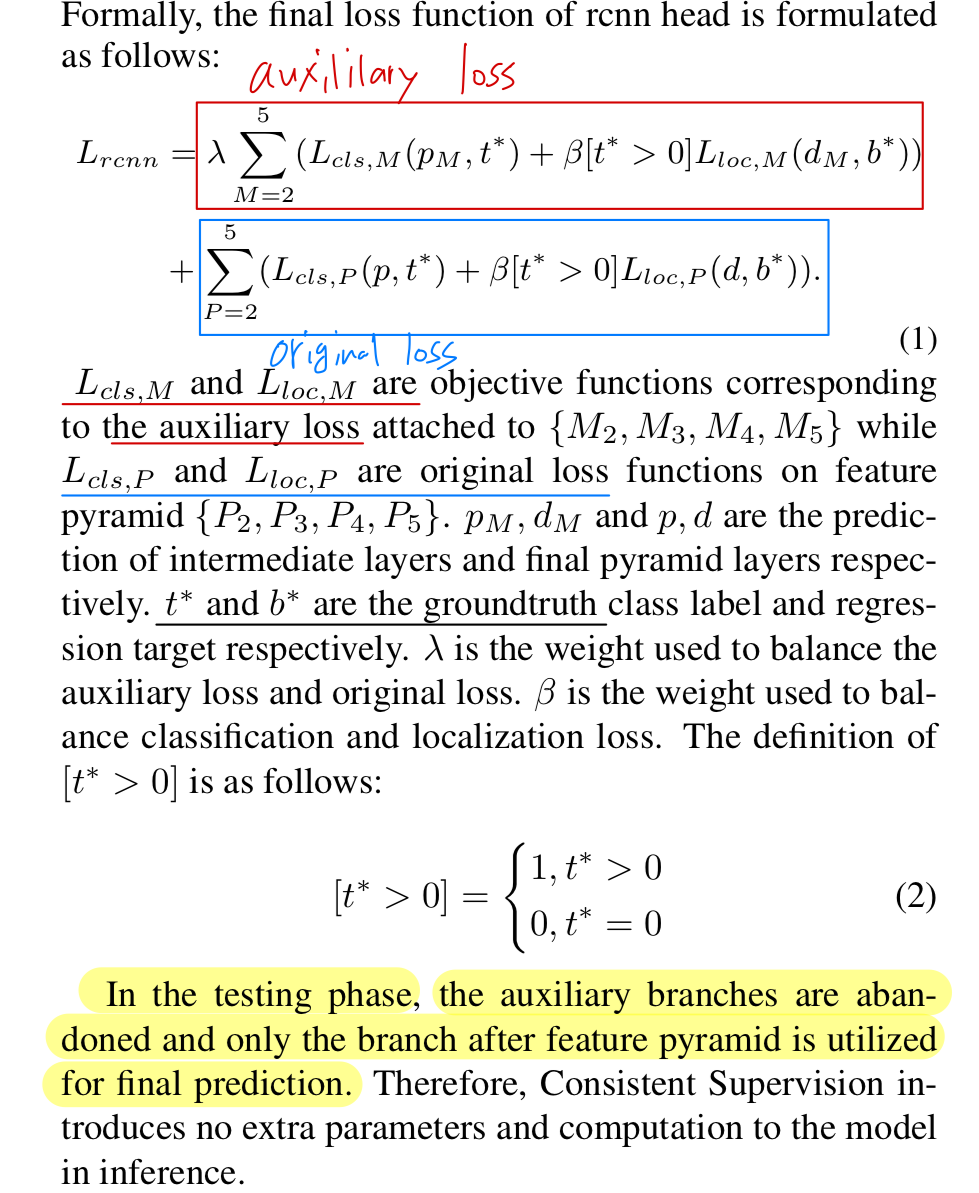

- Consistent Supervision을 수행하기 위해,

each RoI는 all feature levels에 mapped되며,

RoI-Align [13]을 사용하여 의 각 level로부터 RoI feature가 추출된다.

그 후에, multiple class and box reg heads가 auxiliary loss를 만들기 위해 these features들에 붙여진다.

The params of these class and box reg heads는 shared되고,

이는 the same supervision signals로 인해 서로 다른 feature maps이 similar semantic information을 학습하도록 유도된다.

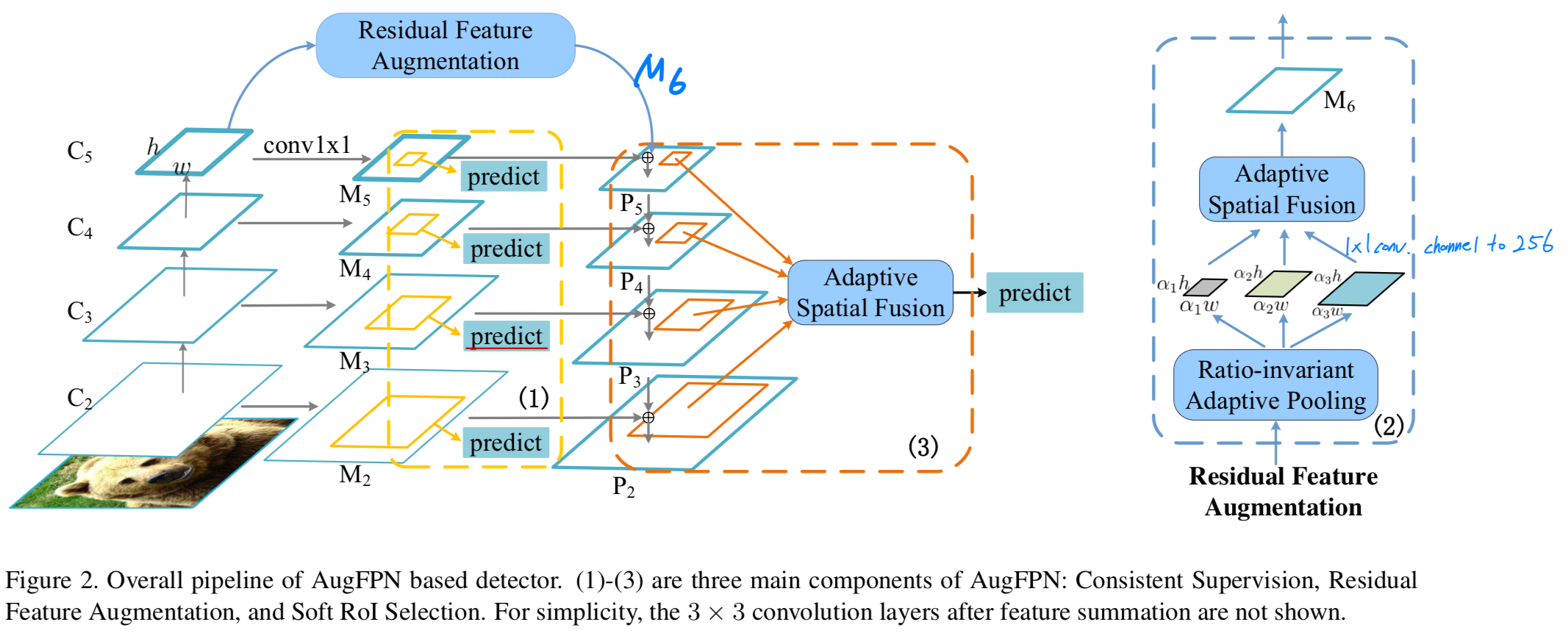

3.2. Residual Feature Augmentation

-

는 the reduced feature channels 때문에 information loss가 발생하고

single scale의 context information만 포함되어 다른 level에서 나온 features들과 호환되지 않는 (not compatible with) 문제가 있다. -

그래서, 우리는 Residual Feature Augmentation을 제안하여 의 feature representation을 개선하고자 한다.

이는 residual branch를 활용하여 original branch에 diverse spatial context information을 instill (주입)하는 방식이다.

우리는 the spatial context information이 the information loss in channels of 을 줄이고,

그에 따라 생성된 feature pyramid의 performance를 동시에 향상시킬 것이라고 기대한다. -

이를 위해,

- 먼저 scale이 인 에 ratio-invariant adaptive pooling을 수행함으로써

에서 의 다양한 scales을 가진 multiple context features를 생성한다. - 그 다음 각 context feature에 1 x 1 conv를 하여 feature channel dimension을 256으로 줄인다.

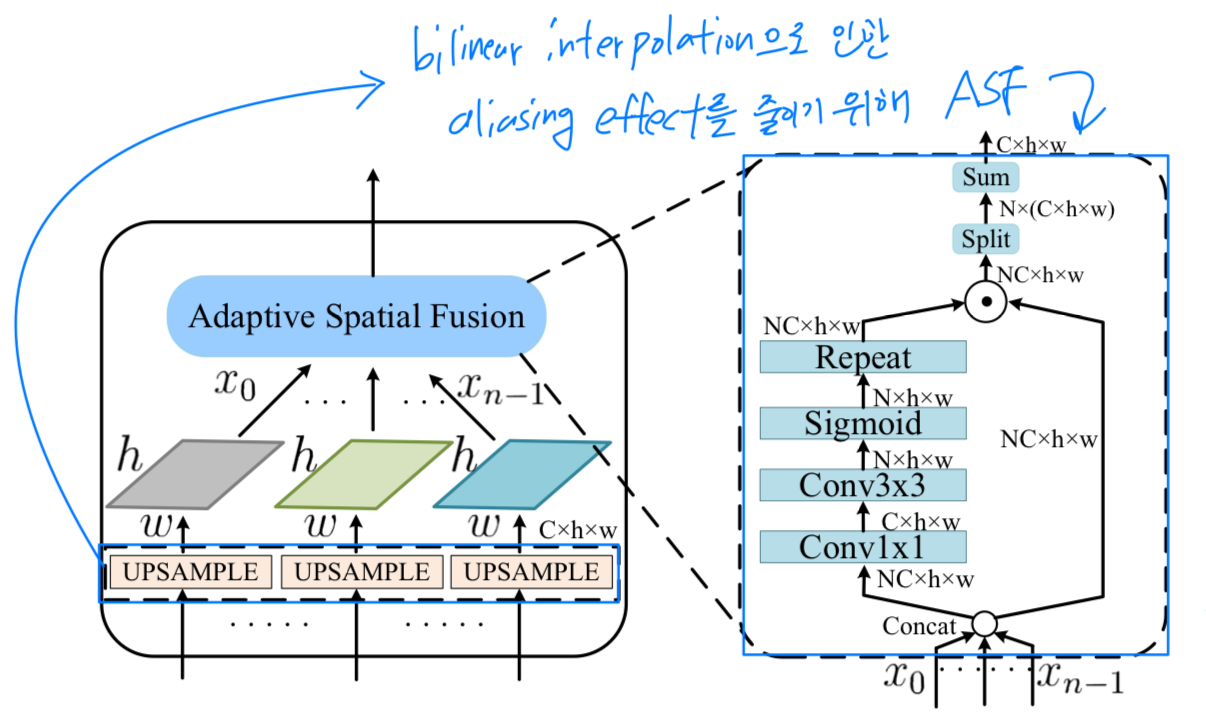

- 마지막으로, subsequent fusion을 위해 scale로 bilinear interpolation을 통해 upsampled된다.

interpolation으로 인한 aliasing effect를 고려하여,

우리는 simple summation 대신 이러한 context features들을 adaptively combine할 수 있는 Adaptive Spatial Fusion (ASF) module을 design했다.

- 먼저 scale이 인 에 ratio-invariant adaptive pooling을 수행함으로써

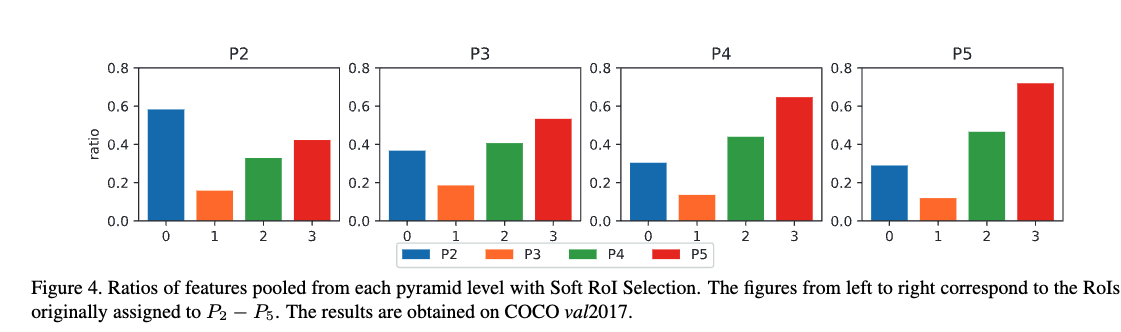

3.3. Soft RoI Selection

-

PANet은 모든 level에서 RoI features를 pooling한 후, fc layers를 사용하여 RoI features를 조정하고, 그중 maximum값을 선택하여 proposal을 refine했다.

max 연산은 the highest responses만 선택하고, 다른 level에서 상대적으로 lower responses을 보이는 features들은 무시하는데, 이들 역시 recognition에 유용할 수 있다.

이로 인해 서로 다른 level의 feature를 충분히 활용하지 못하는 문제가 발생할 수 있다. -

따라서 우리는 Soft RoI Selection을 제안한다.

이는 RoI pooling 과정을 parameterizing하여, 모든 pyramid level에서 얻은 features로부터 better RoI features를 학습하도록 한다.

Soft RoI Selection은 adaptive weights를 도입하여, 각 level에서 RoI region 내 the importance of feature를 더 잘 측정한다.

final RoI features는 heuristic RoI assignment or max operation이 아니라, adaptive weights를 기반으로 생성된다.

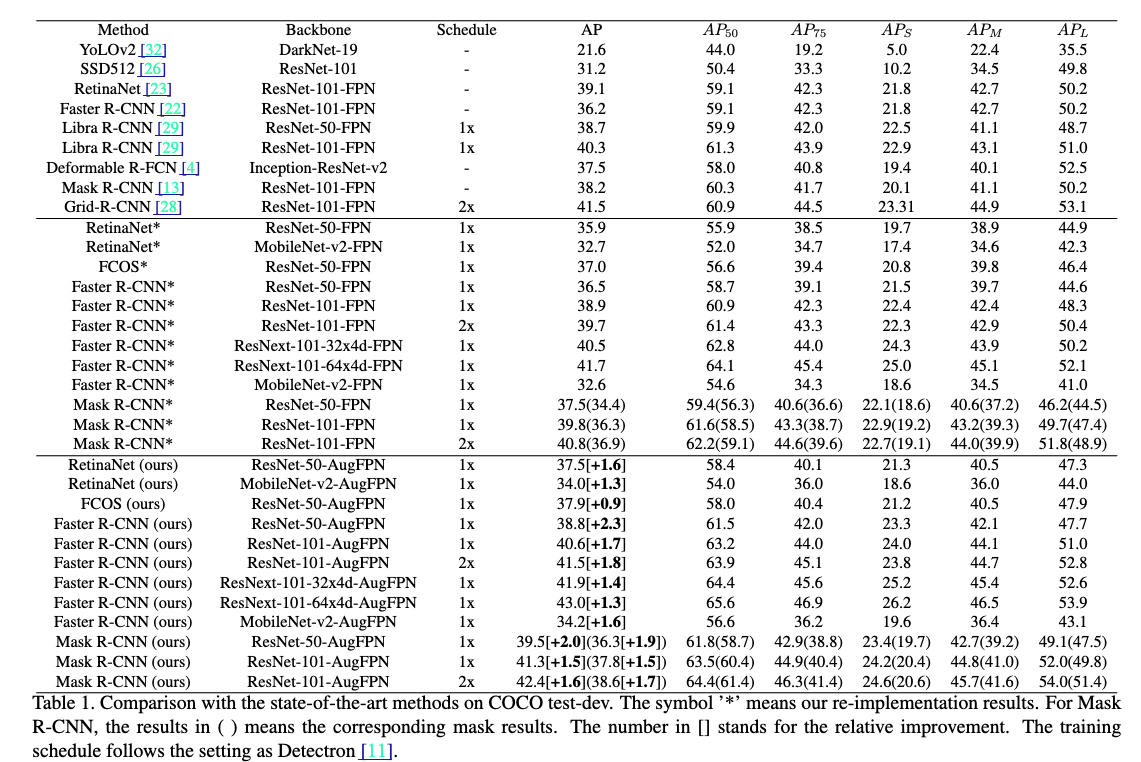

4. Experiments