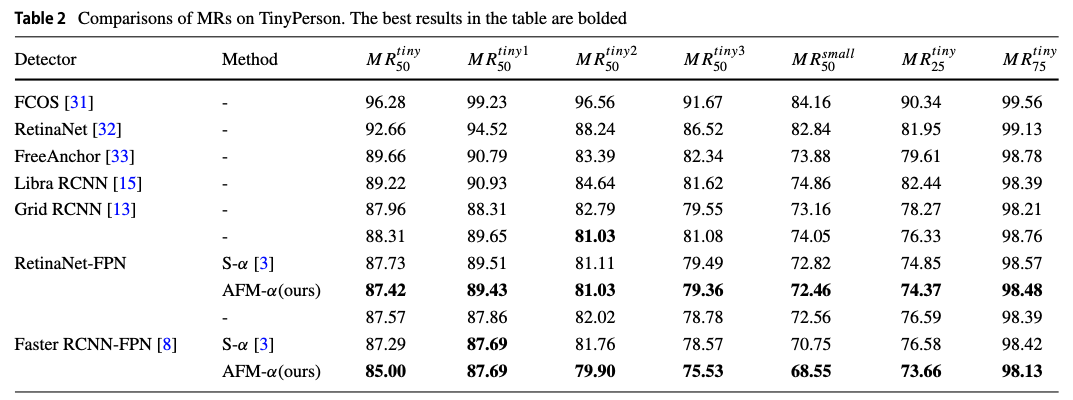

[Simple Review] [2022 Applied Intelligence] Attention-based fusion factor in FPN for object detection

Abstract

배경: 최근, 대부분의 detectors들은 다양한 크기의 objects를 detect하기 위해 feature pyramid를 활용함.문제 제기: 하지만 existing FPN-based feature extraction networks는 effective semantic information을 capturing하는 데에 더 집중하고

FPN feature fusion process에서 dataset scale distribution에 대한 영향은 무시한다.

(내 생각: 이게 어떤 악영향이 있는지? 왜 문제인건지? 디테일한 설명이 필요해 보임)핵심 아이디어, 제안: 이 문제를 해결하기 위해, 우리는 any FPN-based network model에 적용할 수 있는 a novel attention structure를 제안한다.

itself에 attention하는 general attention과는 달리, 우리의 방법은 feature fusion에서 인접한 layer 중 lower layer feature의 영향을 더 잘 활용할 수 있고,

이는 upper layer feature의 filtering을 guide한다.

same sample에 대해 서로 다른 feature map들의 feature information의 차이를 고려함으로써, lower layer에 대해서 invalid sample features of the upper layer를 더 잘 filter out할 수 있다.

우리 방법은 shallow learning에 참여하는 deep features들의 degree(정도)를 더 잘 학습할 수 있게 하여, FPN의 각 layer가 own layer learning에 더 집중할 수 있도록 한다.(?) (내 생각: 이 문장은 abstract여도 너무 추상적이라 생각이 듦...)

1. Introduction

(배경)

- multi-scale object detection에서, the fusion of features with different scales은 model's performance에 매우 중요.

low-level feature는 higher resolution을 가져서 more position and detailed information을 갖지만,

fewer convolutions으로 인해 lower semantics and more noises를 가짐.

high-level feature는 stronger semantic information을 갖지만, resolution이 매우 작아서, the perception of details은 poor함.

이 두 feature를 efficiently integrate하는 방법은 model을 향상시키는 데에 중요함/

(문제 제기)

-

FPN은 계속 발전되어 옴.

SFAM, PANet...

하지만, 그들은 feature fusion에서 dataset 안에 object scale distribution의 영향을 고려하지 않았고, 모든 input features를 동등하게 대했다. (treated equally)

output feature에 대한 서로 다른 resolutions에서의 input features의 contribution은 dataset에서 the scale distribution of objects에 영향을 받을 것이고, 이는 unequal하다. -

하지만 FPN 기반의 detection methods들은 effective semantic information을 capturing하는 데에 집중하고

the influence of the object scale distribution in the dataset은 고려하지 않았다.

(이게 구체적으로 어떤 문제를 야기하는가?)

- 실제 training process에서,

uneven distribution of object scales in the dataset은 FPN의 각 layer의 the effective sample number에 대한 imbalance를 유발한다.

(여기서, 우리는 FPN의 각 layer의 size에 대응하는 positive samples을 effective samples이라고 부른다.)

FPN의 multi-layer connection으로 인해, model은 gradient loss에 의해 optimized될 때, 이러한 imbalance는 model의 performance가 certain task의 relative weight에 심하게 의존적이게 만든다.

이상적으로, each layer of FPN은 각각이 대응하는 scale에 대해서만 집중하길 바란다.

예를 들어, shallow NN는 small objects, deep NN은 big objects를 학습하길 원한다.

하지만, 각 layer들은 간접적으로 다른 layers의 loss에 의해 supervised된다.

결과적으로, 각 layer는 모든 sizes의 objects를 학습하게 되고, 이는 심지어 deep layers가 small objects를 학습하도록 된다.

(관련 연구)

- 존재하는 multi-scale object detection datasets에 대해서, small object data의 양은 보통 적다.

여전히, 이러한 small objects들은 FPN의 각 layer의 학습을 어렵게 한다.

그러므로, 각 layer의 learning ability는 충분하지 않고, the deep layer는 shallow layer를 도와줄 추가적인 power가 없다.

최근 연구 [3]는 small object detection에서 FPN의 top-down pathway의 two-sided effect를 보였다.

FPN의 adjacent layers의 fusion factor를 조절함으로써, shallow learning에 참여하는 the degree of deep features를 바꾸는 것은

shallow learning of small objects and deep learning of big objects를 adaptively promote하여 model의 detection ability를 향상시켰다.

(제안)

- FPN의 feature fusion process 동안에 the negative impact of the uneven distribution of object scales in the dataset을 제거하기 위해서,

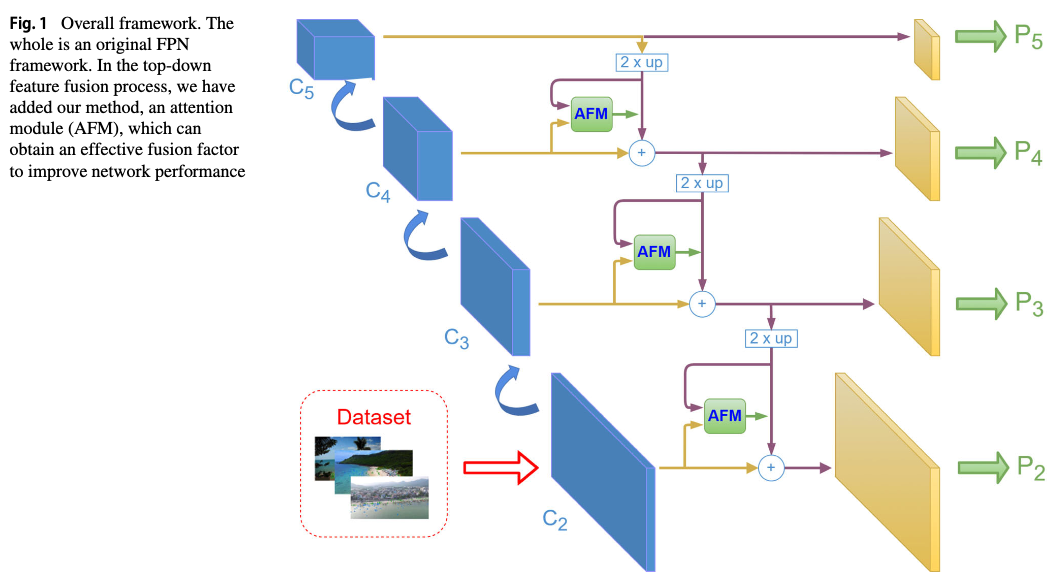

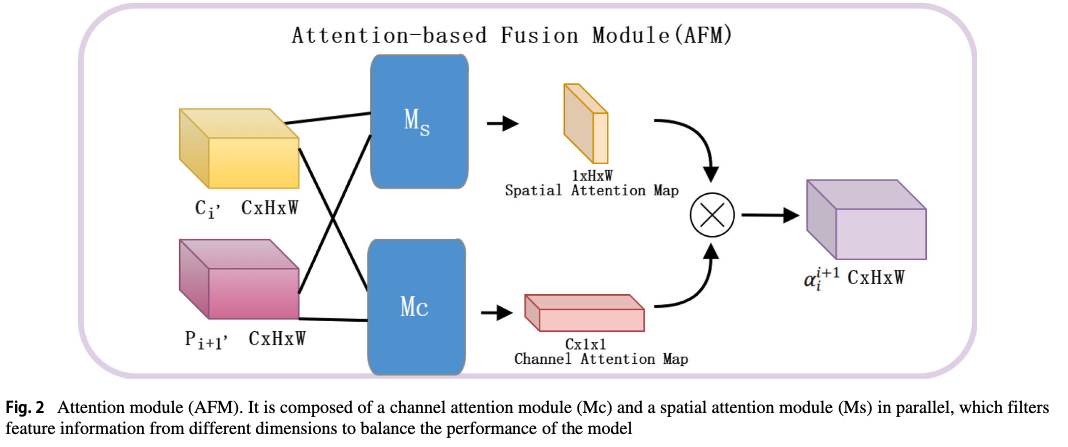

우리는 a novel attention module (AFM)을 제안한다.

ifselft로부터 own attention을 취하는 general attention과 달리, AFM은 internal correlation of data or features를 잘 capture한다.

AFM은 tow modules로 이루어져 있다:- spatial attention은 certain algorithm을 사용하여 high-level and low-level feature information을 the same distribution으로 배치하고,

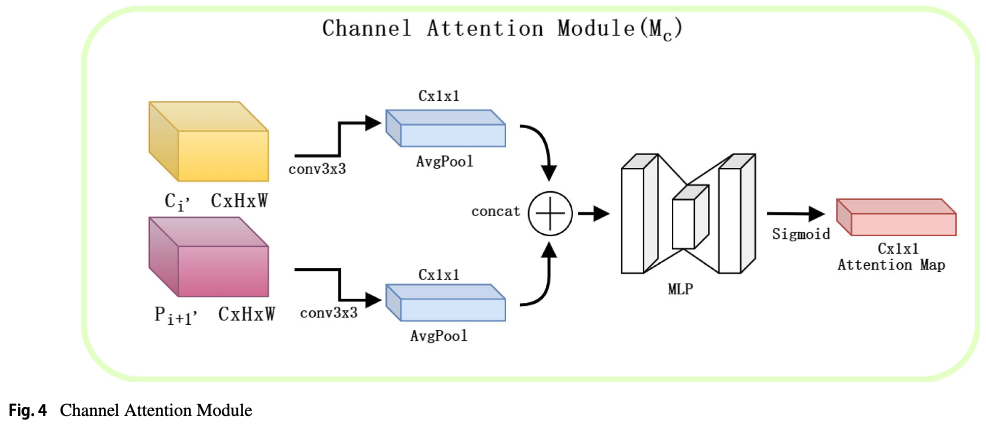

이들의 차이를 분석하여 deep layers로부터 invalid sample features를 fitler out하는 데 도움을 준다. - channel attention은 동시에 high-level features and low-level features의 global information을 aggregates한다.

- spatial attention은 certain algorithm을 사용하여 high-level and low-level feature information을 the same distribution으로 배치하고,

2. Related Works

- AugFPN은 FPN의 feature pyramid에서 some design flaws를 지적하고 consistency supervision으로 해결했고, residual feature enchancement and soft RoI selection으로 better detection results를 달성.

SNIP은 먼저 small scale과 pretraining model의 scale 간의 관계를 분석하고, domain-shift의 영향을 줄이기 위해 a scale-normalized training mechanism을 제안했다.

...

3. AFM-FPN

3.1 Main frame

3.2 Obtain the fusion factor through AFM

3.2.1 Spatial attention module

3.2.2 Channel attention module

4. Experiments

4.1 Experiment on TinyPerson

4.2 Experiment on MS COCO