Regularizing

High Variance문제가 있는 경우, 여러분이 가장 먼저 시도해야하는 것 중 하나는 아마도 정규화(Regularizing)일 것입니다

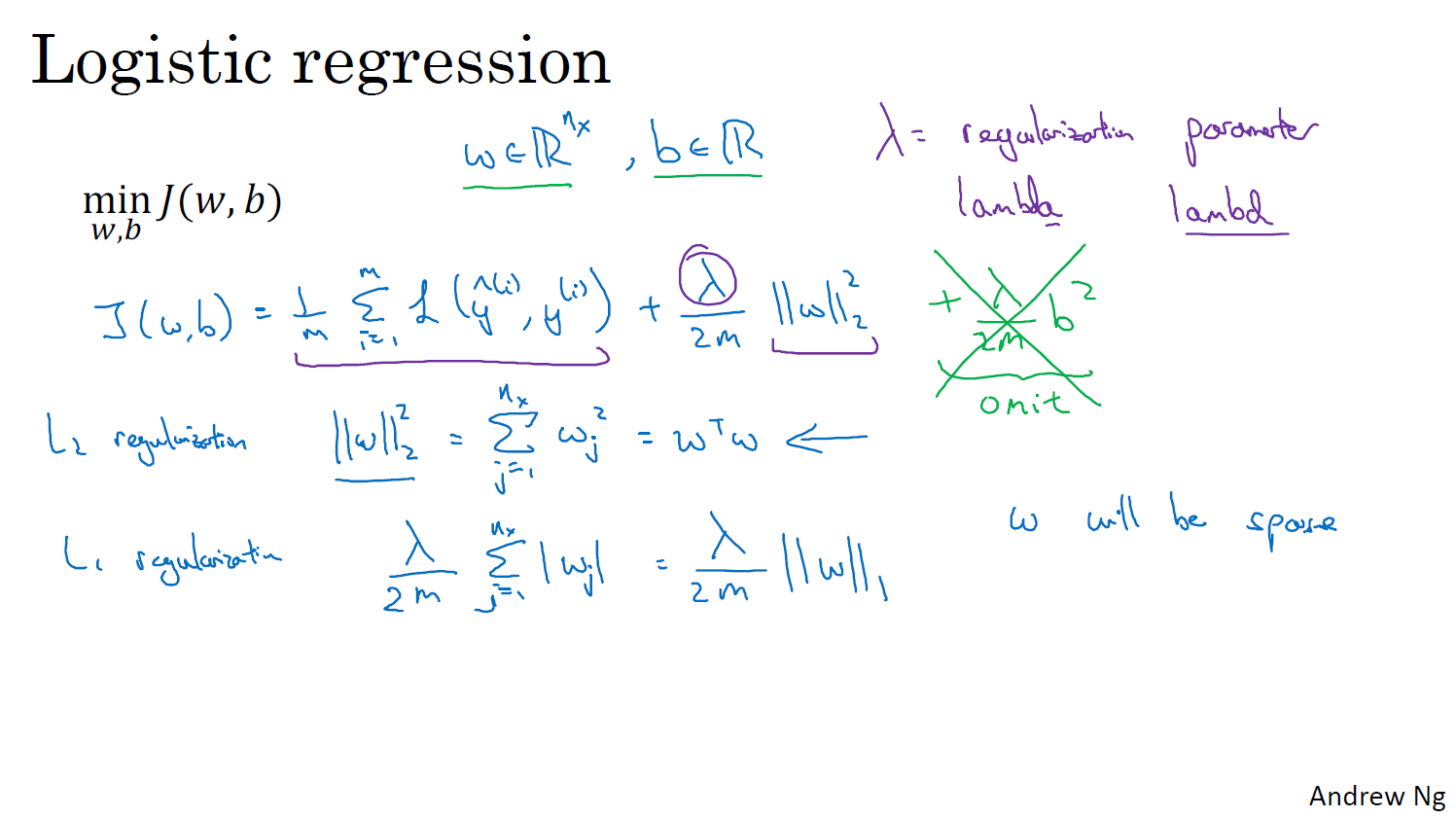

L2 정규화는 가장일반적인 유형의 정규화이다.다른 사람들이 L1 정규화에대해 얘기하는것을 들어본 적이 있을거에요 그리고 그것은 이 L2 노름대신에 더하였을 때 입니다

L1은 잘 사용하지 않는다. w 벡터는 많은 0을 가지고 있어 모델을 저장하는데 더 적은 메모리가 필요하다고 하지만 압축할 용도가 아니라면 그렇게 많이 사용되지 않는다.

위 내용은 https://junstar92.tistory.com/72 여기를 참고핮... 힘들다.. ㅜㅜ

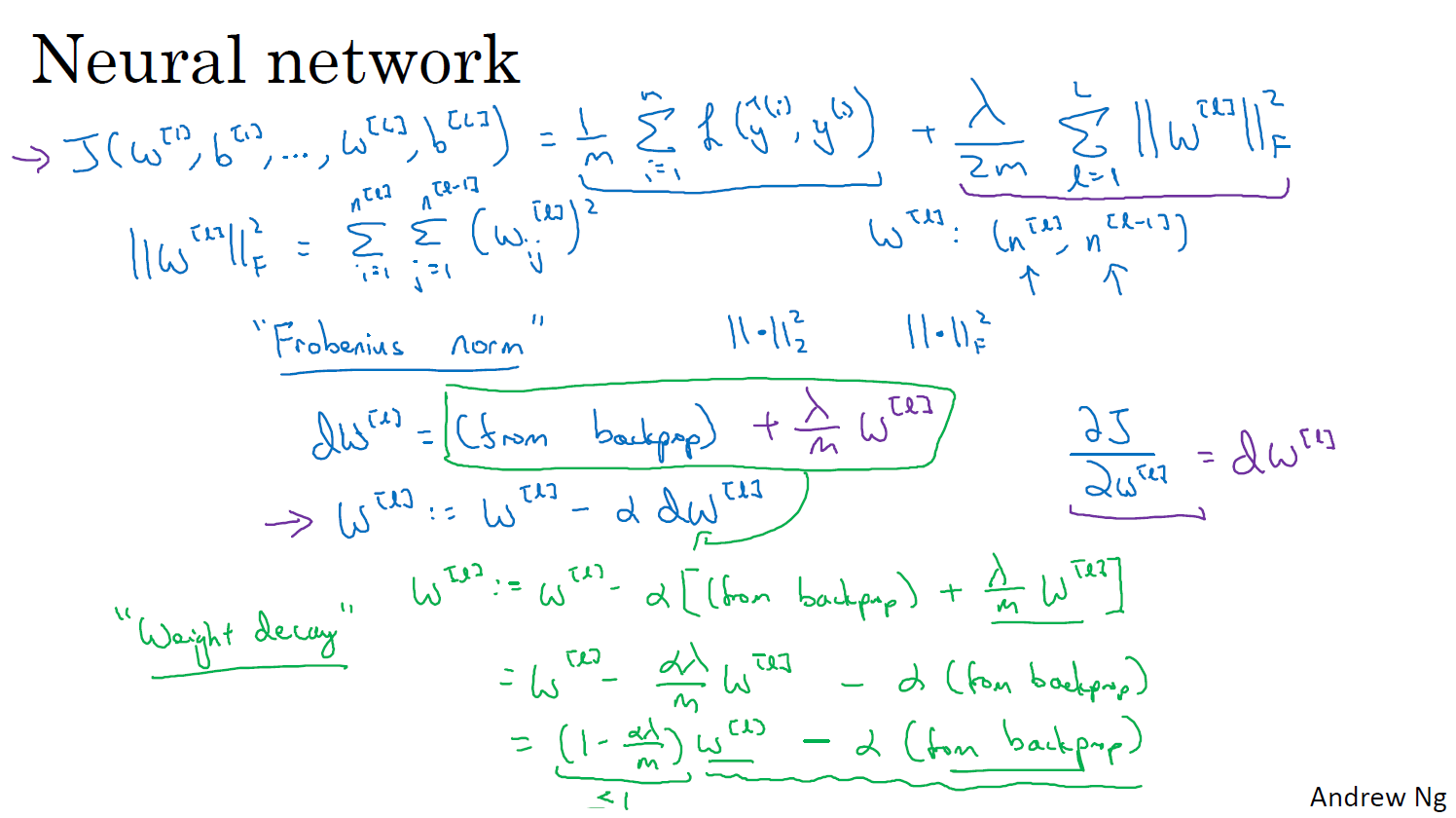

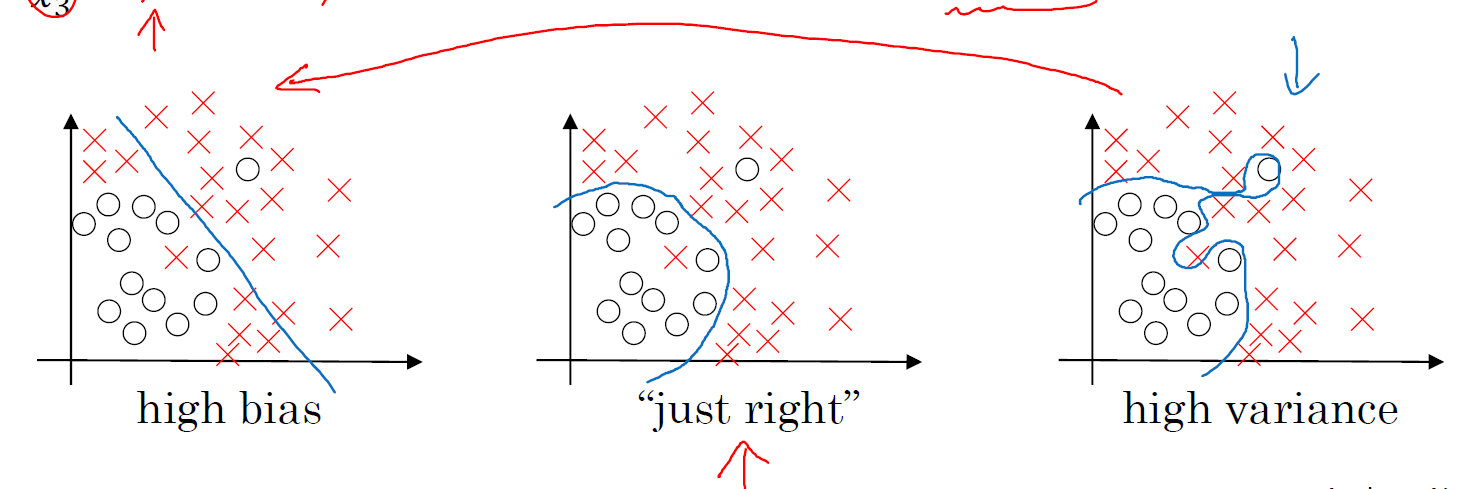

Why regularization reduces overfitting?

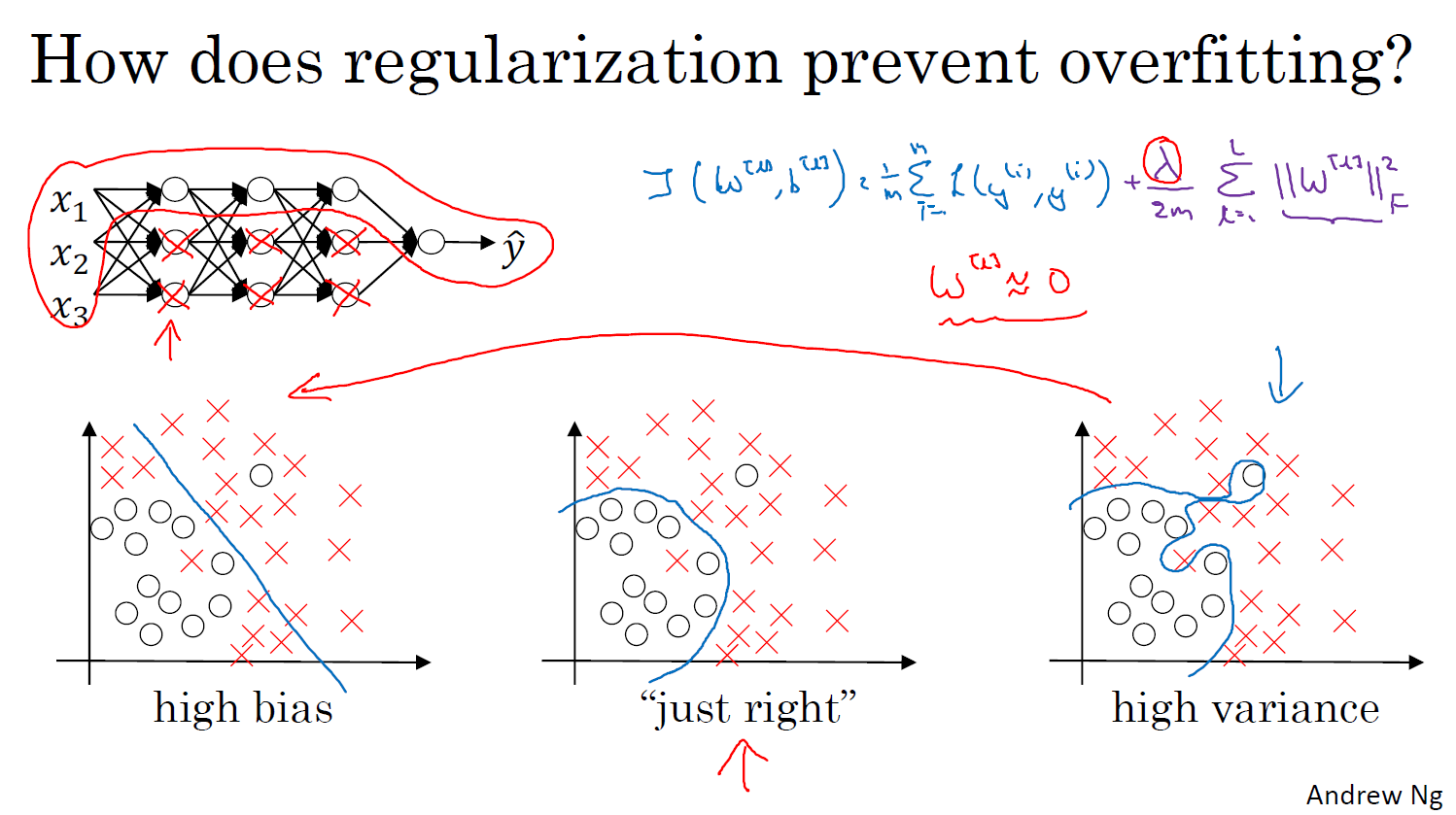

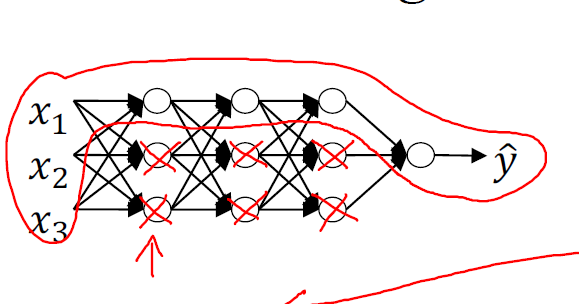

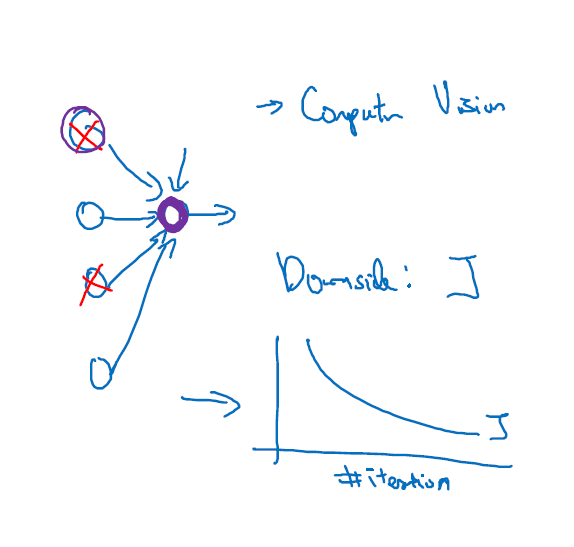

정규화 람다를정말, 정말 크게 만들면, 가중 매트릭스들, W를 합리적으로 0에 가깝게 설정하도록유도할 수 있다는 것입니다 위 이미지 처럼 신경망을 만든다

이렇게 단순한 신경망은 훨씬더 작은 신경망이 되는 것입니다 이러한 과적합한 경우에서 큰바이어스를 갖는 왼쪽의 경우처럼 이동시킵니다 그래서 완전한 0으로 만들기보다는 가운데 그래프 처럼 적당한 값을 부여하도록 한다.

z값이 작으면 위에 tanh 그래프에 빨간 부분만 사용하게 되는데 매우 복잡한 고도의 비선형함수라기 보다는 단순한 함수이기 때문에 과적합도 훨씬 덜해진다.

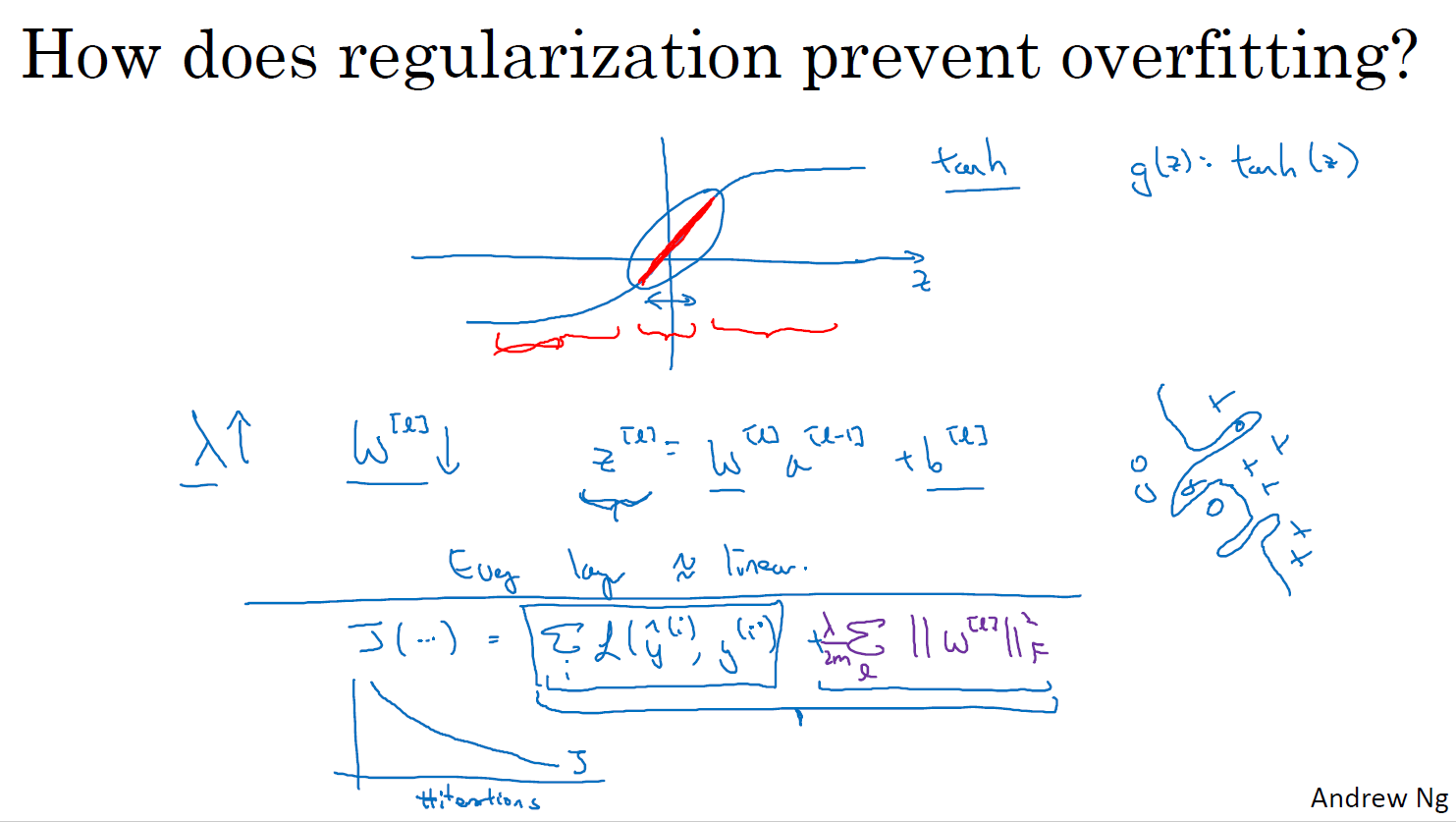

Dropout Regularization

Drop-out은 서로 연결된 연결망(layer)에서 0부터 1 사이의 확률로 뉴런을 제거(drop)하는 기법입니다 그렇다면 Drop-out 기법을 사용하는 이유는 무엇일까요? 결론부터 말씀드리자면, Drop-out은 어떤 특정한 설명변수 Feature만을 과도하게 집중하여 학습함으로써 발생할 수 있는 과대적합(Overfitting)을 방지하기 위해 사용됩니다.

자세한 내용은 참고페이지 참고

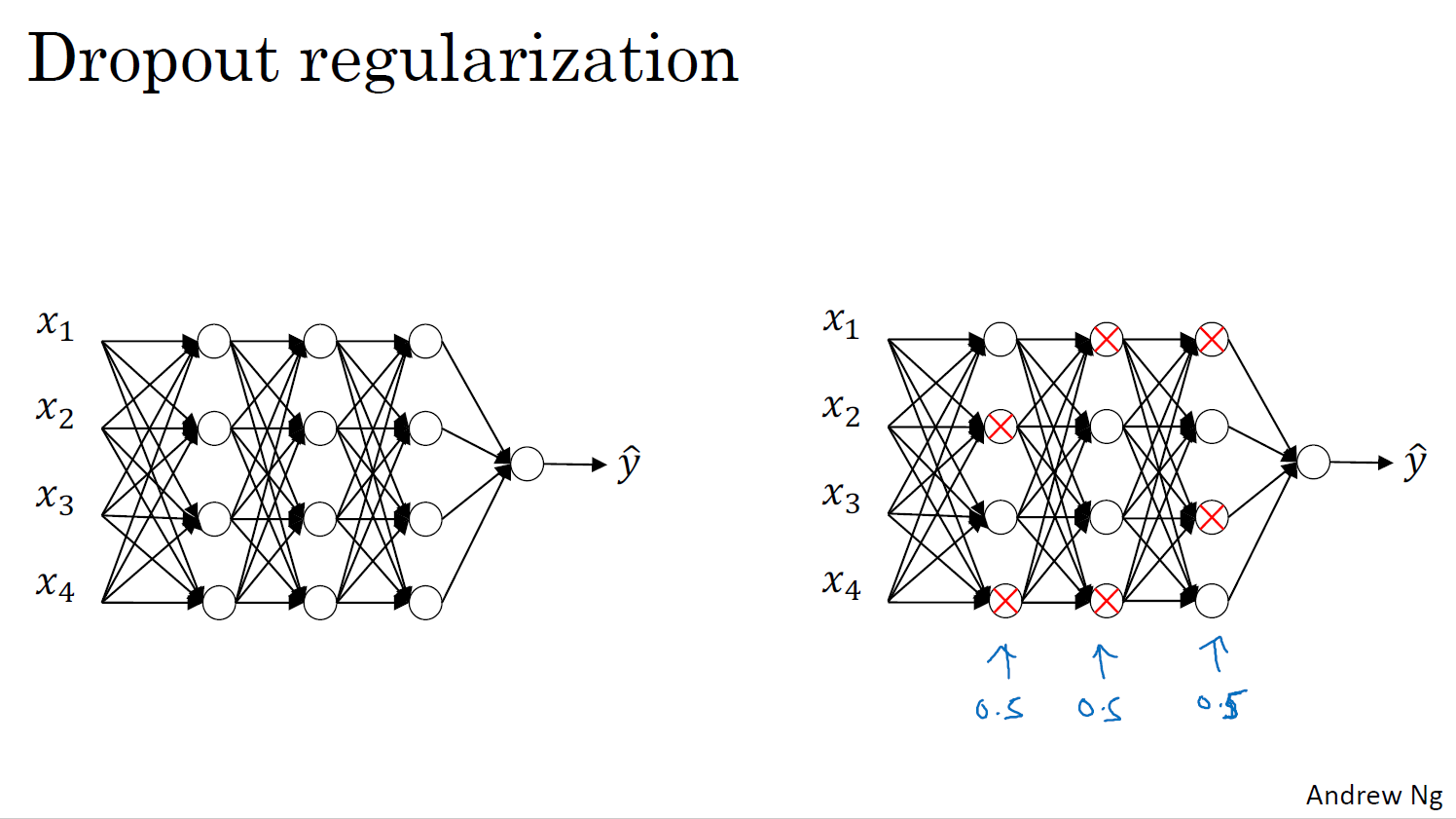

Understanding Dropout

더 작은 신경망을 사용하는 것은 정규화 효과가 있는 것처럼 보인다. 한 가지 특성에 의존하는 것을 피할 수 있다.가중치의 squared 노름을 줄이는 효과가 있고 그러므로 L2 정규화에서 본 것과 비슷하게 드롭아웃 구현의 효과는 그 강도가 L2 정규화와 유사하다 과적합을 피할 수 이싿.

선택해야 하는 것 중 하나는 keep_prob이며 레이어마다 유닛을 유지할 확률을 나타냅니다 따라서 레이어별로 keep_prob을 다르게 하는 것도 가능합니다keep_prob 1.0은 모든 유닛을 유지한다는 뜻입니다 드롭아웃을 그 레이어에는 쓰지 않는 것으로 해석할 수 있습니다 그러나 과적합에 대해 조금 더 걱정을 하는 매개변수가 많은 레이어에는 더 강한 형태의 드롭아웃을 적용하기 위해서 keep_prob이 더 작을 수 있습니다 마치 L2 정규화의 매개변수 람다를 증가시키는 것과 같습니다 일부 레이어를 다른 레이어보다 더 많이 정규화하는 것이죠

컴퓨터 비전에서는 입력 크기가 너무 커서 모든 픽셀들을 입력하는 데에 거의 항상 데이터가 부족합니다 그렇기 때문에 컴퓨터 비전에서는 드롭아웃이 매우 흔하게 활용되고 몇 가지 컴퓨터 비전 연구는 거의 항상 기본값으로 사용합니다 기억하셔야 할 것은 드롭아웃은 정규화 테크닉이고 과적합을 예방하는 데 도움이 된다는 것입니다

Other regularization methods

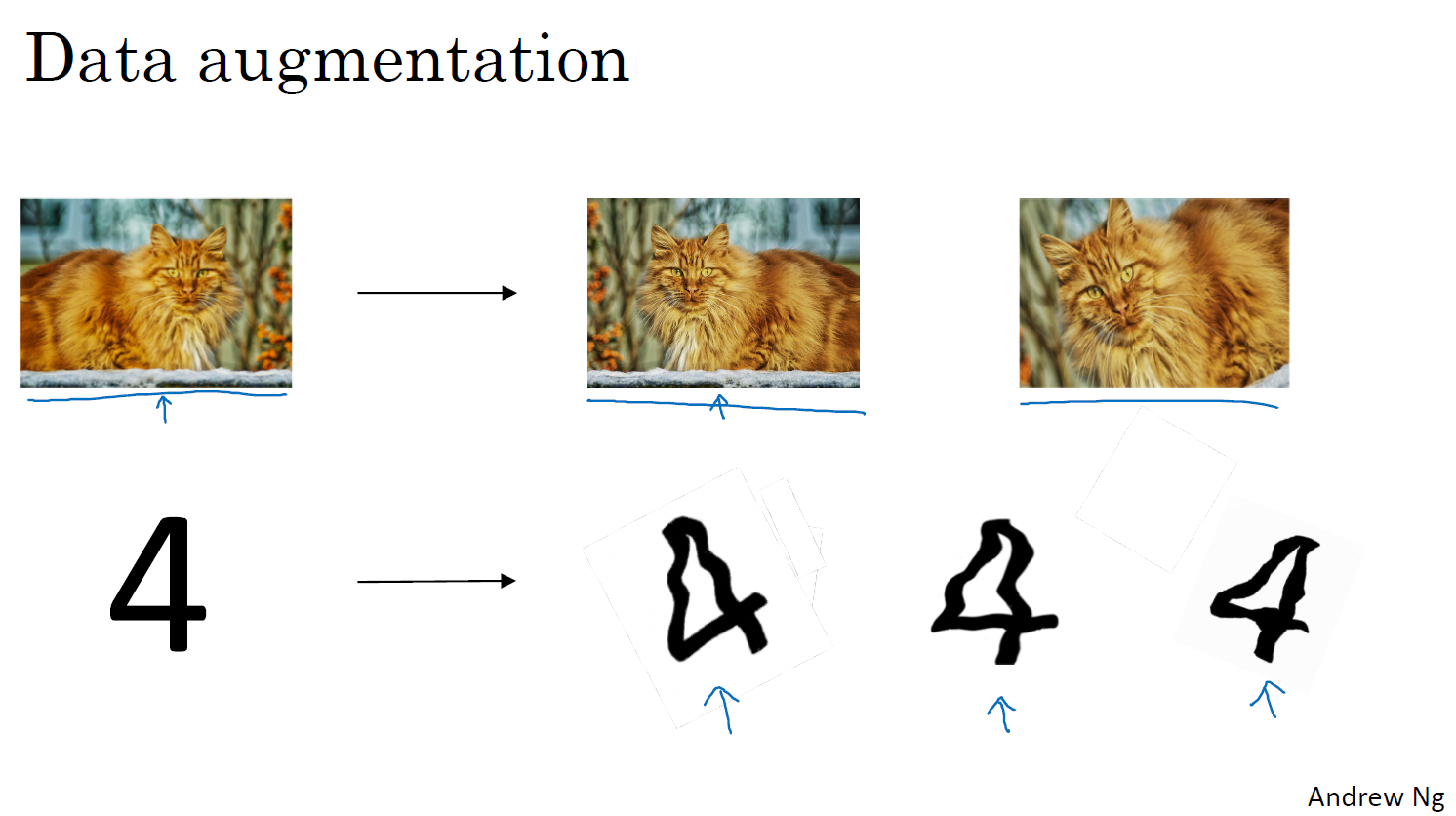

위 피피티는 데이터 증강이라고 한다. 원하는 데이터 수가 부족할 때 사용하는 방법이다. 완전히 새로운 고양이 이미지를 추가하는 것보다는 도움이 되지 않지만 대안으로 좋은 방법이다.

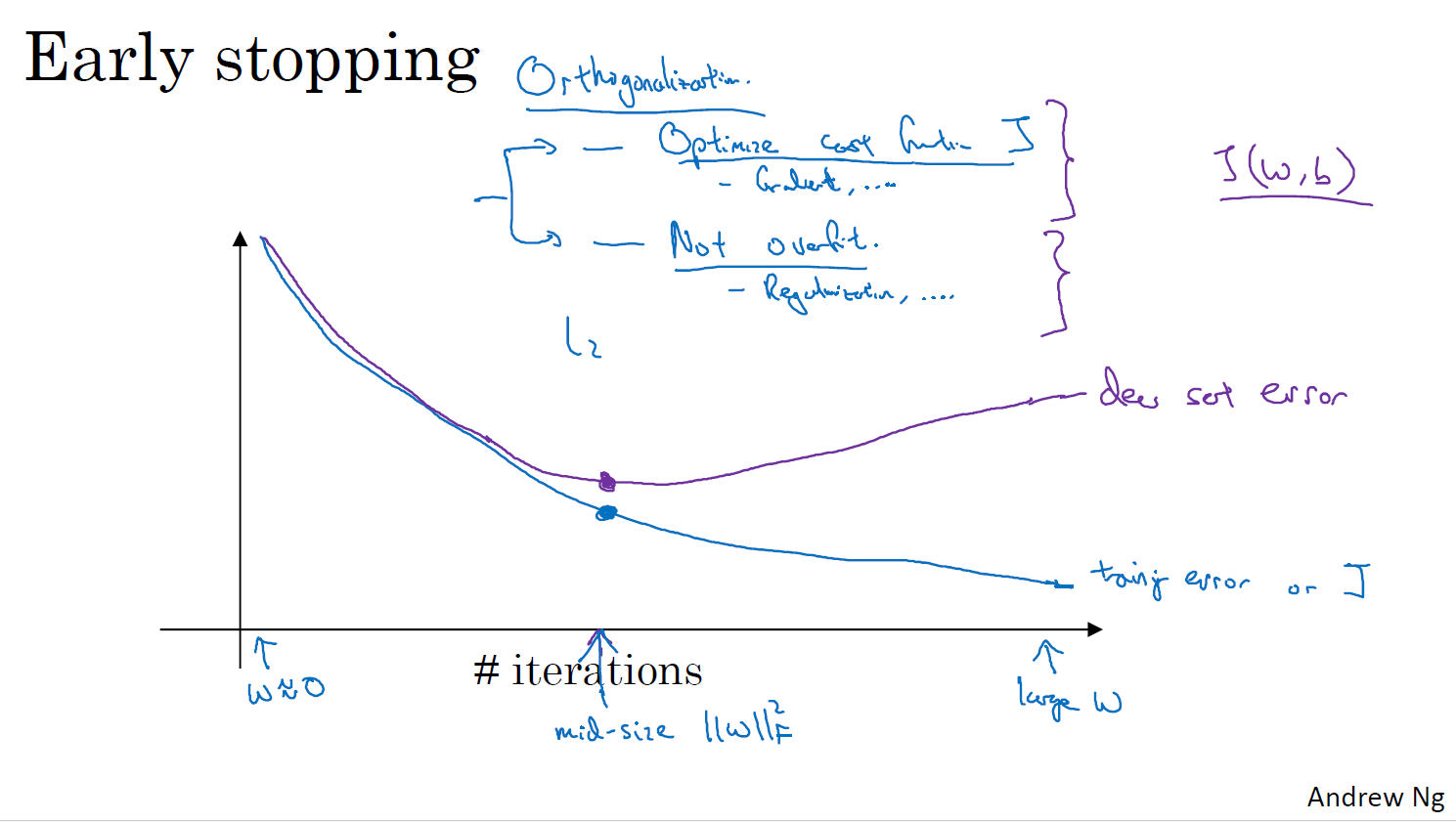

일반화와 비슷하게, 쓰이는 기술 중 early stopping이라고 하는 기술이다. early stopping은 w의 비율이 중간 정도 되는 시점에서 중지시키는 역할을 합니다 그러므로 L2 일반화와 비슷하게, 신경망에서 w 파라미터수가 비슷한 노름을 선정하여 결과적으로 신경망이 덜 overfitting하게 만들어주는 것입니다 early stopping의 주된 단점은, 이것이 이 2개의 업무를 묶는다는 것입니다. 그러면 이 2개의 별개 문제를 단독으로 풀 수가 없게 됩니다. 그러면 결과적으로 여러 가지 시도할 수 있는 방법들에 대해서 더 복잡하게 만드는 경향이 있습니다 조기 종료는 딥러닝 모델 학습에서 과적합을 방지하고 모델 성능을 향상시키는 데 유용한 기법이지만, 단점도 존재합니다. 따라서, 조기 종료를 사용할 때는 장단점을 고려하고 적절하게 설정해야 합니다. 또한, 조기 종료 외에도 다른 과적합 방지 기법 (예: 데이터 증강, 드롭아웃, L1/L2 정규화)과 함께 사용하는 것이 효과적입니다.