[Paper Review] Sequence to Sequence Learning with Neural Networks

1. Overall Summary of the whole content

위 논문은 LSTM(Long Short-Term Memory) 기반 모델을 활용한 sequence to sequence(Seq2Seq) 학습 방법을 제안한다.

(이 페이퍼에서는 4개의 layer로 이뤄진 2개의 LSTM을 사용)

성능을 개선하기 위해 모델에 조금씩 변주를 주며 영어-프랑스어 기계 번역 작업을 수행하고 BLEU점수를 측정한다.

2. Details

(1) Seq2Seq모델 구성 - 인코더,디코더 아키텍처

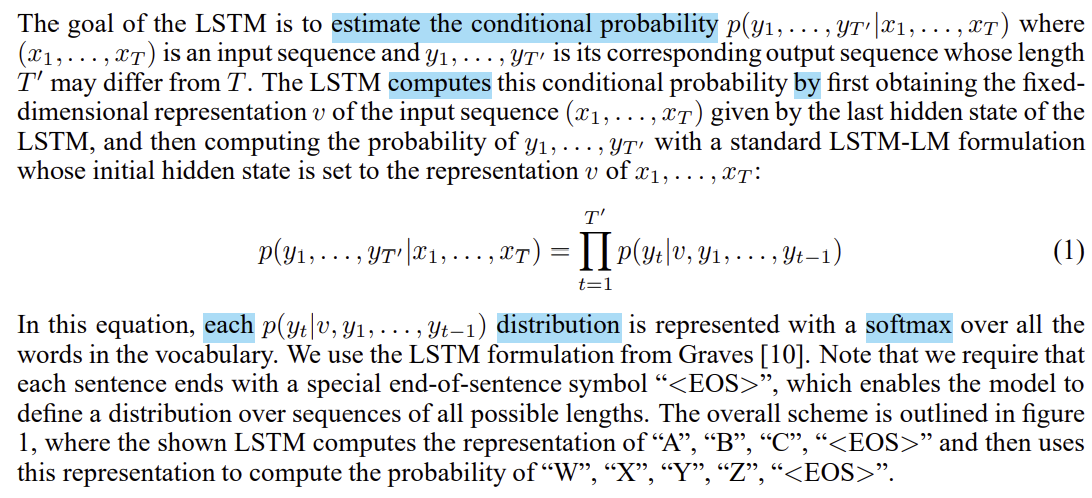

Seq2Seq모델은 입력 시퀀스를 고정된 차원의 백터로 인코딩하고, 이를 다시 목표 시퀀스로 디코딩하는 방식으로 2개의 LSTM 네트워크를 사용한다. 인코더-디코더 아키텍처가 사용되기 이전의 딥러닝 모델들은 고정된 차원의 벡터로 시퀀스를 표현하였기 때문에 입력 및 출력 시퀀스의 길이가 같거나 단순한 패턴일 때만 효과적이었다.

<Encoder-Decoder architecture 이전 딥러닝 모델들의 시퀀스 처리 방식>

- RNN : 시퀀스의 이전 상태를 다음 상태로 전달하여 데이터 처리

-> 한계: 입출력 시퀀스 길이가 동일하거나 간단한 관계여야함.- 고정된 차원의 벡터 사용

-> 한계: 문장을 고정된 차원의 벡터로 변환하여 단어의 순서 정보 유실 가능

-> 이전 모델의 한계: 입력과 출력 시퀀스 사이의 complex mapping 처리의 어려움

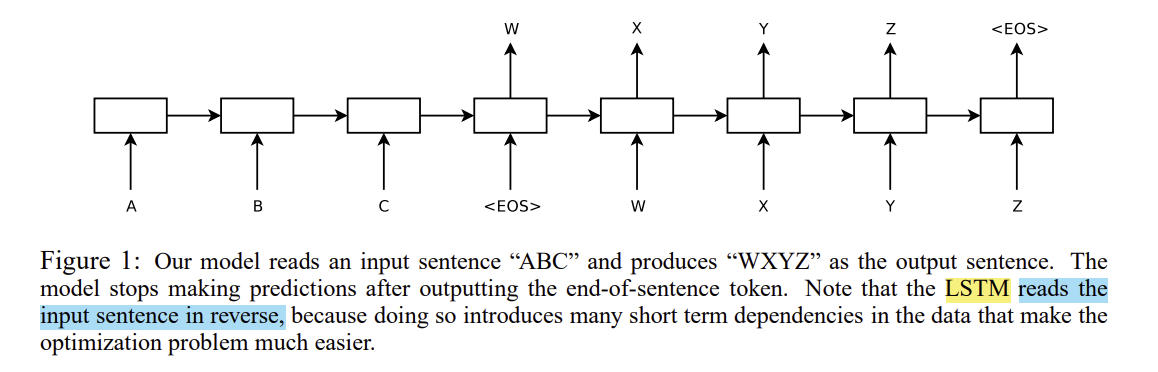

(2) 모델의 성능 향상 - 입력 시퀀스 반전하기

이 페이퍼에서 또 한가지 주목할 부분은 source sentence들을 반전(reverse) 시켜서(target sentence는 반전시키지 않음) 성능을 향상시켰다는 점이다.

Reversing the order of words makes it easy for SGD to "establish communication" between the input and the output.

반전시킨 결과, LSTM의 test perplexity는 5.8에서 4.7로 감소했고, test BLEU 점수는 25.9에서 30.6으로 증가했다.

기존의 순서대로 학습(시퀀스 반전x) : '문장의 맨 앞 단어'<->'출력의 첫 단어' 사이에 긴 거리가 생겨서 모델이 장기 의존성을 학습하는 데 어려움.

<해결 방안: 입력 시퀀스를 반전시키기>

입력 시퀀스를 반전시키면 시퀀스 내 단어들 사이의 단기 의존성을 강화하여 모델이 더 쉽게 학습할 수 있게 함.

While we do not have a complete explanation to this phenomenon, we believe that it is caused by the introduction of many short term dependencies to the dataset. Normally, when we concatenate a source sentence with a target sentence, each word in the source sentence is far from its corresponding word in the target sentence. As a result, the problem has a large “minimal time lag”. (...생략)

Thus, backpropagation has an easier time “establishing communication” between the source sentence and the target sentence, which in turn results in substantially improved overall performance.

3. Conclusion

이 논문은 encoder-decoder 구조를 통해 가변 길이의 입력 시퀀스를 고정된 벡터로 인코딩하고 이를 디코더가 target sequence로 변환하여 예측을 수행하는 방식이 효과적임을 확인하며, Seq2Seq 모델이 sequence to sequence 학습에 좋은 성능을 보인다는 결론을 제시한다. 특히 '2. Details' 부분에서도 다룬 것처럼 입력 시퀀스의 반전 기법은 모델의 장기 의존성 학습을 용이하게 만들어 성능 향상에 기여하고, 이는 시퀀스 간의 거리 감소로 모델의 학습을 돕는 중요한 발견으로 해석된다.

따라서 Seq2Seq 모델은 시퀀스 길이에 무관하게 다양한 입력과 출력 간의 복잡한 매핑 처리가 가능하여 여러 NLP 문제에 적용가능하다는 점을 시사한다.