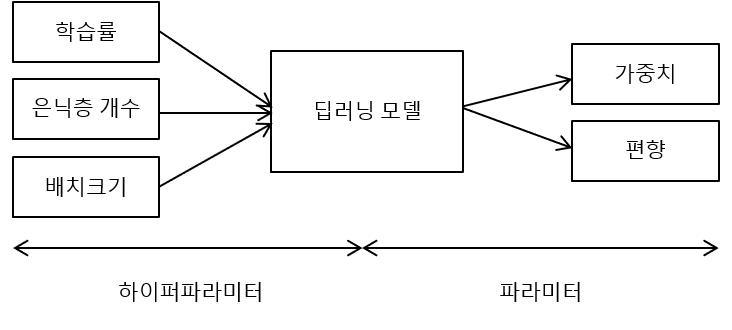

🎯 하이퍼 파라미터란?

하이퍼 파라미터

-

최적의 딥러닝 모델을 구하기 위해 여러 방법과 인간의 선험적 지식을 기반으로 딥러닝 모델에 설정하는 변수를 말함

-

즉, 사람이 직접 결정하는 값

🔐예시) epoch, 학습률, 옵티마이저, 활성화 함수, 배치 사이즈, 은닉층, 노드수, 드롭아웃, L1,L2람다, 가중치 초기화

파라미터

- 매개변수랑 같은 말이라고 보면됨

- 데이터를 통해서 사람이 설정하는게 아니라 머신이 학습되는 값이라고 생각하기

🔐예시)가중치, 편향: 머신이 순전파, 역전파를 겪으면서 스스로 학습하는것)

출처: http://blog.skby.net/%ED%95%98%EC%9D%B4%ED%8D%BC%ED%8C%8C%EB%9D%BC%EB%AF%B8%ED%84%B0-hyperparameter/

위에 그림을 보고 하이퍼 파라미터와 파라미터를 잘 구별하자!

✏️ 상대적으로 중요한 하이퍼파라미터는 학습률

🎯 하이퍼 파라미터 튜닝

- 수작업으로 파라미퍼 수정

- 실험자의 경험과 도메인 지식이 필요

- Grid Search

- 하이퍼 파라미터마다 탐색하는 지점을 정해주면 모든 지점에 해당하는 조합을 알아서 수행

- ⛔️단점: 너무 많은 파라미터를 설정하면 오래걸림

- Random Search

- 무한 루프라는 grid search의 단점을 해결

- 상대적으로 중요한 하이퍼 파라미터에 대해서는 탐색을 더하고 덜 중요한 하이퍼 파라미터에 대해서는 실험을 덜 하도록 함

- Baysian Methods

- 베이지안 방식은 이전 탐색결과 정보를 새로운 탐색에 활용하는 방법

- 하이퍼 파라미터 탐색 효율을 높일 수 있음

🎯 신경망에서 탐색 가능한 하이퍼 파라미터 종류

- 배치 크기(batch size)

- 에포크(epochs)

- 옵티마이저(optimizer)

- 학습률(learning rate)

- 활성화 함수(activation)

- regularization(weight decay/dropout)

- 은닉층의 노드 수