👨🏫 본 리뷰는 cs231n-2017 강의를 바탕으로 진행했습니다.

🤷♂️ 리뷰 전, 8강에 대한 리뷰는 따로 하지 않습니다. 8강 내용은 "Deep Learning Software"으로 딥러닝에 관련된 소프트웨어에 대해 소개하고 있습니다. "Tensorflow", "PyTorch", "CPU/GPU" 등등에 대한 내용을 소개합니다.

Today

- Case Studies

- AlexNet

- VGG

- GoogeLeNet

- ResNet

- Also...

- NiN

- Wide ResNet

- ResNeXT

- Stochastic Depth ....

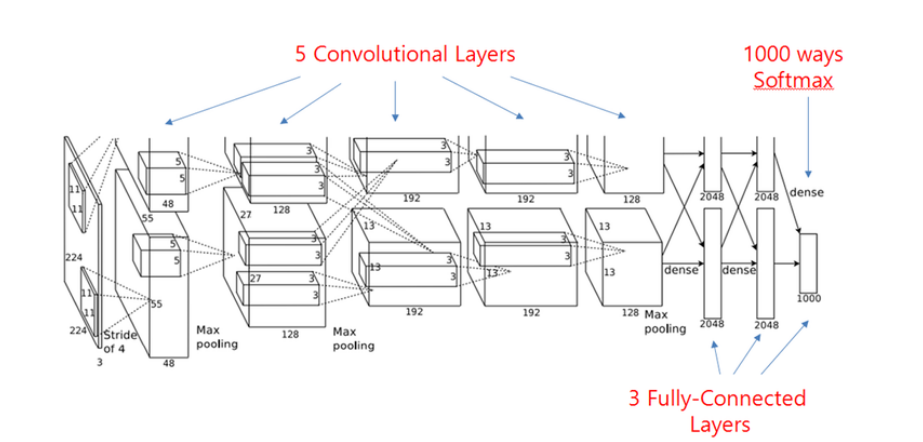

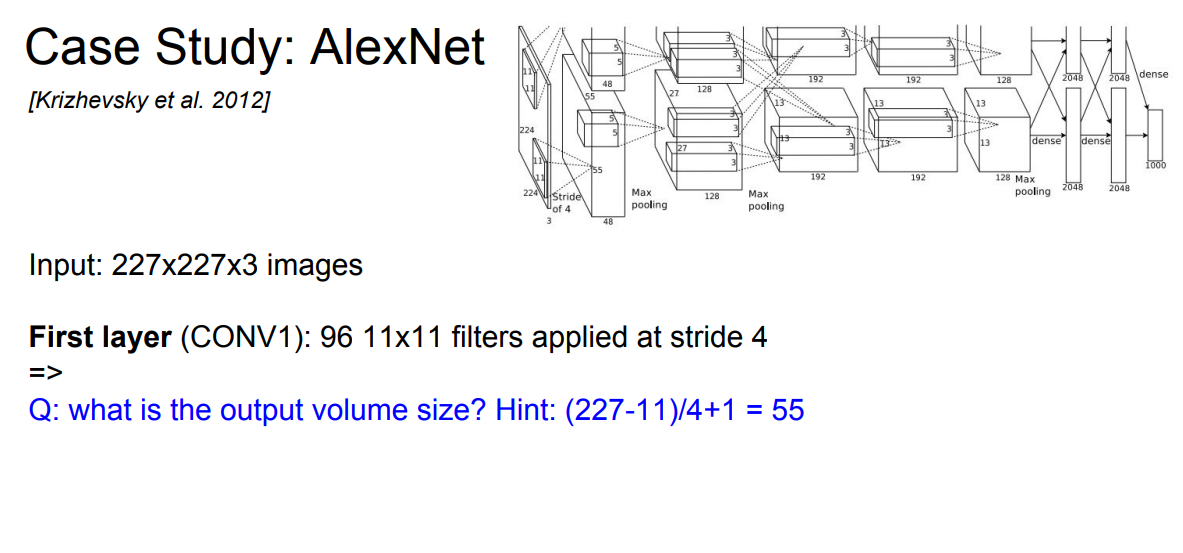

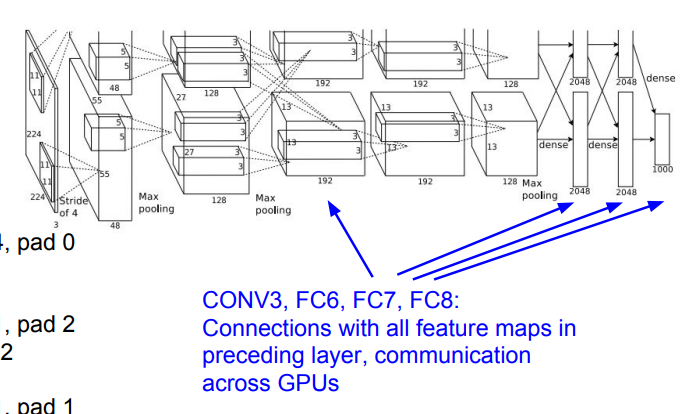

Case Study: AlexNet

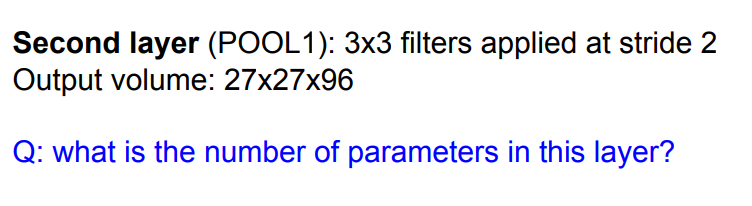

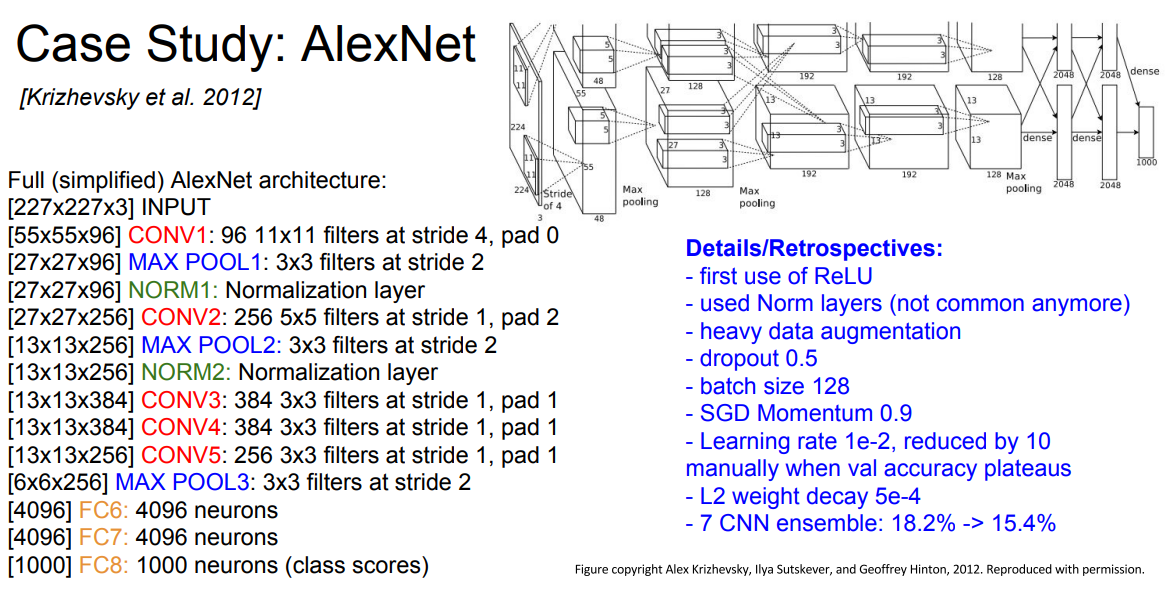

📌 AlexNet은 Image Classification task에서 최초로 사용한 CNN network라고 말할 수 있습니다. 위 그림과 같은 구조로 5개의 Conv layer와 3개의 FC layer로 이루어져있습니다. 또한 2개의 GPU를 사용했습니다.

🎈 Input: 227x227x3 images

🎈 Filter(First layer): 96 11x11 filters with stride 4

🎈 output: 55x55x96 ((227-11)/4 + 1 = 55)

🎈 Paramters: 11*11*3*96 = 35k📌 첫번째 레이어에 대한 연산 과정을 확인할 수 있습니다. 기존의 배웠던 feature size 계산과 parameter 수 계산을 통해 쉽게 연산할 수 있습니다.

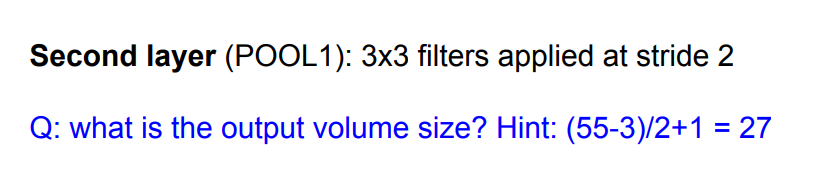

📌 두번째 레이어인 Pooling layer에서는 Depth는 동일하며 feature size에 대한 연산만 있을 뿐입니다. 또한 Pooling layer은 weight 연산을 하지 않기 때문에 따로 파라미터를 사용하지 않습니다.

📌 전반적인 network 구조를 위에서 확인할 수 있습니다. 위의 연산과 동일하게 수행하면 어렵지 않게 계산할 수 있습니다.

- ReLU

- local response normalization(LRN)(not common anymore)

- heavy data augmentation(filp, jittering, color...)

- Dropout(0.5)

- Batch size 128

- SGD Momentum(0.9)

- Learning rate 1e-2, reduced by 10 manually when val accuracy plateaus

- L2 weight decay 5e-4

📌 계략적으로 위의 방법을 사용했다고 합니다. 대부분은 흔히 사용되는 방법들이며, LRN 같은 경우에는 이제는 사용하지 않는다고 합니다.

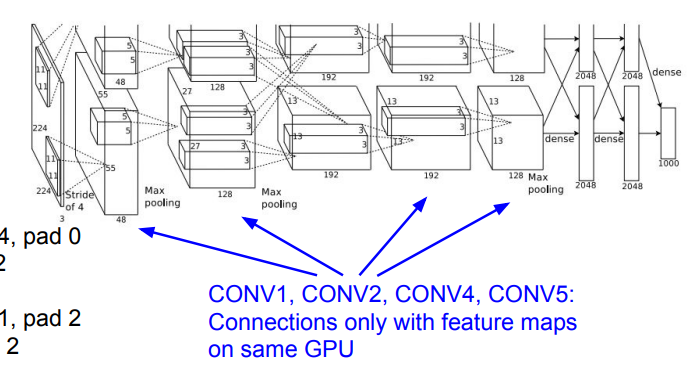

📌 AlexNet은 2개의 GPU를 사용했으며 ConV1, 2, 4, 5에서는 같은 GPU끼리 연산을 했다고 합니다. 즉, 일부의 feature map만 봤다고 이야할 수 있습니다.

📌 이 외의 레이어에서는 GPU간의 통신을 통해 전체 레이어를 활용할 수 있습니다.

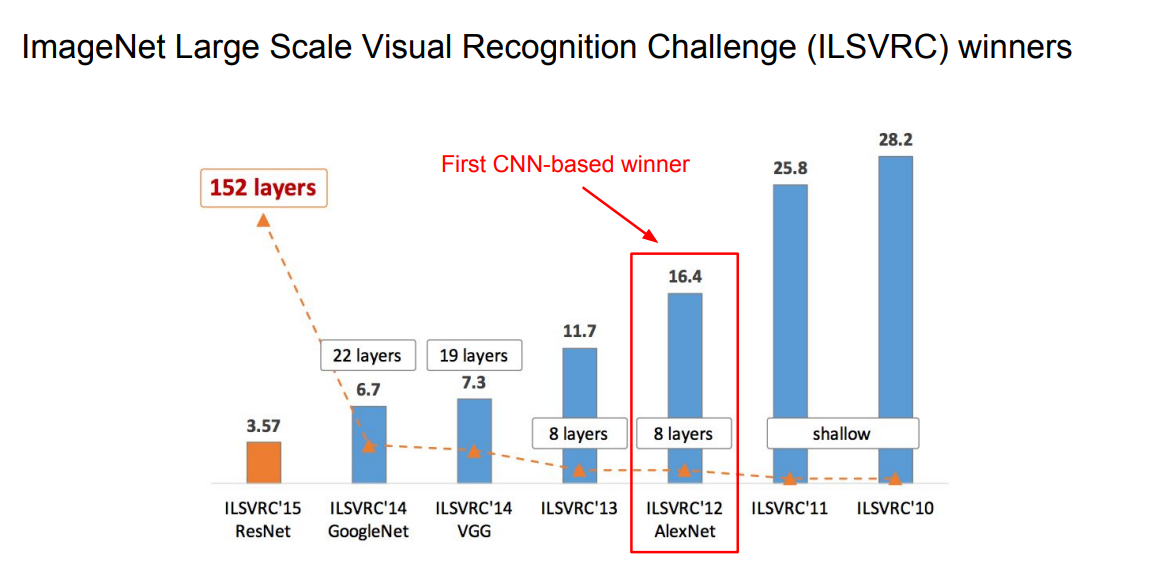

📌 결과적으로 ILSVRC'12 대회에서 1등이라는 좋은 성과를 보여줬습니다.

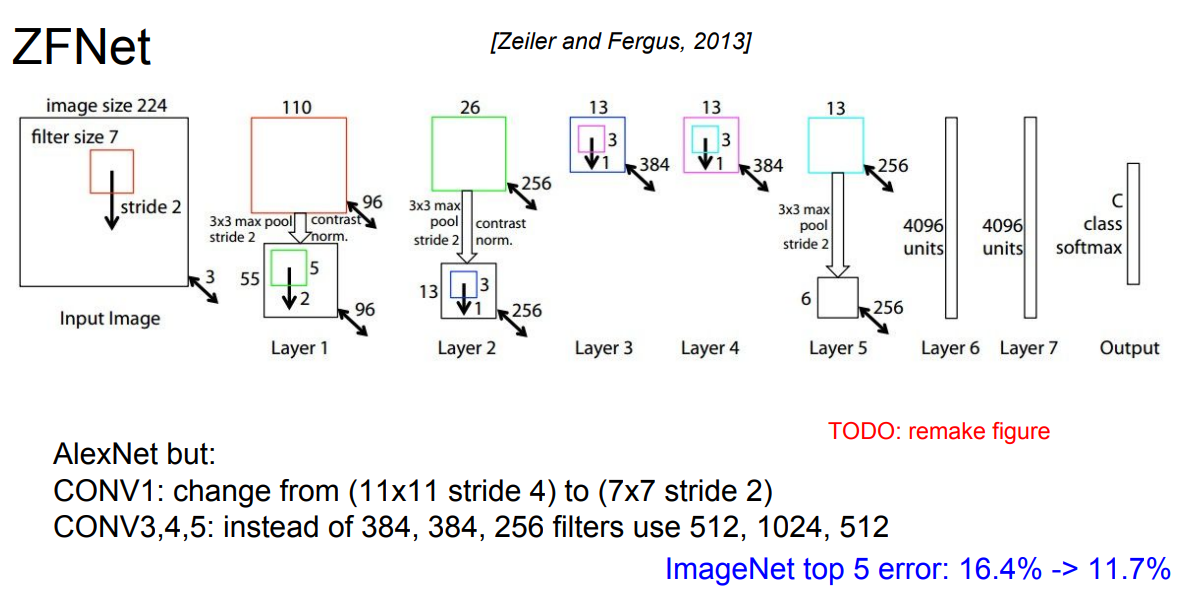

📌 ZFNet은 기존의 AlexNet의 구조는 동일하지만 feature map size 및 channel 수를 변경함으로써 기존의 AlexNet보다 좋은 성능을 보였다고 합니다.

📌 마지막으로 AlexNet의 구체적인 정보는 논문에서 확인하실 수 있습니다.

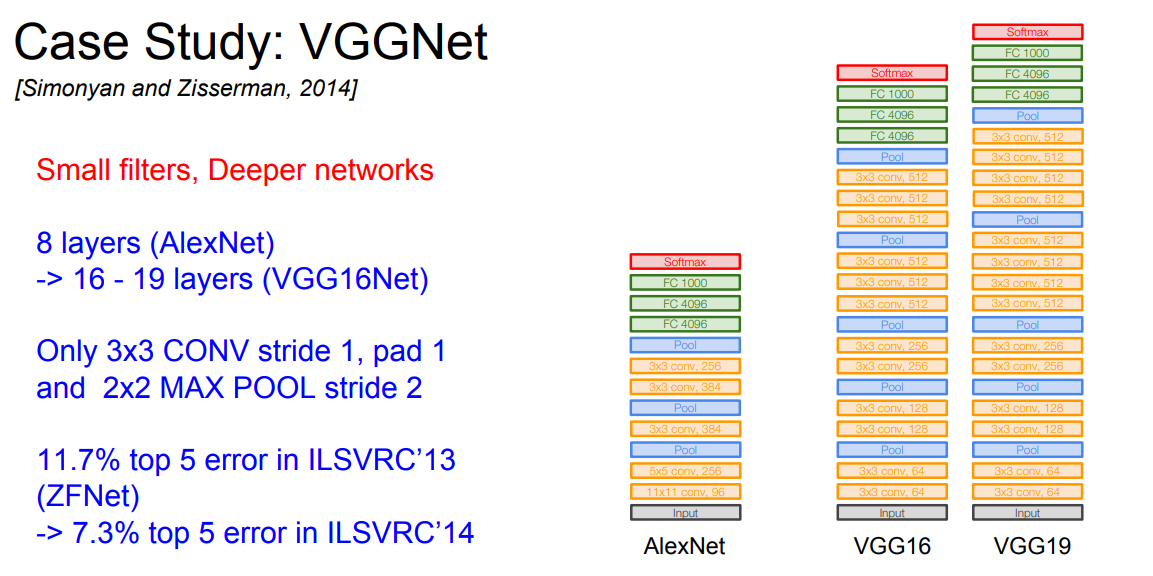

Case Study: VGGNet

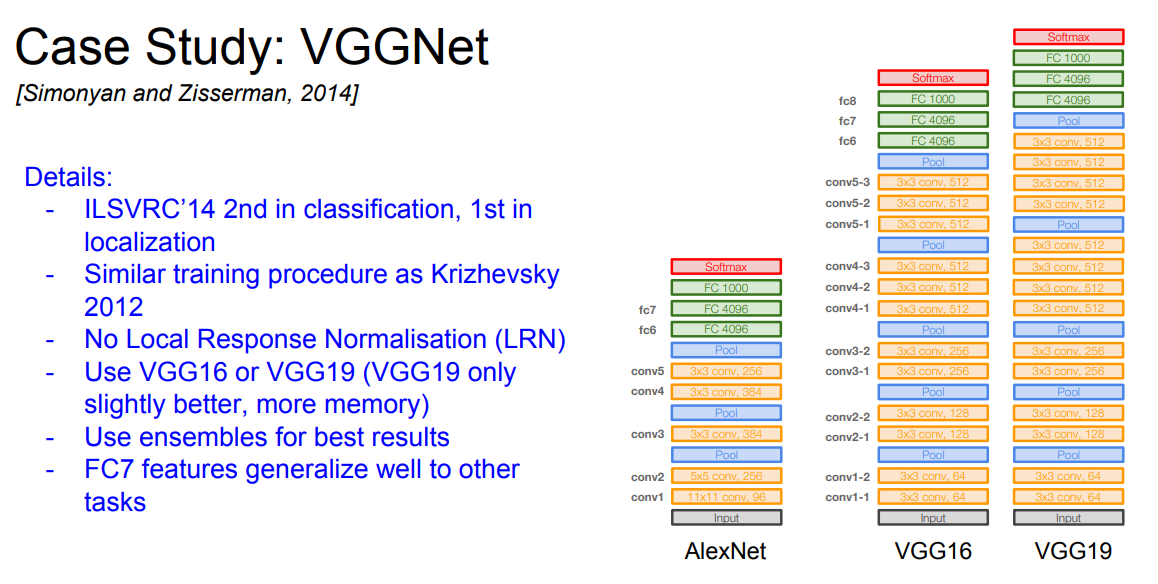

📌 다음으로는 ILSVRC'14 대회에서 2등을 한 VGGNet에 대해 소개해드리겠습니다. VGGNet은 매우 자주 사용되는 network며 classification 외에도 다른 task에서 backbone network로 매우 자주 사용됩니다.

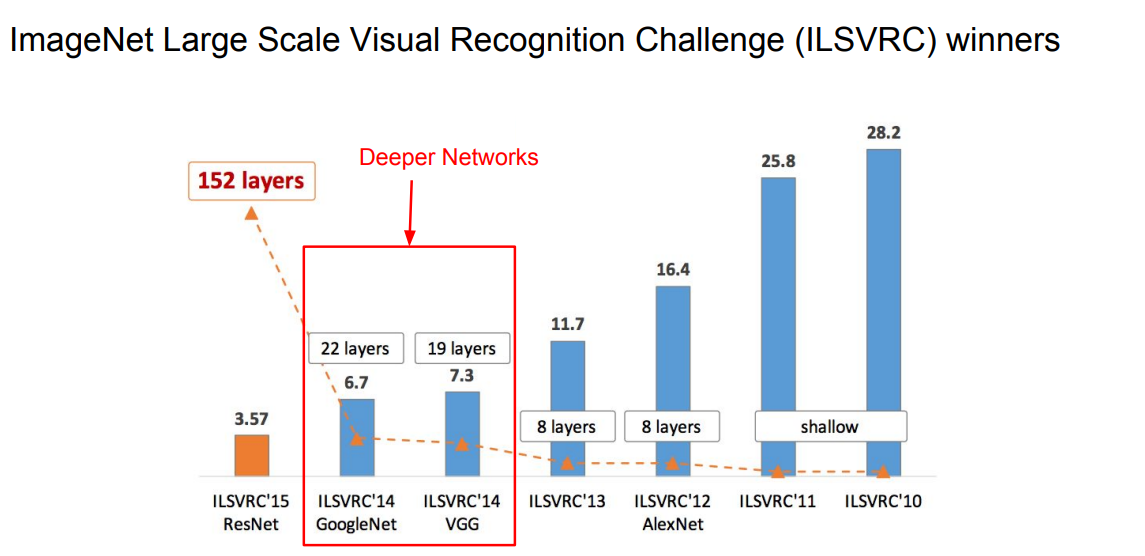

📌 VGG는 작은 필터(3x3 filter)와 깊은 네트워크로 구성되어 있습니다. 기존의 8 layers(AlexNet)애서 16-19 layers 까지 증가시켰고, 오직 3x3 filter만 사용했습니다. 위에서 볼 수 있듯이 이전의 ZFNet보다 좋은 성능을 얻을 수 있었습니다.

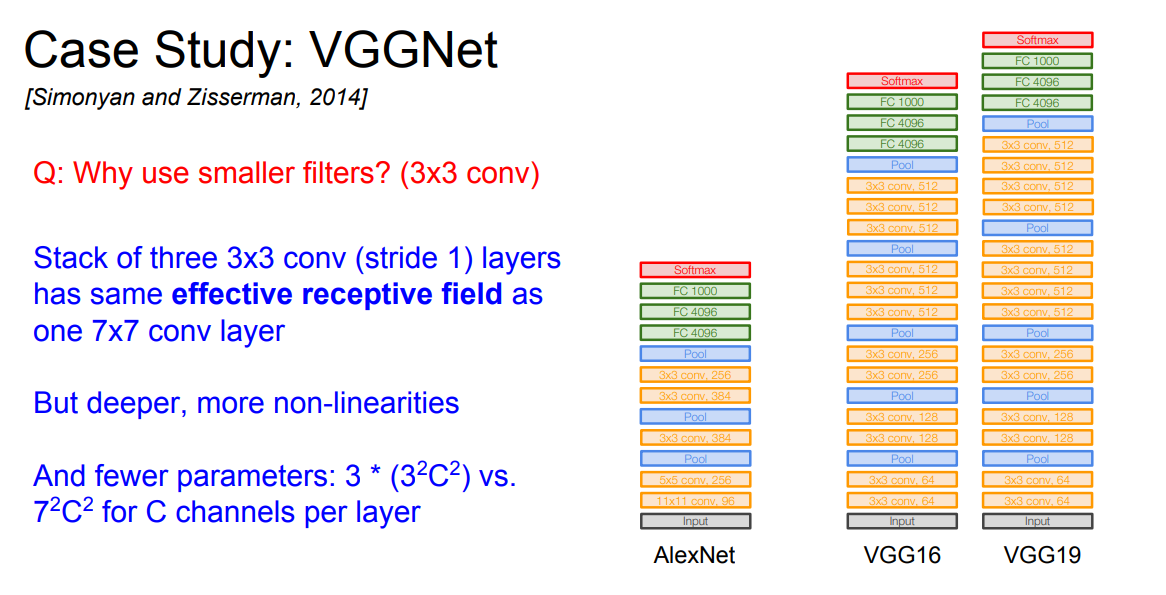

📌 VGGNet에서는 왜 3x3 filter만 사용했을까요? 3x3 filter 3개가 7x7 filter와 같은 receptive field를 구성하지만, 오히려 더 적은 파라마터 수가 요구됩니다.

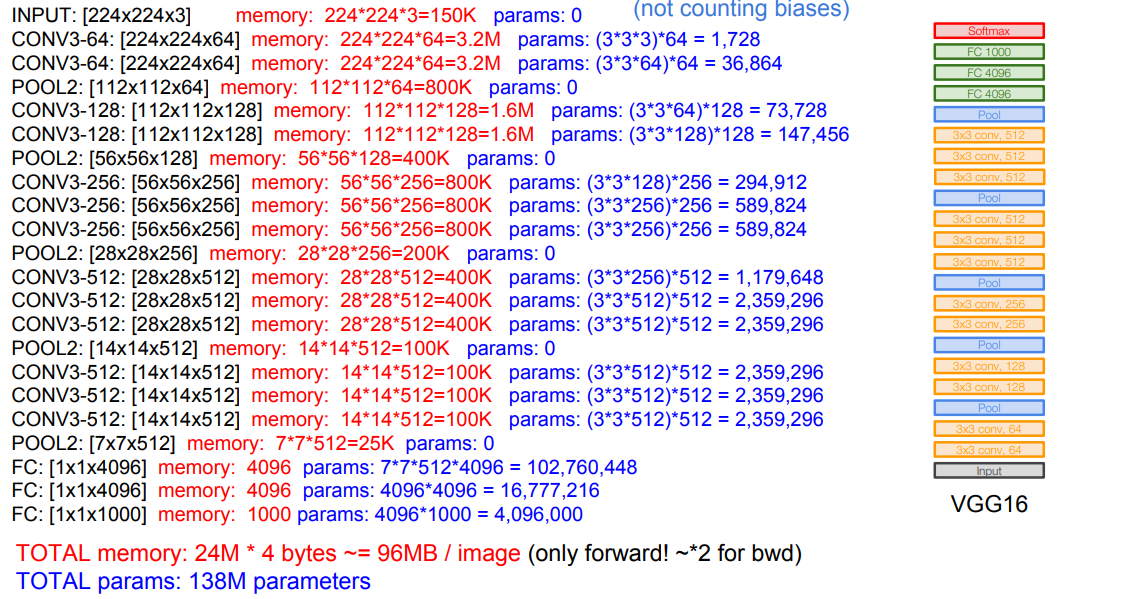

📌 위에는 VGG16 네트워크에서의 필요한 memory와 parameters 수를 확인할 수 있습니다. 각 이미지당 forward pass 기준으로 96MB가 필요하며, 138M 파라미터가 필요합니다. 위에서 확인할 수 있는 특징은 초기 Conv layer 에서 많은 메모리가 필요하며, 마지막 FC layer에서 많은 파라미터가 필요한 것을 확인할 수 있습니다.

- No Local Response Normalization(LRN)

- Use VGG16 or VGG19

- generalize well to other tasks

Case Study: GoogLeNet

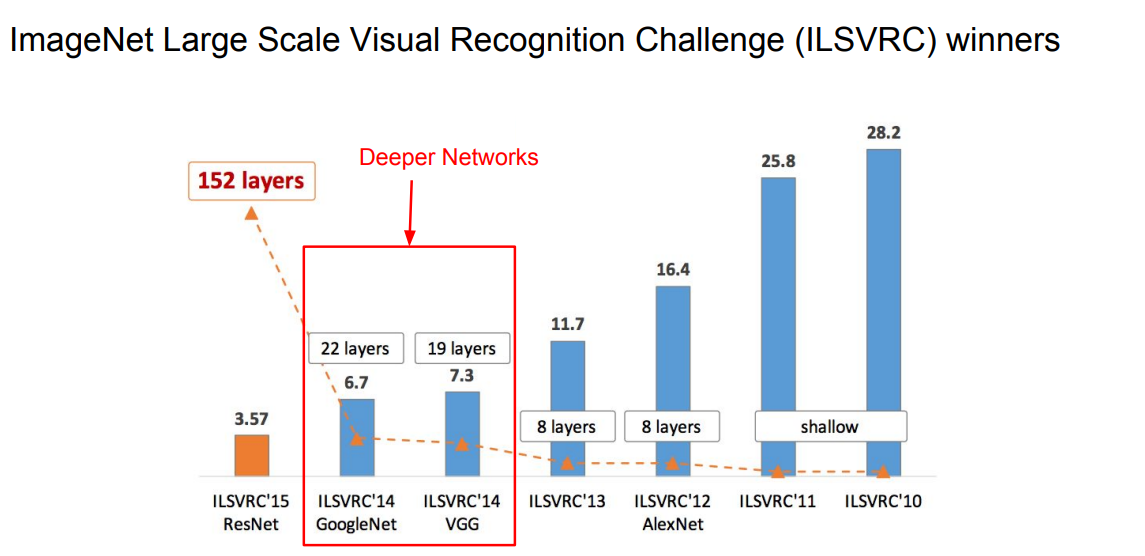

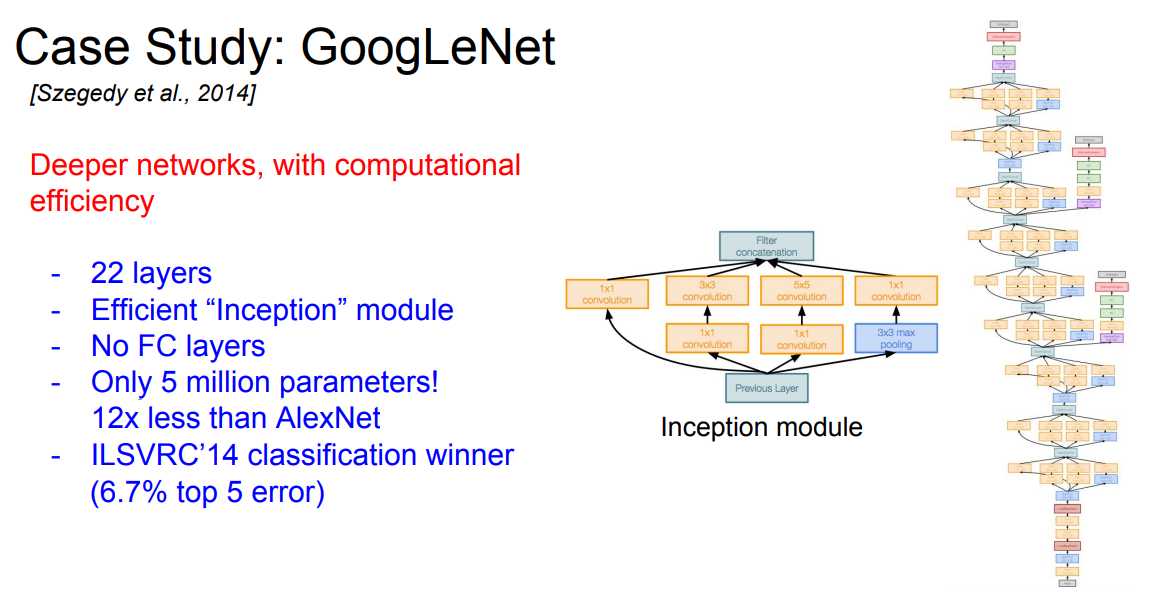

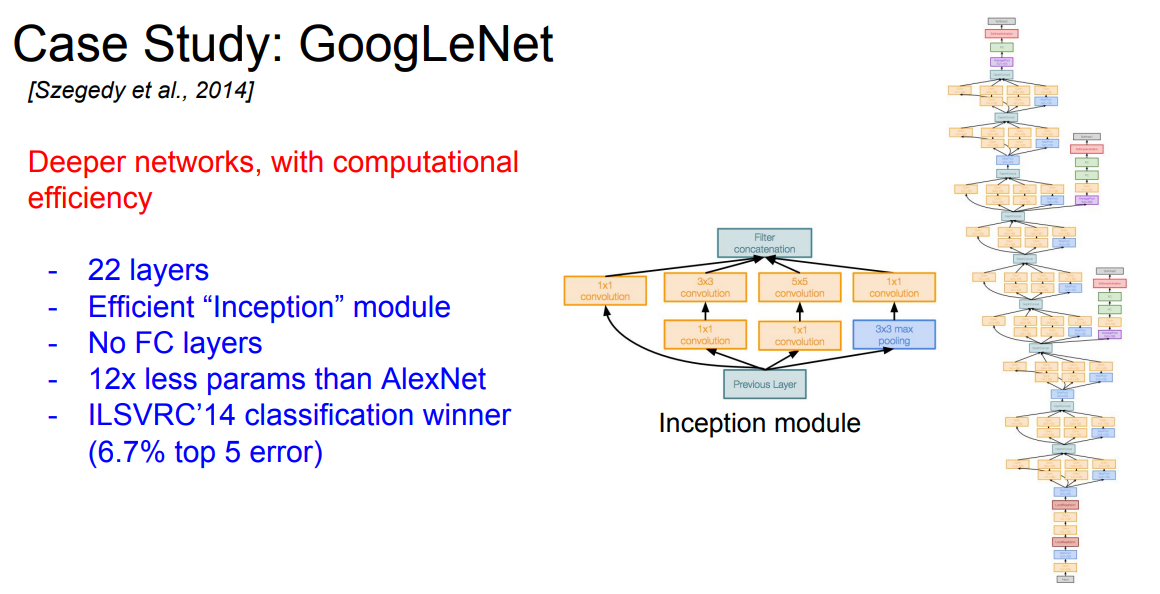

📌 다음으로는 ILSVRC'14 대회에서 1등을 한 GoogLeNet에 대해 소개해드리겠습니다. GoogLeNet은 Inception module을 사용한 Network라고 이야기할 수 있습니다.

📌 GoogLeNet은 더 깊어진 네트워크와, 추가적인 computationmal efficiency를 생각한 network라고 생각할 수 있습니다.

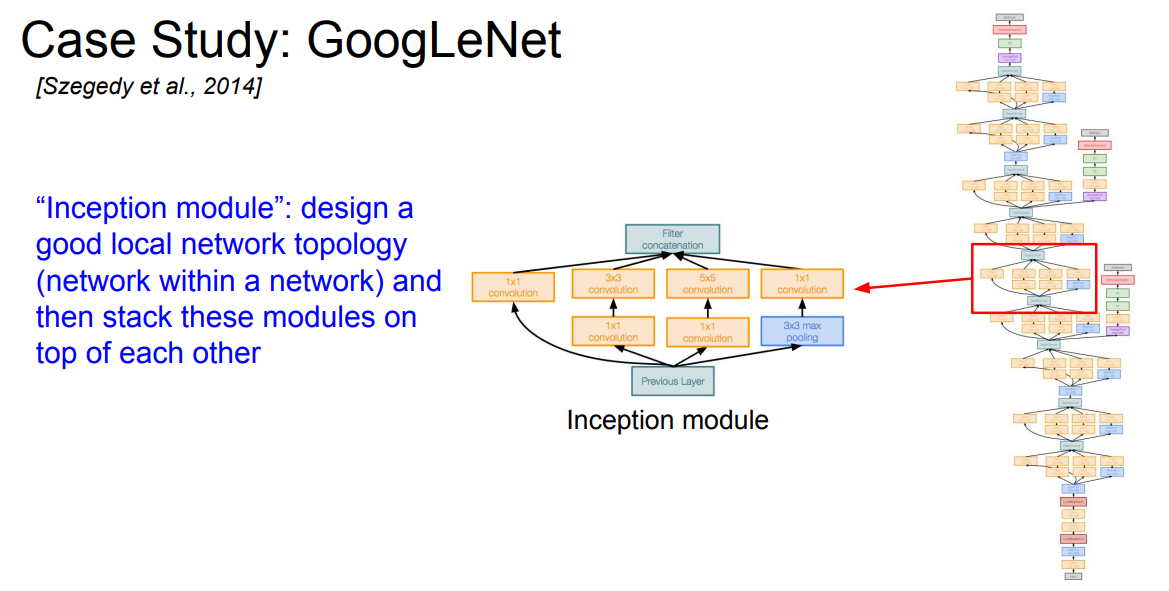

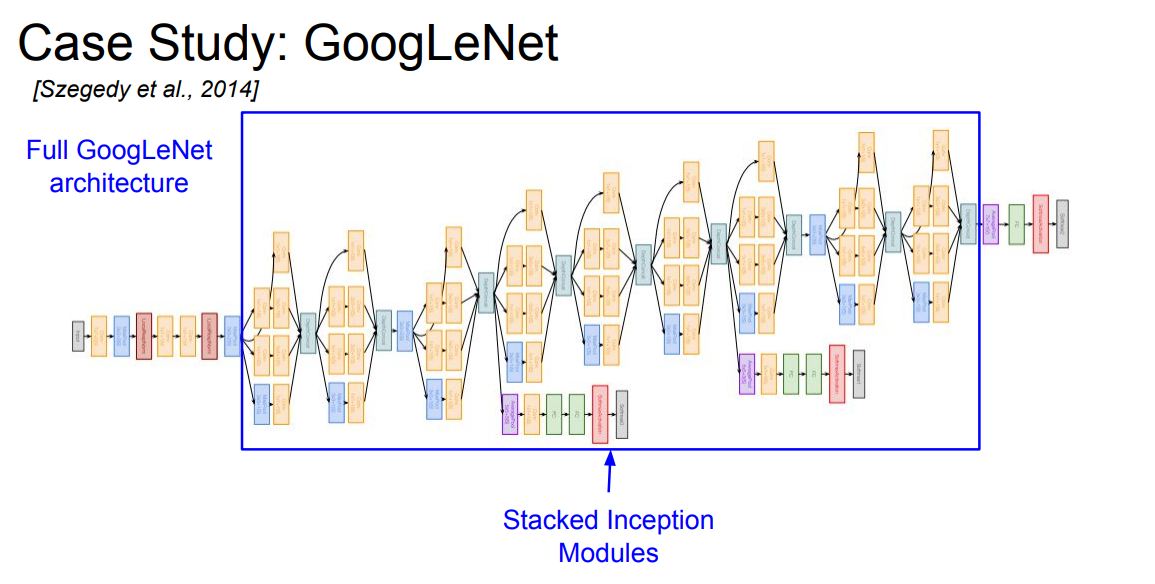

📌 GooLeNet의 핵심 네트워크는 "Inception module"이라고 말할 수 있습니다. 위에서 확인할 수 있듯이 "design a good local network topology"라고 말하고 있습니다. 또한 "Inception module"의 stack으로 이루어져있는 네트워크 입니다.

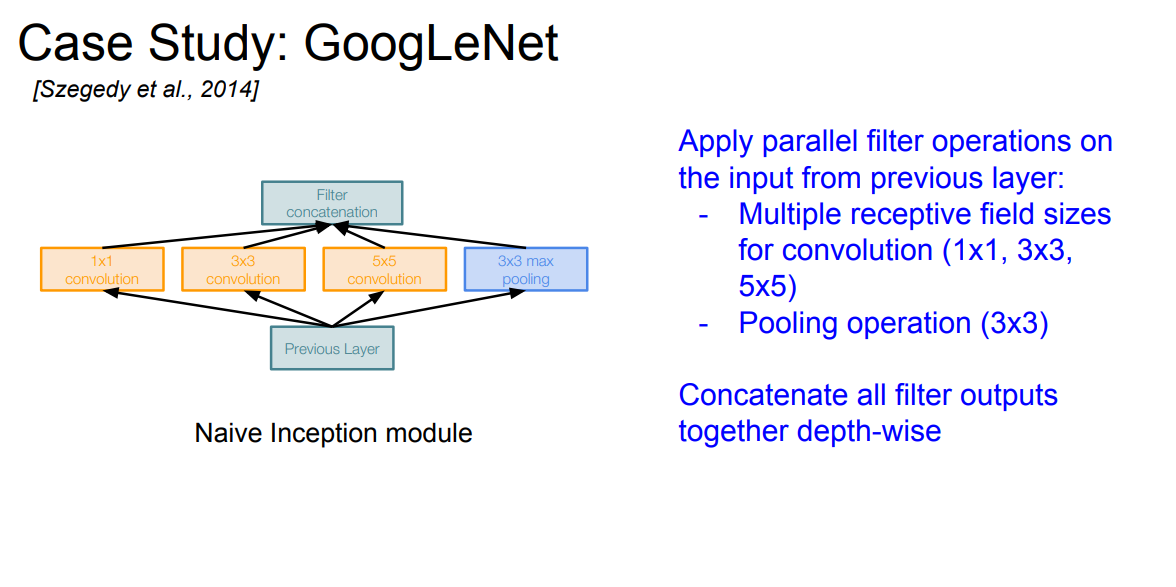

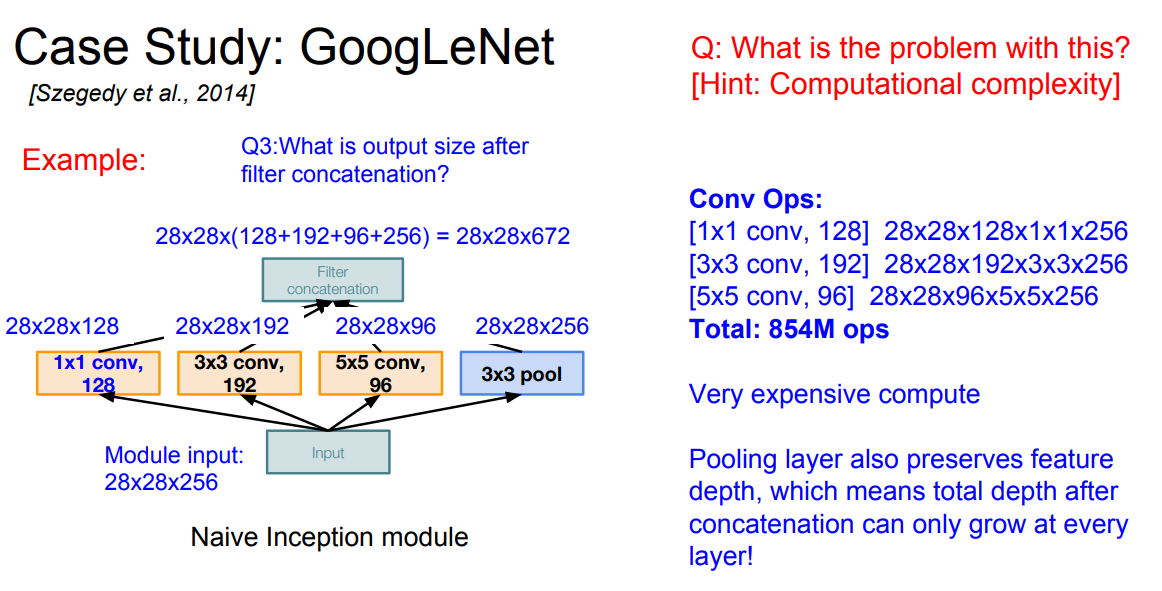

📌 위에는 Naive한 Inception module을 확인할 수 있습니다. 병렬적으로 filter을 각각 다른 filter size를 연산한 후에 concatenate(depth-wise) 연산을 수행합니다.

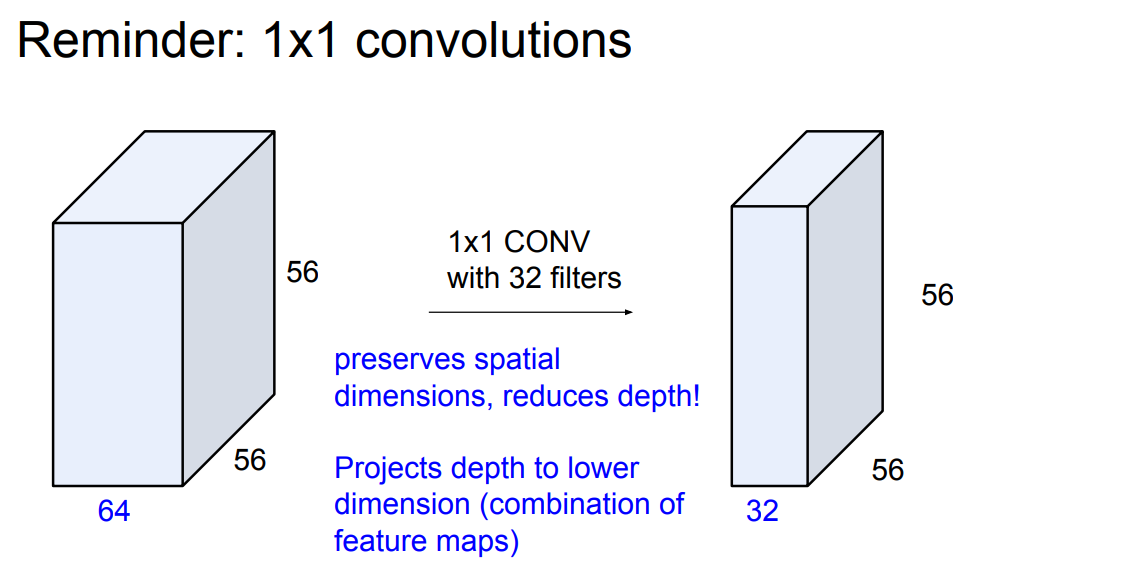

📌 위의 Naive한 Inception module에서의 문제는 매우 비싼 컴퓨팅 연산이라고 생각할 수 있습니다. 위의 파라미터 수 및 연산 수를 확인해보면 많은 연산이 필요한 것을 확인할 수 있습니다. 위와 같은 문제를 해결하기 위한 방법으로는 1x1 conv layer를 사용함으로써 feature의 depth를 낮출 수 있습니다.

📌 위에서 확인할 수 있듯이 1x1 filter을 사용해 depth를 낮출 수 있습니다.

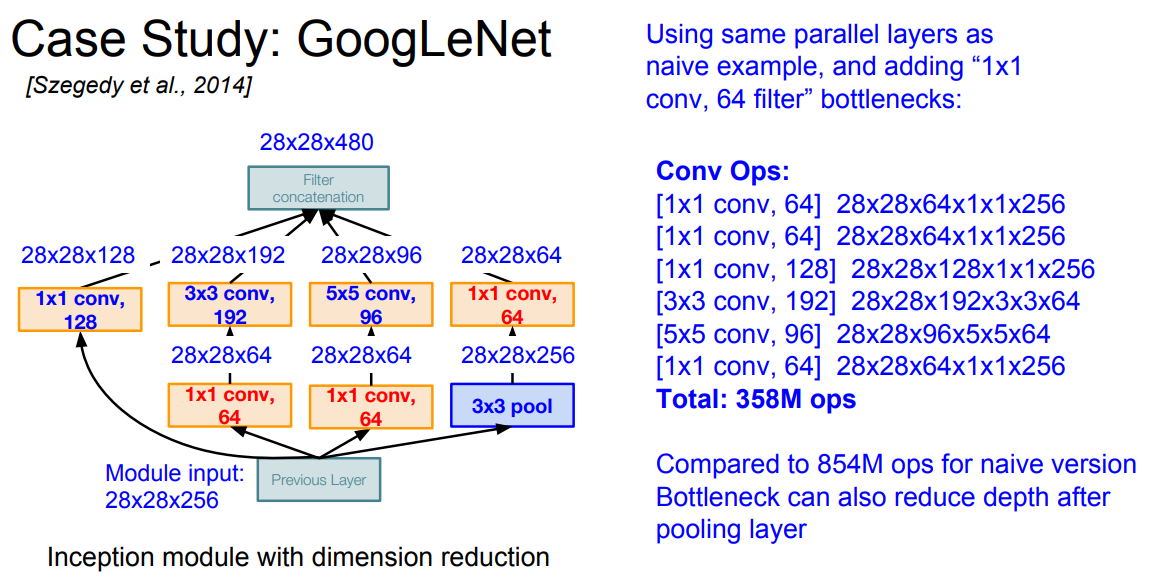

📌 위와 같이 1x1 conv layer를 추가한 새로운 Inception module를 확인할 수 있습니다. 1x1 conv layer을 통해 파라미터의 연산 수를 줄일 수 있는 것을 확인할 수 있습니다.

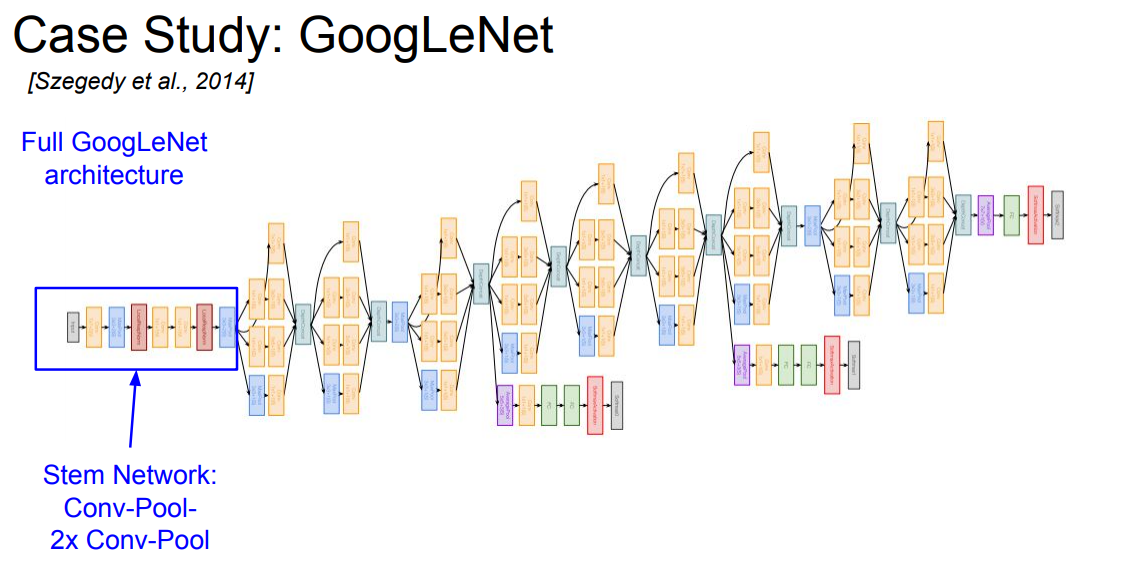

📌 GoogLeNet의 초기에는 Stem Network라고 부르며 일반적인 Conv layer을 구성합니다.

📌 이후에는 Inceptino Modules의 Stack으로 네트워크를 구성하고 있습니다.

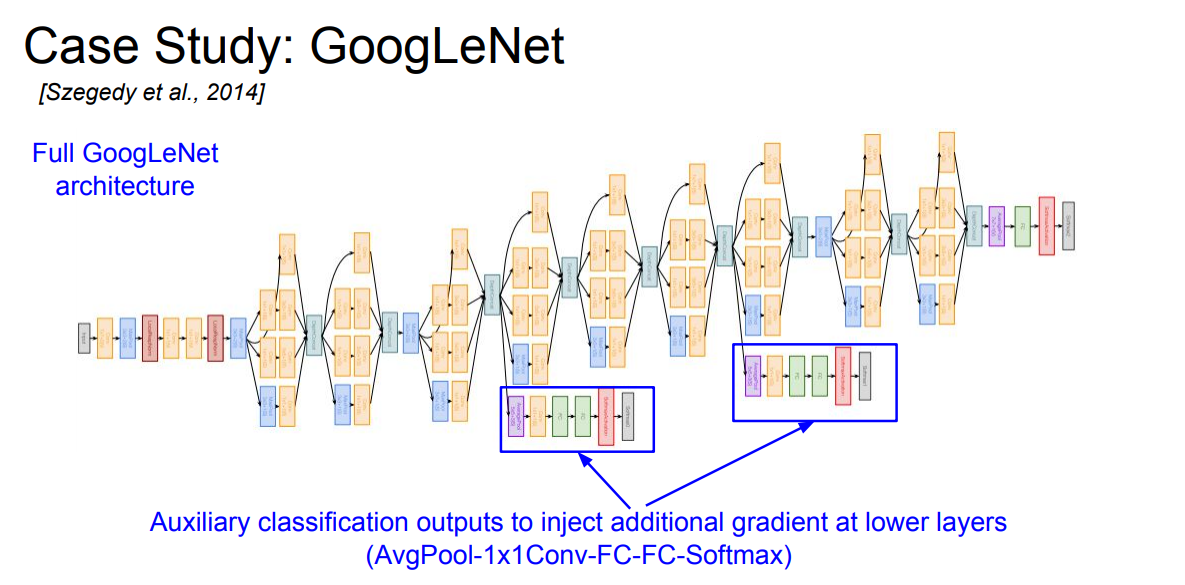

📌 또한 중간에 Auxiliary classification라는 보조 분류기를 사용해 gradient vanishing을 제어하는데 도움을 줍니다. 네트워크가 deep하게 되면 gradient가 사라지는데 이를 보조 분류기에서 도움을 줍니다.

- 22 layers

- Efficient "Inception" module

- No FC layers

- 12x less params than AlexNet

📌 GoogLeNet은 위와 같은 특징을 가지고 있습니다.

Case Study: ResNet

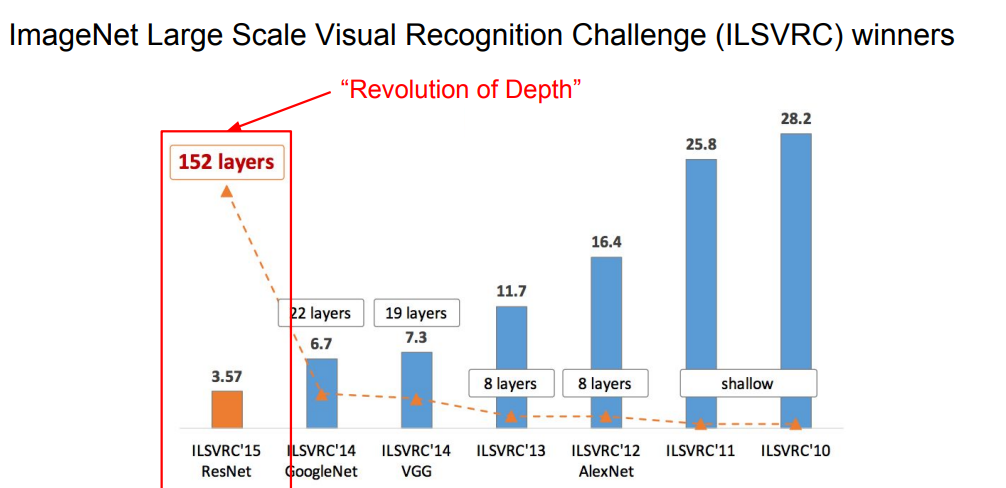

📌 다음으로는 ILSVRC'15년도 1등을 한 ResNet에 대해 소개해드리겠습니다.

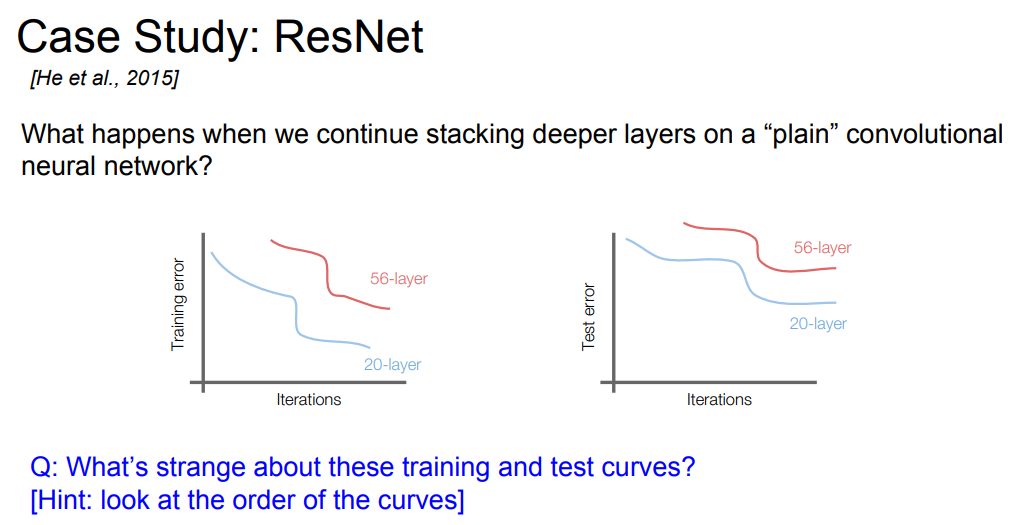

📌 먼저 저자는 만약 "plain"한 CNN에서 매우 깊은 네트워크를 학습하면 어떻게 될까? 라는 의문을 제기했습니다. 일반적으로 생각해본다면 Overfitting이 되겠다 라고 생각할 수 있습니다. 하지만 위에 그래프에서 확인할 수 있듯이 오히려 나쁜 성능을 보여줍니다. 이를 "degration"이라고 논문에서 언급합니다.

📌 생각할 수 있는 가설로는 최적화 문제를 생각할 수 있습니다. 모델이 깊어질 수록 최적화 하기에 어렵기 때문입니다.

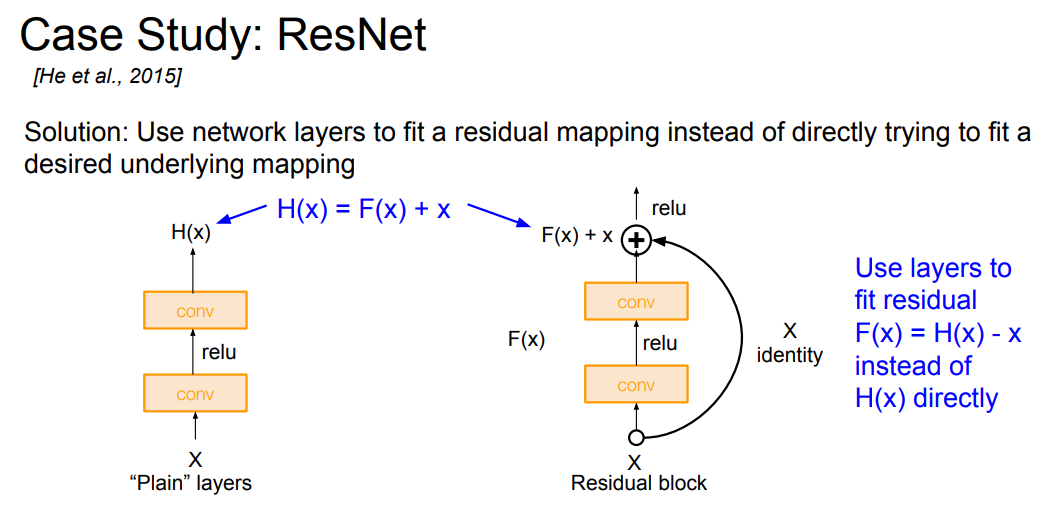

📌 이에 대한 해결책으로 위의 block 구조를 제시합니다. 을 로 계산합니다. 라고 말할 수 있으며 이를 'residual'라고 부릅니다. 에 input으로 들어온 를(identity mapping)을 더합니다. 결론적으로 resnet의 목표는 residual을 0에 가깝게 만드는 것이라고 생각할 수 있습니다. 즉, 기존의 를 근사하는 것이 아닌 residual인 를 근사한다고 말할 수 있습니다.

📌 위의 방법은 Overfitting과 gradient vanishing에 도움이 된다고 합니다.

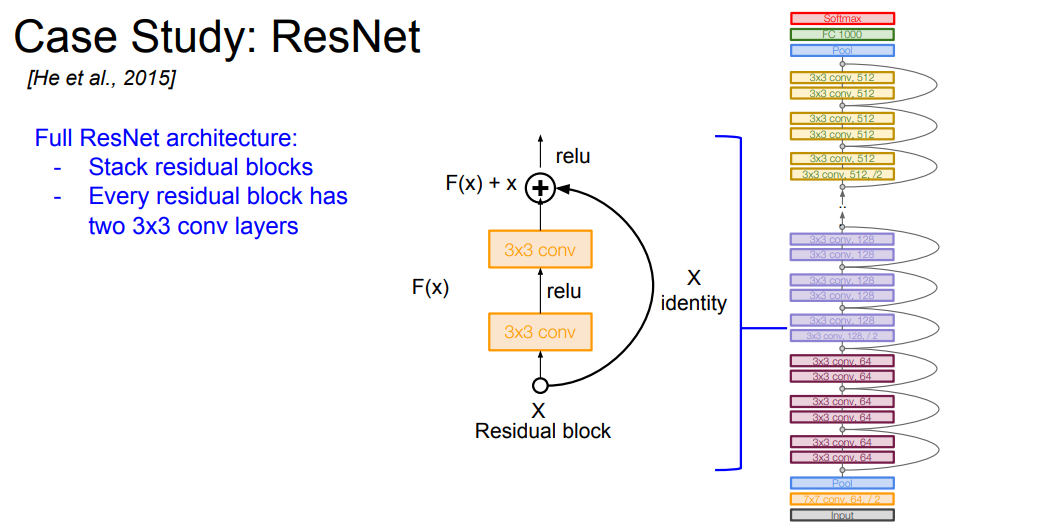

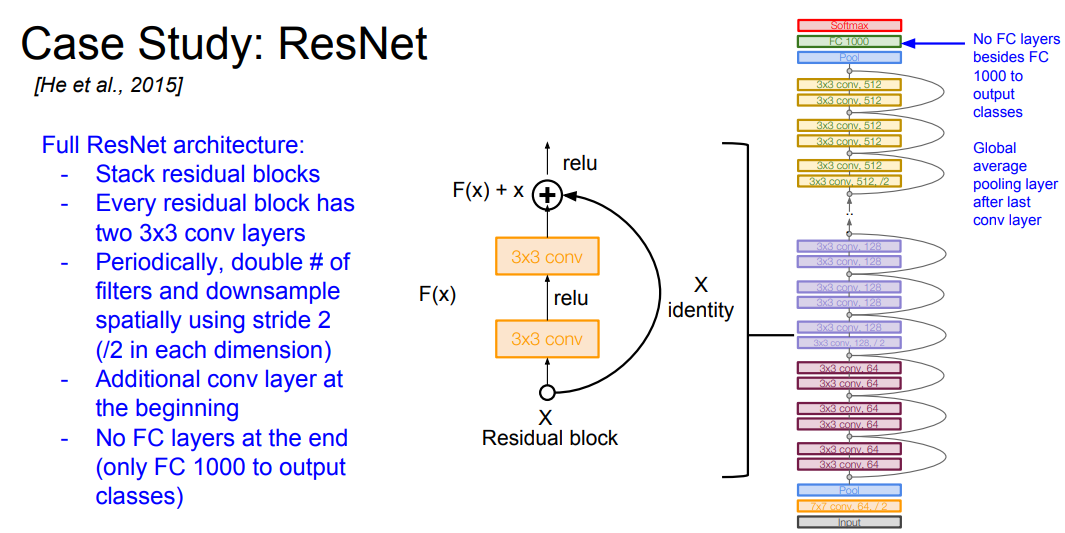

📌 전체적인 ResNet의 아키텍처는 위와 같이 여러개의 residual block으로 이뤄져 있습니다.

📌 ResNet은 최대 150 layer 정도까지 쌓을 수 있으며, 주기적으로 필터를 두배 씩 늘리고 stride 2를 이용해 downsampling을 수행합니다. 네트워크 초반에는 Conv layer가 추가적으로 붙으며 FC layer은 없습니다. 대신 GAP를 사용해 1000개의 class를 분류합니다.

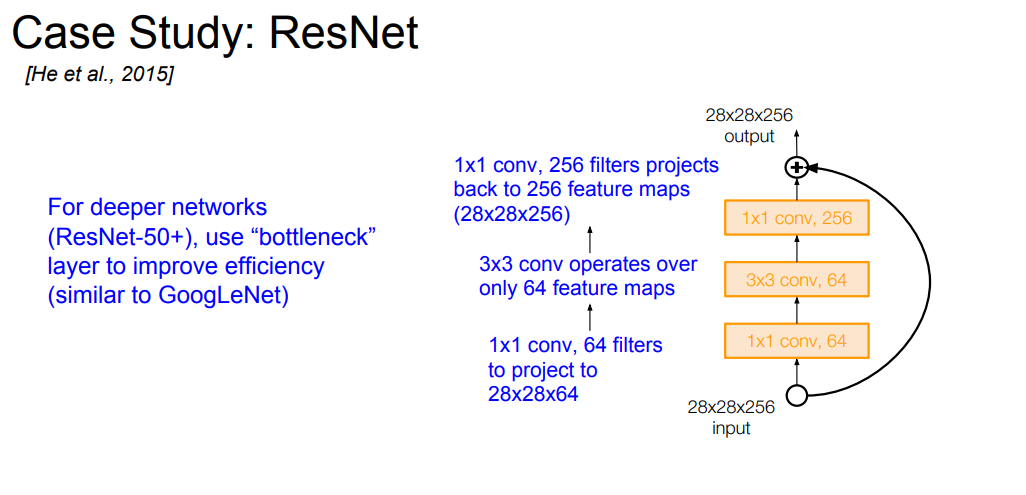

📌 ResNet은 34, 50, 101, 152 depth를 가진 버전들이 있으며, 50+이면 효율성을 위해 bottleneck layer를 추가합니다. 1x1 conv lyaer를 추가함으로써 더 적은 파라미터로 학습할 수 있습니다.

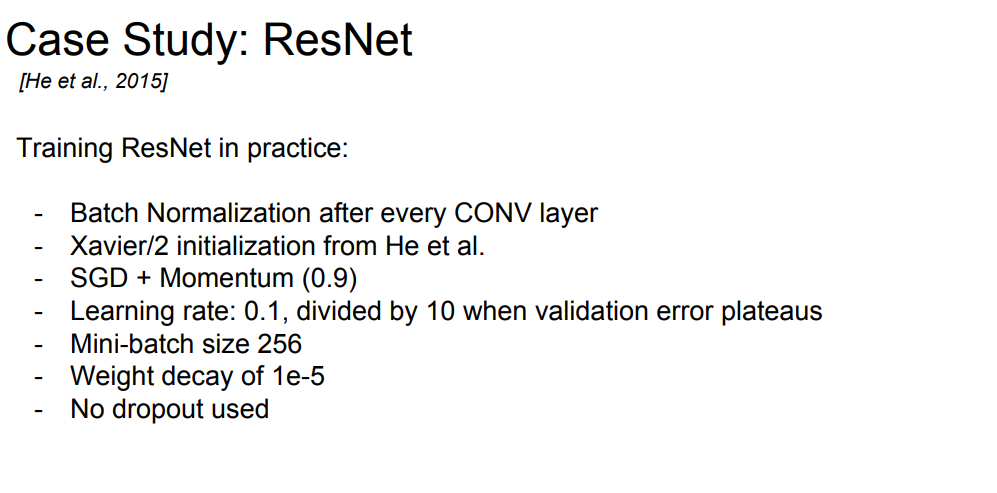

- Batch Normalization after every Conv layer

- He initialization

- SGD + Momentum(0.9)

- lr: 0.1, divided by 10 when valization error plateaus

- Mini-batch size 256

- Weight decay of 1e-5

- No dropout

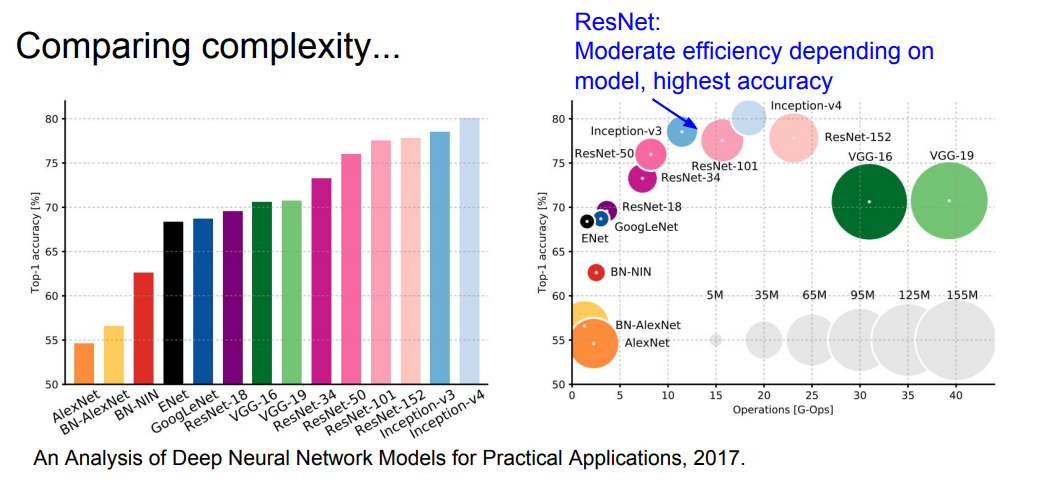

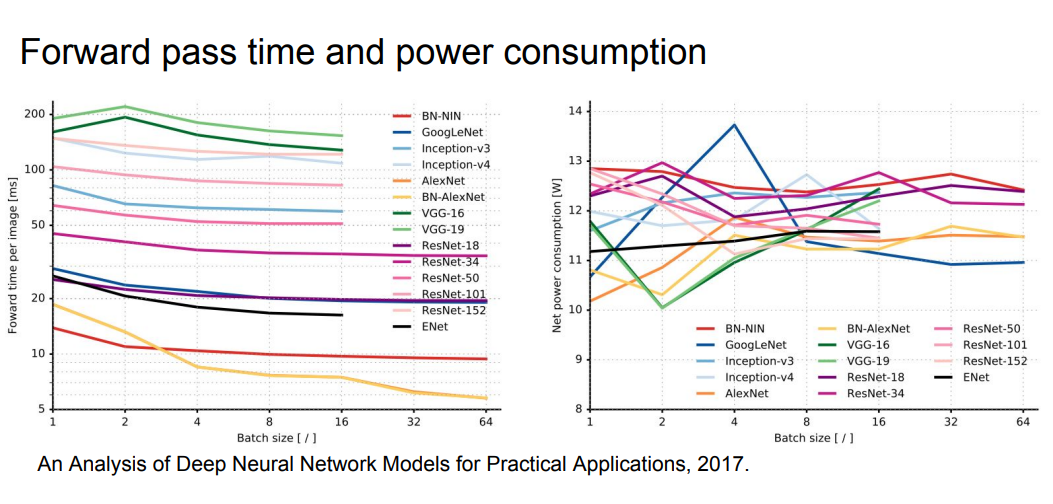

📌 지금까지 배운 다양한 CNN 네트워크들의 비교 그래프입니다. 당연하게도 가장 최근에 나온 ResNet이 다방면에서 우수한 성능을 보여주는 것을 확인할 수 있습니다.

Network in Network(NiN)

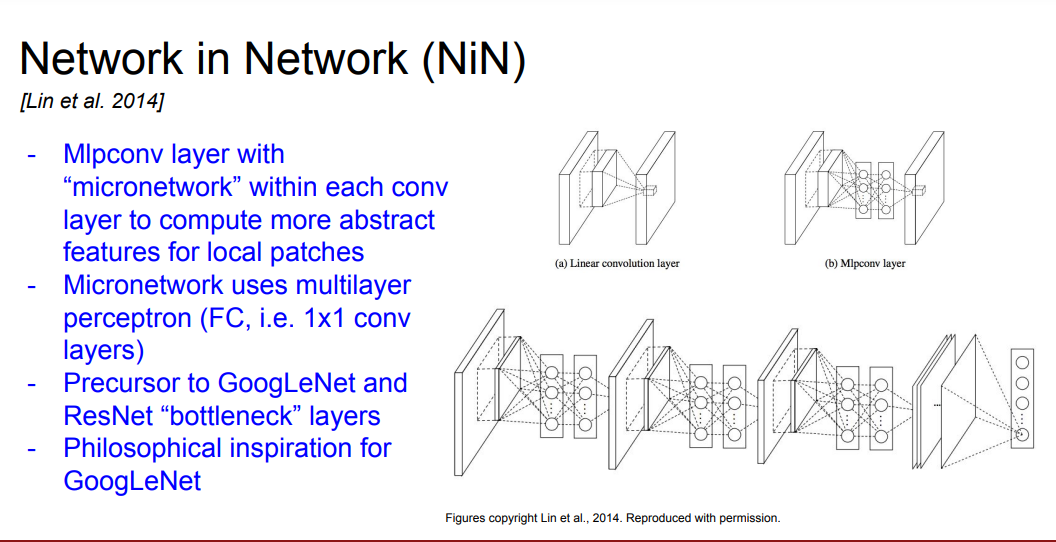

📌 이 외에도 다양한 방법론들이 존재하는데, 가장 먼저 소개해드리는 것은 NiN 모델입니다. 이 모델은 Conv layer 사이에 micronetwork를 구성하는데 이를 MLP로 구성한다고 합니다.

Improving ResNet

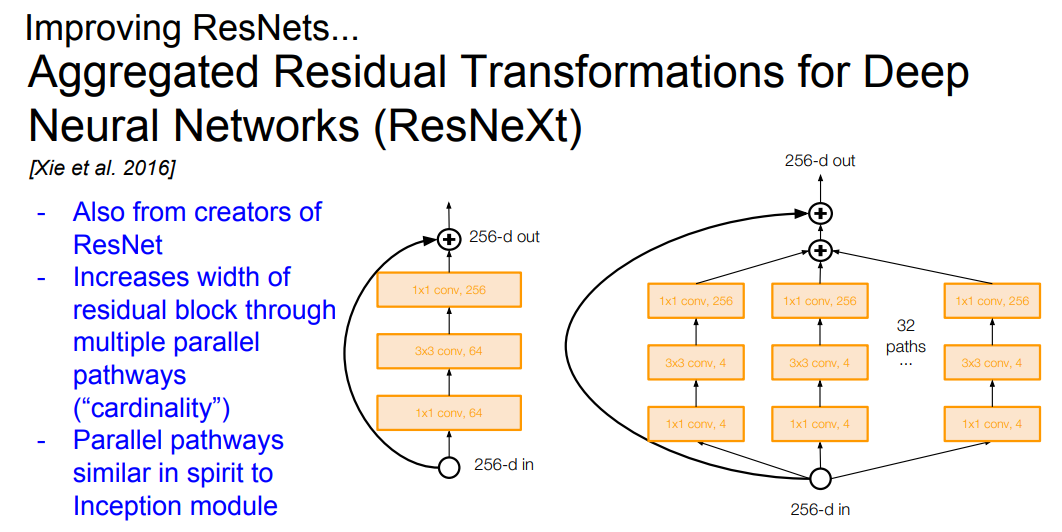

📌 ResNet의 경우에도 계속해서 연구가 이뤄지는데 이 중에 가장 논문에서 많이 보이는 RexNeXt에 대해 소개하겠습니다. 위의 그래프에서 볼 수 있듯이 residual block의 넓이 병렬적인 pathways로 증가시킵니다. 이는 inception module과 비슷한 것을 확인할 수 있습니다.

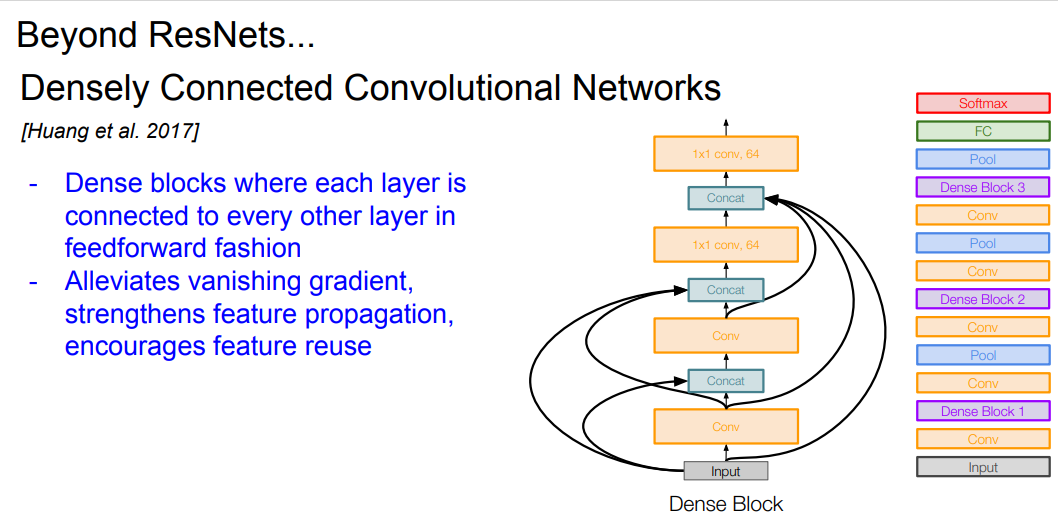

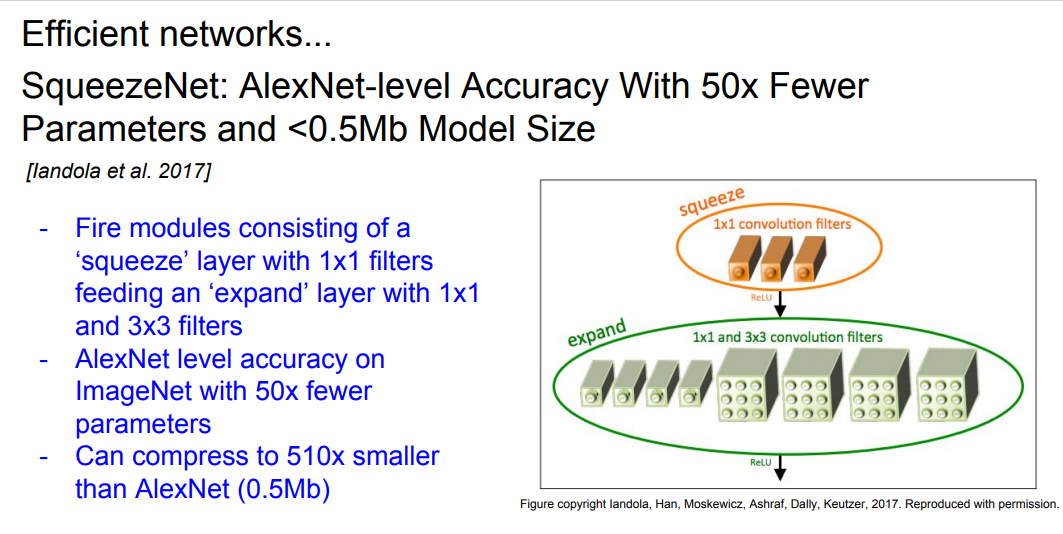

Beyond ResNet

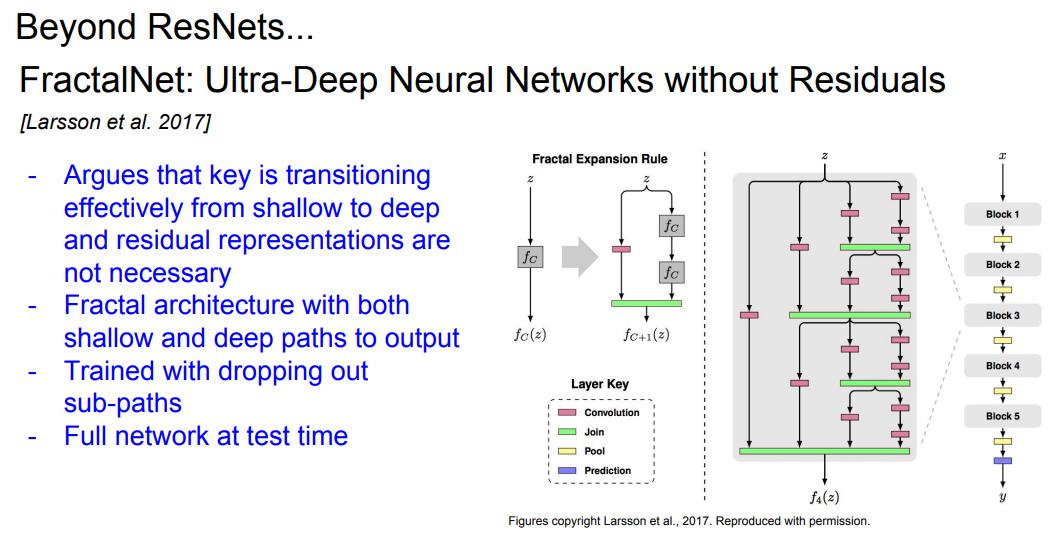

📌 이 외에도 ResNet의 residual를 사용하지 않는 몇 가지 모델을 간단하게 소개하겠습니다.

📌 위의 FractalNet, DenseNet, SqeeuzeNet은 각각의 글을 읽어보시면 도움이 될 듯합니다. 디테일한 부분이 궁금하다면 논문을 읽으시면 됩니다.

Summary

📌 오늘은 다양한 CNN network들을 알아봤습니다. 위에서 소개한 VGG, GoogLeNet, ResNet은 매우 다방면으로 사용되기 때문에 꼭 알아야하는 backbone 네트워크라고 생각됩니다.