👨🏫 본 리뷰는 cs231n-2017 강의를 바탕으로 진행했습니다.

Today

- Fanicer optimization

- Regularization

- Transfer Learning

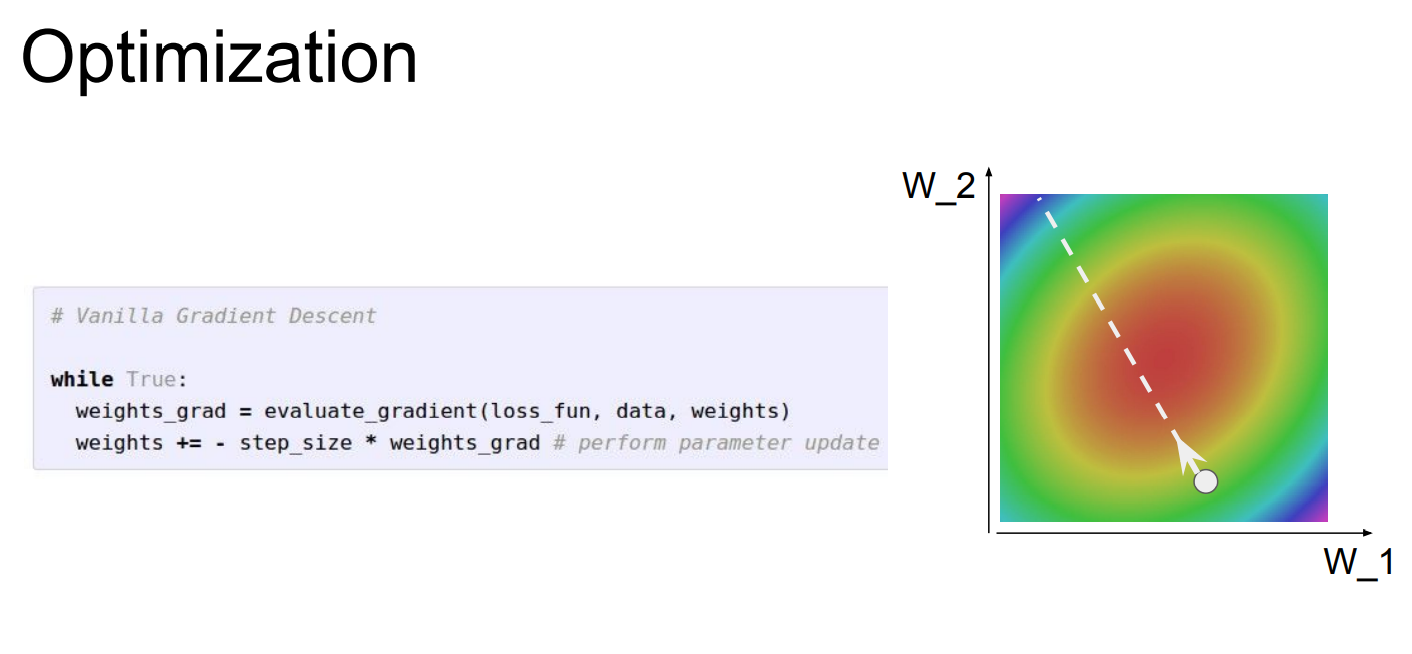

Optimization

📌 일반적으로 Neural Netwoks에서 optimization이 가장 중요한 부분 중 하나라고 말할 수 있습니다. 그리고 우리는 손실 함수가 가중치에 대한 "landscape(산)"이라고 상상해 볼 수 있습니다.

📌 위에는 단순한 가중치에 대한 그래프를 보여주고 있습니다. "red"부분이 0에 가까운 지점이라고 말할 수 있습니다. 일반적인 SGD를 사용한다고 하면 미니 배치안의 데이터에서 Loss를 계산하고, 그리고 Gradient의 반대 방향을 이용해 파라미터를 업데이트합니다.

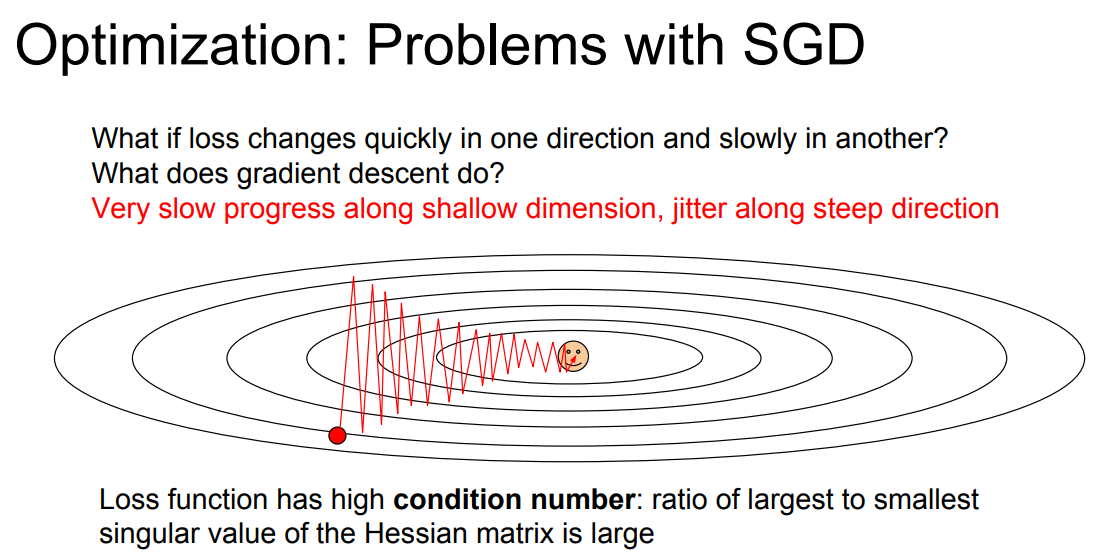

📌 하지만 이 심플한 알고리즘은 실제로 사용하게 되면 몇 가지 문제가 발생합니다.

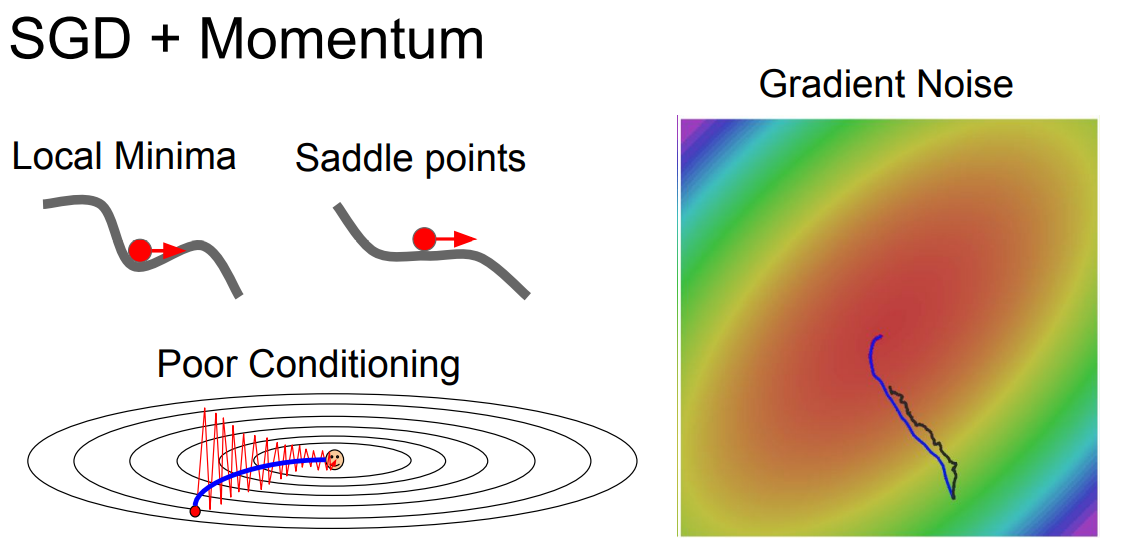

📌 첫번째 문제로는 위의 그래프와 같이 한쪽 방향으로는 빠르고, 다른 한쪽 방향으로 느리게 진행된다면 그래프와 같이 특이한 지그재그 형태를 볼 수 있습니다.

📌 위와 같이 그래프는 수평방향 차원의 가중치는 업데이트가 아주 느리게 되는 것을 볼 수 있고, 이는 매우 비효율적입니다. 위의 그래프는 단순한 차원이지만 실제에서는 더욱 빈번하게 일어난다고 합니다.

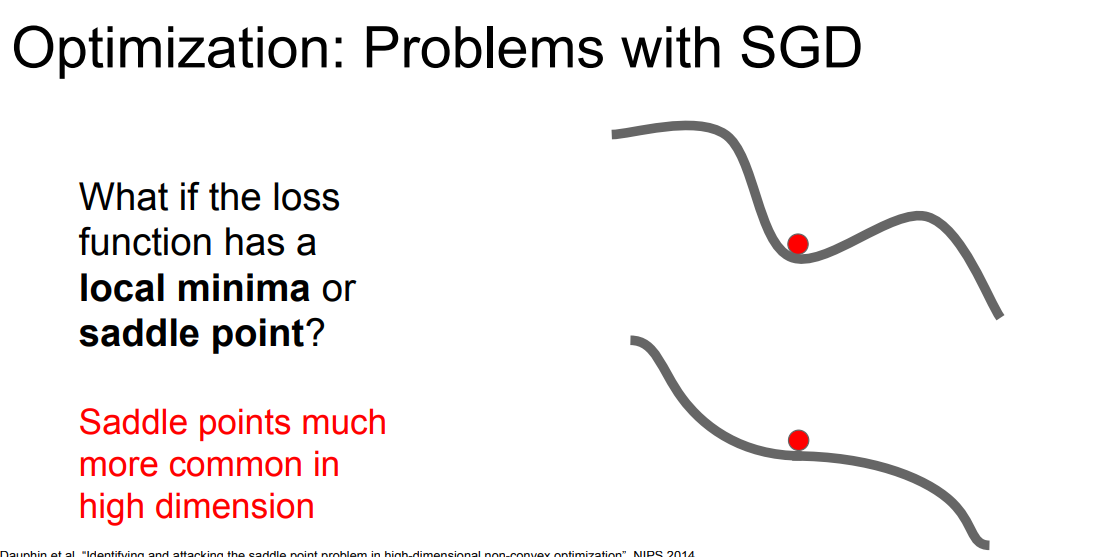

📌 위 그림은 x축은 가중치, Y축은 loss를 나타내고 있습니다. loss값이 local minima or saddle point에 위치한다면, SGD는 멈춰 버릴것 입니다. 이유는 gradient가 0이 될 것이기 때문입니다.

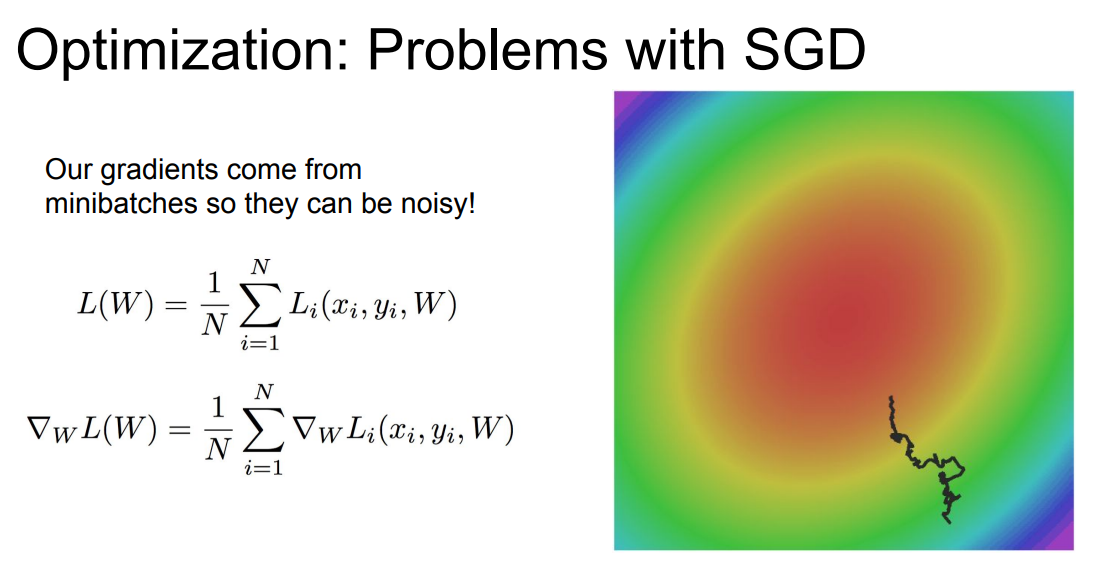

📌 또한 일반적으로 사용하는 SGD의 경우 minibatch만을 사용하기 때문에, 정확한 gradient가 아닌 noisy estimate만을 구할 뿐 입니다.

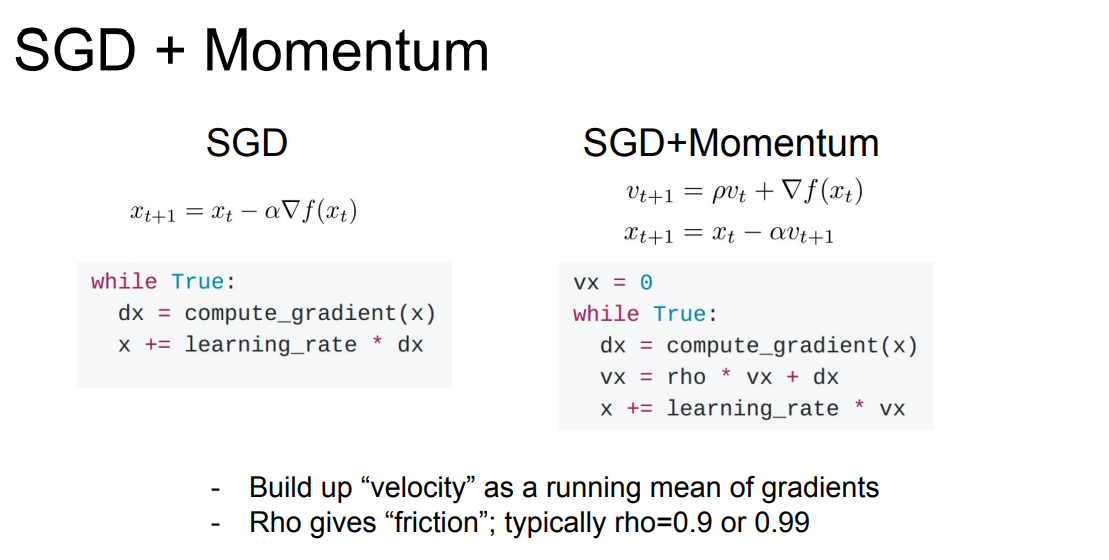

📌 위와 같은 문제점들을 해결하기 위해 나온 방법은 하나는 SGD + Momentum(관성계수)를 추가하는 것 입니다. 아이디어는 간단하게도 velocity(속도)를 유지하는 것입니다.

📌 gradient를 계산할 때 velocity를 이용하는 것입니다. 위의 코드를 바탕으로 보면 직관적으로 velocity 는 이전 gradients의 weight sum이라고 말할 수 있습니다. 또한 "rho"라는 추가 하이퍼 파라미터가 존재하는데 이는 모맨텀은 비율을 말하고, 일반적으로 0.9로 맞춰준다고 합니다.

📌 Momentum만으로도 위에서 제시된 문제들을 해결할 수 있습니다. Momentum 계수로 인해서 Local Minima 혹은 Saddle points와 같은 지점에서 멈추지 않고 진행할 수 있습니다. 또한 Momentum을 추가해 velocity가 생기면 결국 noise가 평균화 되어버린다고 합니다(?????? 이 부분은 정확히 이해가 되지 않습니다.)

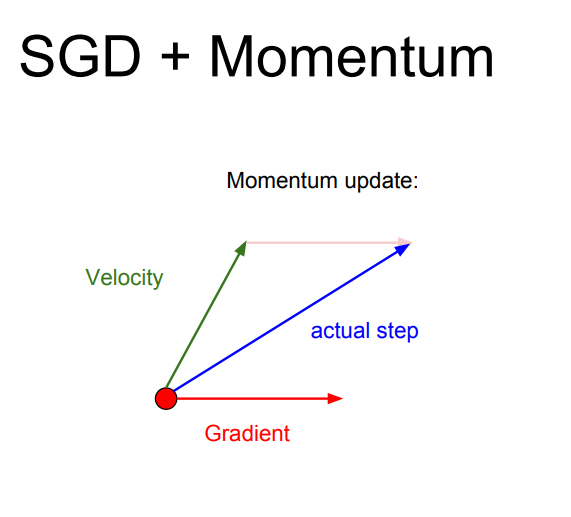

📌 velocity를 사용해 noise를 극복하는 것을 보여주는 벡터 그림입니다. 잘못된 방향으로 가고 있는 gradient velocity(momentum)을 사용해 극복하고 있는 그림입니다.

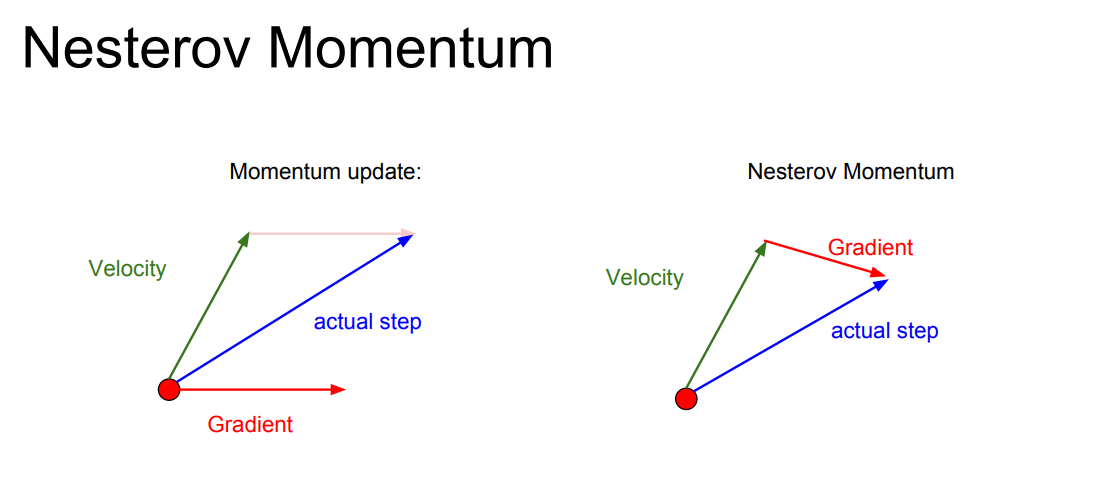

📌 오른쪽에는 "Nesterov Momentum"라고 모맨텀의 번형이 있습니다. 이는 모맨텀에서 계산 순서를 바꾼 것이라고 합니다. "velocity" 방향으로 간 후에 gradient를 계산하고, 다시 원점으로 돌아와 둘을 합친다고 합니다. 이 방법은 convex한 문제에서는 효과적이라고 하지만 neural network는 non-convex이기에 효과적이지 않다고 합니다.

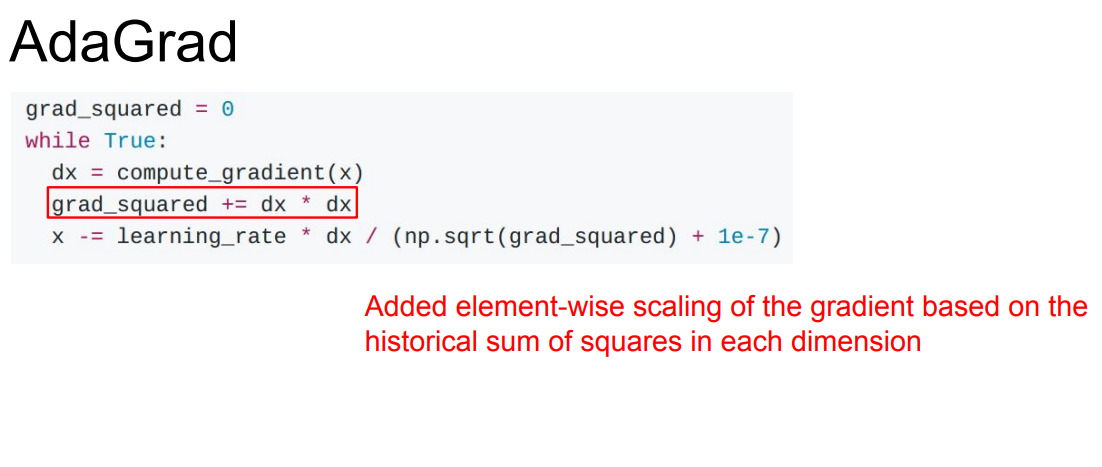

📌 또 다른 방법 중 하나인 AdaGrad는 훈련도중 계산되는 gradients를 활용하는 방법입니다. AdaGrad는 "velocity" term 대신에 "gradient_squaerd" term을 사용합니다. gradient를 제곱의 형태로 계속해서 더하며, 위의 수식과 같이 그 제곱 항을 나눠줍니다.

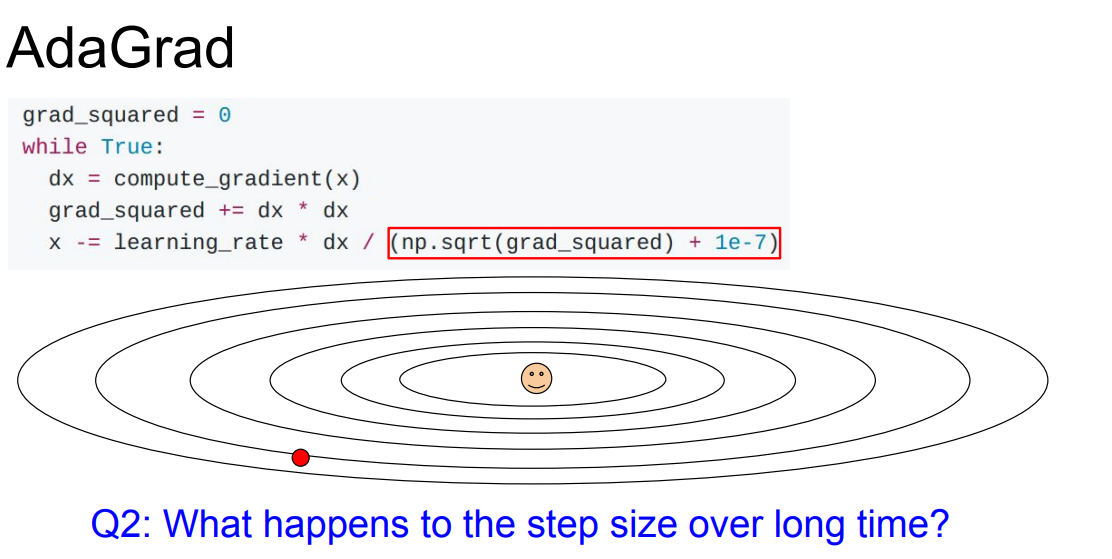

📌 2차원의 좌표에서 한 차원은 항상 높은 gradient를 가지는 차원이고, 나머지 하나는 작은 gradient를 가지는 차원이라고 가정합니다. 높은 gradient에서는 높은 "gradient_squaerd" 값을 가지기 때문에, 속도가 점점 줄어듭니다. 그 반대로 오히려 속도가 빨라질 것입니다.

📌 하지만 AdaGrad에는 문제가 있습니다. 학습 횟수 t가 계속 늘어난다면 어떻게 될까요?

step을 진행할 수록 값이 점점 작아질 것입니다. 당연하게도 gradient를 계속해서 더하고 있기 때문에, 점점 증가할 것이고 Step size를 점점 더 작은 값이 되게 할 것입니다.

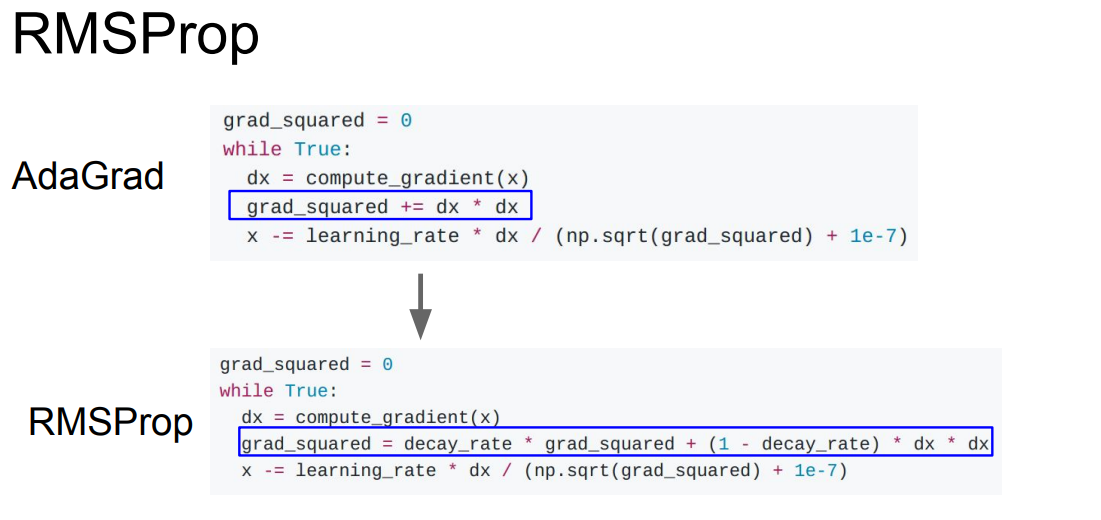

📌 이를 개선하기 위한 RMSProp 방법이 제안됩니다. RMSProp에서도 제곱 항을 그대로 사용하지만 decay_rate를 누적 값에 곱해줍니다. decay_rate의 값은 일반적으로 0.9 or 0.99를 사용한다고 합니다. 이를 통해 step의 속도를 가속/감속 시킬 수 있습니다. 즉, 위와 같은 특징으로 Step size의 값이 작게되는 것을 방지할 수 있습니다.

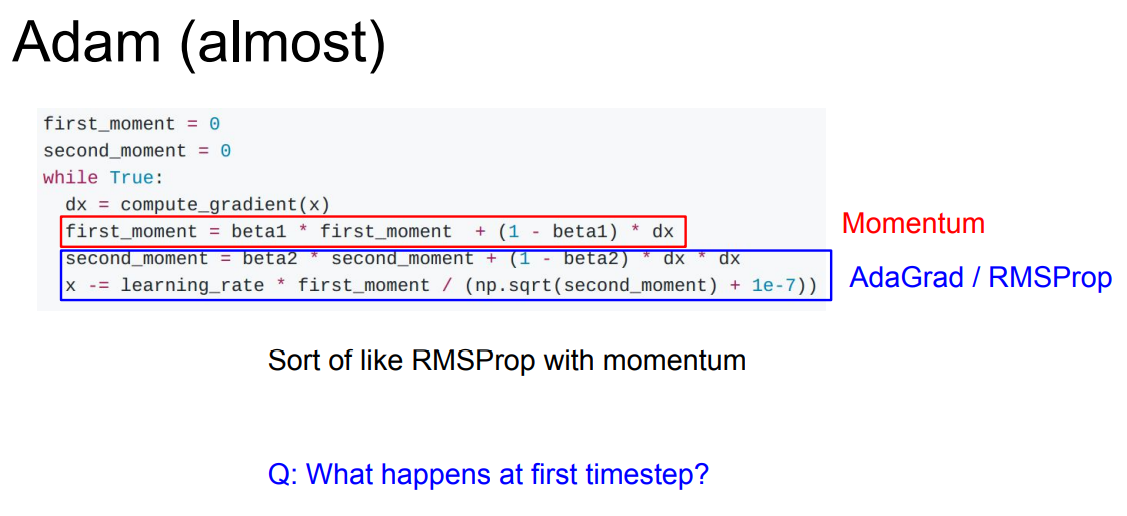

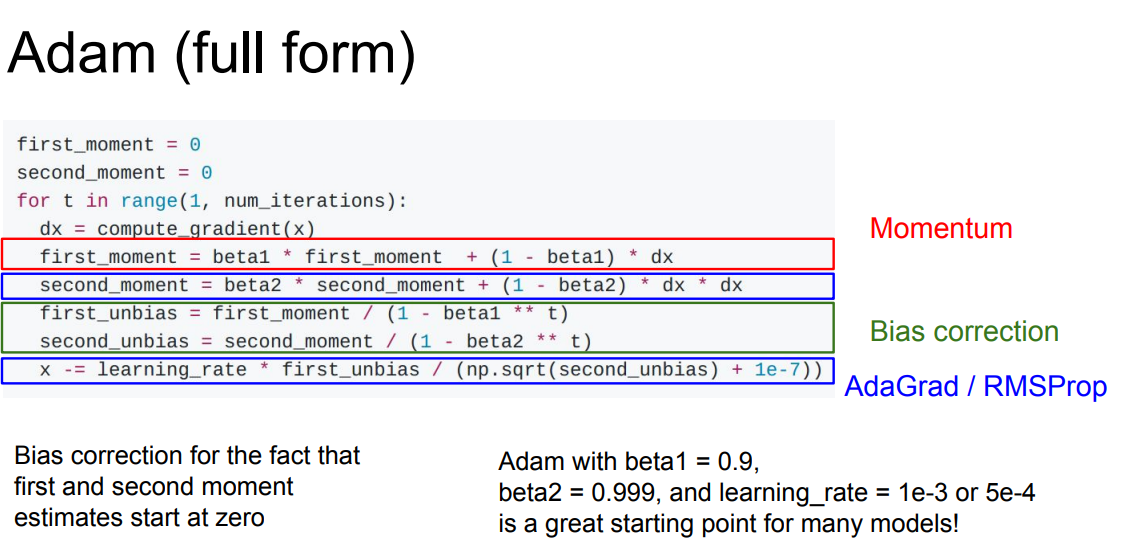

📌 먼저 RMSProp은 기존의 momentum과 다른 방식을 사용합니다. 그래서 두 방법을 합쳐서 사용하게 되면 더 좋은 성능을 가지게 될 것같습니다. 그 방법론이 바로 Adam(= momentum + RMSProp) 알고리즘 입니다. 위의 수식은 Adam 알고리즘의 일부입니다.

📌 먼저 first_moment는 velocity의 역활을 하고, second_moment gradient의 제곱 항을 나타냅니다. 하지만 여기서도 문제가 생깁니다. 바로 초기에 second_moment를 0로 초기화합니다. second moment을 1회 업데이트 하고 난 후에 보면 역시 0에 가까운 값을 가질 겁니다.(beta2(=decay_rate) 0.9 or 0.99) 그러면 초기 step이 엄청나게 커지게 되는 것을 확인할 수 있습니다. 이는 인위적인 현상이기 때문에 뭔가 조치가 필요합니다.

📌 위의 문제를 해결하기 위해 unbiased term을 계산해 줍니다. unbiased term을 통해 위의 문제를 해결해 줄 수 있다고 합니다.

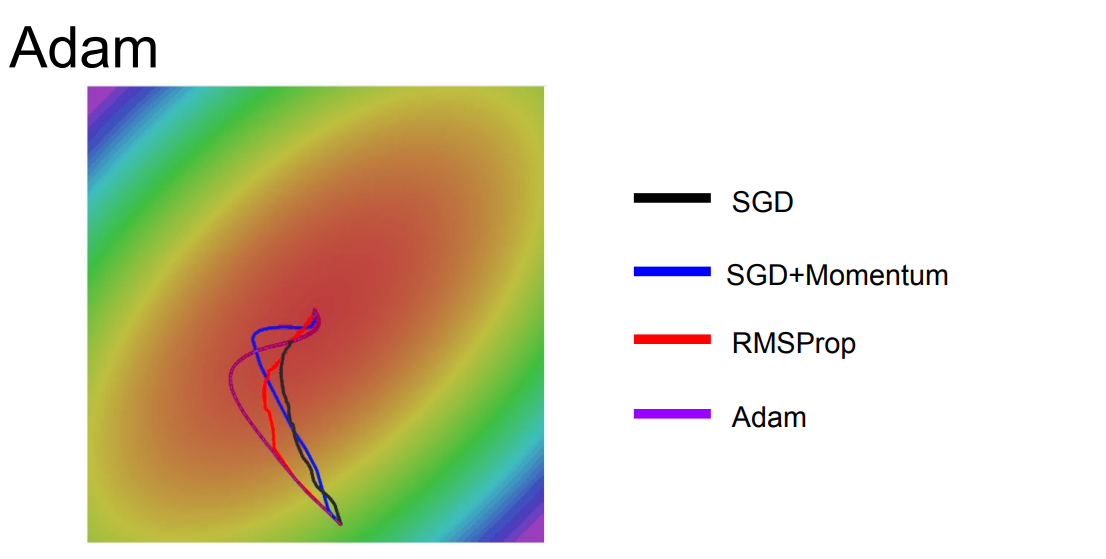

📌 Adam optimization의 그래프를 보여줍니다.

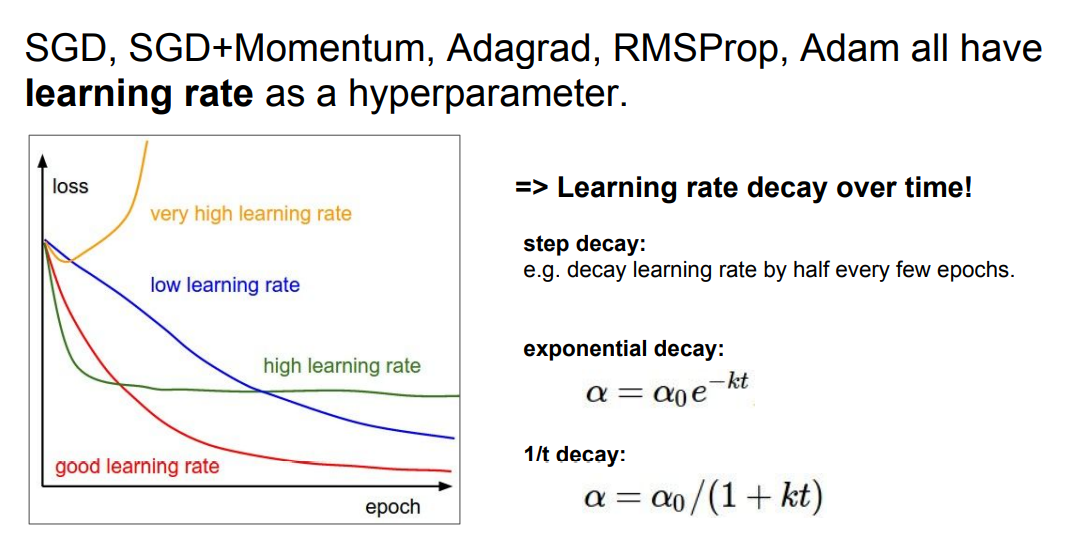

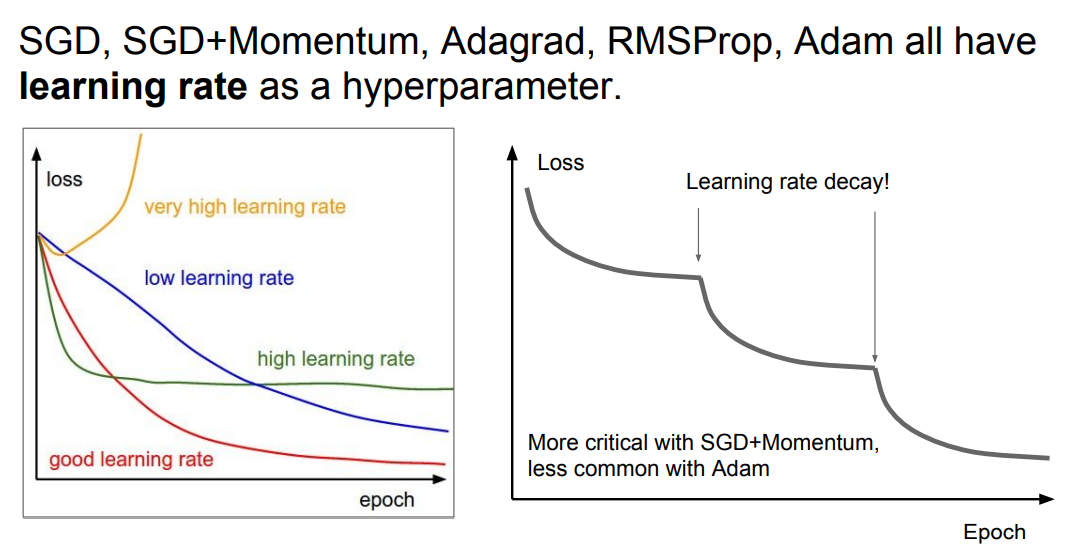

📌 지금까지 배운 모든 optimization 방법에는 learning rate가 존재합니다. 결론적으로 좋은 모델을 만들기 위해선 적절한 learning rate가 필요합니다. 위의 그래프 처럼 learning rate에 따라서 loss의 그래프가 확연하게 차이나는 것을 확인할 수 있습니다.

📌 저흰 learning rates dacay 전략을 사용해, 각각의 learning rates의 특성을 적절히 이용할 수 있습니다.

📌 처음에는 learning rates를 높게 설정한 다음에 학습이 진행될수록 learning rates를 점점 낮추는 것입니다. 위의 그림은 ResNet논문의 loss 그래프 입니다. 평평해지다가 갑자기 내려가는 구간이 learning rates를 낮추는 구간이라고 생각할 수 있습니다. learning rates를 낮추는 구간은 현재 잘 수렴하고 있지만 gradient가 점점 작아지고 있다면, learning rate의 값이 커 더욱 깊게 들어가지는 못하는 것이기 때문에 learning rates을 낮춰줍니다.

📌 추가적으로 learning rates decay는 추가적인 하이퍼 파라미터인데 이를 처음부터 고려하지 말라고 합니다. 너무 경우의 수가 많기에, 먼저 decay 없이 수행해보라고 합니다.

🤷♂️ 이후 지금까지의 optimization 알고리즘들은 모두 1차 미분을 활용한 방법이라고 이야기 하면서, 2차 미분을 사용해 정보를 추가적으로 사용할 수 있다고 합니다. 이를 사용하면빠르게 minima 지점을 찾을 수 있다곤 하지만... neural network에서는 사용하기 어렵다고 합니다. NxN Hessian 메트릭스가 필요한데 이는 너무나도 메모리를 필요로 하기에 잘 사용하지 않는다...합니다만.. 이 부분은 어려워서 잘 모르겠스빈다..

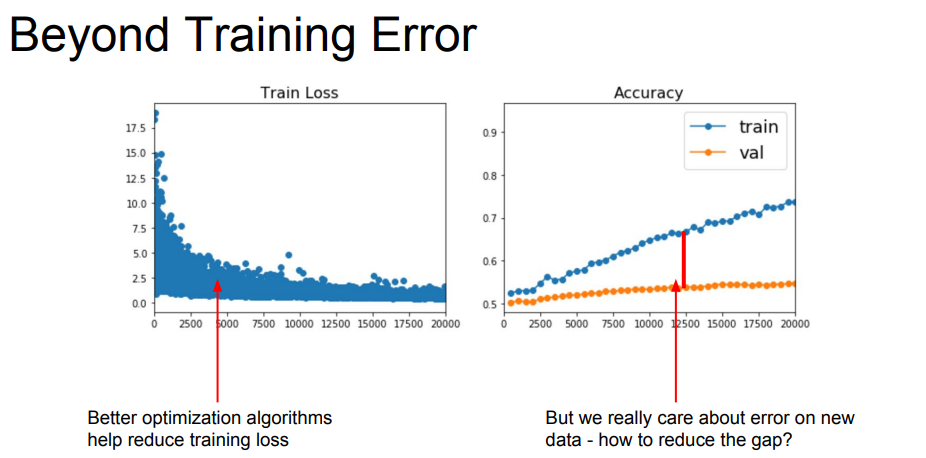

Regularizations & Model Ensembles

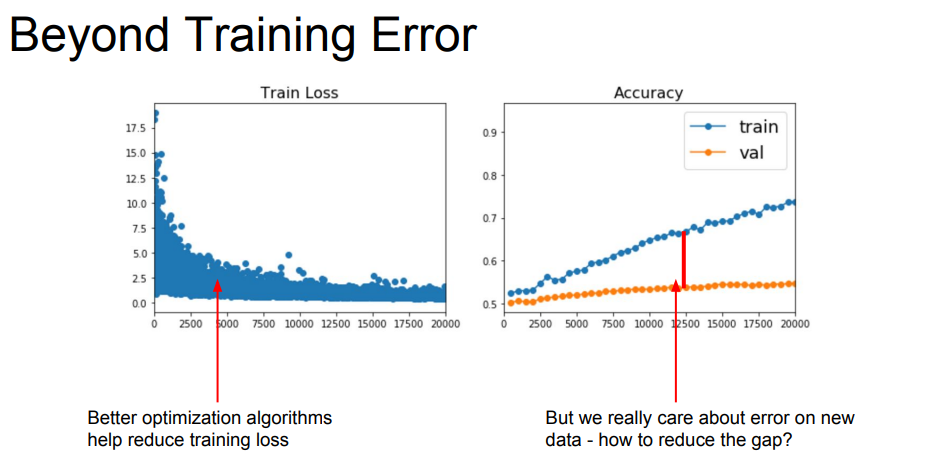

📌 위의 그래프를 보면 완벽하게 fit되지 않는 train loss와 train, val의 큰 gap을 볼 수 있습니다. 위의 문제들을 해결하기 위해 다양한 방법을 사용할 수 있씁니다.

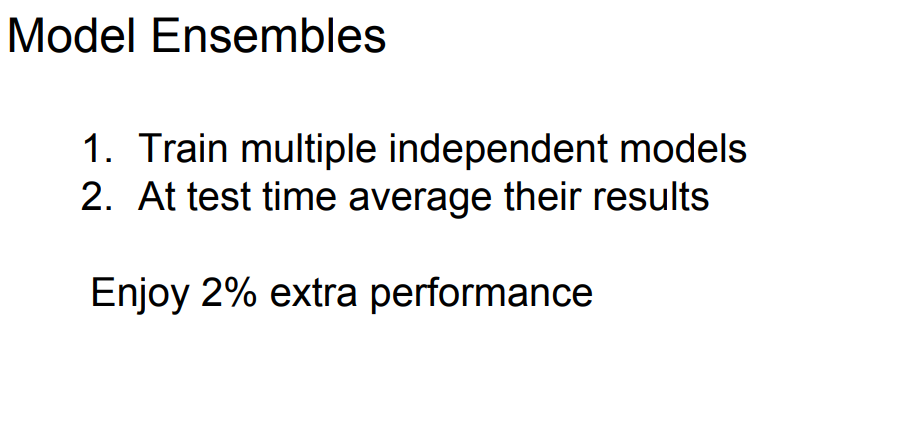

Model Ensembles

📌 주로 머신러닝에서 사용되는 모델 앙상블 기법입니다. 모델 하나만 학습시키지 않고 10개의 모델을 독립적으로 학습시켜 모델의 결과의 평균을 이용합니다.

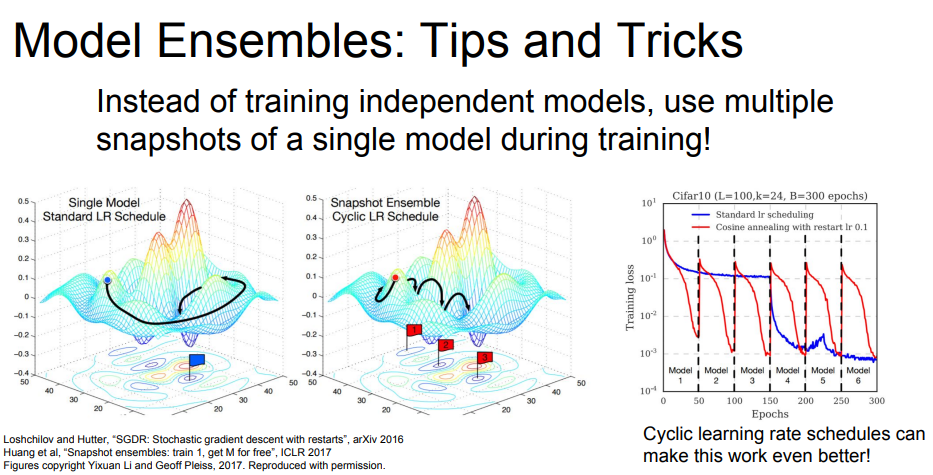

📌 독립적으로 모델을 학습시켜 앙상블 하는 것외에도, 학습 도중 중간 모델들을 저장(snapshots)해 앙상블 할 수도 있습니다. Test시 여러 snapshot의 결과를 평균으로 사용하는 것입니다.

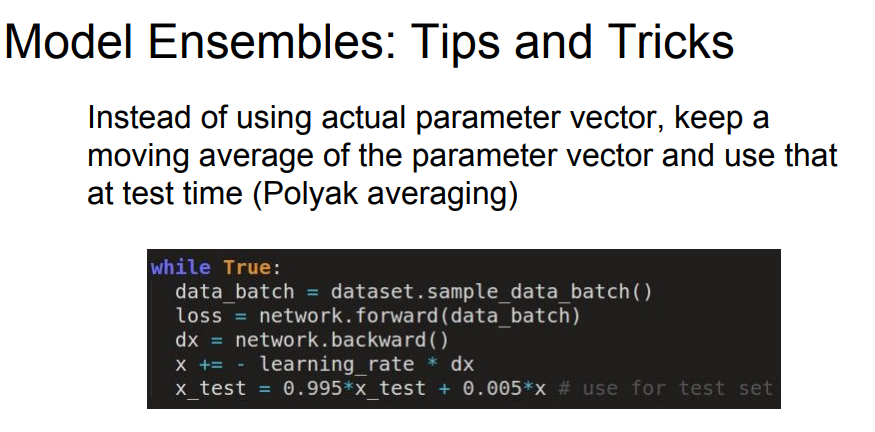

📌 또 다른 방법으로는 학습하는 동안 파라미터의 decaying average를 계산해 사용합니다. 이 방법은 smooth 앙상블 효과를 볼 수 있다고 합니다.

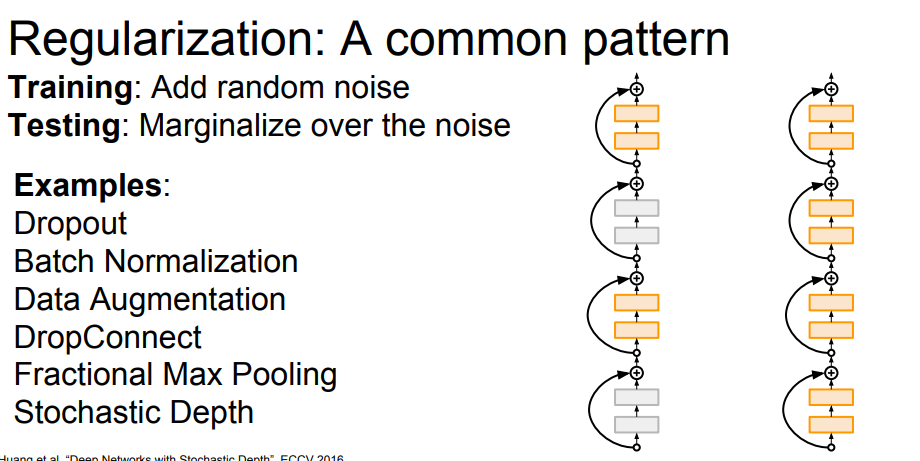

Regularization

📌 Regularization는 앙상블과 다르게 다양한 모델을 사용하는 것이 아닌 하나의 모델을 사용해 위의 문제를 해결할 수 있습니다.

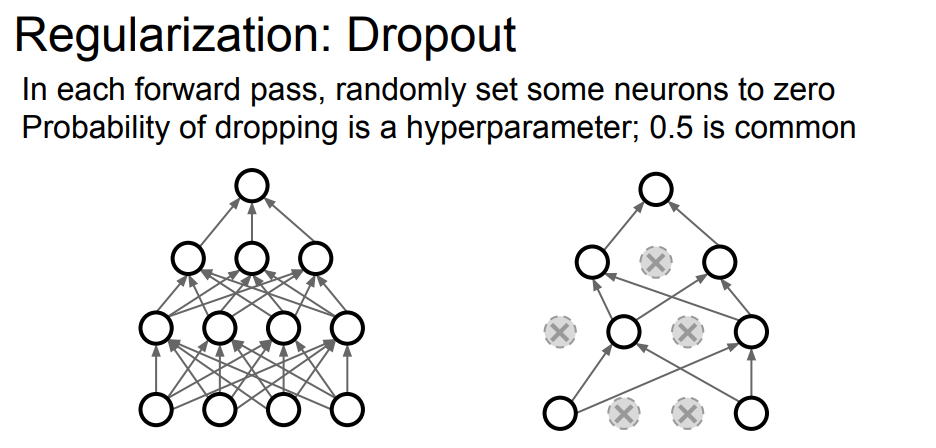

📌 기존의 배웠던 L2 Regularization은 딥러닝에서는 주로 사용하지 않는다고 합니다. Neural network에서 가장 많이 사용되는 regularzation은 바로 dropout이라고 합니다.

📌 Dropout은 forward pass 과정에서 임의로 일부 뉴런을 0으로 만드는 것입니다. 일반적으로 어떤 확률을 사용해 dropout을 진행합니다. 또한 랜덤으로 뉴런을 선택하기에 매 forawrd pass마다 다른 뉴런들이 선택될 것입니다.

📌 한 가지 의문은 왜 Dropout이 좋을까요? 일부의 뉴런 즉 정보를 버리는 것과 다름이 없는 행동입니다. Dropout은 쉽게 네트워크가 어떤 일부의 features에만 의존하지 못하게 해줍니다. 즉 Overfit되는 것을 어느정도 막아준다고 합니다. 또한 모델 앙상블 효과를 얻을 수도 있다고 합니다.

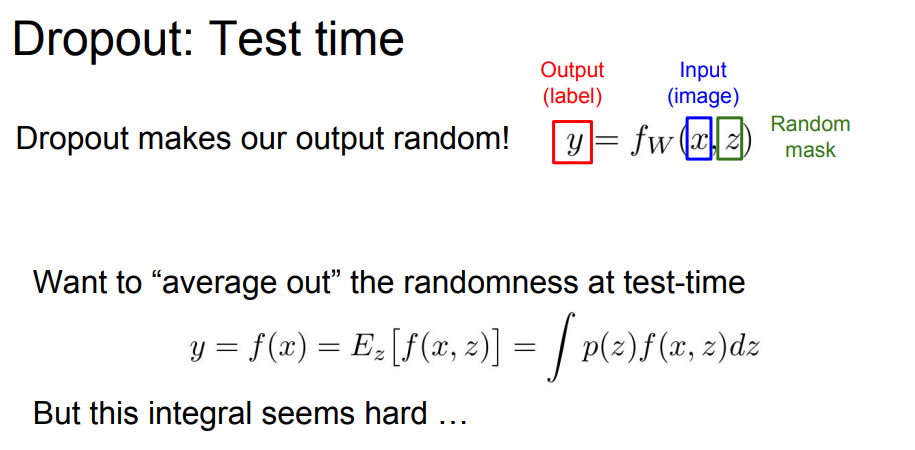

📌 또한 한 가지 생각해봐야 하는 것이 Test시에는 dropout을 어떻게 사용해야할까요? test time에서는 임의의 값을 부여하는 것은 좋지 않다고 합니다. 이를 해결하기 위해 위의 식에서 확인할 수 있듯이 "z"(random mask)을 marginal out을 통해 f(x)에 대한 함수를 구할 수 있습니다. 하지만 실질적으로는 계산이 매우 어렵다고 합니다.

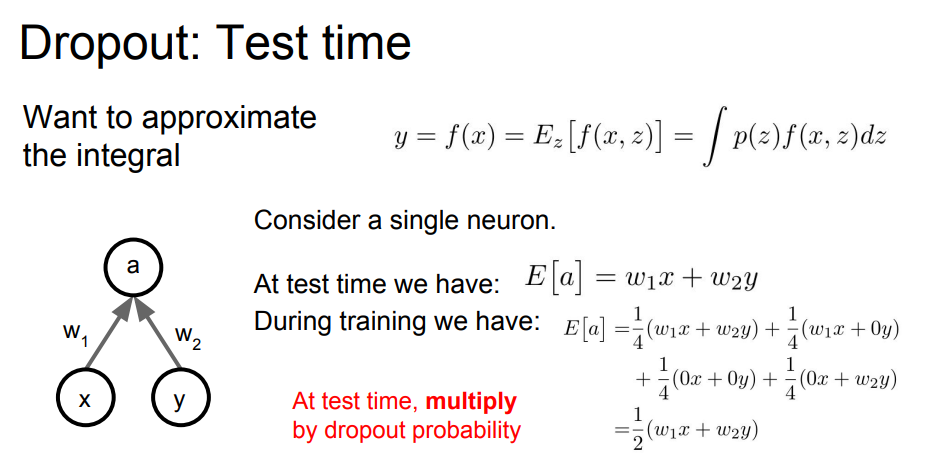

📌 이를 대채하는 방법으로 , dropout을 0.5로 지정하고 하는 training 과정에서 우리는 의 기댓값을 위와 같이 라고 계산할 수 있습니다.(dropout mask에는 4가지 경우의 수가 존재합니다.) 이를 바탕으로 test시 출력 값에 dropout probability를 곱합으로써 이 둘의 기댓값이 같아질 수 있습니다.

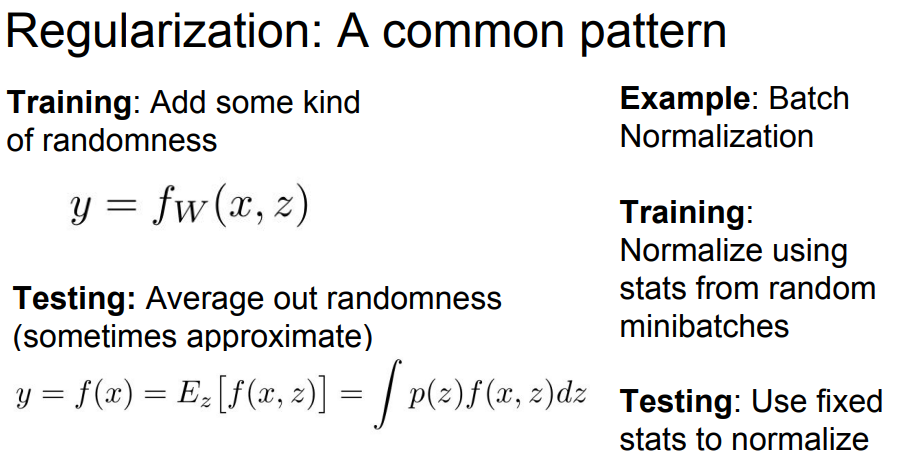

📌 Dropout vs Batch Normalization(유사한 효과라고 합니다.)

Data Augmentation

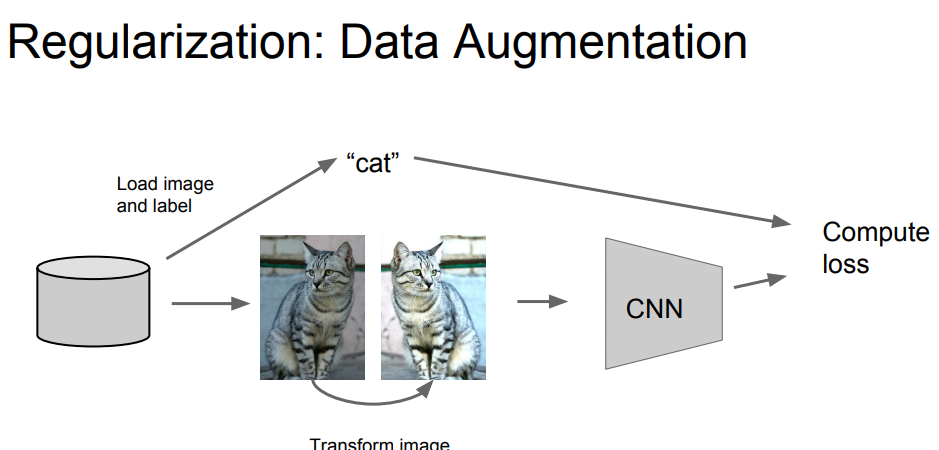

📌 Data Augmentation는 input image를 random하게 transform해 사용하는 것 입니다. transform에는 다양한 방법이 있습니다.

📌 Horizontal Flips, Random crops and scales, Color Jitter( Randomize contrast and brightness), rotation... 등등 다양한 방법들이 존재합니다.

📌 이 외에도 다양한 Regularization 방법들이 존재합니다.

Transfer Learning

📌 모두가 알고있다 싶이 일반적으로 CNN을 학습하기 위해선, 엄청나게 많은 데이터가 필요합니다. 하지만 라벨링된 많은 데이터를 가지고 싶지 않습니다.

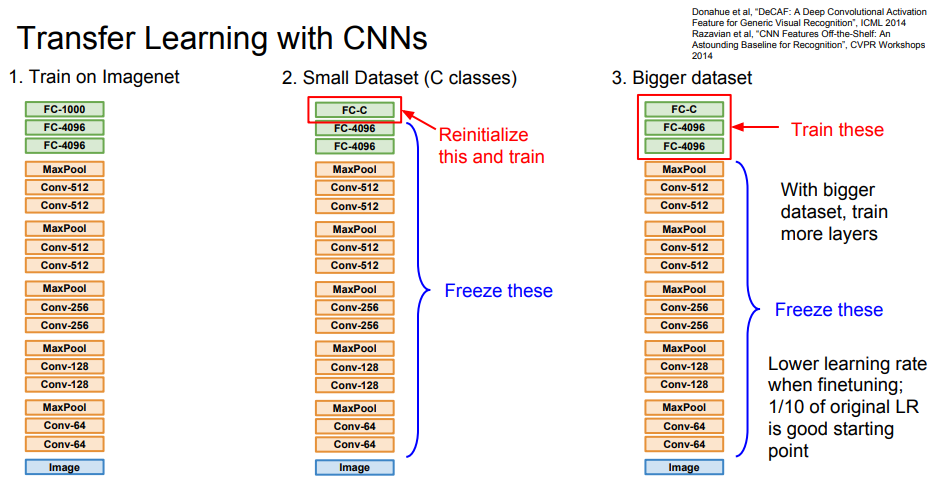

📌 Transfer Learning는 간단합니다. 먼저 ImageNet과 같이 매우 큰 데이터 학습시킵니다. 일반적으로 pre-train이라고 부릅니다. 다름 내가 현재 가지고 있는 작은 데이터로 일부의 layer만 학습시키는 것입니다. 학습시키지 않는 layer은 전부 freeze 합니다. 또한 일반적으로 layer를 학습시킬 때는 원 lr의 1/10의 lr을 사용하는 것을 권장합니다. 또한 위와 같이 추가적으로 학습시키는 것을 fine-tuning 한다고 부릅니다.

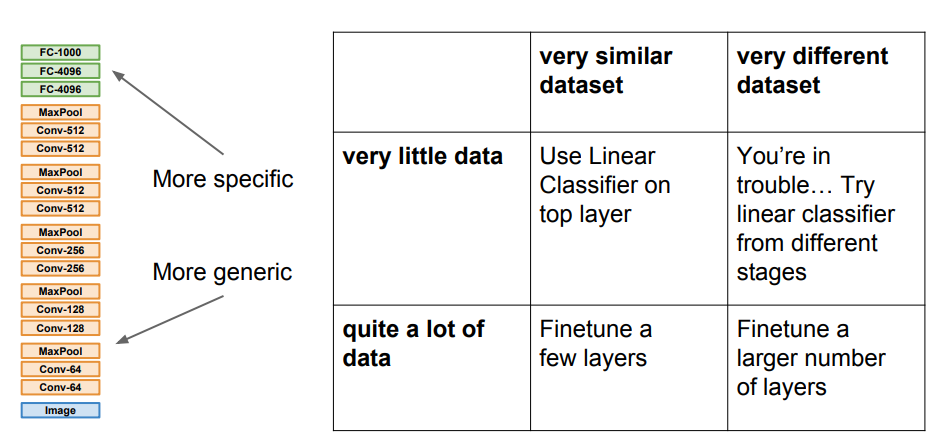

📌 Transfer Learning은 다양한 방법으로 fine-tuning을 진행할 수 있습니다. 위의 표에서는 어떤 상황에서 얼마나 fine-tuning 해야하는지 대략적으로 알려주고 있습니다.

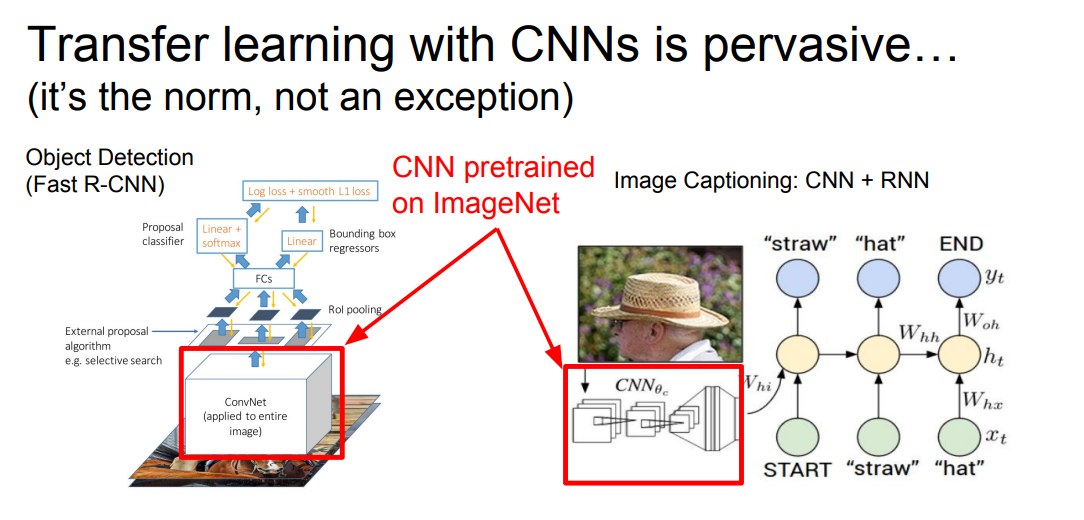

📌 Transfer Learning은 매우 흔하게 사용되고 있습니다. 실제로 다양한 논문들을 확인해보면 거의 모든 논문들에서 사용하는 것을 확인할 수 있습니다. 거의 필수적으로 하는 방법이라고도 말할 수 있을 것입니다.