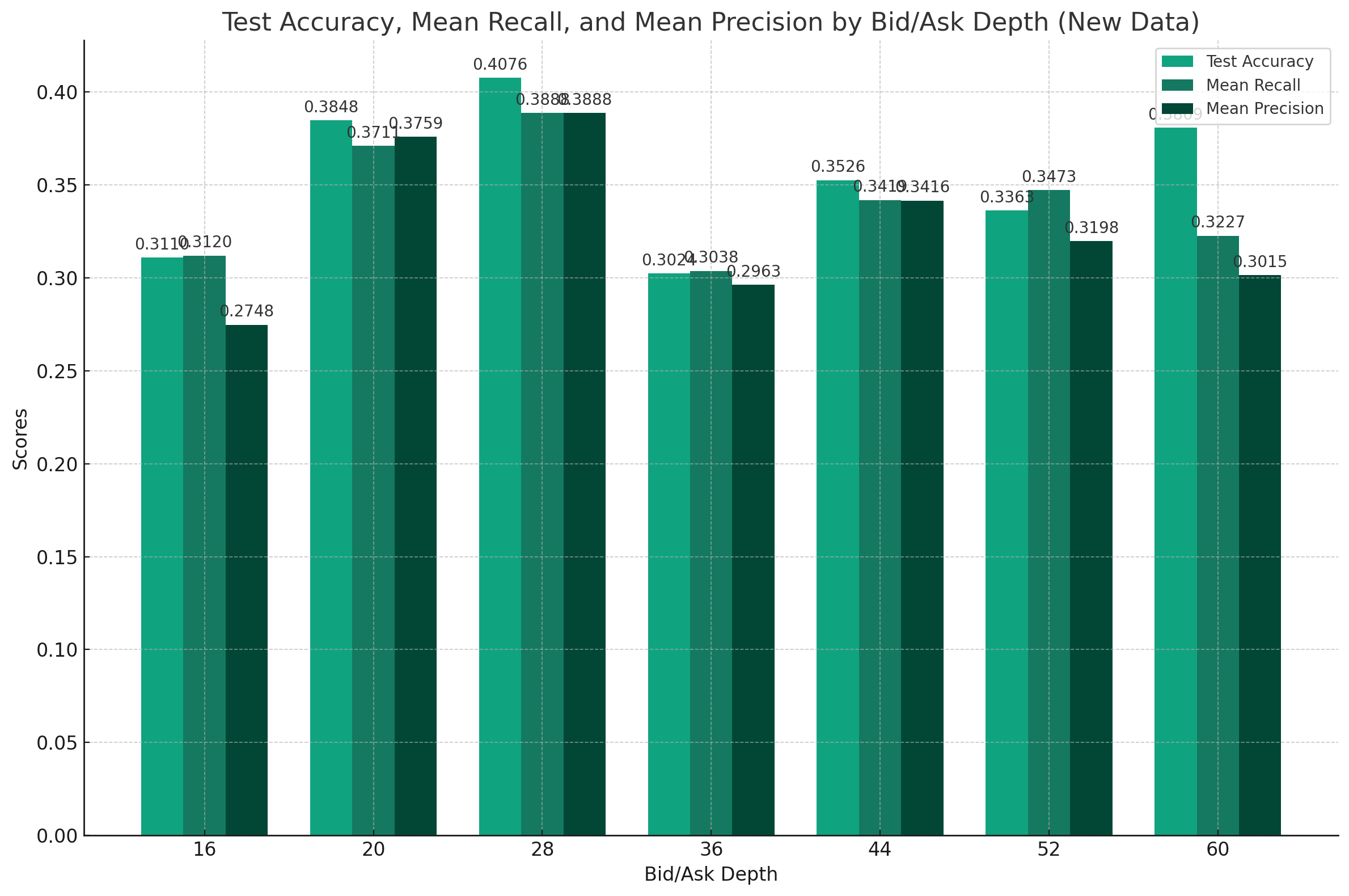

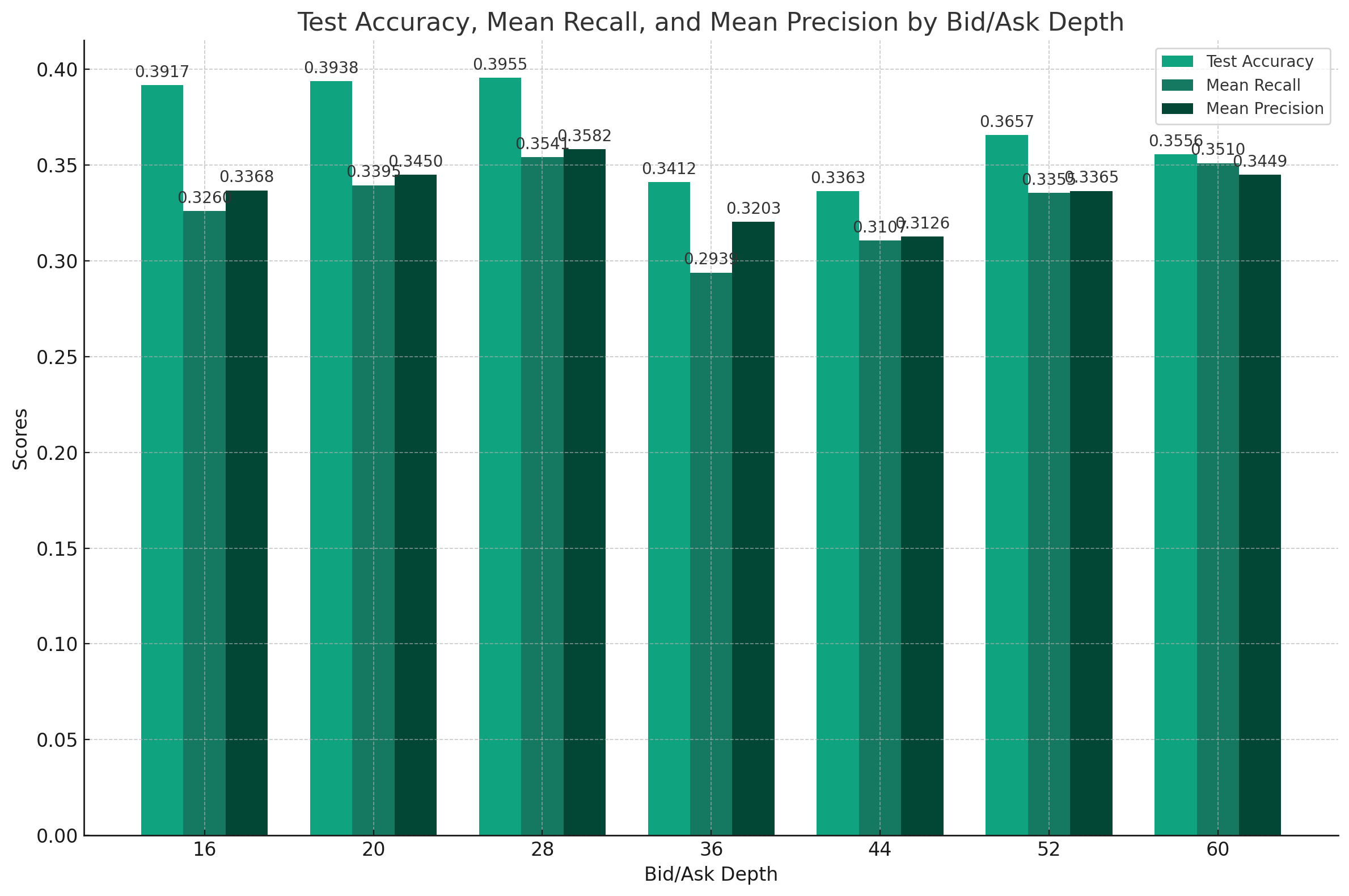

호가 Depth가 깊을수록 더 많은 Noise가 발생하지 않을까라는 의문으로 DeepLOB의 호가 Depth 최적화 실험

- 종속 변수 : 향후 5분간 High - Low Price Size에 대한 Label

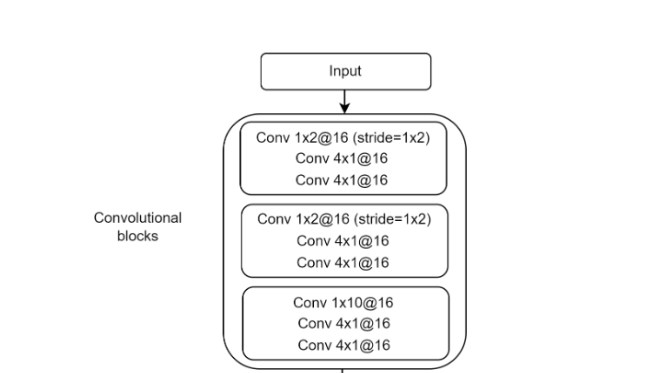

DeepLOB CNN PART

해당 모델 특징 중 하나인 CNN PART에서 호가 깊이에 따른 두 번의 분석이 이루어지는데, 이 과정 후 전체 호가의 깊이가 1/4로 요약되어 줄어들고, 해당 길이만큼의 Filter로 요약해 Inception Module에 넘겨주게 된다.

따라서 모델의 구조를 그대로 유지하고, Order Level Performance를 하기 위해서는 4의 배수 단위로 비교만 가능하다.

Test

- BTC-KRW 20240120 ~ 20240205 Orderbook data

- Group By 5s

Result

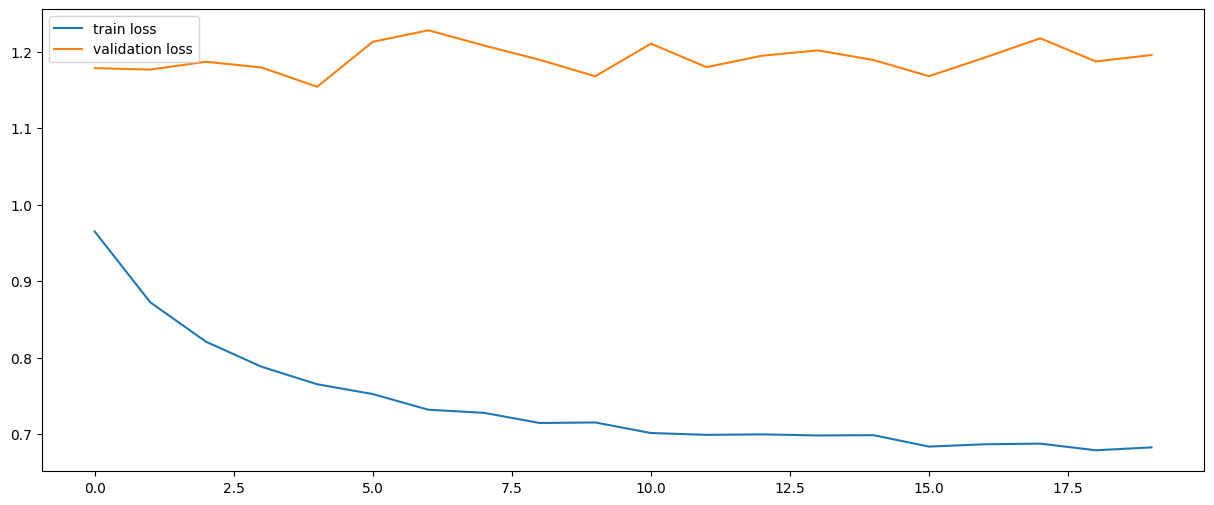

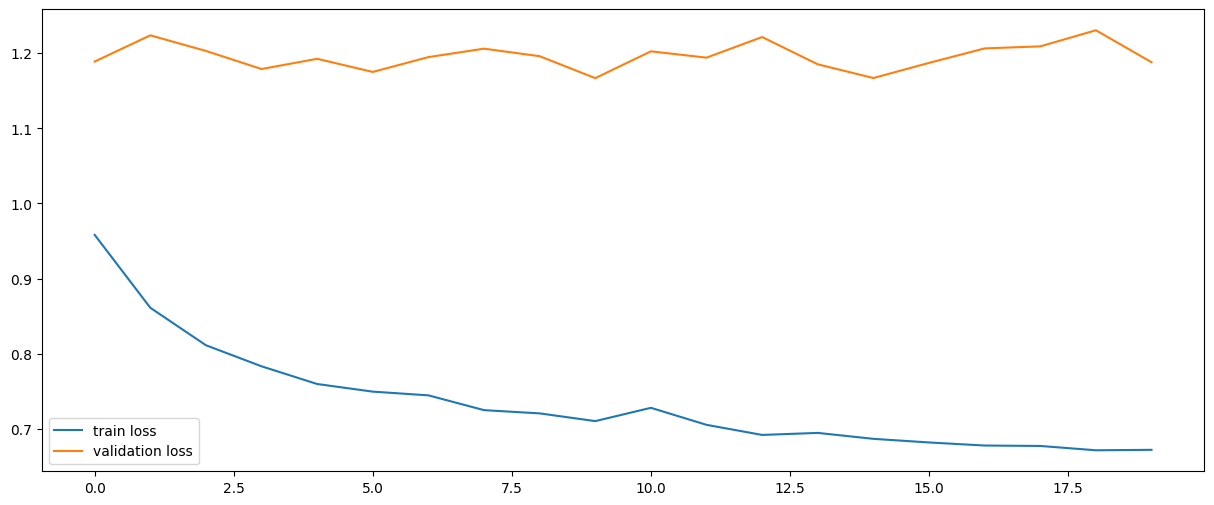

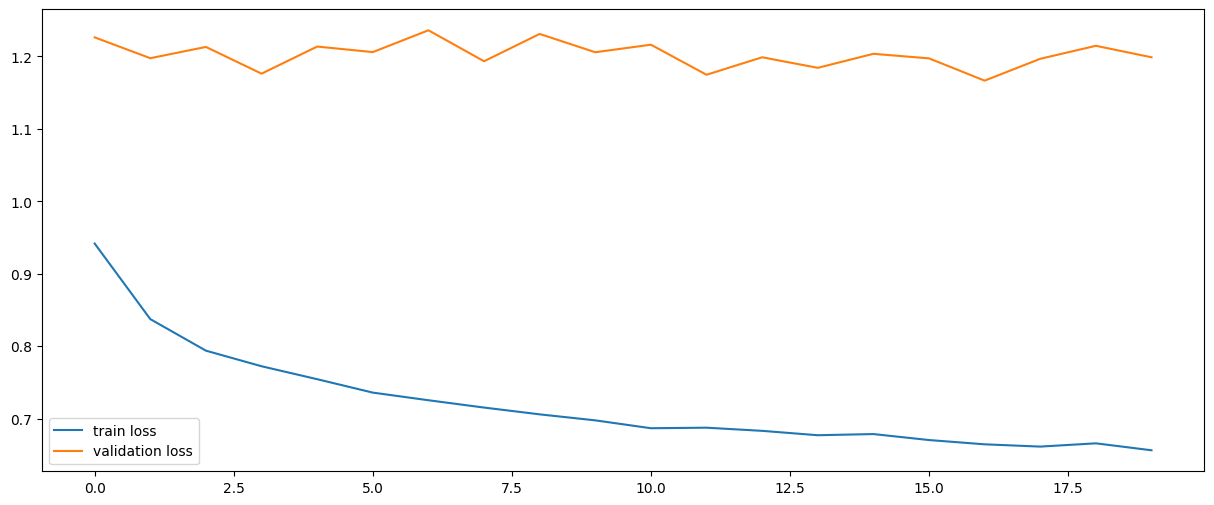

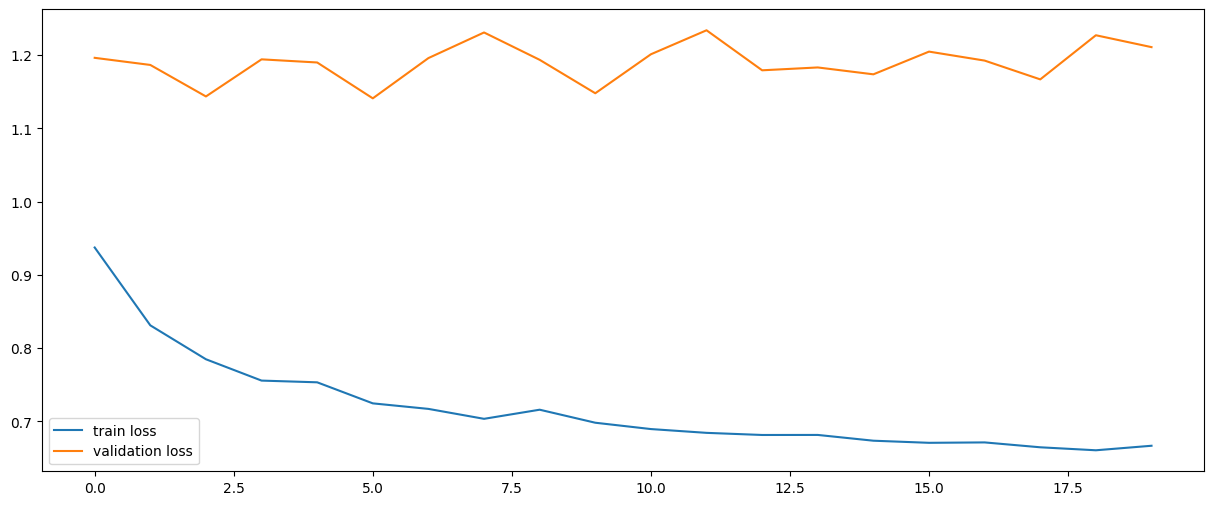

Bid, Ask 각각 4개 호가 (16)

Test Accuracy: 0.3917

Recall per class: [0.09029077 0.8145268 0.07326007]

Precision per class: [0.46538124 0.41537293 0.12958963]

Mean Recall: 0.3260

Mean Precision: 0.3368

Bid, Ask 각각 5개 호가 (20)

Test Accuracy: 0.3938

Recall per class: [0.16221731 0.72650563 0.12983313]

Precision per class: [0.40682303 0.41719715 0.21097884]

Mean Recall: 0.3395

Mean Precision: 0.3450

Bid, Ask 각각 7개 호가 (28)

Test Accuracy: 0.3955

Recall per class: [0.33072607 0.54235606 0.18925519]

Precision per class: [0.4657567 0.43782556 0.17101876]

Mean Recall: 0.3541

Mean Precision: 0.3582

Bid, Ask 각각 9개 호가 (36)

Test Accuracy: 0.3412

Recall per class: [0.08518959 0.68266049 0.11396011]

Precision per class: [0.46132597 0.41790742 0.08179959]

Mean Recall: 0.2939

Mean Precision: 0.3203

Bid, Ask 각각 11개 호가 (44)

Test Accuracy: 0.3363

Recall per class: [0.14402313 0.57263402 0.21530322]

Precision per class: [0.38782051 0.40541174 0.14449604]

Mean Recall: 0.3107

Mean Precision: 0.3126

Bid, Ask 각각 13개 호가 (52)

Test Accuracy: 0.3657

Recall per class: [0.18840333 0.59712111 0.22100122]

Precision per class: [0.41204909 0.41086066 0.18666208]

Mean Recall: 0.3355

Mean Precision: 0.3365

Bid, Ask 각각 15개 호가 (60)

Test Accuracy: 0.3556

Recall per class: [0.08501955 0.62326274 0.34472934]

Precision per class: [0.41288192 0.42627589 0.19543147]

Mean Recall: 0.3510

Mean Precision: 0.3449

Graph

호가 Depth가 깊을수록 더 많은 Noise가 발생하지 않을까라는 가설에 대해

같은 조건으로 호가 깊이만 달리하여 모델 성능을 측정한 결과

4~7개의 호가를 사용한 범위에 대해서 호가 사용개수를 늘리는 것이 성능 향상에 도움이 되는 것을 확인 할 수 있었다.

그 중 7개의 호가를 사용하는 것이 가장 높은 정확도를 보여주었고, 이후 호가 개수가 9개를 사용하는 시점에서 급격하게 성능이 줄어들다 점차 성능 향상을 보여주는 모습을 보여주었다.

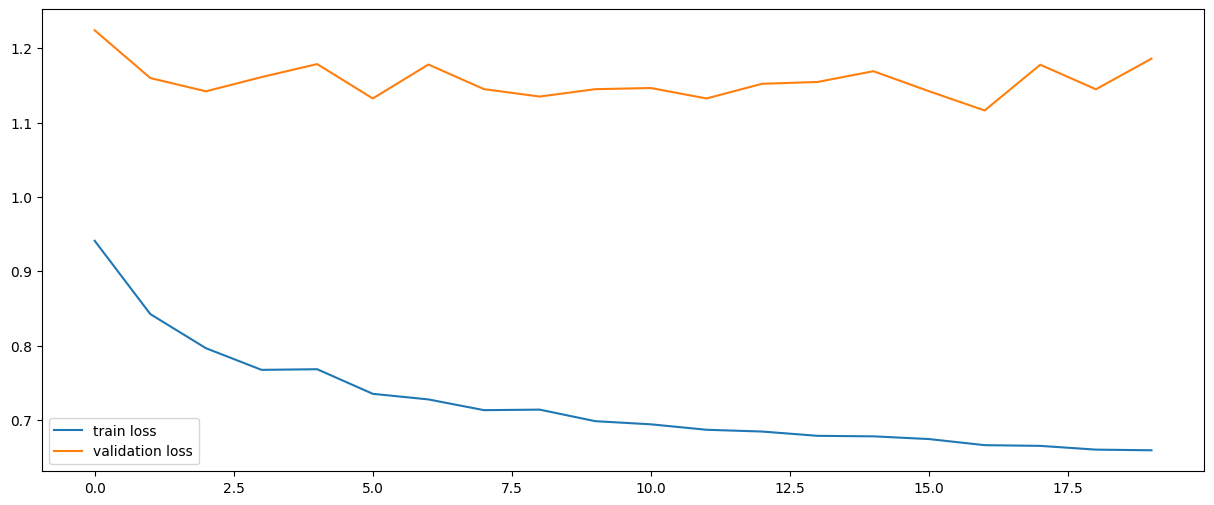

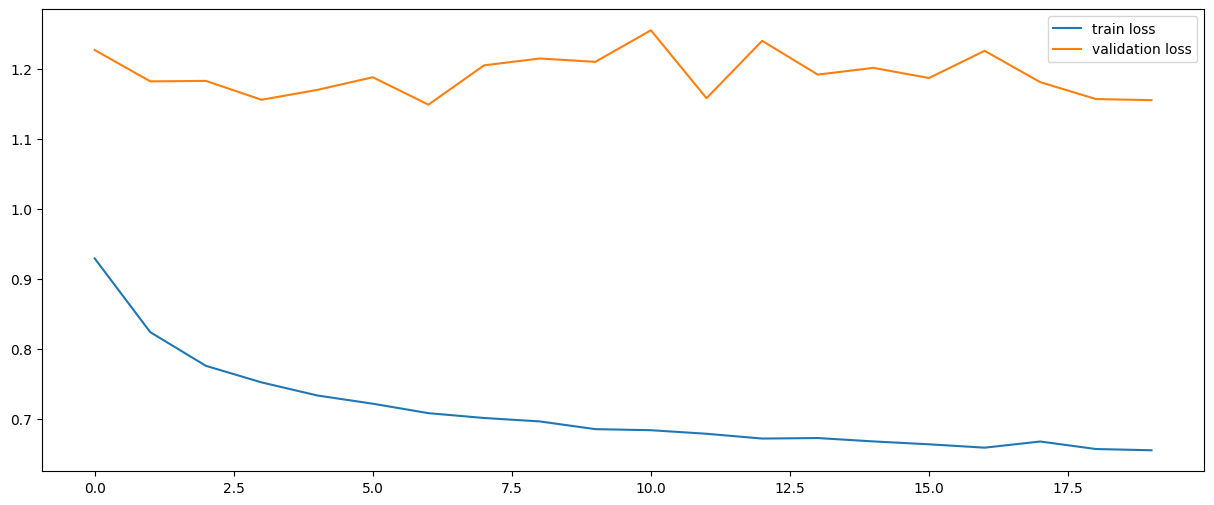

아래는 위와 같은 조건으로 ALGO의 0205 ~ 0213의 데이터를 기반으로 동일하게 진행한 실험 결과로 마찬가지로 28개의 호가를 사용했을 때, 높은 성능을 보여주었다.