Coding

1.Twin Deconvolution 소개 및 코드 구현

U-Net 기반으로 Generation을 하거나, 여타 방법을 활용해서 Non-Autoregressive하게 upsampling을 해야 할 때 Conventional하게 사용하는 방법에는 Transposed Convolution (DeConvolution)이나 Inte

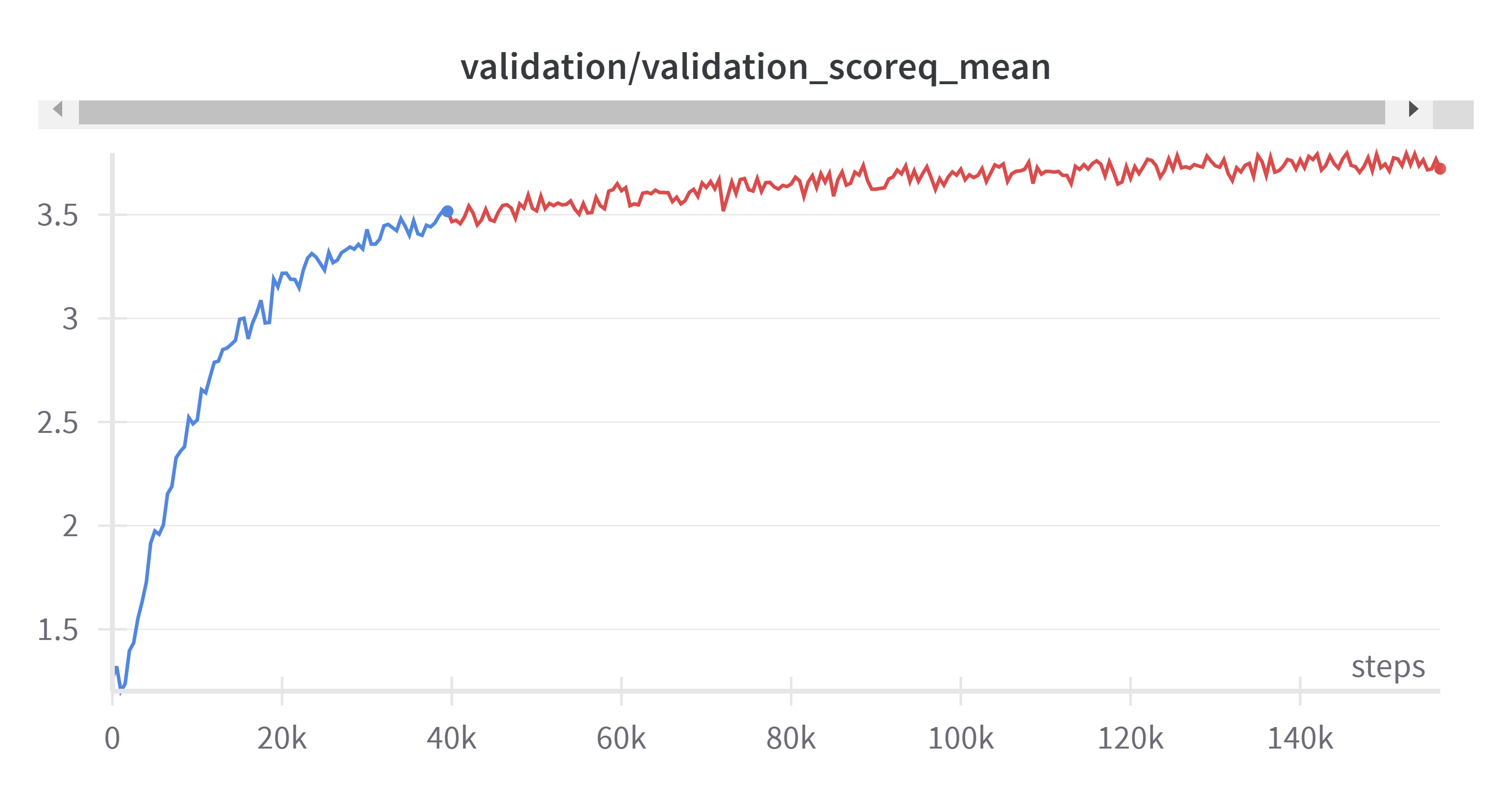

2.Learning Rate Warmup & Decay Pytorch 코드

특히 큰 모델을 학습할 때일수록 Learning rate가 중요해진다. Learning rate를 키웠다가 (Warmup) 다시 줄이는 (Decay) 하는 방식은 모델이 Local minima 에 빠지지 않도록 하는 데 굉장한 도움이 된다. 이에 Pytorch 코드를

3.Cosine Similarity의 Bound 조정하기 + 코드

Introduction Cosine Similarity (코사인 유사도) 는 아주아주 유명한 개념이다. 두 벡터 간 내적을 각 벡터의 거리 (Norm) 의 곱으로 나누어 주면 두 벡터 간 cosine 각도가 나온다는 것이고, 이는 사실 고등학교 삼각함수에도 나오는 내용

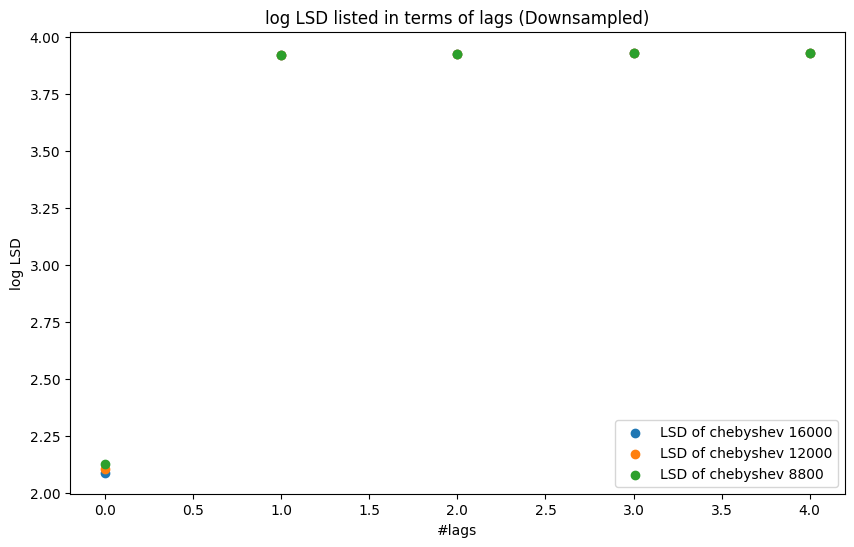

4.Audio Super Resolution 소개 및 음질 저하를 위한 Chebyshev Type 1 Filter 특징 정리(코드 포함)

요새 Audio Super Resolution 이라는 태스크에 관심이 많다. 오디오의 해상도를 높이는 작업인데, 쉽게 말해 전화나 라디오 등 음성이나 과거 음악 등 저음질 음성을 고음질로 전환하는 것이라 말할 수 있다. 비슷한 예시이지만 이미지의 해상도를 높이는 Ima

5.Torch Dataloader에서 drop_last에 대하여

Torch dataloader를 선언할 때 다양한 인자들이 있는데, 모델이나 loss function 등을 제외하고서 실질적인 코딩의 관점에서 이러한 인자들이 생각보다 꽤나 많이 중요하다. 어느정도냐면 단 한가지의 인자를 바꾸기 전과 후가 거의 학습 속도나 stabil