1) RAG (Retrieval-Augmented Generation)

RAG란 무엇인가

RAG는 그대로 해석해보면,

- Retrival(검색) : 외부 저장소에서 정보를 가져와

- Augmented(보강된) : 가져온 정보를 활용해 답변을 보강하며

- Generation (생성): 최종 답변을 생성하는 방식이다.

즉, AI한테 질문을 할 때마다 실시간으로 외부 데이터를 가져와서 참조하는 것이다.

+) RAG는 LLM 기술에서 많이 사용된다. (ex, OpenAI, Amazon Titan, Google Gemini...)

그렇다면 왜 RAG를 사용할까?

LLM의 문제점

LLM은 크게 두 가지의 문제점이 있다.

먼저 기존 LLM은 학습된 정보만을 기반으로 답변하기 때문에, 새로운 정보와 최신 데이터에 대해 질문에 대해 잘 모르기 때문에 엉뚱한 답변을 하는 문제가 있다.

두 번째는 LLM은 답변을 생성할 때 자기가 어디서 배웠는지 기억하지 않고, 그냥 훈련 데이터 속 패턴을 기반으로 가장 그럴듯한 답변을 만들어내는 문제가 있다.

이를 해결하기 위해 등장한게 RAG다!

RAG는 어떤 방식으로 LLM의 문제를 해결할까?

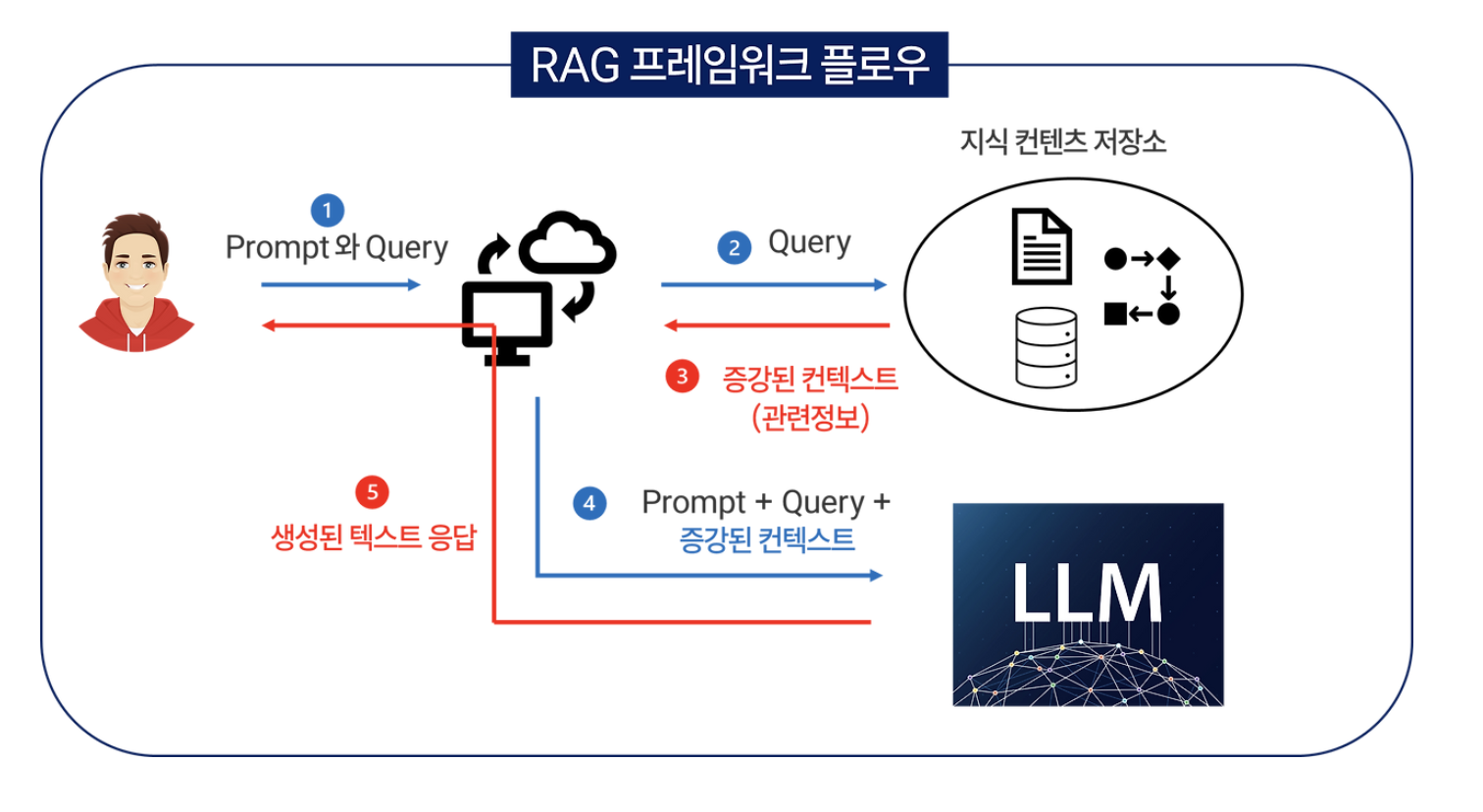

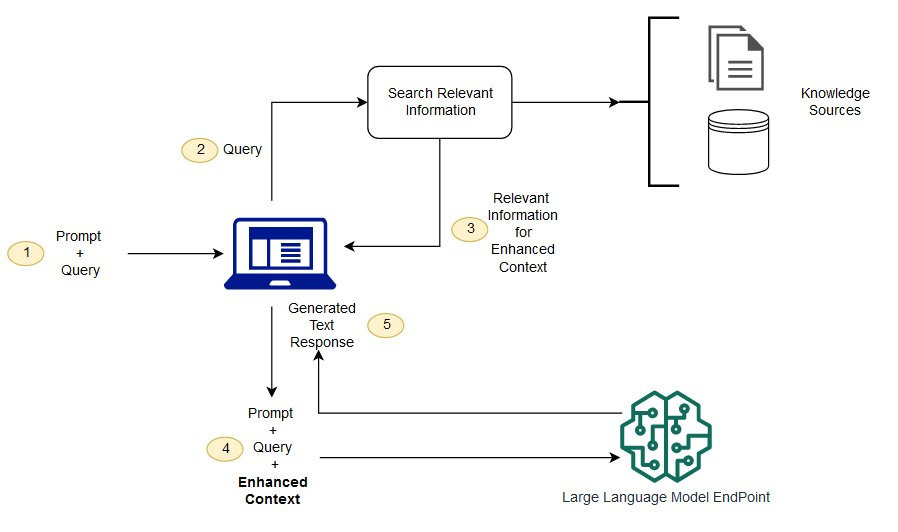

RAG는 아래와 같은 7단계 프로세스를 통해 LLM의 한계를 보완한다.

1) 문서 수집 및 정리

(예: FAQ, 정책 문서, 가이드라인 등 내부 지식 데이터)

2) 문서를 Embedding 처리

→ 텍스트를 숫자 벡터로 변환해 의미 기반 검색이 가능하도록 변환.

3) Vector DB에 저장

(대표적으로 FAISS, Pinecone 같은 벡터 데이터베이스 사용)

4) 사용자가 질문 입력

5) 관련 문서 검색 (Retriever)

→ 질문과 가장 관련 있는 문서를 벡터 기반으로 빠르게 찾음.

6) 검색된 문서 + 사용자 질문을 LLM에 전달

7) LLM이 최신 정보와 문맥을 반영해 답변 생성

이처럼 RAG는 LLM이 최신 정보와 출처를 바탕으로

더 정확하고 신뢰할 수 있는 답변을 생성할 수 있도록 지원하는 핵심 기술이다.

MCP(Model Context Protocol) 등장

앞서 살펴본 RAG는 LLM이 최신 정보에 접근할 수 있도록 외부 데이터를 검색하여 답변을 보강하는 방식이었는데 아무래도 RAG는 주로 '읽기'에 초점을 맞추고 있어, LLM이 외부 도구를 '실행'하거나 '조작'하는 데에는 한계가 있다!

이러한 한계를 극복하기 위해 등장한 것이 바로 MCP(Model Context Protocol)이다.

MCP란 무엇인가?

MCP는 대형 언어 모델(LLM)이 외부 데이터 소스나 도구와 상호작용할 수 있도록 표준화된 인터페이스를 제공하는 개방형 프로토콜이다. 이를 통해 LLM은 단순히 정보를 검색하는 것을 넘어, 실제로 외부 시스템과 상호작용하며 작업을 수행할 수 있다!

MCP 예시

간다한 예시로 GPT가 슬랙과 연결되어 메세지를 받아온다고 가정해보자.

그러면 다음과 같이 슬랙에서 GPT로 메세지가 전달된다.

그런데 이걸 보고 AI 스스로 "회의 공지구나", "요약 대상이다" 이러한 의미를 파악하기는 어렵다.

AI 입장에서는 단순히 넘어온 문자열 데이터일뿐, 내재된 의미를 알 수 없기 때문이다.

그래서 필요한게 MCP이다!

MCP는 이렇게 넘어오는 데이터에 대해 AI가 무슨 상황인지 이해할 수 있도록 문맥화하여 설명해주는 규칙이다.

도구와 형식에 따라 다를 수 있지만 이런식으로 문맥까지 구조화해서 전달 받으면 AI는,

"슬랙에서 온 회의 메세지구나", "요약이 필요하구나", "노션에 작성하면 되겠네" 등 사람이 스스로 설명하는 것이 아닌 AI가 스스로 문맥을 이해하여 적절한 행동을 할 수 있다!

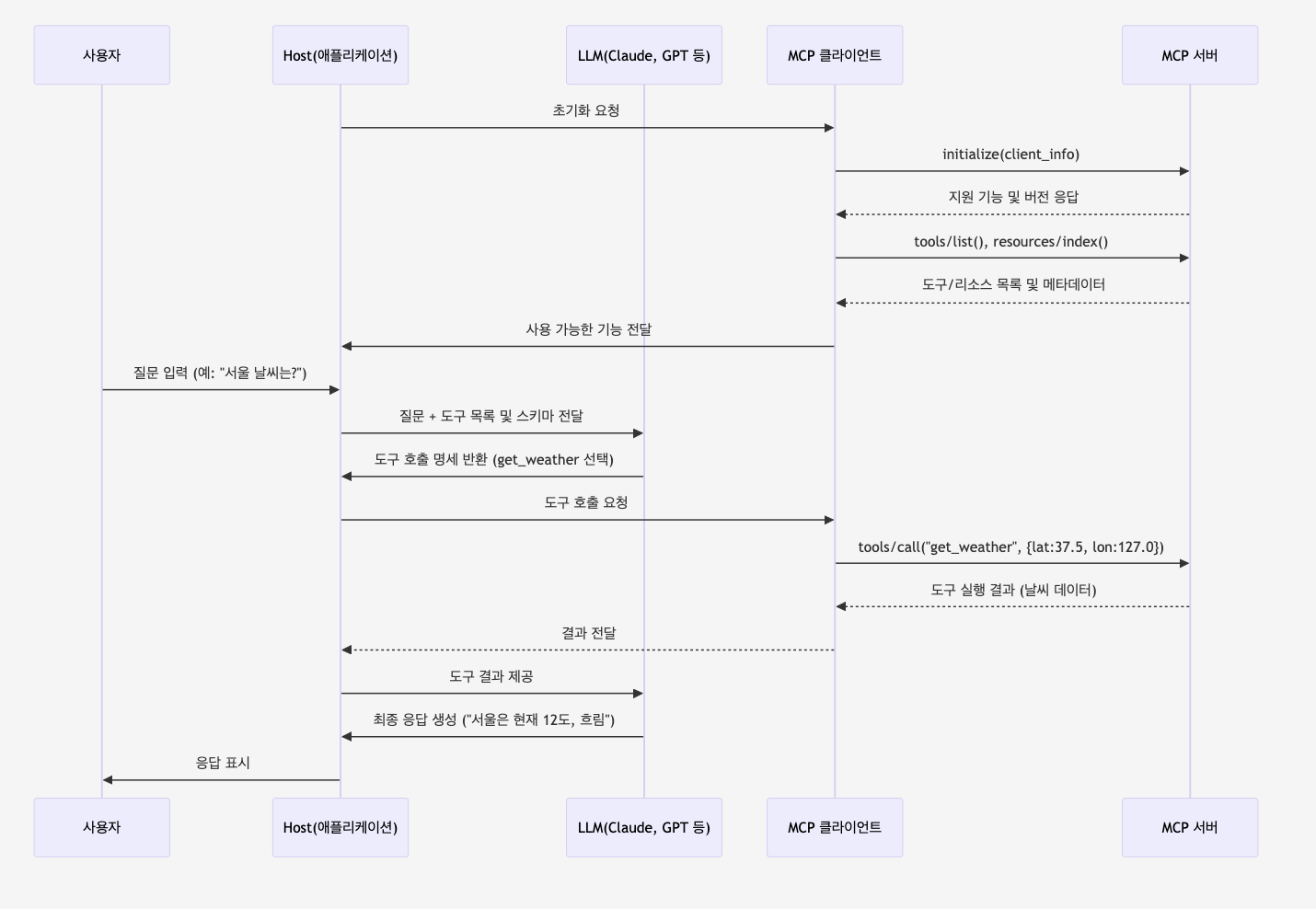

MCP 구동 방식

단계별로 하나씩 매우 간단하게 살펴보자면,

1. 초기화 & 연결

호스트 앱이 MCP 서버와 연결해 사용할 수 있는 도구 목록과 기능을 확인하고,

2. 도구 목록 등록

서버가 제공하는 도구(예: 날씨 조회, 캘린더 등)를 클라이언트가 받아서 LLM에 제공한다.

3. 사용자 질문 입력

사용자가 요청을 입력하면 LLM이 질문을 받고,

4. LLM이 도구 선택

LLM이 질문에 맞는 도구를 선택하고, 호출할 인자(tool_calls)를 생성한다.

5. 도구 실행 요청

호스트가 MCP 서버에 도구 실행 요청을 보내고, 서버가 실제 외부 API 호출하며,

6. 도구 실행 결과 반환

서버가 실행 결과를 JSON 형태로 클라이언트에 전달한다.

7. LLM이 최종 답변 생성

LLM이 도구 결과를 활용해 사용자에게 최종 응답 생성하여 제공한다.

즉, MCP는 LLM이 외부 도구를 직접 실행하지 않고,

‘어떤 도구를 쓸지’ 결정만 하면 나머지는 표준 프로토콜을 통해 자동으로 처리되는 구조이다!

왜 MCP가 요즘 주목받고 있을까?

1) AI 에이전트가 뜨면서 MCP도 같이 주목받고 있다!

최근 AutoGPT, Devin과 같은 AI 에이전트가 등장하면서

AI가 스스로 검색, 일정 관리, 보고서 작성 등 여러가지 작업을 하는 시대가 열렸다.

AI가 이런 역할을 제대로 하려면,

단순히 답변만 하는 게 아니라 여러 도구들과 연결돼서

상황을 이해하고 실행까지 할 수 있어야 한다.

바로 그 연결을 표준화한 게 MCP다!

그래서 AI 에이전트가 주목받으면서 MCP도 자연스럽게 주목받고 있다.

2) 에이전트보다 MCP가 더 빨리 실무에 적용되고 있다

기존 AI 에이전트는 아직 속도가 느리고, 안정성이 부족해서 당장 현업에 쓰기에는 아직까지는 무리다.

반면 MCP는 이미 다양한 서비스에 적용되고 있다.

Claude, Zapier, GitHub, Microsoft 같은 곳에서

자동화와 연동 작업에 적극적으로 활용되고 있다.

즉, MCP는 지금 바로 실무에 쓸 수 있는 현실적인 기술이라는 점에서 주목받고 있다!

결론

왜 RAG와 MCP를 알아야 할까?

시간이 지나면서 확실히 느끼는게 AI는 더 끊임없이 발전하고 있다.

챗지피티 초반처럼 단순 질문하고 답해주는 AI가 아닌 더 똑똑하고 더 실용적인 모습을 현재 LLM에서 볼 수 있다.

내가 살펴본 RAG와 MCP는 결국 LLM을 실무에서 바로 쓸 수 있다는 것이 크나큰 장점인 것 같다.

1년 뒤에도 어떤일이 벌어질지 모르는 AI시대 속 AI를 활용한 자동화된 시대에 적응하기 위해서는 RAG와 MCP는 반드시 알고 넘어가야 할 것 같다고 느꼈다!

실무에서도 많이 적용되고 있다고 하니 나도 하나씩 도움을 받아볼 예정이다 😎

출처

RAG

10분만에 RAG 이해하기

RAG (Retrieval-Augmented Generation)란? 쉽게 정리

검색 증강 생성(RAG)이란 무엇인가요?

MCP

MCP(Model Context Protocol)란?

모델 컨텍스트 프로토콜(MCP)이 뭐야?

MCP(Model Context Protocol)란? 반복 업무 줄여주는 AI 자동화의 핵심 (당장 활용 가능한 툴 소개)