1. Problem Statement

Environment Definition

[Outline]

Rocket Recycling

1) 로켓이 목표 지점에서 바로 선 채 머무르도록 하는 Hovering

2) 로켓이 지정된 착륙 지점에서 안전하게 착륙하도록 하는 Landing

[Environment Settings]

- Earth gravity

- Air resistance proportional to the velocity

State Space

{ }

- Rocket Position(Initially 500m above the ground) & Speed(initially -50m/s)

- Rocket Angle(initially 90deg) & Angle Velocity

- Time

- Nozzle Angle [-20deg, +20deg]

Action Space

{ }

- Thrust acceleration: { 0.2g, 1.0g, 2.0g } (discrete)

- Angular velocity of nozzle: {0, -30deg/s, +30deg/s} (discrete)

Reward

HOVERING

Rocket Position이 predefined target point와 가까울수록,

Rocket Angle이 0에 가까울수록 높은 reward

LANDING

착지 시 Rocket Position이 predefined landing point와 가까울수록,

Rocket Speed가 safe threshold보다 작고,

Rocket Angle이 0에 가까울수록 높은 reward

2. Backgrounds

Continuous한 state vector를 입력받아 value function 혹은 action에 대한 vector를 출력하는 network라는 개념은 동일. 출력값과 loss function의 정의만 상이.

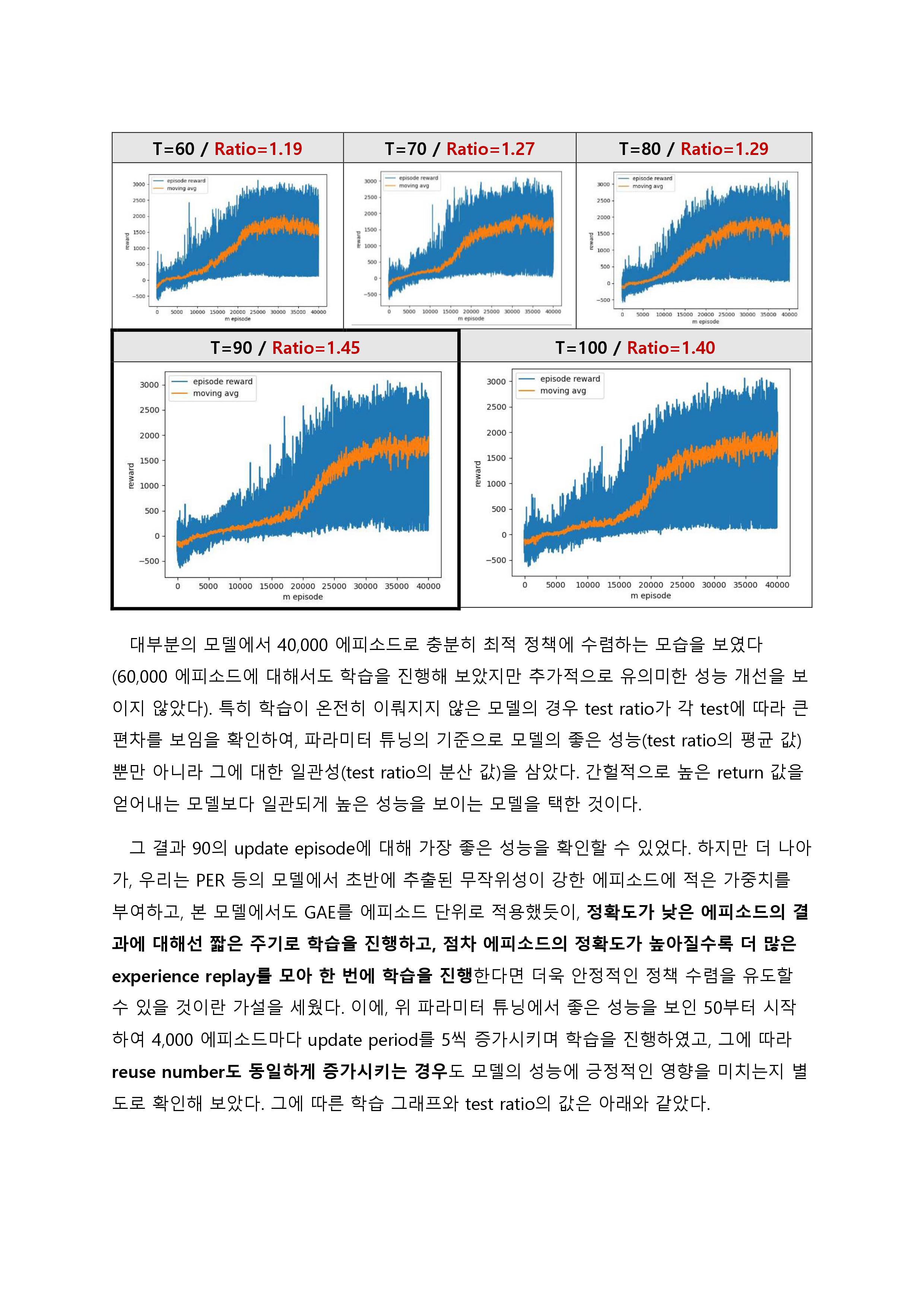

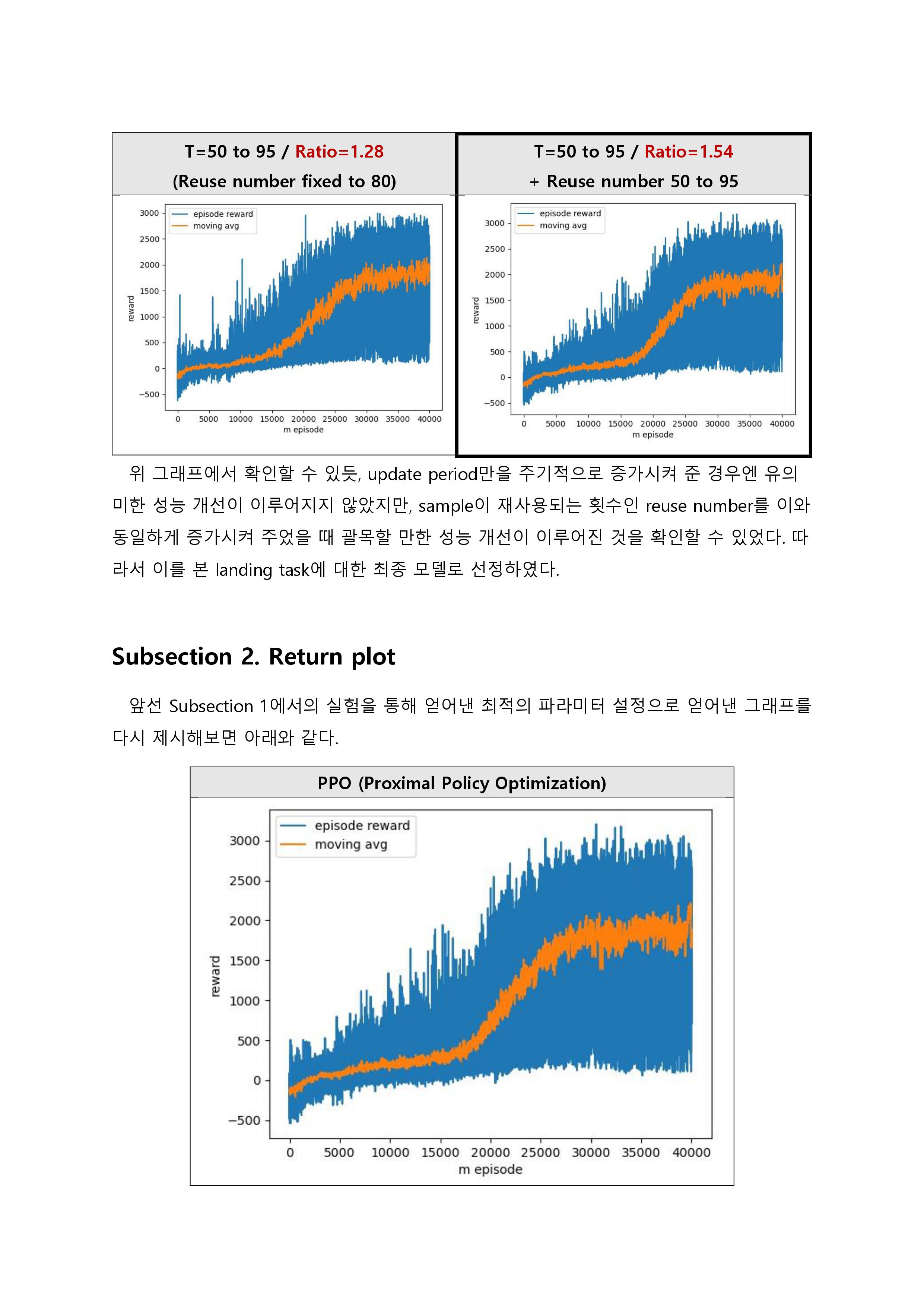

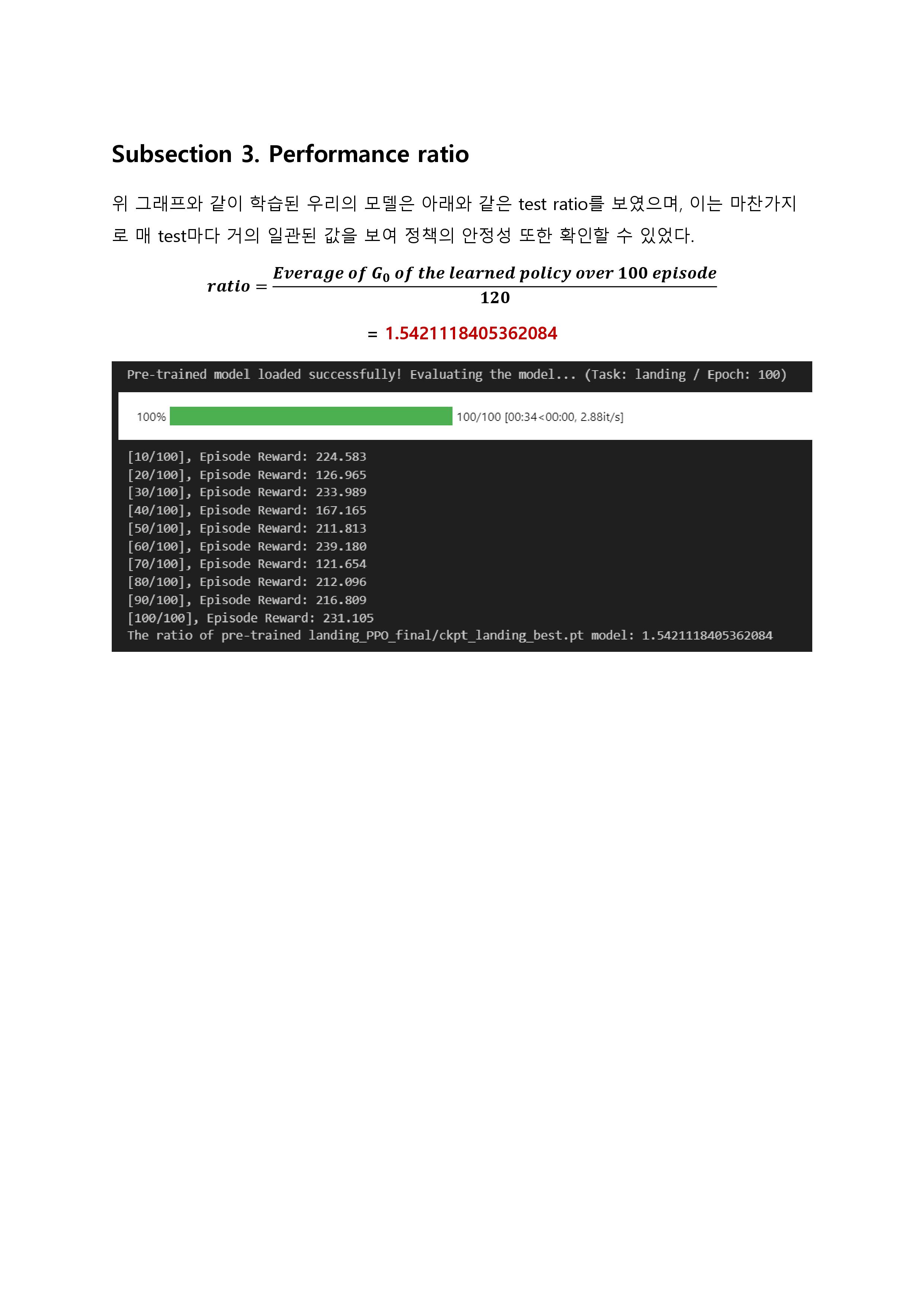

3. Experimental Results