📄 BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension 논문 리뷰

Paper Review

1. Introduction

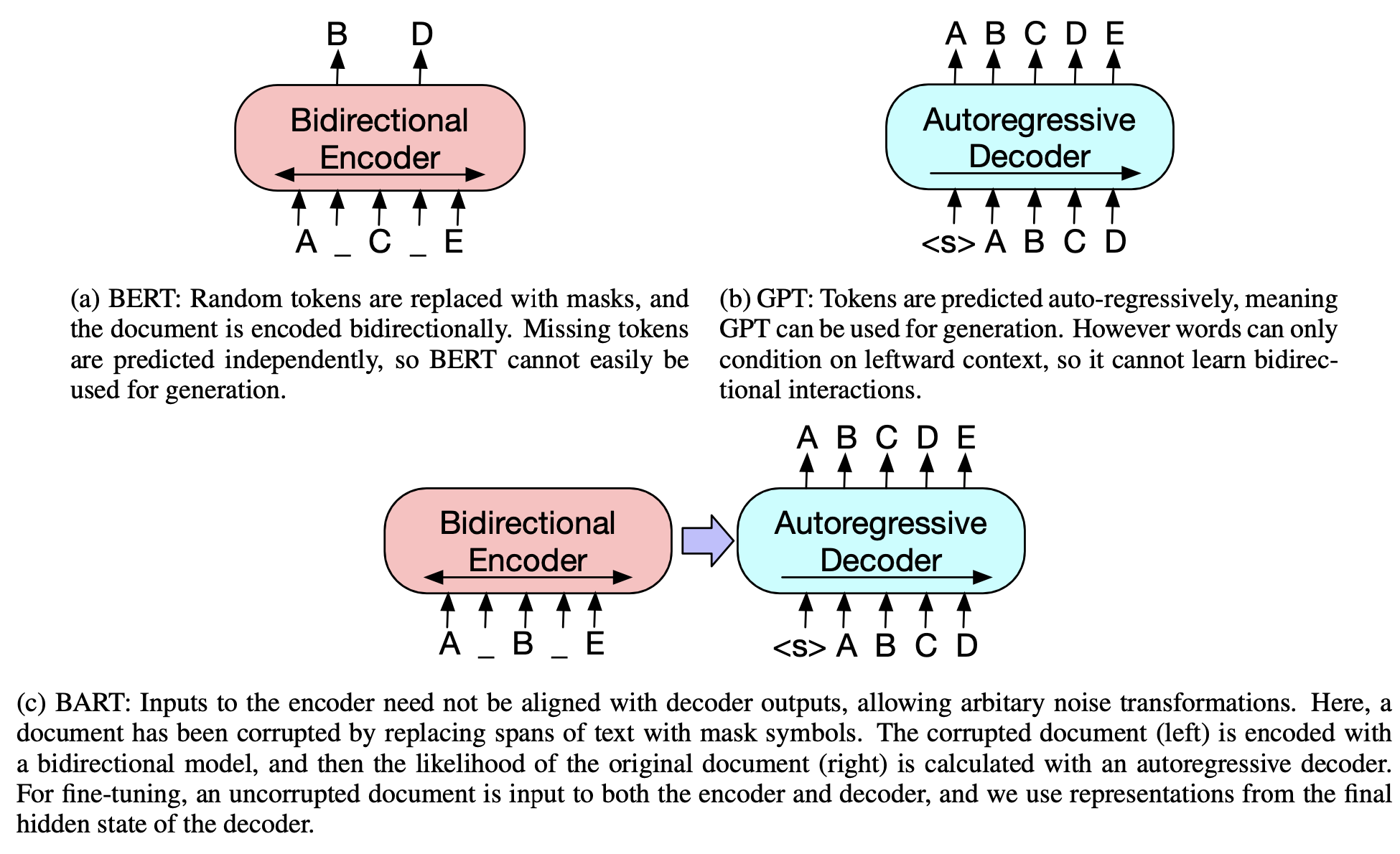

BERT 이후에 나온 연구에서는 MASK token의 분포를 바꾸어 훈련하는 방법을 다루었는데 이런 방법론은 span prediction, generation 등에서 잘동작하기 위한 방법으로 모든 태스크에 적용할 수는 없다. encoder만 존재하는 BERT는 일반적인 업무를 처리할 수 없고, decoder만 존재하는 GPT는 양방향 문맥정보를 반영하지 못하기 때문이다.

BART는 Bidirectional과 Auto-Regressive Transformer를 합친 모델이다. BART는 seq2seq 모델로 만들어진 denosing autoencoder이며 두가지의 Pretraining단계가 있다.

- 텍스트를 임의의 noising 함수를 이용해 오염시킨다.

- seq2seq 모델이 원래의 텍스트를 복원하기위해 학습된다.

BART는

- transformer 기반의 신경망 기계 번역 구조로, BERT와 GPT를 일반화했다고 볼 수 있다.

- noising의 유연성을 가지고 있다. 어떤 임의의 변형이라도 기존 텍스트에 바로 적용될 수 있다.

▶︎ 최고의 성능을 보이는 noising은 기존 문장의 순서를 랜덤하게 섞고 임의의 길이의 텍스트를 하나의 단일 MASK token으로 교체하는 것이다.- 텍스트 생성에 fine-tuning을 하였을 때 특히 효율적이지만, conprehension 태스크에서도 잘 동작한다.

2. Model

BART는 seq2seq 모델로 구현되고, noising을 통해 손상된 텍스트를 BERT가 encoding하고 GPT decoder가 이를 받는다. Pretraing을 위해 기존 문서의 negative log likelihood를 최적화 한다.

2.1 Architecture

BART의 decoder는 GPT에서 사용하는 ReLU함수 대신 GeLU로 변경하였고, 파라미터 초기화는 로 했다.

base(encoder와 decoder layer의 개수가 각각 6개)와 large(encoder와 decoder layer의 개수가 각각 12개) 크기의 모델이 존재한다.

BERT와의 차이점

- decoder의 각 layer는 encoder의 최종 hidden layer와 cross-attention을 수행한다.

▶︎ key, value로 같은 값을 사용하지만 query는 다른 값을 사용하는 어텐션 연산(즉, query ≠ key = value)을 cross attention 연산이라 한다.- encoder가 바로 masking된 단어를 유추하지 않기 때문에 feed-forward 네트워크를 사용하지 않는다.

2.2 Pretraining BART

BART는 문서를 오염시킨 뒤 resontruction loss(decoder의 output - 기존문서의 cross-entropy loss)를 최적화 시키는 것으로 훈련을 진행한다.

BART는 다양한 corruption을 적용할 수 있다. 아래는 실험에 사용된 다양한 noising 기법들이다.

- Token Masking

랜덤으로 토큰들이 샘플링되어 MASK 토큰으로 치환된다. 모델은 이 MASK 토큰이 어떤 토큰이었는지 맞추는 방향으로 학습된다. - Token Deletion

랜덤한 토큰들이 제거된다. 위의 방식과는 다르게 모델은 input의 어느 위치에서 이 토큰이 사라졌는지에 대한 정보도 함께 학습해야한다. - Text Infilling

포아송 분포()를 따르는 길이의 text span을 생성해서 이를 하나의 MASK 토큰으로 마스킹한다. 모델은 MASK토큰에 해당되는 단어들을 맞춰야한다. 여러 토큰이 하나의 mask 토큰으로 바뀔 수 있고, 길이가 0인 경우에는 mask 토큰만 추가될 수도 있다. - Sentence Permutation

하나의 문서가 마침표를 기준으로(문장별로) 분리가 되며, 이 문장들은 랜덤하게 순서가 섞인다. 모델은 이 문장들을 원래의 순서대로 배열하는 방향으로 학습이 된다. - Document Rotation

하나의 토큰이 랜덤으로 동일한 확률로 선택되고, 문서가 섞여 해당 토큰이 문서의 시작점이 된다. 모델은 문서의 시작점을 찾는 방향으로 학습된다.

3. Fine-tuning BART

BART가 생성해내는 representation은 여러 다운스트림 어플리케이션에서 다양한 방법으로 적용될 수 있다.

3.1 Sequence Classification Tasks

Sequence Classification Task는 어떠한 시퀀스를 분류하는 태스크이다.

encoder와 decoder는 같은 input값을 사용한다. decoder의 마지막 hidden state가 새로운 nulti-class linear classifier로 전달된다.

마지막 토큰까지 입력이 완료되면 전체 입력에 대한 decoder의 attention을 계산할 수 있다.

3.2 Token Classification Tasks

전체 문서를 encoder와 decoder에 입력한다. decoder의 top hidden state를 각 단어에 대한 representation으로 사용하여 이를 토큰 분류에 사용한다.

3.3 Sequence Generation Tasks

기존 BERT는 encoder만을 가지고 있기 때문에 generation 태스크를 수행하지 못하는데 BART는 autoregressive decoder를 가지고 있기 때문에 abstractive question answering과 summarization과 같은 sequence generation 태스크에 바로 적용 할 수 있다.

3.4 Machine Translation

영어를 다른 언어로 번역하는 것이 Machine Translation 태스크이다. BART 모델 전체를 Machine Translation을 위한 pre-trained decoder로 사용하고 bitext로부터 학습된 새로운 encoder를 추가해 인코더-디코더를 fine-tuning 한다.

▶︎ 새로 추가된 encoder는 end-to-end로 학습되며, 이 encoder를 학습시킴으로써 외국어 단어들을 영어로 mapping해 BART가 외국어를 denoise할 수 있도록한다.

새로운 encoder를 학습시키는 방법

두가지의 단계가 있는데 두 단계보무 cross-entropy loss를 최적화하는 방향으로 진행된다.

- 첫번째 단계 : BART의 대부분의 파라미터를 freeze하고 랜덤으로 초기화된 source encoder, BART encoder의 첫번째 레이어 self-attention input projection matrix만 학습시킨다.

- 두번째 단계 : 모든 파라미터를 학습시킨다.

8. Conclusions

BART는 손상된 문서를 기존 문서로 매핑하는 것으로 학습하는 사전학습 방법론을 이용한 모델이다. BART는 분류 task에서 RoBERTa와 비슷한 성능을 내면서도 generation task에서도 state-of-the-art 성능을 보였다. 향후 연구로 pre-training을 위한 document를 손상시키는 방법을 더 조사해야할 필요가 있다.