Target

- https://arxiv.org/abs/2405.04517

- 현대 LLM 기법 적용

- LSTM의 제약조건을 해결하여 효율적으로 확장한다는 목표

키워드

- LSTM

- xLSTM

배경

LSTM은 RNN 계열의 일종으로, Gate 형식으로 정보 제어- Forget Gate를 통해 이전 Cell의 정보의 망각 조절

- Input gate를 통해 신규 정보의 보존 조절

- Output gate를 통해 최종 출력

- 장기 의존성 및 기울기 소실 문제 완화하는데 도움

- LSTM은 예측분야에서 큰 성공을 거두었지만, 한계점 존재

- 과거 학습정보에 대한 저장 여부

- 병렬화 부족

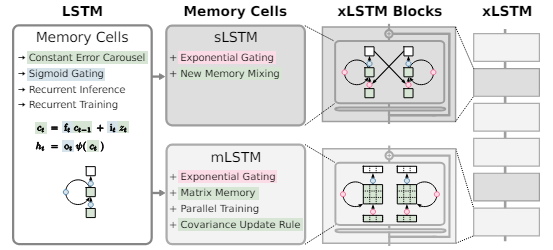

- 한계점 보완 및 성능 향상을 위해 sLSTM, mLSTM Block 제시

모델 아키텍쳐

-

기존 LSTM 대비 변경된 점

- 장기적인 기억 종속성 향상 및 병렬성 향상

- LSTM의 정보 조절을 위해 지수 게이트 기법 도입

- Input Gate 및 Forget Gate에서

Exponential activation functions추가하여 보다 매끄럽게 정보의 흐름이 이루어질 수 있도록 함 - 해당 과정 간 안정화를 위해 Normalized state 추가

- Input Gate 및 Forget Gate에서

- Memory 관련 기법

- 새로운 메모리 구조 제시 : sLSTM, mLSTM

- sLSTM : Memory Mixing 추가

- Scalar 형태로 데이터 활용

- Input된 Dimension을 Head 형태로 대입

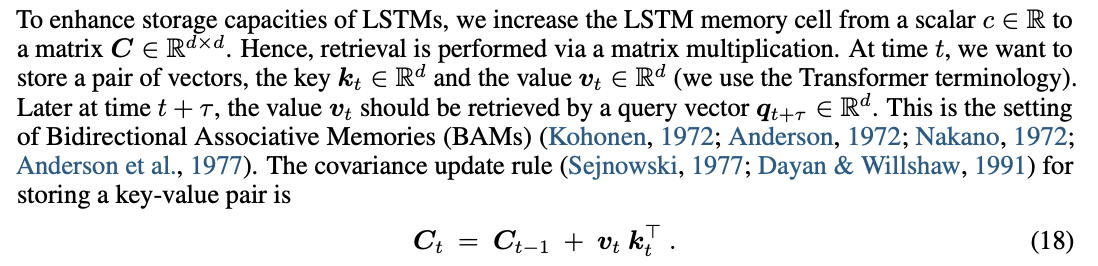

- mLSTM : 공분산 Update 기능

- Matrix 형태로 데이터 활용

- mLSTM의 경우, 병렬화를 통한 연산 효율성을 위해 Memory Mixing을 적용하지 않음

-

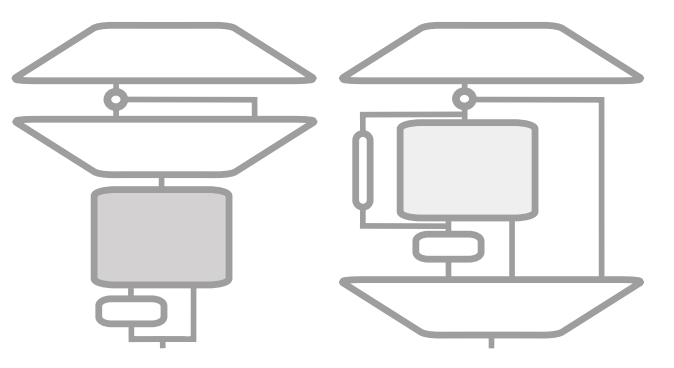

Block 아키텍쳐

- sLSTM (왼쪽)

- Transformer 와 유사한 형태의

Post up-projection - Input이 (선택적인 컨볼루젼) sLSTM으로 이어짐

- 이후 Gated MLP 단계로 이동

- Transformer 와 유사한 형태의

- mLSTM (오른쪽)

- SSM과 유사한 형태의

Pre up-projection - 2개의 MLP 형태로 감싸짐

- 학습 가능한 Skip Connection

- Convolution

- 구성요소별로 작동하는 (componentwise) Output Gate

결론

- SSM과 유사한 형태의

- 이러한 형태로 구성된 xLSTM은 Transformer와 어느정도 유사한 성능을 보이거나, 보다 나은 성능을 종종 보여주곤 함

- 이는 예측분야, LLM 분야 외 다양한 방면으로 확장될 수 있는 모습을 보여줌.

추가내용

- 오늘 날짜 기준, 2일 전 Vision 분야에 적용된 xLSTM (ViL)에 관련된 정보 또한 공개됨.

- https://arxiv.org/html/2406.04303v1