⌚ 활동 시간 : 2023년 2월 11일 오후 8시 ~ 오후 11시

✨ 목표 : 모두의 딥러닝 14장 내용을 읽고 관련 내용을 정리하였다.

🎈 14장

와인 종류 예측 모델을 작성하는 예를 사용한다.

Binary Cross Entropy Loss

이진 분류는 데이터를 두 가지 정답 중 하나로 분류하는 것이다. 이러한 이진 분류에 Binary Cross Entropy Loss함수를 사용할 수 있다. y hat은 0~1 사이의 시그모이드 함수 출력값이며, y는 실제 값이다. 단일 항목에 대한 이진 분류는 아래의 식을 사용한다.

여러가지 항목에 대해 이진 분류 해야한다면 그것은 멀티 이진 분류이다. 여러개의 노드에 대해 시그모이드 함수를 적용하여 이진 분류 작업을 수행한다.

이진 분류가 아닌 다중 분류라면 이는 softmax함수를 사용한다. softmax 함수는 분류되는 클래스가 n개일 때, n차원 벡터를 입력받아서 입력이 각 클래스에 속할 확률을 출력한다.

Adam Optimizer

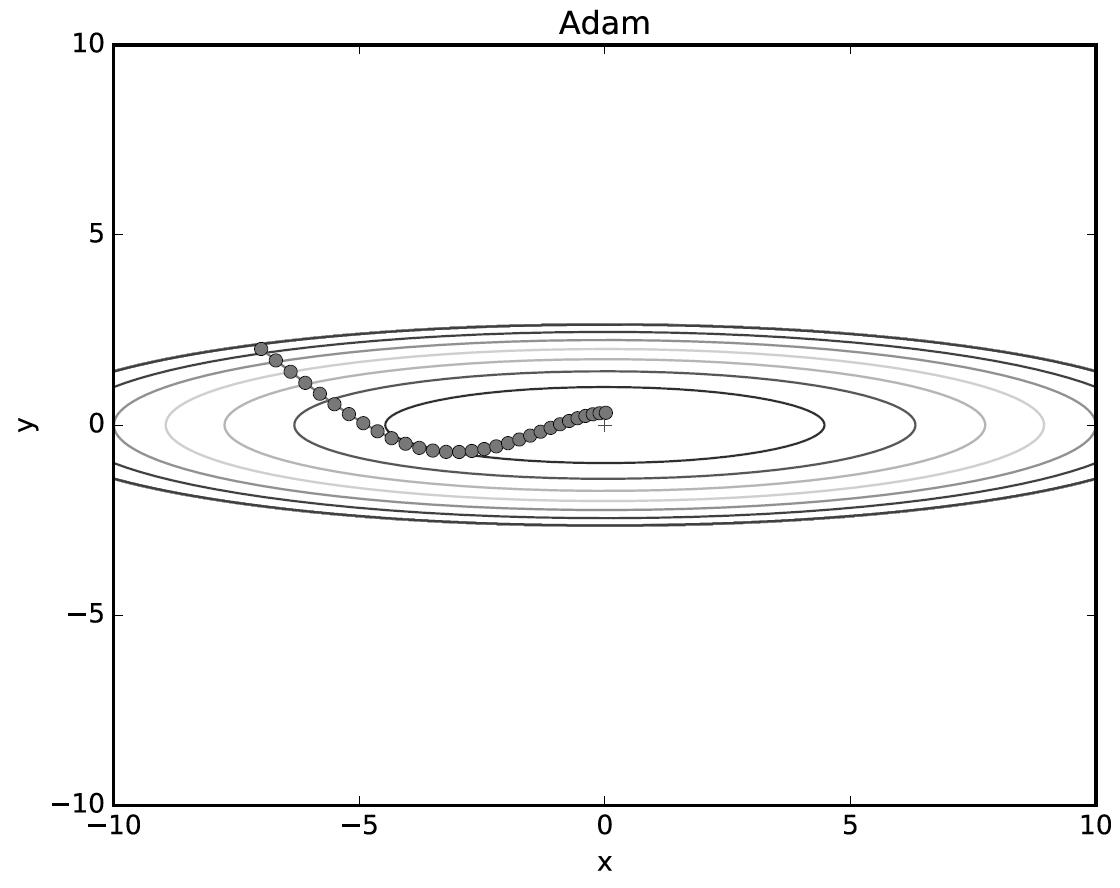

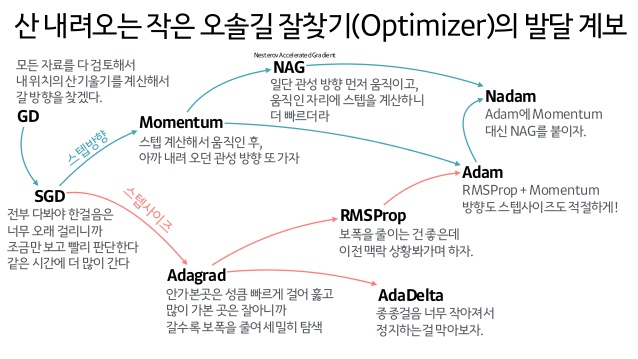

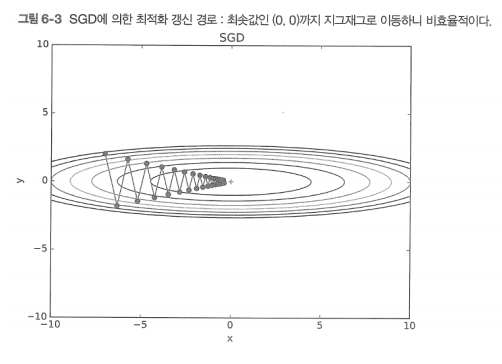

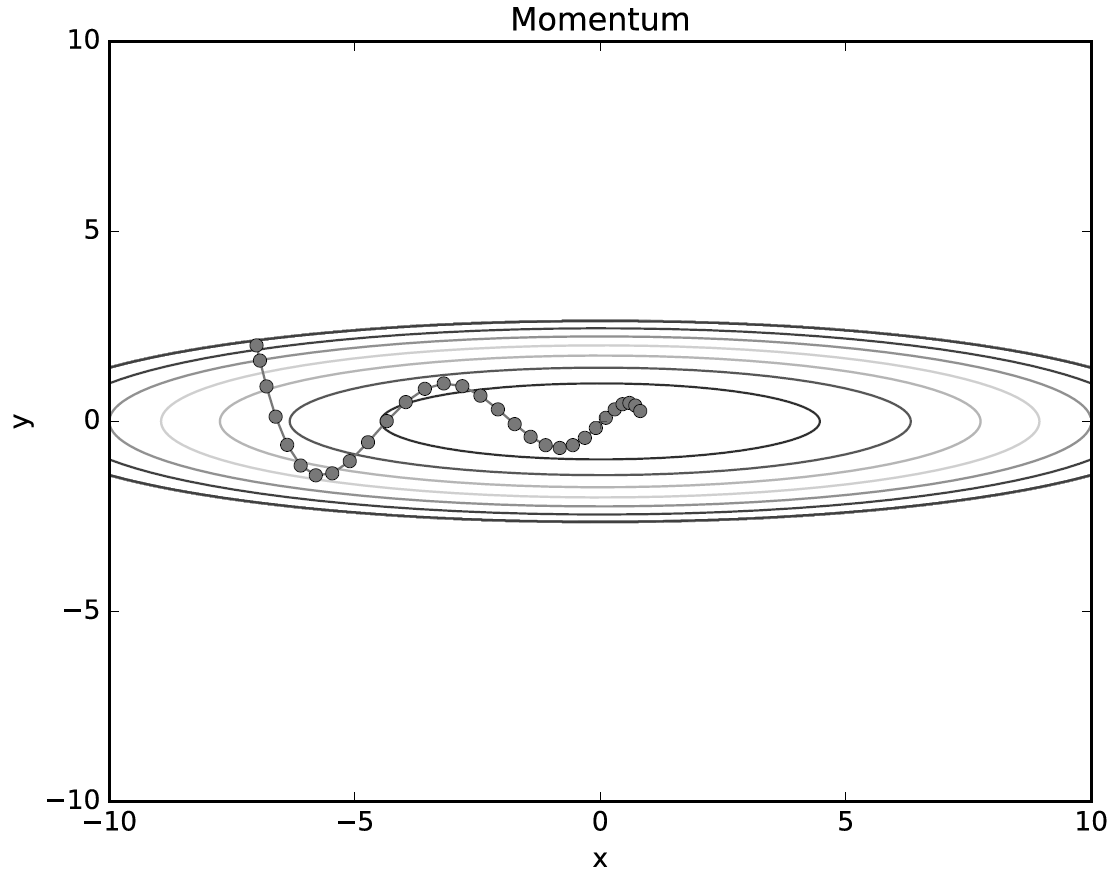

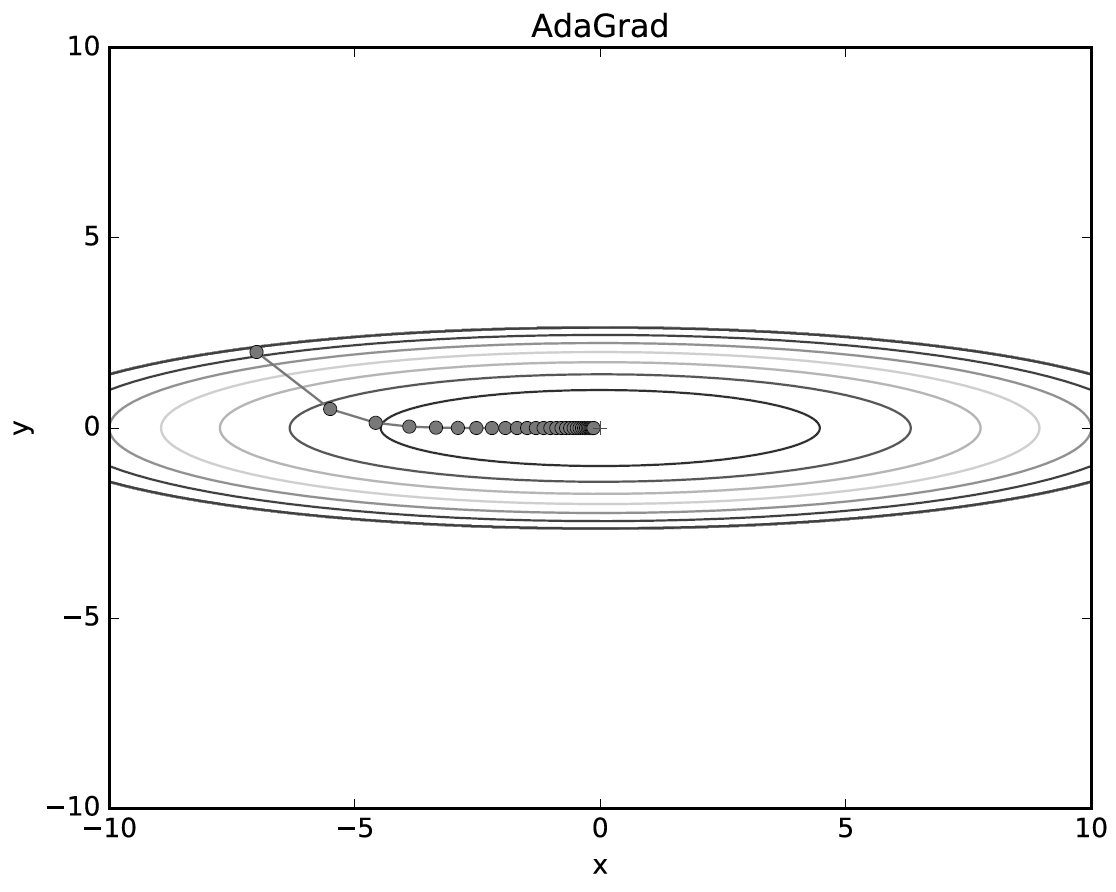

최적화 함수는 딥러닝에서 network가 빠르고 정확하게 학습하는 것을 목표로 한다. 대표적인 Optimizer기법들이 최적값을 찾아가는 특성은 아래 그래프로 표현된다.

SGD(Stochastic Gradient Descent)는 최적의 매개변수 값을 찾기 위해 매개변수를 미분한 기울기를 구한다.

Momentum은 빠른 학습 속도와 SGD의 local minima문제(기울기 값이 0이 되는 지점에서 update 되지 않기 때문에 global이 아닌 local의 최저점에 수렴함)를 해결하고자 SGD에 관성의 개념을 적용한 방법이다. 이전 이동거리와 관성계수에 따라 매개변수를 update하도록 수식이 적용되었다.

NAG(Nesterov Accelrated Gradient)는 Momentum으로 이동된 지점의 기울기를 활용하여 parameter를 update하기 때문에 Momentum이 갖는 문제(최적의 parameter를 관성에 의해 지나친다는 점)를 극복할 수 있다.

Adaptive Gradient(AdaGrad)는 parameter에 개별 기준을 적용한다. 지속적으로 변화하던 매개변수 말고 한 번도 변하지 않은 매개변수에 더 큰 변화를 주는 것이다. 학습이 진행됨에 따라 변화 폭이 줄어서 움직이지 않을 수 있다는 단점이 있다. Learning rate를 서서히 낮추는 방법이다.

RMSProp는 Adagrad의 문제를 개선하기 위해 계산식에 지수이동평균을 적용하여 학습의 최소 step을 유지할 수 있게 한다. 핵심은 최근 time step에서의 기울기는 많이 반영하고 과거의 time step의 기울기는 조금만 반영하는 것이다. 변수마다 적절한 학습률을 적용할 수 있다는 장점과 AdaGrad보다 학습을 오래 할 수 있다는 장점이 있다.

Adaptive Moment Estimation(Adam)은 RMSProp와 Momentum 기법을 합친 최적화 함수이다. 이는 기울기 값과 기울기의 제곱 값의 지수 이동 평균을 사용하여 step 변화량을 조절한다.