modern CNN & Computer Vision Applications

Modern CNN

- AlexNet

- VGGNet

- GoogleNet

- ResNet

- DenseNet

AlexNet

- ReLU activation

→ Overcome the vanishing gradient problem - 2 GPUs

- local response normalization, Overlapping pooling

- Data augmentation

- Dropout

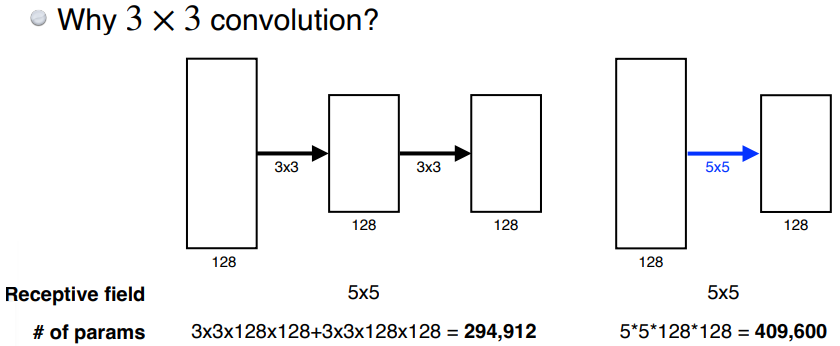

VGG

- 3x3 convolution filter

- Dropout

GoogleNet

- network-in-network(NiN)

- Inception blocks

: 1x1 convolution을 앞에 끼워넣어서 channel 방향으로 dimension을 줄여 parameter 수 감소

ResNet

- identity map(skip connection)

- Bottleneck architecture

DenseNet

- Dense block : Each layer concatenates the feature maps of all preceding layers - convolution layer을 기하 급수적으로 키움

- Transition block (dimension reduction)

: BatchNorm → 1x1 convolution → 2x2 AvgPooling

Computer Vision Applications

Semantic Segmentation : 이미지를 픽셀 별 분류

Fully convolutional network

: 뒤의 dense layer을 없애는 방법

input size 상관 없이 돌아가지만 subsampling에 의해 output dimensions가 감소

→ coarse ouput을 늘려야함, Deconvolution(conv transpose) 이용

Detection

이미지를 per pixel이 아닌 bounding box로 분류

- R-CNN : 2000개의 region을 뽑아서 같은 크기로 wrap → compute CNN features → region 분류

- SPPNet : R-CNN과 다르게 CNN을 한번

- Fast R-CNN

- ROI pooling

- Faster R-CNN : region proposal network + Fast R-CNN

- anchor boxes : bounding box 사이즈를 미리 정함

- YOLO

출처 - 부스트캠프 AI tech 교육자료

[부스트캠프 AI Tech] Week 3 - Day 2