회귀 모델

예측 대상이 연속형 수치 데이터인 경우

MSE, RMSE, MAE, MAPE...

분류 모델

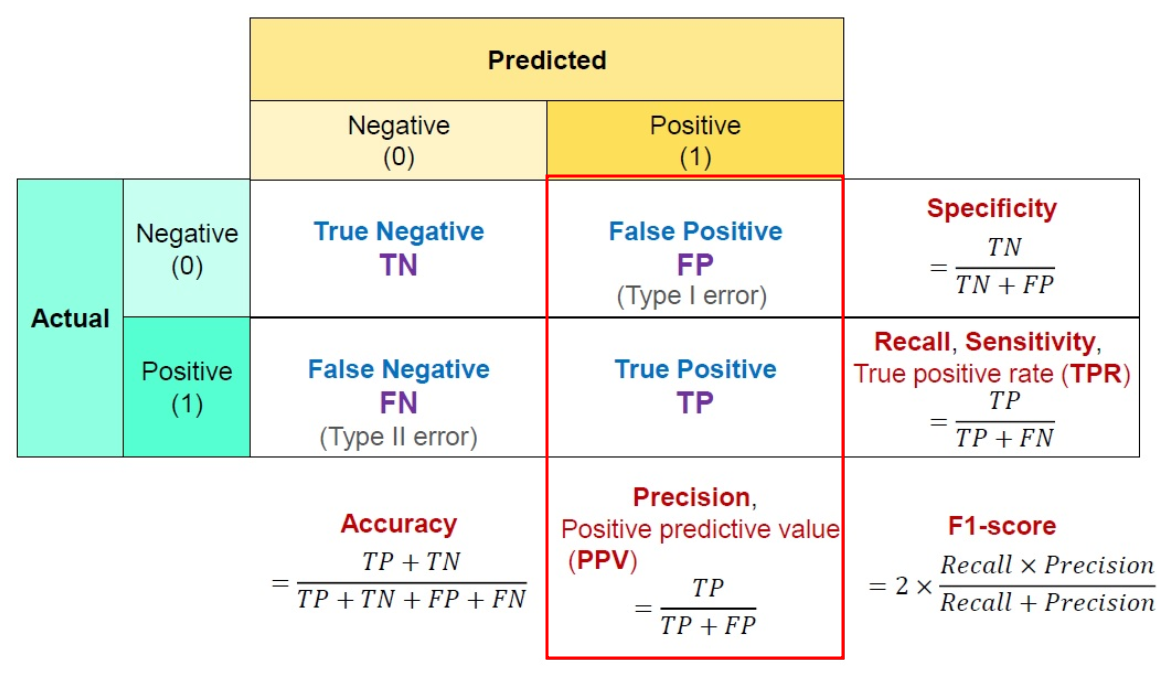

혼동 행렬

혼동 행렬은 특정 클래스에 대해서 (ex 암이냐?) 맞다(Positive) 아니다(Negative) 중 하나로 예측한 결과와 실제 정답의 경우를 나타낸 행렬

각 셀의 설명

혼동 행렬의 각 셀에서 Positive-Negative는 모델의 예측 결과임.

데이터가 어떤 클래스에 속하는지, 아닌지의 결과를 뱉어냈다는 말임.

앞에 True, False는 그게 실제 정답과 일치하는지 나타냄.

뒤부터 읽는 것을 추천

모델의 예시: 이 환자가 암인가? 이게 꽃인가? ...

(다중 분류, Multi classification은 기다 아니다 분류를 여러번 하는 거라고 보면 됨)

- True Positive: 모델이 맞다고 했는데 실제로도 맞는 것

- False Positive: 모델이 맞다고 했는데 실제로는 아닌 것

- True Negative: 모델이 아니라고 했는데 실제로도 아닌 것

- False Negative: 모델이 아니라고 했는데 실제로는 맞는 것

Accuracy = 전체 내가 예측한 것 중에 내가 틀리다 했든 맞다 했든 어쨌든 정답과 예측이 일치하는 것.

즉 전체 분의 맞는 것(true 붙은 것들)

Precision = 모델이 맞다고 한 것 중에 정답도 맞는 비율

모델이 맞다고 한 것(XXX Positive) 분의 모델이 맞다고 했는데 실제로도 맞는 것(True Positive)

Recall = 맞는 것 중에 모델도 맞다고 한 비율

맞는 것 (= 모델이 맞다고 했는데 실제로도 맞음 + 모델이 아니라고 했는데 실제로는 맞음 = True Positive + False Negative) 분의 True Positive

둘의 조화평균인 F1 Score는