Abstract

- T2I 모델들은 좋은 성능을 보이고 있지만, 일정한 스타일을 유지하도록 보장하는 것은 여전히 도전이다.

- 최소한의 어텐션 공유로 본 논문에서는 스타일이 정렬된 데이터의 모음을 생성하는 것을 가능케 한다.

Method

- 본 논문의 목표는 스타일이 text prompt인 가 들어올 때, 각각의 스타일에 대응하는 이미지의 그룹들인 를 만들어내는 것이다.

- 본 방식의 핵심 insight는 self-attention mechanism을 다양한 생성된 이미지들에 전반적으로 소통할 수 있게 만드는 것이다.

- Full attention Sharing을 진행하게 되면 생성된 데이터 자체를 해칠 수 있다. 위 사진에서 유니콘에 공룡의 녹색이 섞여들어간 것과도 같다.

- 이를 방지 및 해결하고자 저자들은 모든 이미지끼리 attention 공유를 하는 것이 아니라, 한 개의 이미지랑만 attention sharing을 진행한다고 한다. (주로 배치에서 첫 번째 사진이 된다.)

- 하지만 이러한 방법은 style이 정확하게 정렬되지는 않은 것을 확인할 수 있으며, 이유로는 attention의 흐름이 너무 약해서 그렇다고 생각한다.

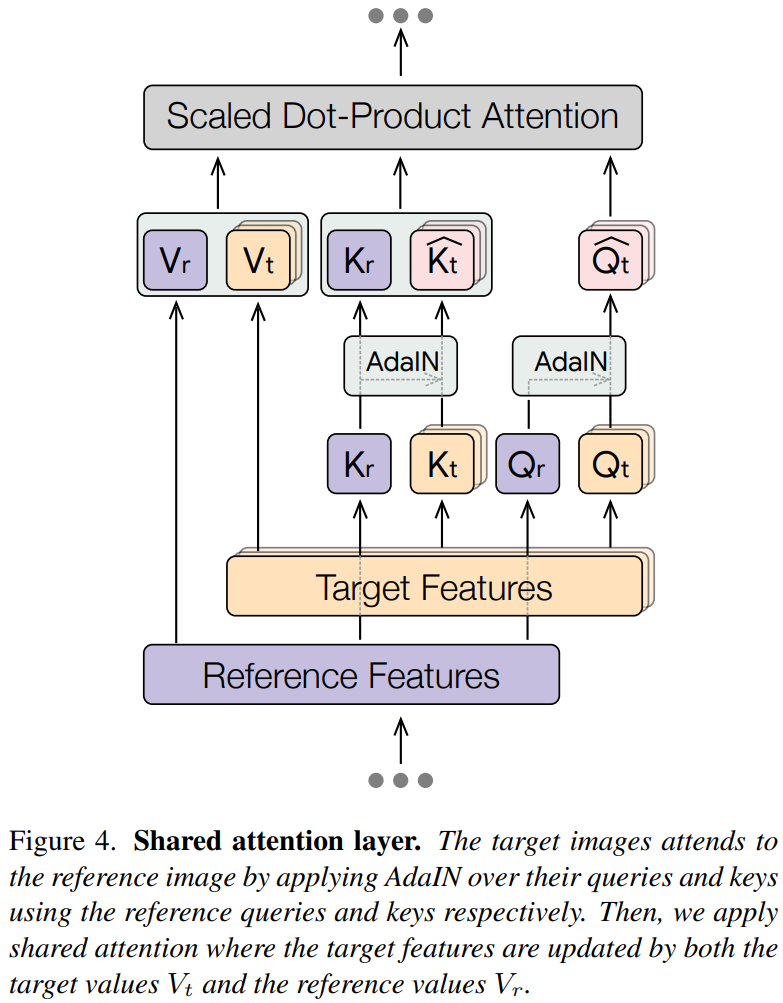

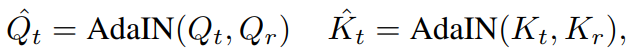

- 위 둘의 문제를 상호보완하기 위해서 위와 같은 사진의 shared attention layer를 사용한다.

- AdaIN를 사용하여서 target과 reference의 쿼리 및 키를 정규화한다.

- 결과는 다음과 같다.