LLM 스터디

1.LLM 공부 1일차 :: 무작정 LLM 돌려보기

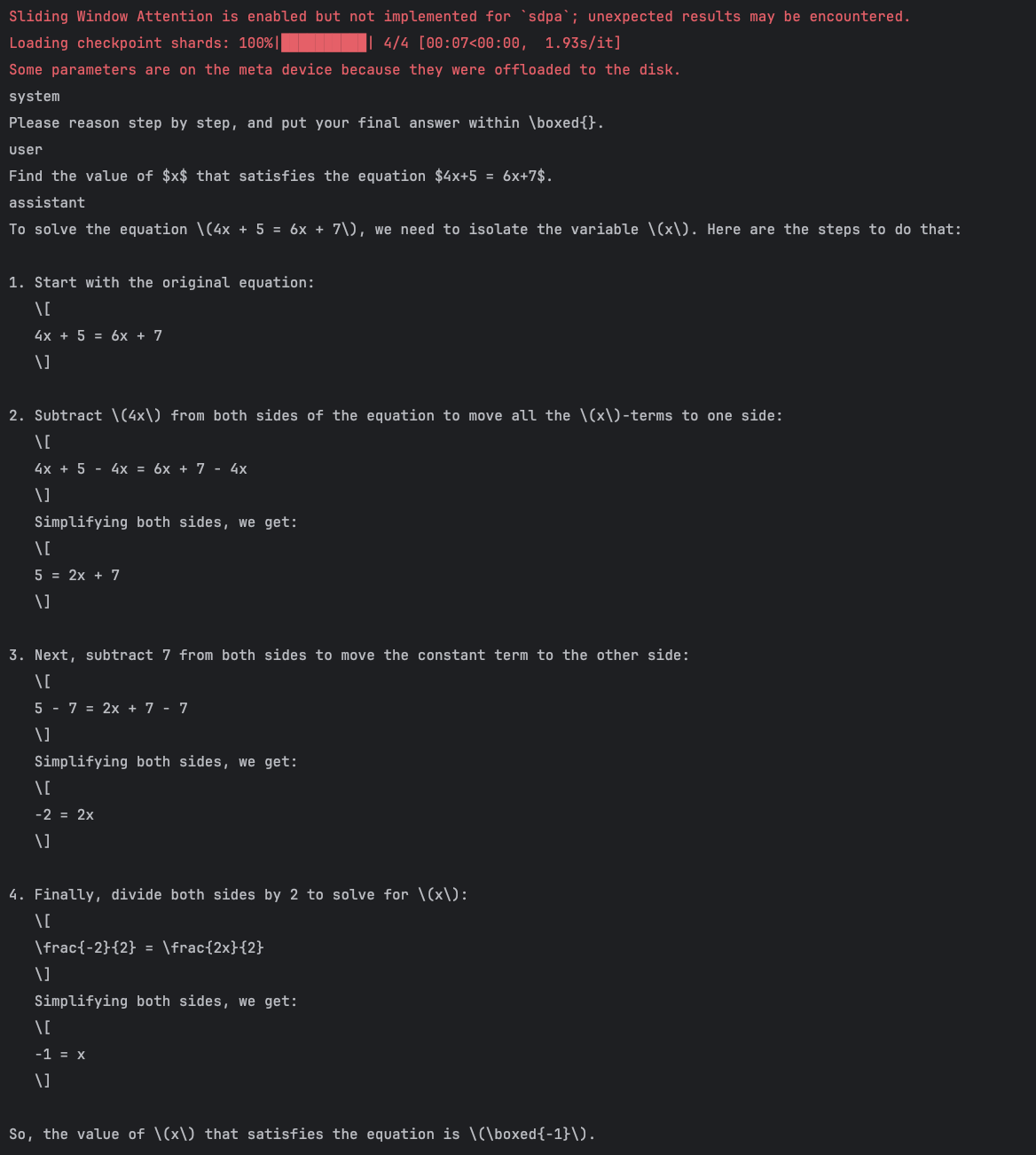

어떤 공부를 해야할지 몰라 일단 llm 모델을 받아 돌려보자는 생각을 하였다.메모리와 저장공간이 부족해 맥북을 초기화하고 hugging face에서 Qwen 모델을 받아 pycharm 에서 돌려보았다.음... 뭔지 모르겠다 일단 돌려보자

2025년 3월 13일

2.LLM 공부 1일차 :: 뉴럴 네트워크

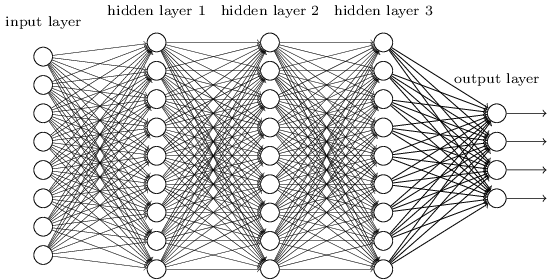

사실 llm 공부를 하려 했는데 고등학교 부전공 시간에 배웠던 인공지능 기초가 부분 부분 기억이 안나서 복습하는 느낌으로 몇몇 기초 개념들을 정리하려고 한다.정말 많이 본 이미지지만, 이것도 llm 학습시키는 것에 1000분의 1도 안되게 축소한 것이다뉴럴 네트워크는

2025년 3월 13일

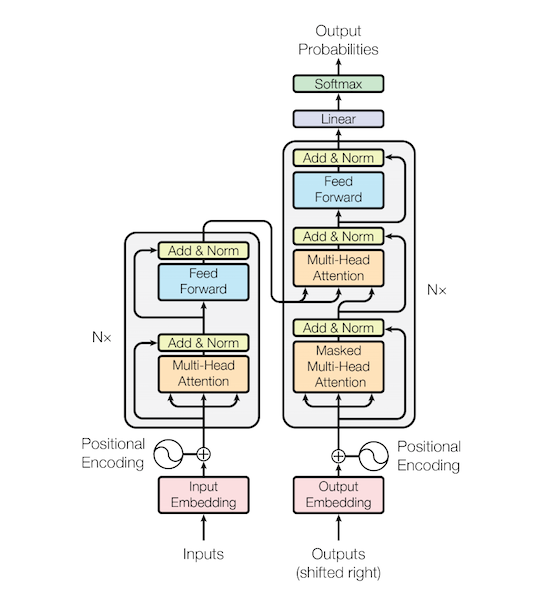

3.LLM 공부 2일차 :: FFN(Feed Forward Neural Network)

기초지식 별로 없이 무작정 llm을 공부하고 싶어서 transformer 관련된 내용을 뒤져보다논문에서 Feed Forward이란 단어가 자주보여 정리해보려 한다.Relu 활성함수를 활용하면서 총 2번의 선형회귀식으로 이루어짐을 알 수 있다. 라고 하는데 대체 뭘보고

2025년 3월 13일

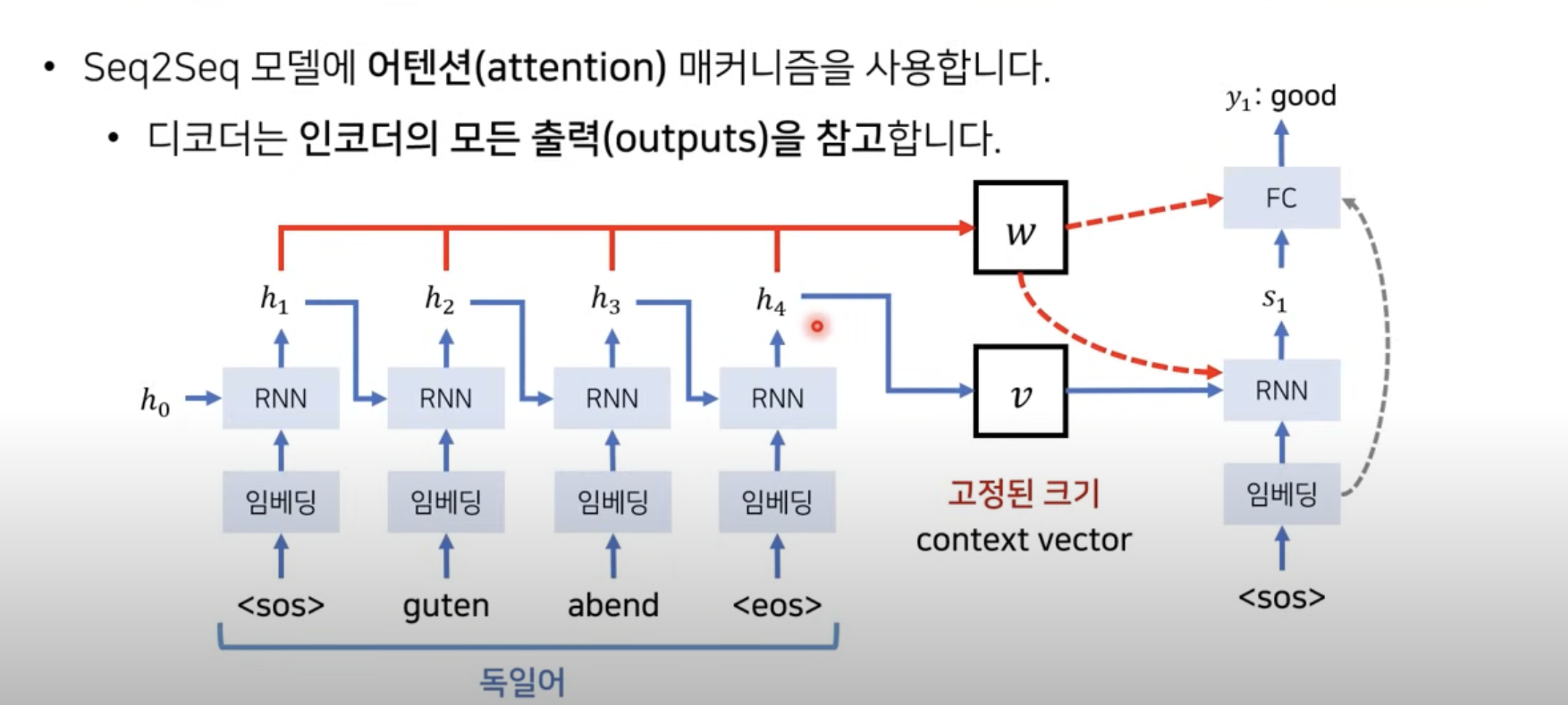

4.LLM 공부 2일차 :: seq2seq with Attention

대충 어떻게 공부 해야할지 갈피를 잡은것 같다. transformer가 어떻게 동작하는지 등의 원리를 따라가며 공부할 예정이다. 오늘은 입력 임베딩, 위치 인코딩, seq2seq가 attention을 적용하게된 이유에 대해 알아볼 것이다. https://arxiv.o

2025년 3월 13일