기초지식 별로 없이 무작정 llm을 공부하고 싶어서 transformer 관련된 내용을 뒤져보다

논문에서 Feed Forward이란 단어가 자주보여 정리해보려 한다.

수식풀이

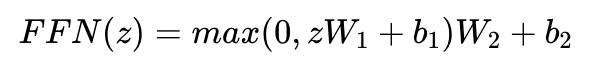

Relu 활성함수를 활용하면서 총 2번의 선형회귀식으로 이루어짐을 알 수 있다.

라고 하는데 대체 뭘보고 2번의 선형회귀식과 Relu 활성함수를 활용했는지 모르겠어서

풀어서 설명한 자료를 찾아보았다.

첫 번째 선형 변환: zW1 + b1

:입력 z에 가중치 행렬 W_1을 곱하고 편향 b_1을 더합니다.

ReLU 활성화 함수: max(0, x)

:첫 번째 선형 변환의 결과에 ReLU 함수를 적용합니다. (이 부분은 간단하게 알 수 있었다.)

두 번째 선형 변환: (결과)W_2 + b_2

:ReLU 함수를 통과한 결과에 다시 가중치 행렬 W2를 곱하고 편향 b2를 더합니다.

선형 변환에 대한 자료는 아래에서 찾아봤다.( 따로 포스트에서 다룰 예정 )

: https://datahacker.rs/linear-transformations/

요약 ( 선형 변환은 실제로 입력 벡터를 출력 벡터로 매핑하는 함수 )

FFN 활용

간단하게 과정을 정리해보았다.

-

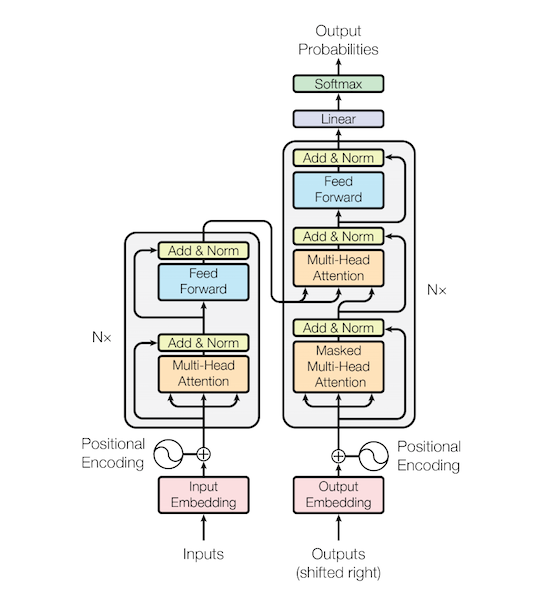

Input Embedding: 각 단어를 벡터로 변환.

-

Positional Encoding: 단어의 위치 정보를 추가.

-

Self-Attention: 각 단어가 다른 단어들과 어떻게 관련되는지 계산.

-

Normalization: 데이터를 정규화하여 학습을 안정화.

-

Feed-Forward Network( 이번에 배운거 ): 더 복잡한 특성을 학습.

-

Residual Connection: 그래디언트 흐름을 개선하고 더 깊은 학습을 가능하게 함.

잘 모르겠지만 그렇다고 한다. 다음에 더 자세하게 찾아 정리해보겠다.