Provider dependency를 설치하기 위해서는 Custom docker image를 Build 해야 한다.

데이터 분석 및 처리를 위해 많이 사용하는 Spark dependency를 설치해보자.

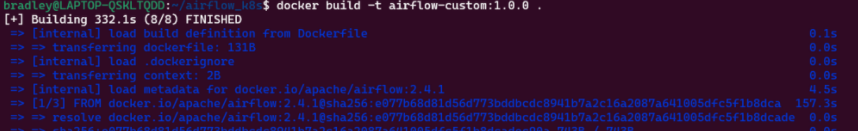

Custom docker image 만들기

requirements.txt 생성

requirements.txt

apache-airflow-providers-apache-spark==2.0.0Dockerfile 생성

Dockerfile

FROM apache/airflow:2.4.1

COPY requirements.txt .

RUN pip install -r requirements.txtImage build

docker build -t airflow-custom:1.0.0

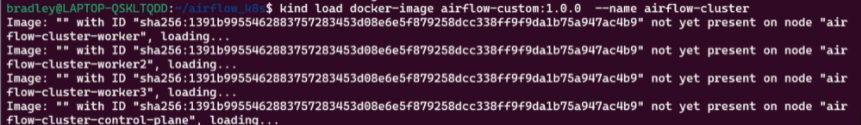

Cluster에 Load하기

kind 명령어로 Build한 Docker image를 Cluster에 Load 한다.

kind load docker-image airflow-custom:1.0.0 --name airflow-cluster

배포에 적용하기

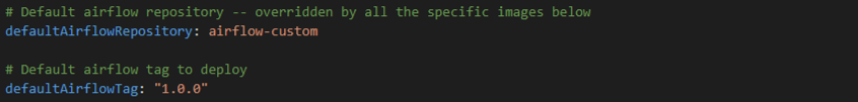

values.yaml 변경

배포 시마다 Provider dependency를 반영한 Image를 기반으로 적용하기 위해 values.yaml 파일에 Build한 Docker image를 적용한다.

Helm 배포

helm upgrade --install airflow apache-airflow/airflow -n airflow -f values.yaml --debug

helm ls -n airflow

Provider 설치 여부 확인

Spark 2.0.0 Version이 잘 설치된 것을 확인할 수 있다.

kubectl exec <webserver_pod_id> -n airflow -- airflow providers list