Python 설치(mac)

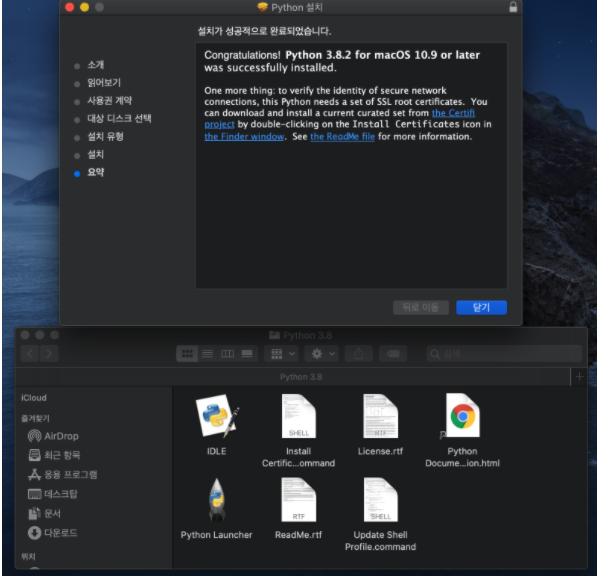

파이썬 다운로드 링크 (3.8.2버전)

https://www.python.org/ftp/python/3.8.2/python-3.8.2-macosx10.9.pkg

이런 폴더가 나타나면 설치가 완료!

mongoDB 설치(mac)

-

맥북 비밀번호 설정

MongoDB를 설치하기 위해 Homebrew 라는 프로그램을 이용 할 것이다, 이 때 반드시 컴퓨터 비밀번호가 있어야 한다.

-

Spotlight 에서, "terminal" 또는 "터미널"로 검색해 터미널을 열어준다.

터미널이란?

우리는 주로 마우스를 써서 컴퓨터에 명령을 내리지만, 컴퓨터가 더 익숙한 건 '명령어'를 통한 명령이다.

터미널은, '명령어를 쓸 수 있는 창'으로 생각하자!

.

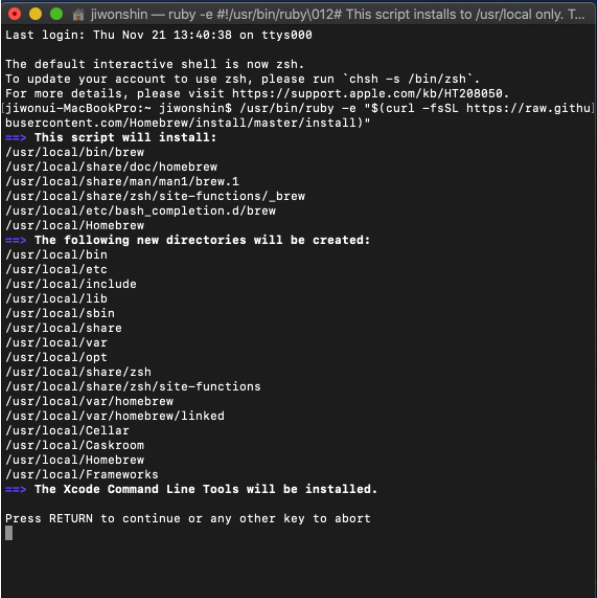

.- Homebrew 설치하기

/bin/bash -c "$(curl -fsSL [https://raw.githubusercontent.com/Homebrew/install/master/install.sh](https://raw.githubusercontent.com/Homebrew/install/master/install.sh))"

여기서 엔터키를 누르면!

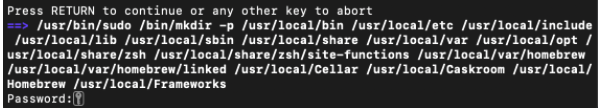

비밀번호를 입력칸이 나오게 된다! 나의 맥 패스워드를 입력!

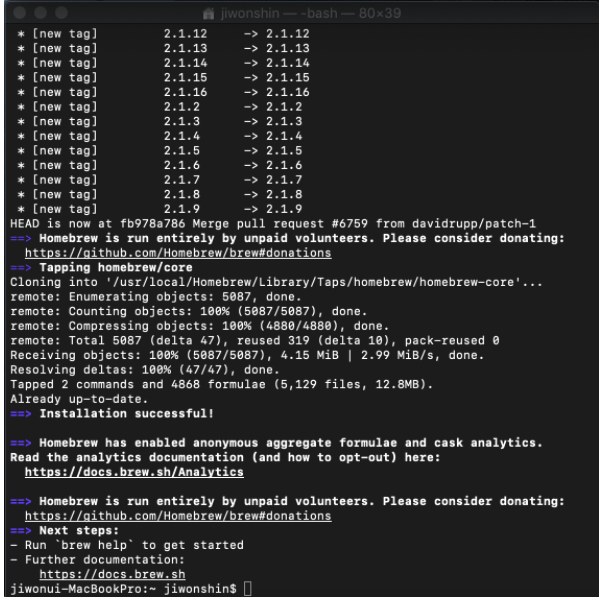

이렇게 나오게 되면 homebrew 설치하기 끝!

mongoDB 설치하기

한줄씩 터미널 창에 코드 입력하기

brew tap mongodb/brewbrew install mongodb-community설치가 끝나면 mongoDB가 잘 설치되었는지 확인을 해봅시다.

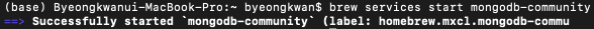

mongoDB 실행 명령어

brew services start mongodb-community입력을 하게되면

이런 화면이 나오게된다!

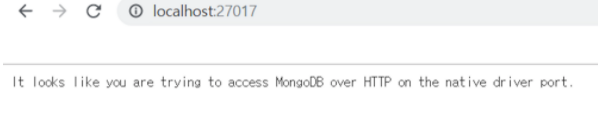

그후 확인하는 방법은 이 링크를 클릭해보면

http://localhost:27017

이런식으로 문구가 나오면 성공입니다!

Robo3T 설치하기 (mac)

다운로드 링크

https://robomongo.org/download

오늘 배울 것

- 크롤링

- mongoDB

네이버 영화 페이지 크롤링 해보기!

네이버 영화 페이지 링크

https://movie.naver.com/movie/sdb/rank/rmovie.nhn?sel=pnt&date=20200303

일단 크롤링 하기에 앞서 크롤링에 필요한 패키지를 설치 해봅시다!

- requests 패키지 설치

pip install requests- beautifulsoup4 패키지 설치

pip install beautifulsoup4설치가 완료되었으면 이제 크롤링 기본 세팅을 하겠습니다.

import requests

from bs4 import BeautifulSoup

# 타겟 URL을 읽어서 HTML를 받아오고,

headers = {'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.86 Safari/537.36'}

data = requests.get('https://movie.naver.com/movie/sdb/rank/rmovie.nhn?sel=pnt&date=20200303',headers=headers)

# HTML을 BeautifulSoup이라는 라이브러리를 활용해 검색하기 용이한 상태로 만듦

# soup이라는 변수에 "파싱 용이해진 html"이 담긴 상태가 됨

# 이제 코딩을 통해 필요한 부분을 추출하면 된다.

soup = BeautifulSoup(data.text, 'html.parser')

#############################

# (입맛에 맞게 코딩)

#############################- select/ select_one의 사용법

영화 제목을 가져와 보기!

태그 안의 텍스트를 찍고 싶을 땐 -> 태그.txt

import requests

from bs4 import BeautifulSoup

# URL을 읽어서 HTML를 받아오고,

headers = {'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.86 Safari/537.36'}

data = requests.get('https://movie.naver.com/movie/sdb/rank/rmovie.nhn?sel=pnt&date=20200303',headers=headers)

# HTML을 BeautifulSoup이라는 라이브러리를 활용해 검색하기 용이한 상태로 만듦

soup = BeautifulSoup(data.text, 'html.parser')

# select를 이용해서, tr들을 불러오기

movies = soup.select('#old_content > table > tbody > tr')

# movies (tr들) 의 반복문을 돌리기

for movie in movies:

# movie 안에 a 가 있으면,

a_tag = movie.select_one('td.title > div > a')

if a_tag is not None:

# a의 text를 찍어본다.

print (a_tag.text)- beautifulsoup 내 select에 미리 정의된 다른 방법

# 선택자를 사용하는 방법 (copy selector)

soup.select('태그명')

soup.select('.클래스명')

soup.select('#아이디명')

soup.select('상위태그명 > 하위태그명 > 하위태그명')

soup.select('상위태그명.클래스명 > 하위태그명.클래스명')

# 태그와 속성값으로 찾는 방법

soup.select('태그명[속성="값"]')

# 한 개만 가져오고 싶은 경우

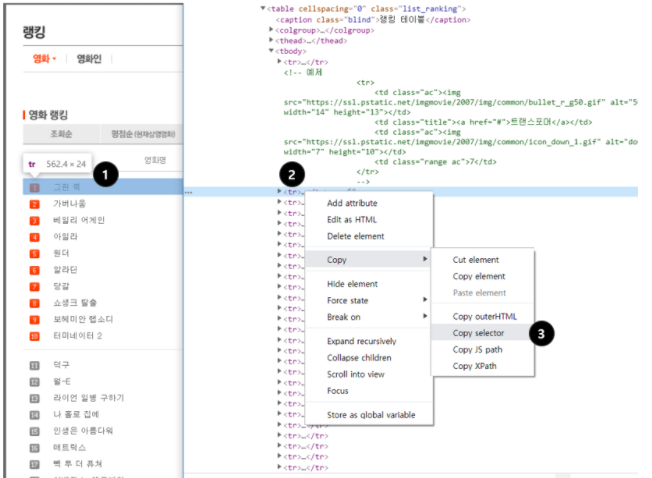

soup.select_one('위와 동일')정확 하지는 않으나 크롬 개발자 도구를 참고 가능!

- 원하는 부분에서 마우스 오른쪽 클릭 → 검사

- 원하는 태그에서 마우스 오른쪽 클릭

- Copy → Copy selector로 선택자를 복사할 수 있음

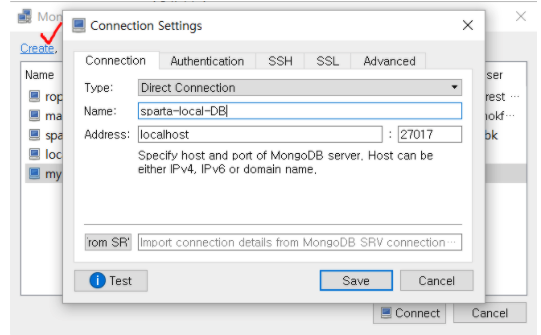

robo 3T 준비하기

- robo 3T의 역할

mongoDB는 GUI를 제공하지 않기 때문에 DB내부를 살펴보기 위한 프로그램을 따로 설치해야된다 이 기능을 제공하는 프로그램이 바로 robo 3T의 역할이다.

- robo 3T 세팅하기

create 버튼을 클릭하고 name 부분에 자기가 원하는 이름을 아무거나 넣으면 된다.

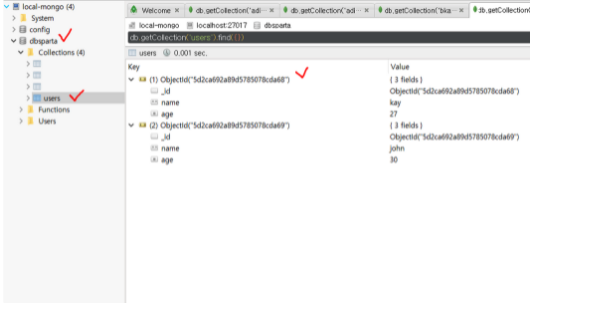

db, collection, documents(각 데이터들을 지칭)를 확인 가능합니다.

Database 는 크개 2가지의 종류가 있다.

-

RDBMS(SQL)

행/열의 생김새가 정해진 엑셀에 데이터를 저장하는 것과 유사합니다. 데이터 50만 개가 적재된 상태에서, 갑자기 중간에 열을 하나 더하기는 어려울 것입니다. 그러나, 정형화되어 있는 만큼, 데이터의 일관성이나 / 분석에 용이할 수 있습니다.

ex) mysql,oracle -

No-SQL

딕셔너리 형태로 데이터를 저장해두는 DB입니다. 고로 데이터 하나 하나 마다 같은 값들을 가질 필요가 없게 됩니다. 자유로운 형태의 데이터 적재에 유리한 대신, 일관성이 부족할 수 있습니다.

ex) MongoDB

나는 RDBMS인 mysql로 몇개의 프로젝트를 한적이 있어서 RDBMS에 익숙한편인데 No-SQL은 한번도 해본적이 없어서 조금 두렵기는 한다.... ㅠㅠ

자 이제 python으로 db를 조작을 해보겠습니다.

pymongo로 DB조작하기

- pymongo 설치하기

pip install pymongo- pymongo의 기본 코드

from pymongo import MongoClient

client = MongoClient('localhost', 27017)

db = client.dbsparta

# 코딩 시작- DB연결하기, 데이터 넣기

from pymongo import MongoClient # pymongo를 임포트 하기(패키지 인스톨 먼저 해야겠죠?)

client = MongoClient('localhost', 27017) # mongoDB는 27017 포트로 돌아갑니다.

db = client.dbsparta # 'dbsparta'라는 이름의 db를 만듭니다.

# MongoDB에 insert 하기

# 'users'라는 collection에 {'name':'bobby','age':21}를 넣습니다.

db.users.insert_one({'name':'bobby','age':21})

db.users.insert_one({'name':'kay','age':27})

db.users.insert_one({'name':'john','age':30})- 모든 결과 값을 보기

from pymongo import MongoClient # pymongo를 임포트 하기(패키지 인스톨 먼저 해야겠죠?)

client = MongoClient('localhost', 27017) # mongoDB는 27017 포트로 돌아갑니다.

db = client.dbsparta # 'dbsparta'라는 이름의 db를 만듭니다.

# MongoDB에서 데이터 모두 보기

all_users = list(db.users.find({}))

# 참고) MongoDB에서 특정 조건의 데이터 모두 보기

same_ages = list(db.users.find({'age':21},{'_id':False}))

print(all_users[0]) # 0번째 결과값을 보기

print(all_users[0]['name']) # 0번째 결과값의 'name'을 보기

for user in all_users: # 반복문을 돌며 모든 결과값을 보기

print(user)- 특정 결과 값을 뽑아 보기

user = db.users.find_one({'name':'bobby'})

print(user)- 수정하기

# 생김새

db.people.update_many(찾을조건,{ '$set': 어떻게바꿀지 })

# 예시 - 오타가 많으니 이 줄을 복사해서 씁시다!

db.users.update_one({'name':'bobby'},{'$set':{'age':19}})

user = db.users.find_one({'name':'bobby'})

print(user)- 삭제하기(위험하니 잘 생각하고 사용하세용!)

db.users.delete_one({'name':'bobby'})

user = db.users.find_one({'name':'bobby'})

print(user)- 코드 요약본

# 저장 - 예시

doc = {'name':'bobby','age':21}

db.users.insert_one(doc)

# 한 개 찾기 - 예시

user = db.users.find_one({'name':'bobby'})

# 여러개 찾기 - 예시 ( _id 값은 제외하고 출력)

same_ages = list(db.users.find({'age':21},{'_id':False}))

# 바꾸기 - 예시

db.users.update_one({'name':'bobby'},{'$set':{'age':19}})

# 지우기 - 예시

db.users.delete_one({'name':'bobby'})# 저장 - 예시

doc = {'name':'bobby','age':21}

db.users.insert_one(doc)

# 한 개 찾기 - 예시

user = db.users.find_one({'name':'bobby'})

# 여러개 찾기 - 예시 ( _id 값은 제외하고 출력)

same_ages = list(db.users.find({'age':21},{'_id':False}))

# 바꾸기 - 예시

db.users.update_one({'name':'bobby'},{'$set':{'age':19}})

# 지우기 - 예시

db.users.delete_one({'name':'bobby'})자 이제 웹크롤링한 결과를 pymongo를 이용하여 mongoDB에 넣어봅시다!

웹스크래핑 결과 저장하기

- pymongo 기본 세팅

import requests

from bs4 import BeautifulSoup

from pymongo import MongoClient # pymongo를 임포트 하기(패키지 인스톨 먼저 해야겠죠?)

client = MongoClient('localhost', 27017) # mongoDB는 27017 포트로 돌아갑니다.

db = client.dbsparta # 'dbsparta'라는 이름의 db를 만듭니다.

# URL을 읽어서 HTML를 받아오고,

headers = {'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.86 Safari/537.36'}

data = requests.get('https://movie.naver.com/movie/sdb/rank/rmovie.nhn?sel=pnt&date=20200303',headers=headers)

# HTML을 BeautifulSoup이라는 라이브러리를 활용해 검색하기 용이한 상태로 만듦

soup = BeautifulSoup(data.text, 'html.parser')

# select를 이용해서, tr들을 불러오기

movies = soup.select('#old_content > table > tbody > tr')

# movies (tr들) 의 반복문을 돌리기

for movie in movies:

# movie 안에 a 가 있으면,

a_tag = movie.select_one('td.title > div > a')

if a_tag is not None:

rank = movie.select_one('td:nth-child(1) > img')['alt'] # img 태그의 alt 속성값을 가져오기

title = a_tag.text # a 태그 사이의 텍스트를 가져오기

star = movie.select_one('td.point').text # td 태그 사이의 텍스트를 가져오기

print(rank,title,star)- 도큐먼트 만들어 하나씩 insert하기

import requests

from bs4 import BeautifulSoup

from pymongo import MongoClient # pymongo를 임포트 하기(패키지 인스톨 먼저 해야겠죠?)

client = MongoClient('localhost', 27017) # mongoDB는 27017 포트로 돌아갑니다.

db = client.dbsparta # 'dbsparta'라는 이름의 db를 만듭니다.

# URL을 읽어서 HTML를 받아오고,

headers = {'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; Win64; x64)AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.86 Safari/537.36'}

data = requests.get('https://movie.naver.com/movie/sdb/rank/rmovie.nhn?sel=pnt&date=20200303',headers=headers)

# HTML을 BeautifulSoup이라는 라이브러리를 활용해 검색하기 용이한 상태로 만듦

soup = BeautifulSoup(data.text, 'html.parser')

# select를 이용해서, tr들을 불러오기

movies = soup.select('#old_content > table > tbody > tr')

# movies (tr들) 의 반복문을 돌리기

for movie in movies:

# movie 안에 a 가 있으면,

a_tag = movie.select_one('td.title > div > a')

if a_tag is not None:

rank = movie.select_one('td:nth-child(1) > img')['alt'] # img 태그의 alt 속성값을 가져오기

title = a_tag.text # a 태그 사이의 텍스트를 가져오기

star = movie.select_one('td.point').text # td 태그 사이의 텍스트를 가져오기

doc = {

'rank' : rank,

'title' : title,

'star' : star

}

db.movies.insert_one(doc)