이 글은 Linear Algebra and Its Applications 책을 정리한 글입니다.

- 어떠한 inconsistent system of equation이 solution이 없을때 approximate solution을 구할 필요가있다. 이번 챕터에서는 orthogonality라는 성질을 통해 nearest point를 찾고 approximate solution을 찾을것 이다.

6.1 Inner product, length, and orthogonality

The Inner Product

- 위와같은 의 vector 가 있을때 우리는 이를 matrix로 간주할 수 있으며, tranpose인 를 matrix이다. 또한 이들의 matrix product인 는 a single real number로 쓸 수 있는데 이를 Inner product라고 하며 라고 쓸 수 있으며 이를 dot product라고 한다.

Theorem1

Let be vector in , and let c be scalar then,

- =

- and if and only if

The Length of a Vector

Definition

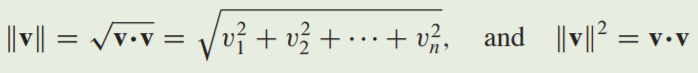

- The length (or norm) of in is nonnegative scalar defined by

- unit vector = 1

- normalizationing

Distance in

Definition

- For and in , the distance between and , written as dist(,), is the length of the vector . That is dist(,) =

Example

- 두 vector , 사이의 distance를 구하라.

- 아래 그림에서 나타나다시피 와 의 distance는 와 0 사이의 distance와 같다.

Example4

Orthogonal Vectors

- 위 그림에서 distance from to 이 distance from to 랑 같다묜 이는 geometrically perpendicular하며 이 둘은 squares of distance가 같다.

- 두 dist가 같을 조건은 2 = -2 이므로

이 되어야한다.

Definition

-Two vectors and in are orthogonal if

- 추가로 zero vector는 의 모든 vector에 대하여 orthogonal하다 ()

Theorem

Pythagoream Theorem

- Two vector are orthogonal if and only if

Orthogonal Complement

- vector 가 의 subspace W에 모든 vector에 orthogonal하다면, 는 W에 orthogonal하다고 말한다. 또한 W에 orthogonal인 set of all vector 를 orthogonal complemnet of W 라고 하며 으로 표기한다.

- 위 그림처럼 W가 의 원점을 지나는 subspace인 평면이고 L이 W에 perendicular(직각)이며 원점을 지나는 직선이다. vector 가 W of 의 모든 벡터에 orthogonal한다면 는 orthogonal to W라고 부른다 (W = 0).

- ortogonal이 vector관의 관계 뿐 아니라 벡터와 subspace사이에서도 사용됨.

Example

- vector 가 vectors and 에 orthogonal하다고 가정했을때. 가 vector 에 orthogonal함을 보여라.

Example6~8

Theorem3

- Let A be an matrix. The orthogonal complement of the row space of A is the null space of A, and the orthogonal complement of the column space of A is the null space of :

6.2 Orthogonal Sets

- A Set of vectors in is said to be an orthogonal set if each pair of distinct vectors from the set is orthogonal, if whenever

- 해당 set안의 임이의 두 vector가 orthogonal하아면 그 set은 orthogonal set이다는 소리.

Example

- 위 세 vector set이 orthogonal set인지 보여라.

- 각각의 vector들이 orthogonal함을 보였으니 이는 orthogonal set이며 아래 그림과 같다.

Theorem

- If S = {} is an orthogonal set of nonzero vectors in , then S is linearly independent and hence is a basis for the subspace spanned by S.

- 위 식인 linear combination을 만족하는 ~ 가 0인 경우 linearly independent set임을 보일 수 있다.

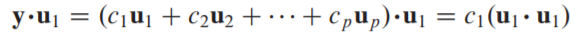

- 위처럼 양변에 을 dot product 시키면 이 되고, 이때 는 당연하게도 무조건 0이상이기에 이 된다.

Definition

Orthogonal Basis

- An orthogonal basis for a subspace W of is a basis for W that is also an orthogonal set.

- 의 subspace의 basis이면서 orthogoanl set이면 orthogonal basis라는 소리.

Theorem

- Let {} be an orthogonal basis for a subspace W of . For each in W , the weights in the linear combination are given by .

- 이 전까지 weights를 찾으려면 augmented matrix를 row operation하여 solution을 찾았는데 orthogonal basis이면 위처럼 명시적으로 주어진다.

- 위 식에서 orthogonal set이기에 끼리의 dot product빼고는 전부 0이 된다.

Example

- set S = {}이 위와 같고, orthogonal basis for 일때 vector = (6,1,-8)를 orthogoanl basis로 표현해보자.

- 간단하게 위 이론에서처럼 계산해보면 위와같다.

Orthogonal Projection

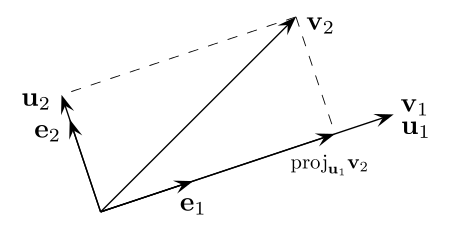

- nonzero vector in 이 주어졌고 vector in 을 두 벡터로 decomposing해보면 아래처럼 나타낼 수 있고,

- some scalar 에 이고 가 에 orthogonal 할때 라면 위 식을 만족한다.

-

이때 이 에 orthogonal하다면,

가 되며 이때, 이고 이 된다. -

이때 vector 는 orthogonal projection of y onto u 로 부르며, vector 를 component of y orthogonal to u 라고 하며 vector를 subspace L ( span{} )로 확장하면 다음과같이 나타낼 수 있다.

* 위 내용은 어떤 vector가 있을 때 어떤 다른 vector 혹은 그 vector의 span에다 orthogonal projection이 어떤식으로 정의되는지를 보여준 것이다.

Example

- 아래 두 vector가 주어졌을때 orthogonal projection of onto 를 찾고 를 두 orthogonal vector의 합으로 나타내라 (하나는 in Span{}, 다른 하나는 orthogonal to )

- orthogonal projection of onto 인 를 구하기위해 계산하면 다음과같고,

- component of orthogonal to (orthogonal to ) 를 구하면 다음과 같다.

- 를 두 벡터로 나타내면 다음과같다.

- 이를 그림으로 나타내면 다음과 같다.

Orthonomal sets

- A Set {} is an orthonormal set if it is an orthogonal set of unit vectors.

- 다시 언급하면 unit vector는 vector의 norm(length)이 1인 vector

Theorem

- An matrix has orthonormal columns if and only if

- 를 위와같이 전개하여 보면 diagonal term들이 전부 1이고 나머지 entry가 0이면 는 orthonomal columns를 갖는단 소리.

Theorme

- Let be an matrix with orthonormal columns, and let and be in . Then

a.

b.

c. if and only if

6.3 Orthogonal Projection

- vector 와 subspace W in 이며 이 W에 orthogonal할때 unique vector 가 있다. 이는 후에 다룰 least-squares solution에서 중요하게 다뤄진다.

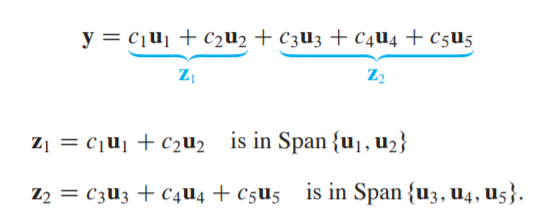

- vector 는 vectors 의 linear combination으로 나타내었을 때 는 처럼 두개의 그룹으로 나타낼 수 있는데 이때 은 linear combination의 일부이며 는 linear combination의 나머지이다. 이는 {} 가 orthogoanl basis( ) 일때 유용하게 사용된다.

Example

- {} 가 의 orthogonal basis이며 이고 subspace W = Span{} 이라고 하였을때 는 vector in W와 vector in 로 아래와같이 나타낼 수 있다.

- in 을 보이기 위해선 가 basis {} for W의 vector에 대해 orthogonal함을 보이면 된다.

Theorme

- Let W be a subspace of . Then each in can be written uniquely in the form , where is in W and is in . In fact, if {} is any orthogonal basis of W, then and .

- The vector 는 orthogonal projection of y onto W 라고 하며 로 나타내며 아래의 그림과같다.

- 이는 이전에 보았던 orthogonal projection of y onto L 을 subspace로 확장한것.

Example

- 아래와 같이 vector가 주어졌고 {} 가 orthogoanl basis for W = Span{} 일때 를 W의 vector와 W에 orthogonal한 vector의 합으로 나타내라.

- theorme에 따라 을 구하고 을 구하면 다음과 같고

- y를 두 vector의 합으로 decompose시키면 다음과 같다.

A Geometric Interpretation of the Orthogonal Projection

-

이번엔 이전까지 보았던 space를 확장해 space상에서 시각적으로 살펴본다.

-

space의 임의의 vector 를 Span{} 평면에 orthogonal projection 시켜보자.

- 위 그림처럼 는 로 정의에서처럼 명시할 수 있고 이때 각각의 component는 , 로 나누어지며 이 , 는 결국 orthogonal basis의 각 벡터 () 가 span 하는 Line에 orthogonal projection 시킨 것 이다.

Theorme - The best approximation theorem

- Let be a subspace of , any vector in , and be the orthogonal projection of onto . Then is the colset point to , in the sense that for all in distinct from .

- length 측면으로 보았을때 와 간의 차이가 에 어떤 vector 와의 차보다 작다는 뜻으로 아래 그림을 보고 이해할 수 있다.

Example

- 아래와 같이 vector 가 주어지고 가 Span{} 이고 가 nearest point to 라고 하였을 때 distance from to 를 구해라.

- 를 구하기 위해 를 구하면 다음과 같고

- distance를 구하면 다음과같다.

- distance from to =

Theorme

-

일단 ~ 가 orthonomal basis이기에 에서 각 vector의 coefficient의 분모가 unit vector끼리의 dot product이니 1이되어 위 (4)식으로 나타낼 수 있다.

-

또한 = 로 쓸 수있는데 이는 (4)번 식을 dot product 정의에 의해 로 나타낼 수 있고 이를 matrix로 정리하여 y를 바깥으로 빼내면 로 나타낼 수 있다.

6.4 The Gram-Schmidt Process

- 이전까진 subspace를 이루는 orthogonal basis가 주어졌을 때 를 가정하였지만 이번 챕터는 gram-schmidt 라는 방법을 통해 orthogonal basis를 구하는 방법을 볼 것이다.

-

vector {}를 subspace = Span{}의 basis라고 가정하자

- Span{}의 basis가 orthogonal하다는 말이 없으니 orthogonal set이 아니라 그냥 linearly independent set이다. -

이때 subspace 를 이루는 orthogonal basis를 찾아보자.

-

을 이라고 하고 를 에 projection 시켜 ()를 구한 후 를 로 나타낼 수 있다.

-

이때 의 linear combination 형태로 나타날수 있으므로 는 subspace 에 있다는 것을 알수 있다.

-

, 가 에 있음을 보였고 orthogonal하게 만들었으니 은 당연히 nonzero이고 가 nonzero임을 보여 linearly independent 함을 보여야한다 (과 가 orthogonal set이기에 nonzero이면 당연히 independent하다) .

-

만일 가 nonzero가 아니라면 와 이 같다는 것인데 이는 가 Span{} 에 있다는 뜻이므로 둘은 dependent set이되고 이는 처음 정의에 의해 과 가 subspace의 basis이니 성립이되지 않아 둘은 linearly independent하다.

W = Span{} = Span{}

- space의 orthogonal basis를 찾는것도 똑같다.

-

벡터 이름이 바뀌어 햇갈리지만 이번엔 basis를 이루는 또다른 주어진 벡터 를 space 에서 구한 평면 (위 그림에선 ) 에 projection시켜 를 찾으면 된다.

-

그 다음엔 을 구하면 되는데 는 이 전 챕터에서 한 것 처럼 과 에 projection시켜주면 된다.

Theorem - The Gram-Schmidt Process

-

위 내용처럼 space의 subspace 의 basis로 하나씩 projection시켜주며 까지 구하여 의 orthogonal basis를 찾을 수 있다.

-

또한 ~ 까지를 구할때 는 ~ 과 의 linear combination으로 나타낼수 있었고 이를통해 Span{} = Span{} 임을 알 수 있다.

Orthonormal basis

- Orthonomal basis는 말 그대로 orthogonal basis에서 각각의 vector들의 norm을 1로 만들어 normalize 시킨 것 이다.

QR Factorization of Matrices

Theorme - The QR Factorization

- If A is an matrix with linearly independent columns, then A can be factored as A = QR, where Q is an matrix whose columns form an orthonormal basis for Col A and R is an upper triangular invertible matrix with positive entries on its diagonal.

-

matrix A가 linearly independent coulmns를 갖고있다 했으니 이는 A = []으로 나타낼 수 있고 이때의 Col A 의 basis는 {}가 되며 이를 Gram-Schmidt를 통해 구한 Col A의 orthonormal basis를 {} 이라고 하자.

-

이때 Col A의 orthonormal basis를 columns 으로 둔 matrix 를 Q라 하고 다음과같이 나타낼수 있다 Q = [].

-

이전에 배웠던 것처럼 = 으로 나타낸 linear combination 임을 알 수 있고 가 n까지 나타날수 있으니 아래 식처럼 나타낼 수 있다.

- 이때 vector 를 아래와같이 나타낼 수 있으며,

- 이는 = Q 식으로 나타낼 수 있고 이를통해 아래와 같이 유도된다.

- 이때 A의 column들이 linealy independent하니 R은 invertible matrix가 되며 이는 n개의 pivot을 갖는단 소리고 이는 R의 diagonal term들이 nonzero가 되어 아래 그림처럼 upper triangular matrix가 된다.

-

또한 처럼 unit vector에 방향을 바꿔주어 R의 diagonal term을 nonnegative하게 만들 수 있다.

-

또한 이전에 보았던 이론을 통해 과 같이 A에 를 multiplication해주어 R을 찾을 수 있다.