논문 제목:Tree of Thoughts: Deliberate Problem Solving with Large Language Models

저자 : Shunyu Yao, Dian Yu, Jeffrey Zhao, Izhak Shafran, Thomas L. Griffiths, Yuan Cao, Karthik Narasimhan

Abstract

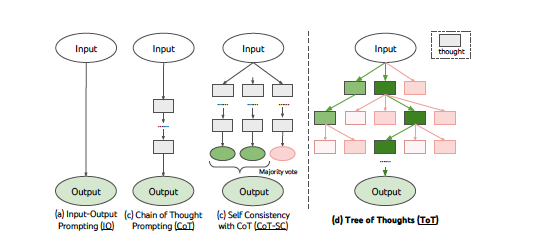

언어 모델 프롬프팅에서 널리 사용되는 "Chain of Thought (CoT)" 접근 방식을 일반화한 것으로, 문제 해결을 위한 중간 단계 역할을 하는 "생각(thoughts)"이라는 일관된 텍스트 단위를 탐구하게 해줌

특징

1) ToT는 여러 가지 다양한 추론 경로를 고려하고, 스스로 선택을 평가하면서 다음 행동 방향을 결정 필요할 경우, 앞으로 내다보거나 뒤로 돌아가는(backtracking) 기능을 통해 전체적인 최적의 선택을 가능

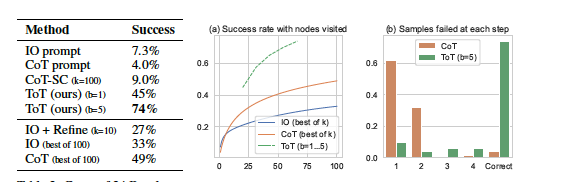

2)ToT는 기존의 CoT보다 더 복잡한 문제에서 성능을 크게 향상

Introduction

언어 모델(GPT, PaLM 등)은 수학적, 상식적, 지식적 추론까지 수행하며 발전왔지만 여전히 기존의 자동회귀 방식(한 번에 하나의 단어를 왼쪽에서 오른쪽으로 생성하는 방식)만으로는 일반 문제 해결에 한계가 있었음.

인간 인지에서 두 가지 결정 모드(fast & automatic과 slow & deliberate)가 있다는 연구에 기반해, 언어 모델에 보다 신중한 계획(deliberative plan) 과정을 추가해야 한다는 아이디어가 제안됨

이러한 계획 과정을 위해, 우리는 뉴웰과 사이먼의 문제 해결 방식을 참고하여 "Tree of Thoughts, ToT" 프레임워크를 제안됨. ToT는 문제 해결 과정에서 중간 단계별로 여러 가지 가능한 생각을 탐색하고 평가하는 구조로, 이를 통해 모델이 보다 체계적으로 문제를 해결할 수 있음

너비 우선 탐색(BFS) 또는 깊이 우선 탐색(DFS) 같은 탐색 알고리즘을 통해 Tree of Thoughts를 활용합니다.

- CoT에 비해 74%로 좋은 성능을 냈다.

추가자료

https://oglee.tistory.com/entry/%EB%85%BC%EB%AC%B8-%EB%A6%AC%EB%B7%B0-Tree-of-Thoughts-Deliberate-Problem-Solving-with-Large-Language-Models

https://lilys.ai/notes/280318