QA

QA(Question Answering, 질의 응답)은 주어진 컨텍스트를 기반으로 질문과 답변을 제시합니다.

일례로, 썸네일의 IBM의 Watson은 고도로 학습된 질의응답 시스템이라 부를 수 있습니다.

기존의 검색기반 QA가 Word Matching, TF-IDF, Okapi BM25, LSA 등의 방법론으로 빠르게 질의를 소화해냈다면, 기계 독해(Machine Reading) 모델의 등장 이후 QA는 더욱 능동적인 질의 응답이 가능해졌습니다.

기계 독해 모델은 단어 수준의 정보 습득을 넘어, 문서를 읽으면서 질문을 참고하고 다시 질문을 읽으면서 문서를 참고하는 회귀적인 학습이 가능합니다.

QA가 해결하고자 하는 문제는 무엇인가?

QA의 연구 주제들은 다음과 같습니다.

- 상호 작용 — 질문 또는 답변 명확히하기

- 응답 재사용 또는 캐싱

- 답변 프리젠테이션

- 지식 표현 및 추론

- QA 시스템을 사용한 소셜 미디어 분석

- 감정 분석

- 의미론적 해결책 제시 : 구문론적으로 다른 질문과 답을 구별

- WordNet, FrameNet 등과 같은 언어 자원의 활용

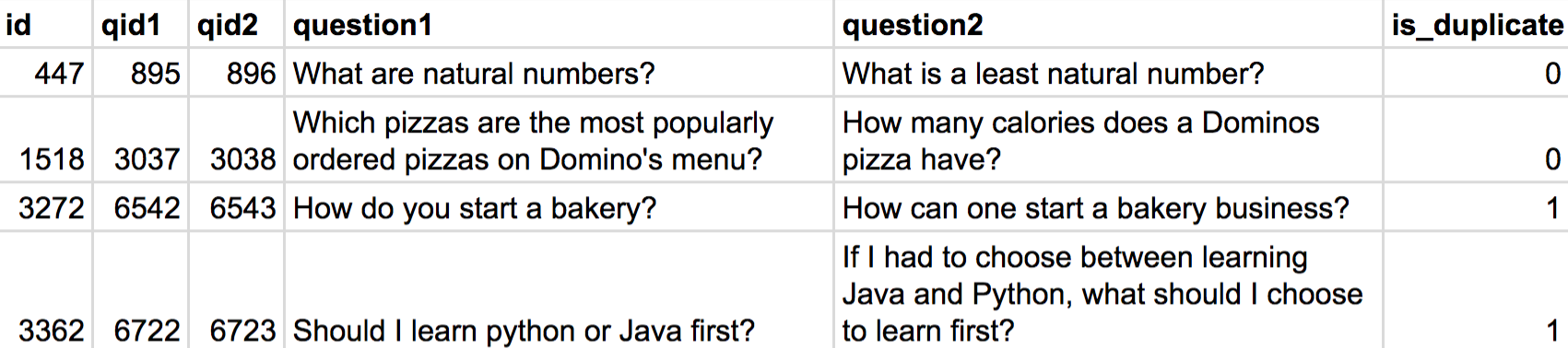

Quora Question Pairs

Quora Question Pairs(QQP)는 400,000개 이상의 질문 쌍으로 이루어져있습니다. 각 레코드는 쌍의 질문에 대한 ID, 개별 질문에 대한 전체 텍스트, 레코드에 실제로 중복 쌍이 포함되어 있는지 여부를 나타내는 이진 값이 포함됩니다.

"미국에서 가장 인구가 많은 주는 무엇입니까?"라는 쿼리와 "미국에서 가장 인구가 많은 주는 어느 주입니까?"는 사실상 같은 질의입니다. 따라서 대규모 질문 데이터가 중복될 경우의 비효율성을 완화시키는 자동화 작업은 매우 주요합니다.

본 데이터셋은 Quora 데이터를 기반으로 의미론적 동등성 모델을 훈련하고 테스트할 수 있는 환경을 마련해줍니다.

더 알아보기 : https://quoradata.quora.com/First-Quora-Dataset-Release-Question-Pairs

XLNet

XLNet은 BERT의 장단점을 개선한 모델입니다. BERT와 같은 사전학습 방식은 자동회귀언어 모델링 보다 더 나은 성능을 제공하지만, 마스킹된 위치 간의 종속성을 무시하고 사전 훈련-미세 조정 불일치를 일으킵니다.

- 인수분해 차수의 모든 순열에 대한 예상 가능성을 최대화하여 양방향 컨텍스트 학습을 가능하게 하고

- BERT의 한계를 극복하는 일반화된 자기회귀 사전 훈련 방법입니다.

양방향 컨텍스트를 모델링하는 기능으로 BERT와 같은 노이즈 제거 자동 인코딩 기반 사전 학습은 자동 회귀 언어 모델링을 기반으로 하는 사전 학습 접근 방식보다 더 나은 성능을 달성합니다. 그러나 마스크로 입력을 손상시키는 것에 의존하는 BERT는 마스킹된 위치 간의 종속성을 무시하고 사전 훈련-미세 조정 불일치로 어려움을 겪습니다.

자기회귀 공식 덕분입니다. 또한 XLNet은 최첨단 자기회귀 모델인 Transformer-XL의 아이디어를 사전 훈련에 통합합니다.

XLNet은 질의응답, 자연어 추론, 감정 분석 및 문서 랭킹 등의 많은 부문에서 SOTA 결과를 얻었습니다.

Keywords

Autoregressive Language Modeling

Transformer-XL

정말 상세한 글이네요. 하루만에 굉장히 정리 잘 하신 것 같습니다. 고생하셨습니다.