- Robot Learning from a Physical World Model

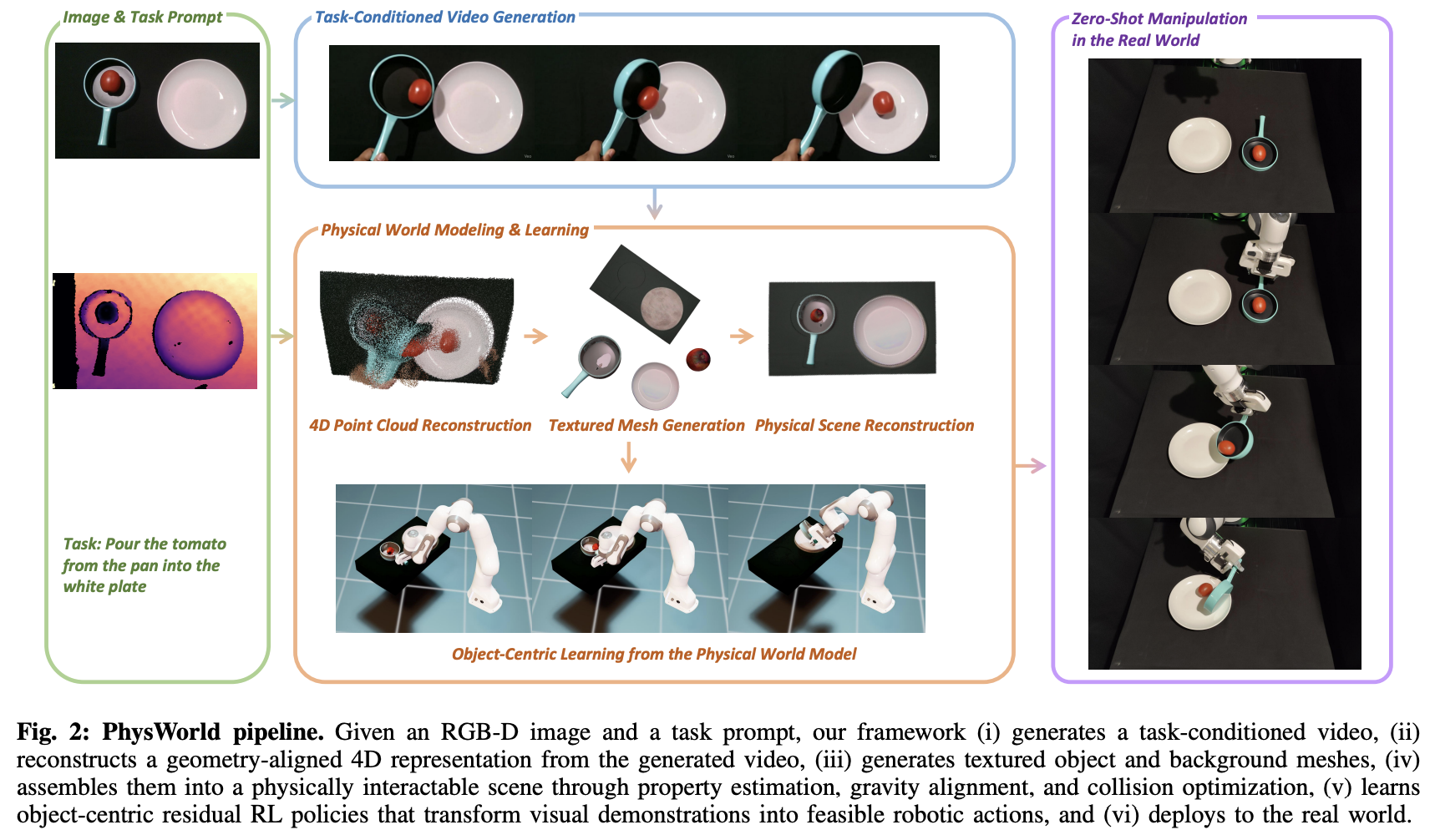

비디오를 따라 zero-shot으로 로봇의 움직임을 만드는 연구. 기존의 비디오 관련 로봇 연구는 많은 데이터가 필요하거나 사람의 개입이 필수적이었는데 이를 최소화하여 zero-shot으로 완성했다고 한다. 그럴 수 있는 핵심 아이디어는 object-centric residual reinforcement learning. 메소드를 보니 RGB-D (depth까지 4차원을 의미)를 입력으로 받고 이를 point cloud로 추격해 reconstruct하는 방식이다. 이를 object-centric residual RL(robust한 policy 대신 grasping and planning attempts를 반복해 baseline actions that narrow the search space를 가능하게 한다는데 그래서 학습에 시간이 아주 많이 들었다고 했다. 자세한 수식은 논문 참조!)로 시뮬레이션 후 real-world에서도 진행하여 정확도를 높였다.