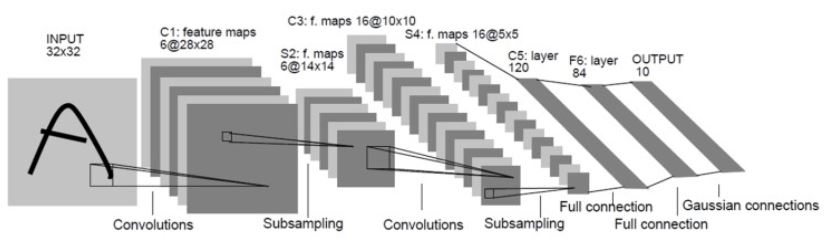

LeNet (1998)

- CNN의 기본 구조를 정립한 네트워크

- 오래된 네트워크지만 비교적 이후 세대에도 꾸준히 사용되는 구조인 Conv - Pooling (Subsampling) - Fully Connection 구조를 가지고 있다.

- tanh를 활성화 함수로 사용한다

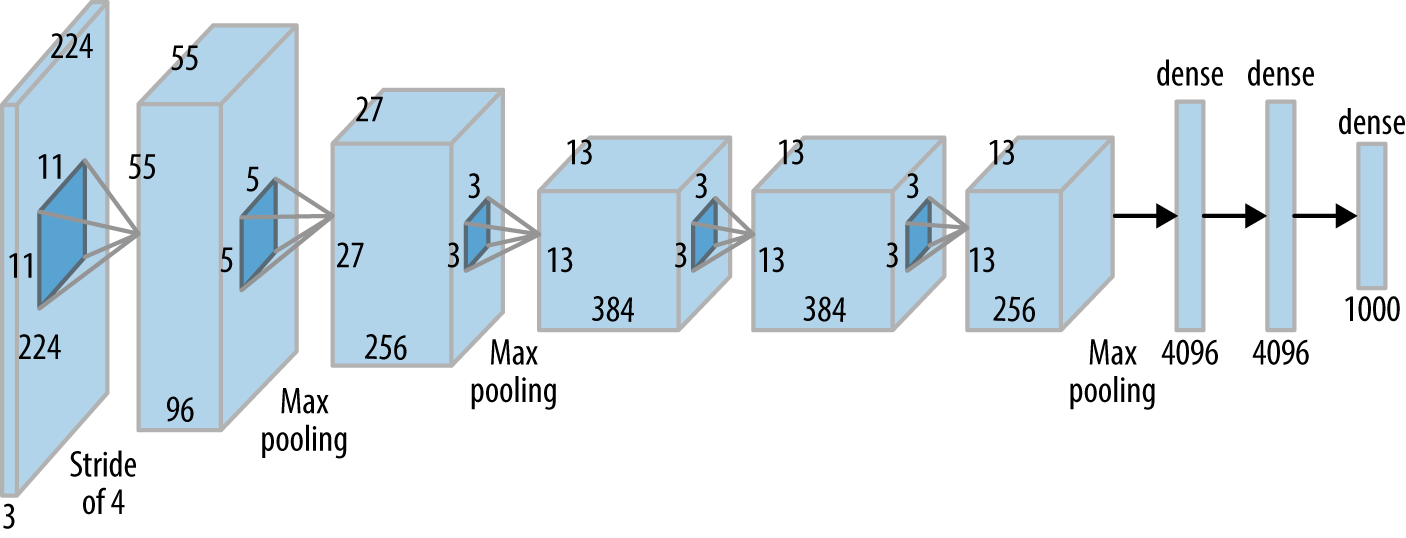

AlexNet (2012)

- 7개의 은닉층과 6천만개의 파라미터로 구성된 그 당시로서는 매우 deep한 네트워크

- Cross-GPU Parallelization : GPU 병렬 컴퓨팅 기법. 이때에는 그냥 설정만 하는 수준이 아니라 GPU 레이어에서 동작하는 단위 연산까지도 설계하는 수준이었다고 한다

- ReLU : 기존 tanh를 사용하는 기조에서 ReLU를 사용하여 학습 속도 향상

- LRN(Local Response Normalization) : 다른 피쳐맵의 동일 위치 픽셀 값들을 정규화하는 기법. Batch Normalization 이전의 정규화 기법

- Overlapping Pooling : 피처맵을 슬라이딩할 때 겹치는 영역이 있도록 설정

- Dropout : 오버피팅 방지를 위해 사용

CV 분야와 딥러닝 사이의 연결고리로 CNN이 적합하다는 것을 증명한 역사적인 네트워크

사용된 기법 하나하나가 후세대 모델 아키텍쳐에 영향을 주었다.

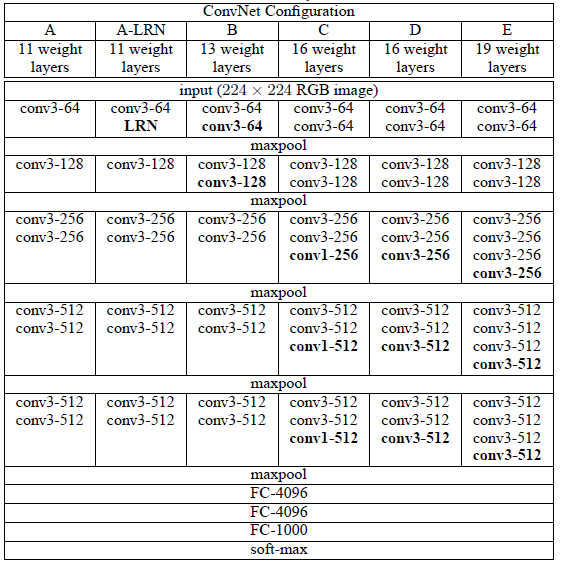

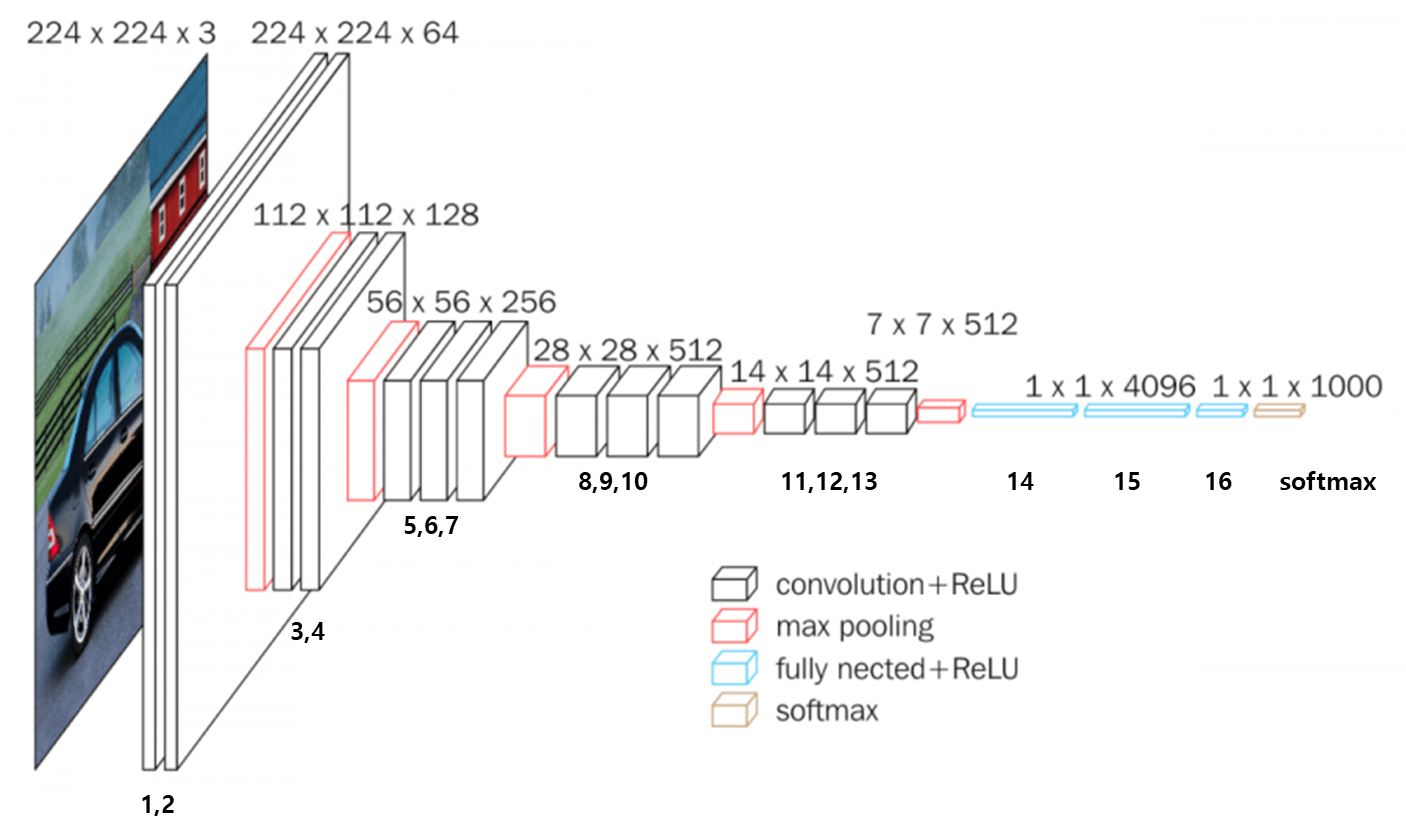

VGGNet (2014)

- 네트워크의 깊이를 깊게 만드는 것이 성능에 어떤 영향을 미치는지를 확인

- 필터의 커널 사이즈를 최대한 작게 3 x 3으로 구성하여 네트워크의 깊이를 깊게 만들었다.

- VGG에서 사용되던 Local Response Normalization(LRN) 에 대한 실험을 진행하여 별로 효과가 없음을 증명함

- 대표적인 네트워크 : VGG16

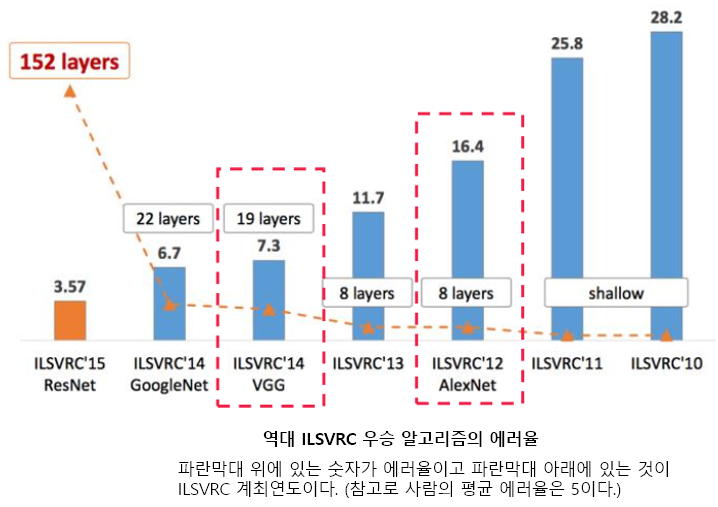

더욱 깊어지는 네트워크

AlexNet과 VGGNet을 거쳐서 점차 레이어 갯수가 늘어났고 ResNet에서는 무려 152개의 레이어나 사용된다.