모델 아키텍쳐

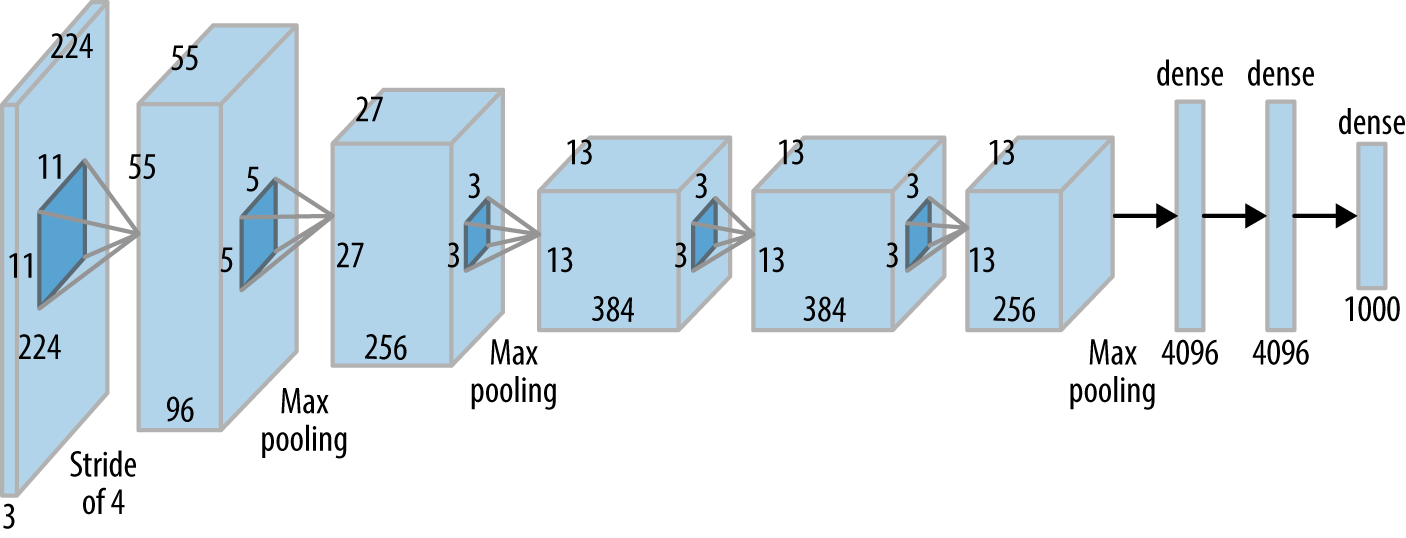

1.LeNet, AlexNet, VGG

CNN의 기본 구조를 정립한 네트워크오래된 네트워크지만 비교적 이후 세대에도 꾸준히 사용되는 구조인 Conv - Pooling (Subsampling) - Fully Connection 구조를 가지고 있다.tanh를 활성화 함수로 사용한다7개의 은닉층과 6천만개의 파라

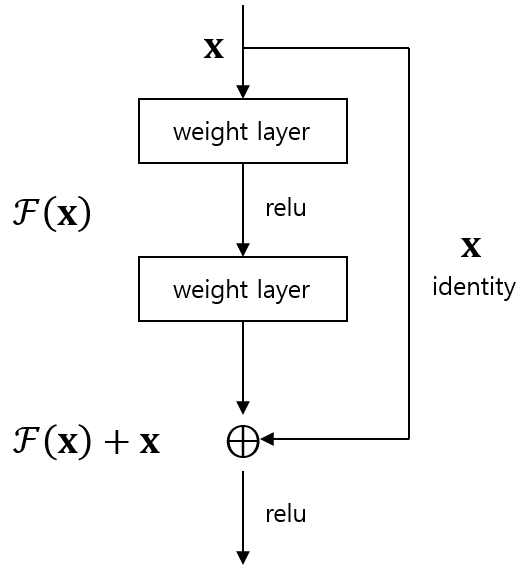

2.ResNet

VGG가 세상에 나온 이후로 점차 네트워크의 깊이가 깊어지게 되었는데, 네트워크가 깊어질수록 역전파시 미분을 더 많이 해야되므로 Vanishing Gradient 문제가 더 심화되었다.또한 네트워크가 깊어질수록 오버피팅도 아니고 언더피팅이 생기는 Degradation

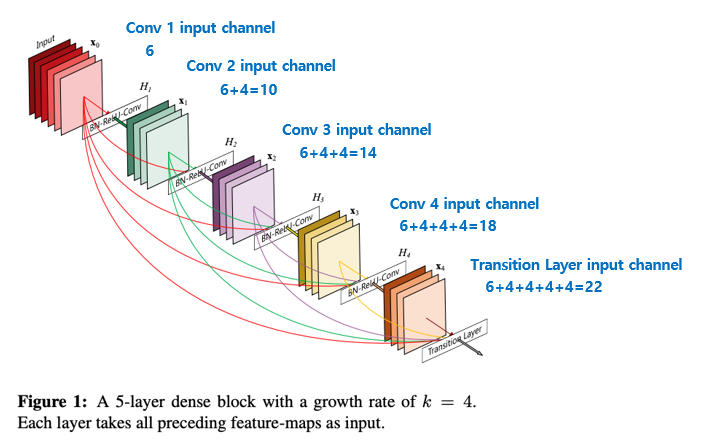

3.DenseNet

이름 그대로 Dense 하게 모든 레이어를 연결하는 네트워크이다. 깊이를 늘려나가는 방식 위주로 탐구되던 VGG와 skip connection 개념을 도입한 ResNet 이후에 만들어진 네트워크라서 특히 ResNet과 많이 비교된다. connectivity 논문에

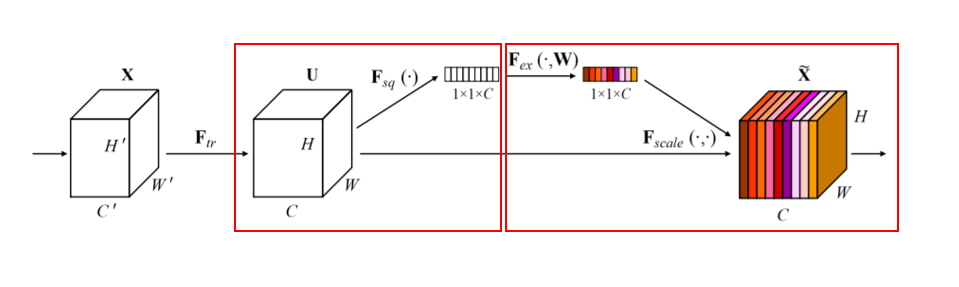

4.SENet

SENet에서 SE는 Squeeze, Excitation 을 의미한다.Squeeze = Global Average Pooling말 그대로 피쳐를 1차원 벡터로 압축한다. (7x7x512) 피쳐맵이라고 하면 GAP를 적용하여 (1x1x512) 형태가 된다.위에서 Sque

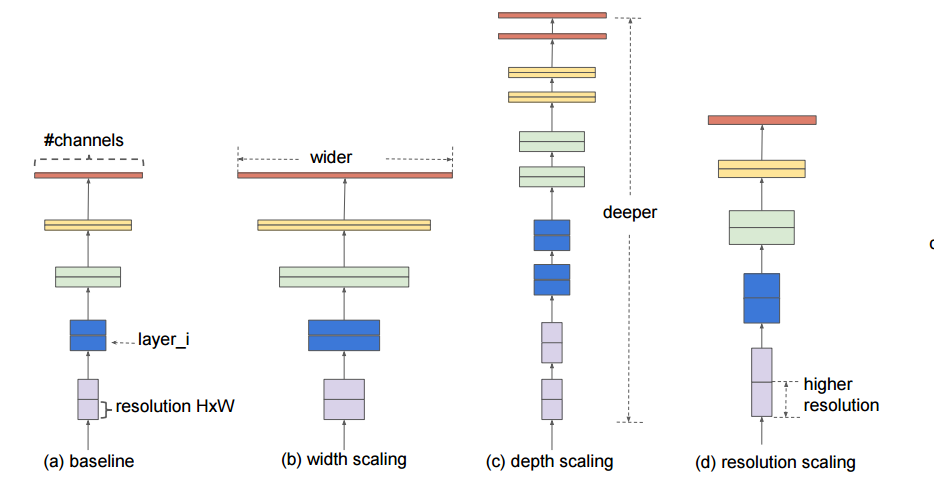

5.EfficientNet

EfficientNet의 핵심적인 접근 방식은 Depth, Width, Resolution 세가지의 factor를 일종의 Grid Search 방식을 이용하여 최적값을 찾아내고 이를 기반으로 학습하는 것이다.depth, width, resolution을 무한정 키울 수

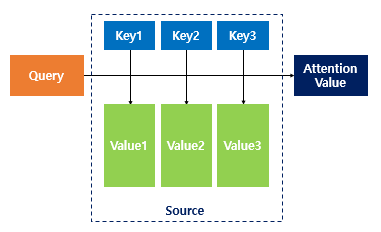

6.Attention

참고 : https://wikidocs.net/22893기계번역에서 기존에 사용되던 RNN 기반의 seq2seq는 문장이 길수록 품질이 떨어지는 문제가 있었는데, 이를 위해 인코더의 문장을 매번 참조하는 기법인 Attention이 등장하게 되었다.어텐션의 기본

7.Vision Transformer (ViT)

참고 : https://velog.io/@pre_f_86/Vision-TransformerViT-%EB%85%BC%EB%AC%B8-%EB%A6%AC%EB%B7%B0 & ChatGPT이미지 패치 분할 및 Flatten이미지는 여러 개의 작은 패치로 분할됩니다.