Keywords: Authorship verification, Linguistically Informed Prompting(LIP), Large language models

논문: https://arxiv.org/pdf/2403.08213v1

코드: https://github.com/baixianghuang/authorship-llm?tab=readme-ov-file

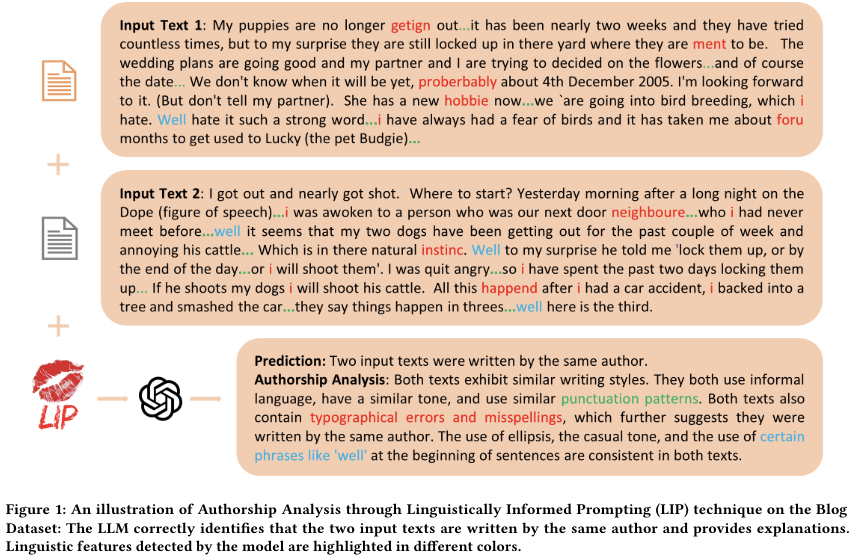

- 개요: LLM이 도메인 특화된 미세 조정 없이도 저자 검증과 할당 작업에서 뛰어난 성능을 발휘할 수 있음을 보여주며, 새로운 언어 지침 기법인 Linguistically Informed Prompting (LIP)을 제안

- 연구질문

- LLM이 제로샷, 엔드투엔드 방식의 저자 검증을 효과적으로 수행할 수 있는가?

- LLM이 여러 후보 저자(예: 10명 및 20명) 중에서 저자를 정확하게 할당할 수 있는가?

- LLM이 저자 분석에서 언어 특성의 역할을 통해 설명 가능성을 제공할 수 있는가?

- 실험설정

- 저자 검증 및 할당: 각 데이터셋에서 저자 검증과 할당 작업을 위한 텍스트 쌍을 균형 있게 준비했습니다. 실험은 세 번 반복하여 평균 점수를 계산했습니다.

- 기준 모델: TF-IDF, BERT 기반 모델, RoBERTa, DeBERTa, ELECTRA와 같은 다양한 사전 훈련된 언어 모델을 사용하여 성능을 비교했습니다.

- 평가지표

- 정확도(Accuracy): 전체 예측 중에서 올바른 예측의 비율을 측정.

- 정밀도(Precision): 양성 예측 중에서 실제 양성의 비율을 측정.

- 재현율(Recall): 실제 양성 중에서 올바르게 예측된 양성의 비율을 측정.

- F1 점수: 정밀도와 재현율의 조화 평균을 계산.

- 방법론

- 언어 모델의 활용: 대규모 언어 모델(LLM)을 사용하여 도메인 특화된 미세 조정 없이 제로샷 저자 검증 및 할당 작업을 수행했습니다. LLM은 다양한 저자의 글쓰기 스타일을 파악할 수 있는 능력을 가지고 있습니다.

- Linguistically Informed Prompting (LIP): 언어적 특징을 강조하여 LLM이 더 정확한 저자 분석을 수행하도록 안내하는 새로운 기법을 제안했습니다. LIP는 텍스트의 구문적 특징, 희귀 단어, 유머, 비꼼, 오탈자 등을 분석하여 저자를 식별합니다.

- 프로세스 설명

- 무지도(No Guidance): 기본 작업 설명만 제공.

- 약간의 안내(Little Guidance): 주제 차이를 고려하지 않도록 추가 지침.

- 문법 안내(Grammar Guidance): 문법적 스타일에 집중하도록 지침.

- LIP: 문법적 스타일 외에도 구체적인 언어적 특징을 분석하도록 지침

Figure: