1일1논문

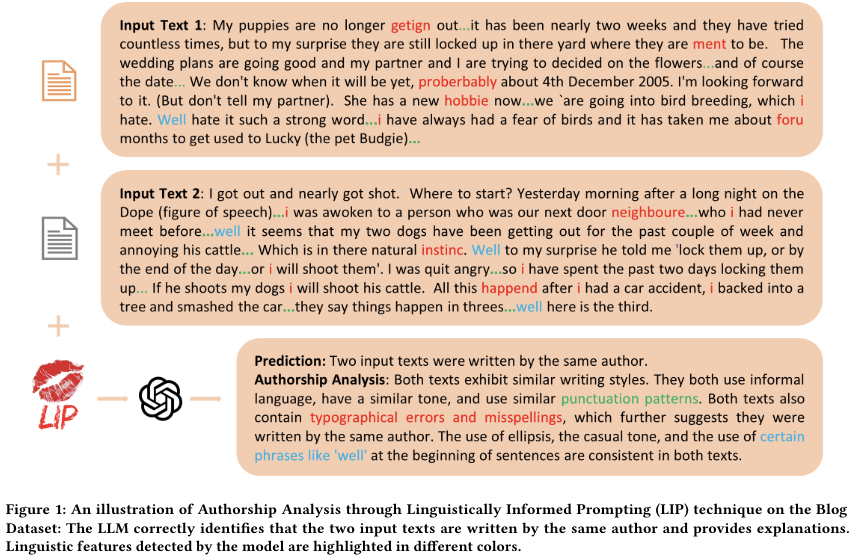

1.Can Large Language Models Identify Authorship? (240703)

논문: https://arxiv.org/pdf/2403.08213v1코드: https://github.com/baixianghuang/authorship-llm?tab=readme-ov-file논문 개요:개요: LLM이 도메인 특화된 미세 조정 없이도

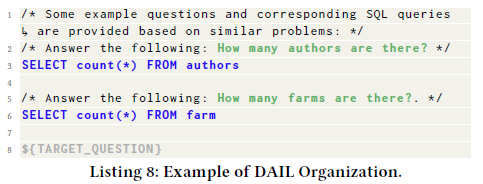

2.Text-to-SQL Empowered by Large Language Models: A Benchmark Evaluation(240704)

논문:https://paperswithcode.com/paper/text-to-sql-empowered-by-large-language 코드: https://github.com/beachwang/dail-sql 요약: 효율적이고 경제적인 LLM 기반 Text-to-S

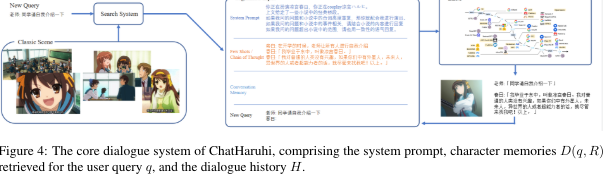

3.ChatHaruhi_Reviving Anime Character in Reality via Large Language Model(240705)

논문: https://arxiv.org/abs/2308.09597 깃허브: https://github.com/LC1332/Chat-Haruhi-Suzumiya 코드 및 설명 참조: https://zhuanlan.zhihu.com/p/671966233?utm_id=0

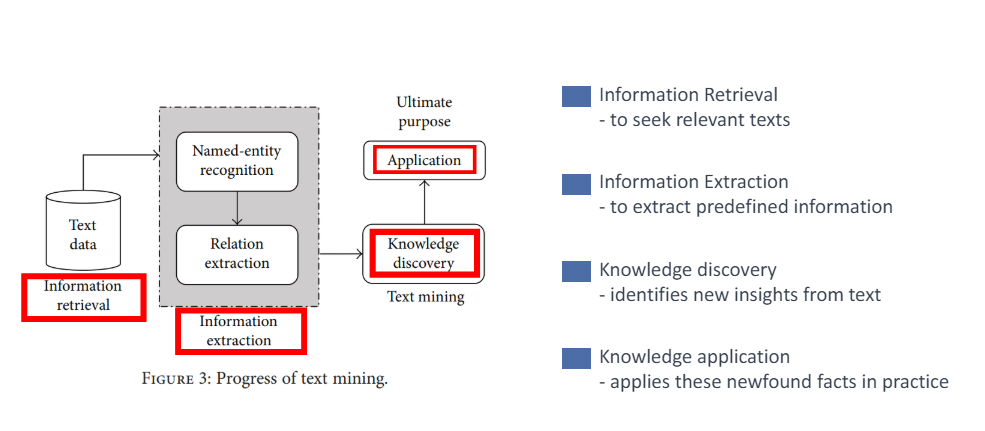

4.Data Processing and Text Mining Technologies on Electronic Medical Records: A Review (240706)

논문: https://pubmed.ncbi.nlm.nih.gov/29849998/발표자료:

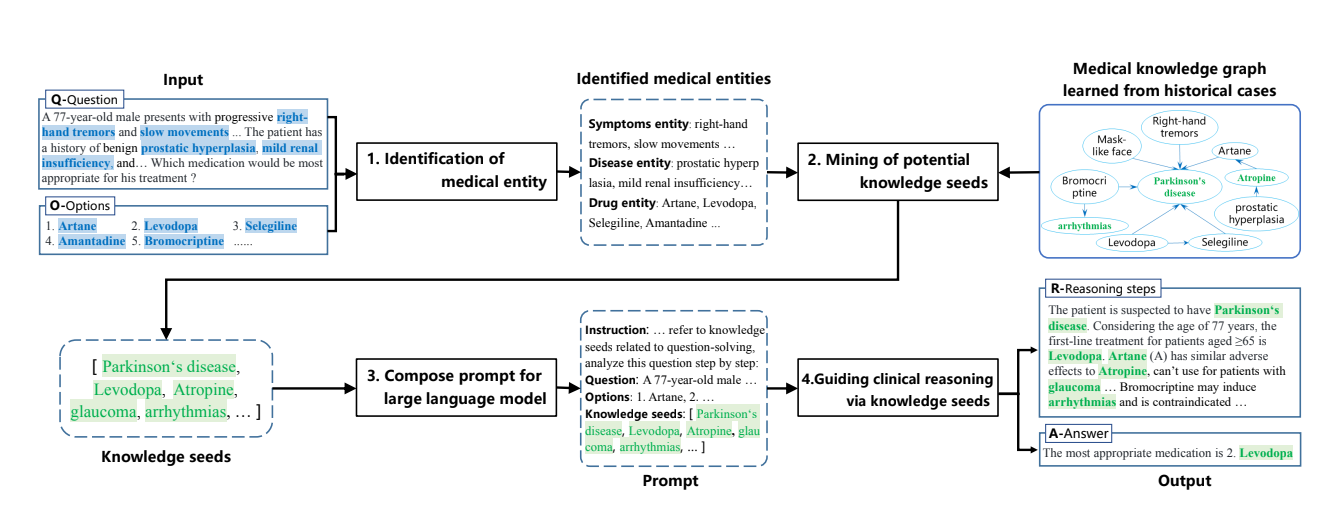

5.Guiding Clinical Reasoning with Large Language Models via Knowledge Seeds(240707)

논문: https://arxiv.org/abs/2403.06609발표자료(made by me):https://drive.google.com/file/d/1YN11uF1DpwRB_m2LxbYINjukcFMFGkk4/view?usp=drive_link

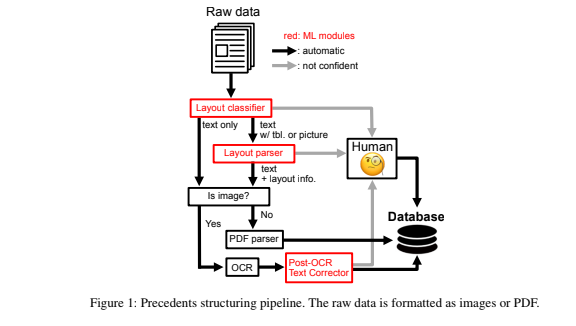

6.A Multi-Task Benchmark for Korean Legal Language Understanding and Judgement Prediction(240708)

논문: https://arxiv.org/abs/2206.05224 발표(made by me): https://drive.google.com/file/d/1KPgAnVD9vzAWy1GT4ZexPwOXhffAtytV/view?usp=drive_link

7.LLM Evaluation Part2. Mechanics Behind LLM Scoring Systems(0709)

원문: https://www.upstage.ai/feed/product/llm-evaluation-part2-evaluation-mechanisms 우리 task적용 결과: Prompt 아래의 instruction과 constraint에 근거하여서, [Answer

8.Next-Generation Databse Interfaces: A Survey of LLM-based Text-to-SQL(240901)

논문: https://arxiv.org/pdf/2406.08426개요:이 논문에서는 먼저 Text-to-SQL 연구의 기술적 도전과 진화 과정을 간략히 개요한 후, Text-to-SQL 시스템을 평가하기 위해 사용되는 데이터셋과 평가 지표를 소개합니다. 이후

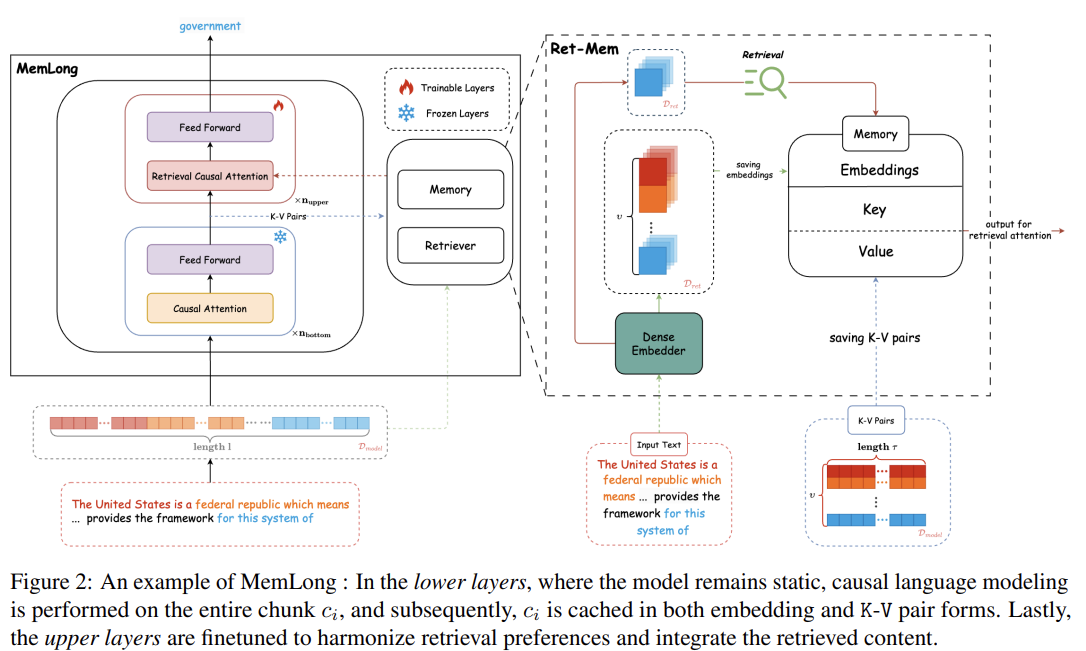

9.MemLong: Memory-Augmented Retrieval for Long Text Modeling(240909)

논문: https://arxiv.org/abs/2408.16967?utm_source=substack&utm_medium=email코드:https://github.com/Bui1dMySea/MemLong이 논문은 MemLong이라는 모델을 소개하고 있

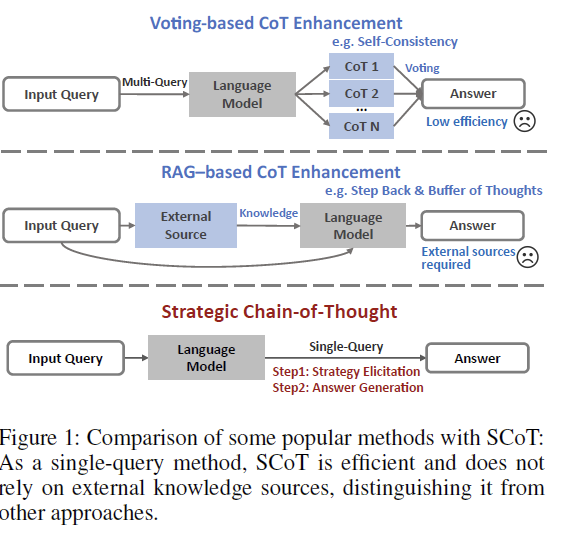

10.Strategic Chain-of-Thought: Guiding Accurate Reasoning in LLMs through Strategy Elicitation

논문: https://arxiv.org/abs/2409.03271v1?utm_source=substack&utm_medium=email기존문제:CoT는 LLM의 추론 능력을 향상시키는 데 널리 성공적이었으나, 생성된 추론 경로의 품질이 일관되지 않아 복잡한 추

11.LLM 모델이 LLM 성능을 평가한다. LLM-as-a-judge 알아보기

https://devocean.sk.com//blog/techBoardDetail.do?ID=166628

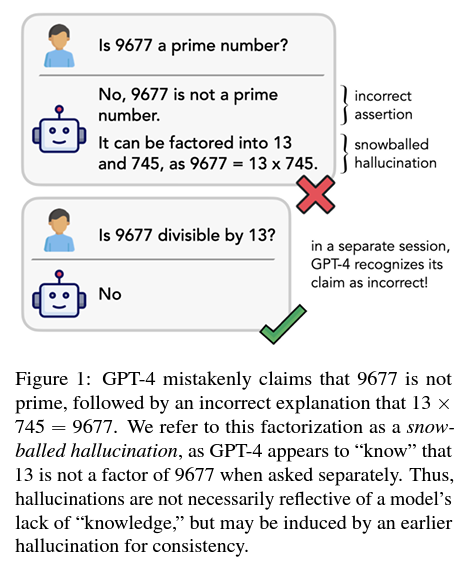

12.HowLanguage Model Hallucinations Can Snowball

언어 모델의 환각(hallucination) 현상이 눈덩이처럼 커지는 현상을 연구한 논문입니다. ChatGPT와 GPT-4가 잘못된 답변을 한 후, 그 답변을 정당화하기 위해 추가적인 잘못된 주장을 하는 현상을 발견했습니다.Introduction:언어 모델이 실제 응용

13.밑바닥부터 Kanana LLM 개발하기: Pre-training

https://tech.kakao.com/posts/661