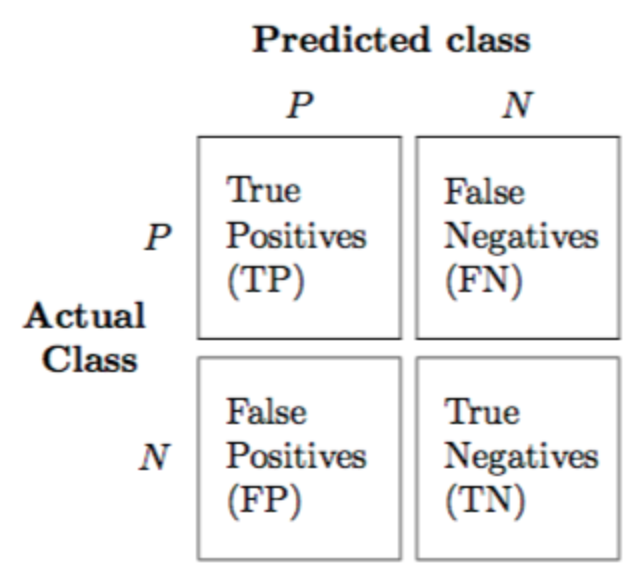

Confusion Matrix(혼동행렬)

- True Positives : True인 레이블을 True라고 예측한 경우를 True Positives라고 한다.

- False Negatives : True인 레이블을 False라 하는 경우를 False Negatives라고 한다.

- False Positives : False인 레이블을 True이라 하는 경우를 False Positives라고 한다.

- True Negatives : False인 레이블을 False이라 하는 경우를 True Negatives라고 한다.

혼동행렬 지표를 통해 분류 기능 측정

정확도(Accuracy)

모델이 얼마나 데이터를 잘 분류했느냐, 즉 분류의 결과가 얼마나 잘 예측하였는가를 측정하는 것입니다.

클래스의 개수가 불균형할 경우 신뢰도가 떨어진다는 단점이 있습니다.

정밀도(Precision)

True라고 분류되어진 데이터 중에 실제 True의 비율을 구하는 지표입니다.

재현율(Recall)

실제 True인 데이터들 중 True라고 잘 예측했는지 평가하는 지표입니다.

Precision과 Recall는 둘다 0.0 ~ 1.0사이의 값을 가지며 높을수록 좋습니다.

Precision이 1.0이라는 의미는 False Positive가 0건이라는 의미입니다.

Recall이 1.0이라는 의미는 False Negative가 0건이라는 의미입니다.F1-score

- Precision과 Recall의 조화평균(산술평균 아님을 주의)을 이용한 F1 Score를 이용하여 구할 수 있습니다.

F1 Score는 0.0 ~ 1.0 사이의 값을 가지며 높을수록 좋습니다.

ROC Curve와 AUC

-

ROC 커브와 x축이 이루고 있는 면적의 넓이를 AUC(Area Under Curve)

-

AUC의 값이 1에 가까울수록 효율적인 모델이라고 할 수 있다.

-

x축 FPR(False Positive Rate)

- 틀린것을 맞았다고 잘못 예측한 수치를 나타낸다.

- 틀린것을 맞았다고 잘못 예측한 수치를 나타낸다.

-

y축 TPR(True Positive Rate)

- 맞은것을 맞았다고 잘 예측한 수치를 나타낸다.

= Recall

- 맞은것을 맞았다고 잘 예측한 수치를 나타낸다.