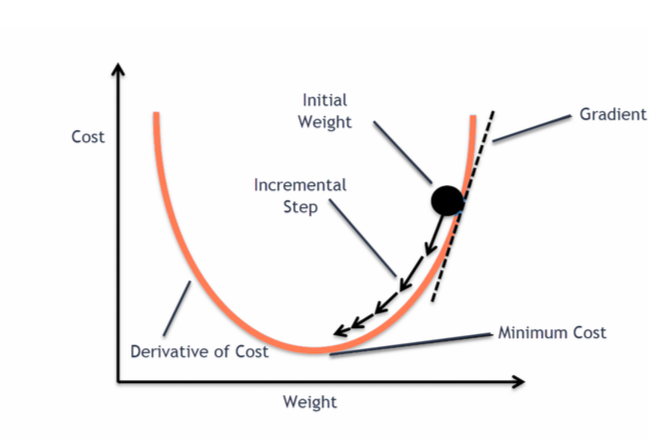

* GD 란? 경사하강법으로 cost function 이 최소가 되는 방향으로 이동하는 것.

cost function이란 (실제값-예측값)^2이다.

(과정) 기울기를 계산해서 cost function (SSE) 이 줄어드는 방향으로 가는 parameter로 업데이트 한다. 이 과정이 backpropagation 이다.

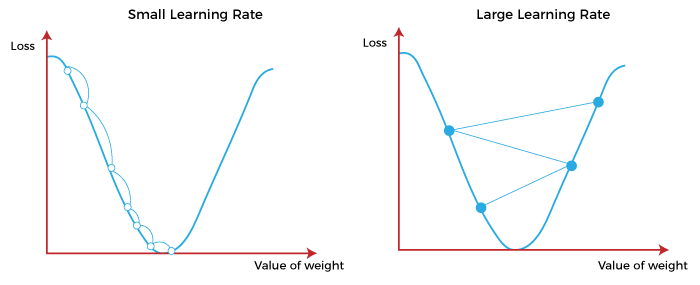

*learning reate 차이

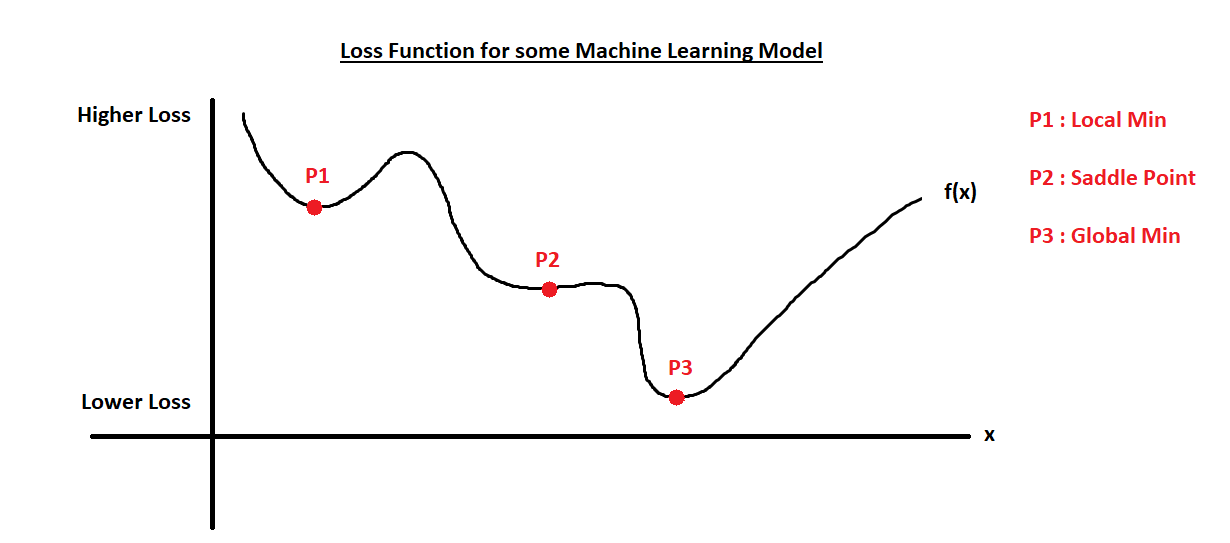

* GD의 problem 1

1) Saddle Point : 기울기가 0인데 최소랑 최대가 아닌 것.

-> Solution : GD의 다양한 변형 (종류) 는 saddle point을 벗어나는데 어느정도 도움을 준다.

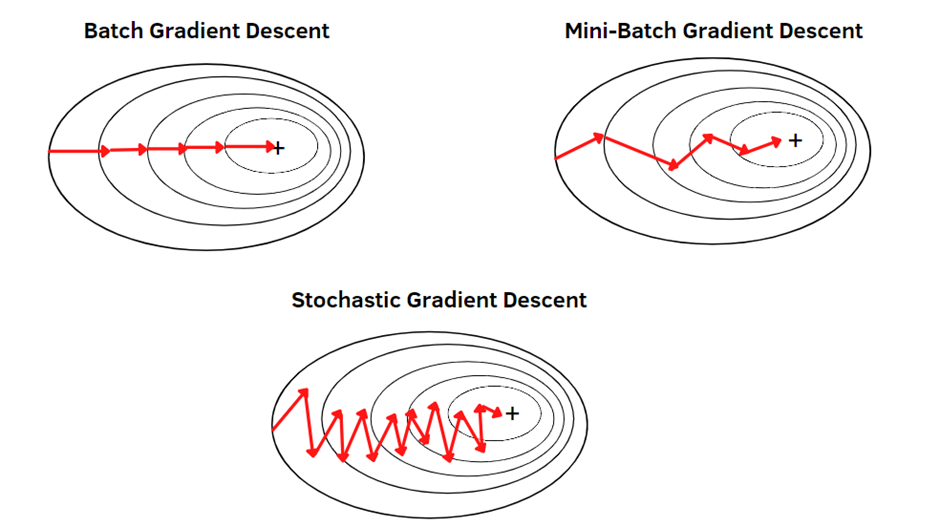

1. Batch Gradient Discent

- 한번 업데이트 때 전체 데이터 셋을 계산, 느리다.

2. Stochastic GD

- 한번 업데이트 때 랜덤으로 싱글 데이터 포인만 사용

3. Mini-Batch GD

- 여러 데이터 포인트를 묶은 작은 배치를 사용

* GD의 problem 2

2) Vanishing gradient (사라지는 기울기, 기울기를 매우 작게 만들어서 기울기가 제대로 업데이트 되지 않는 문제 )

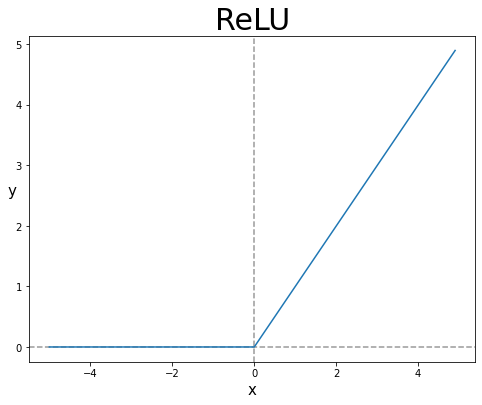

-> Solution : RELU 등 존재

- RELU란?

0보다 크면 그대로 사용

0이랑 음수는 0