Extreme View Synthesis (Aug 2019)

https://arxiv.org/pdf/1812.04777.pdf

Abstract

Extreme View Synthesis는 적은 수의 서로 다른 Viewpoint Image로 novel view synthesis를 수행한다.

Introduction

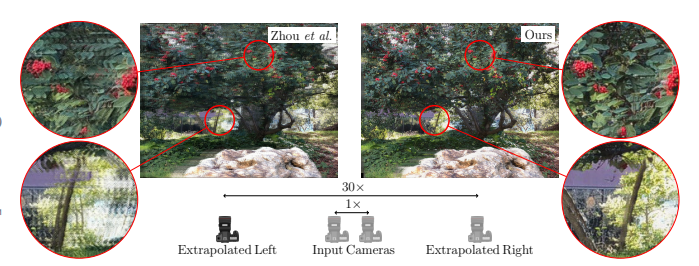

논문의 목표는 최소 두 대의 입력 카메라를 사용하여 새로운 Viewpoint을 추정하고자 하는 것이다. 기존 SOTA가 4.5배까지 Extrapolation을 수행한 것에 비해 본 논문은 아래와 같이 Extrapolation을 30배까지 더 추진한다.

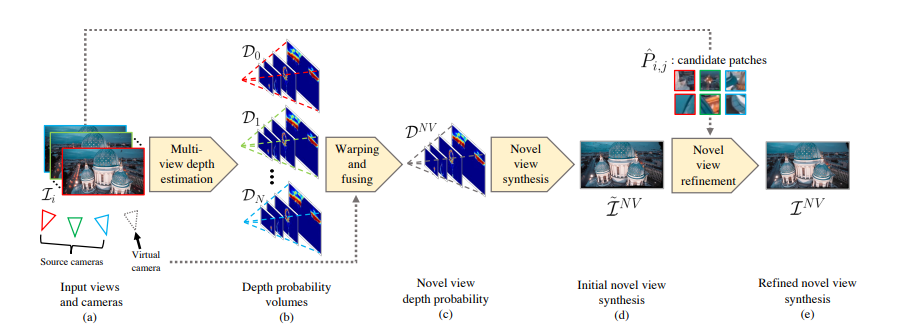

이를 위한 두가지 핵심 아이디어가 있다. 첫째는 exact depth estimation 대신 depth probability volumes를 사용하는 것이다. 둘째는 Image Refine Network에서 depth probability volumes에 따른 sampling patches를 통해 scene의 explicit Information을 활용하는 것이다. 이 두 개념을 결합함으로써, Interpolation과 Extrapolation과 같은 가상의 Extreme View Synthesis의 quaility를 향상시켰다.

Method

Extreme View Synthesis의 과정은 이러하다. 우선 input views(a)로 부터, 각 view마다 depth probability volumes를 생성한다(b). 그 후 주어진 novel view camera pose로 warping과 input depth volumes fusion의 과정을 거쳐 novel depth probability volume을 생성한다(c). 그 후 임시 novel view syntheiss를 수행한다(d). 마지막으로 depth distribution에 기반한 candidate patches의 Image refinement를 통해 Quaility를 높인다(e).