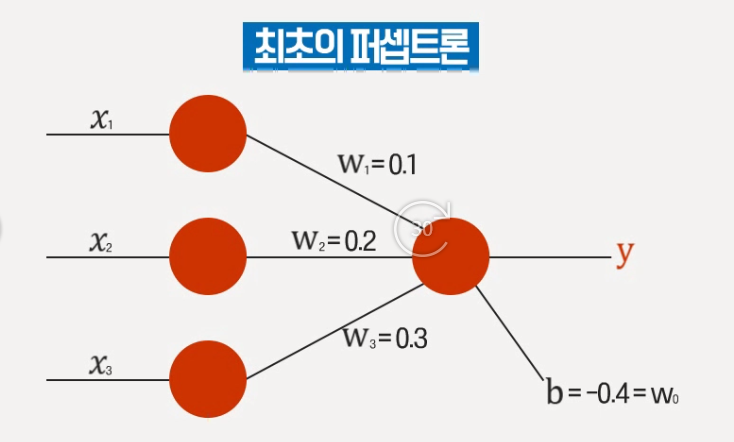

sign 함수

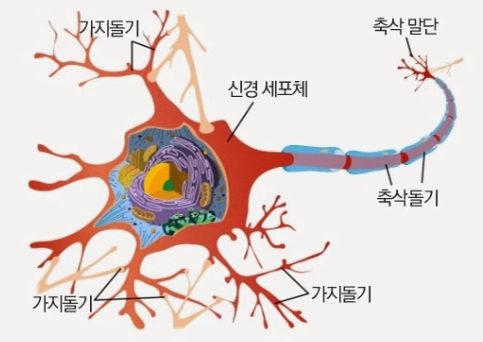

: 최초의 신경망의 활성화 함수

이 값이 어느정도 이상이되면 출력이 되지만 아니면 무시됨

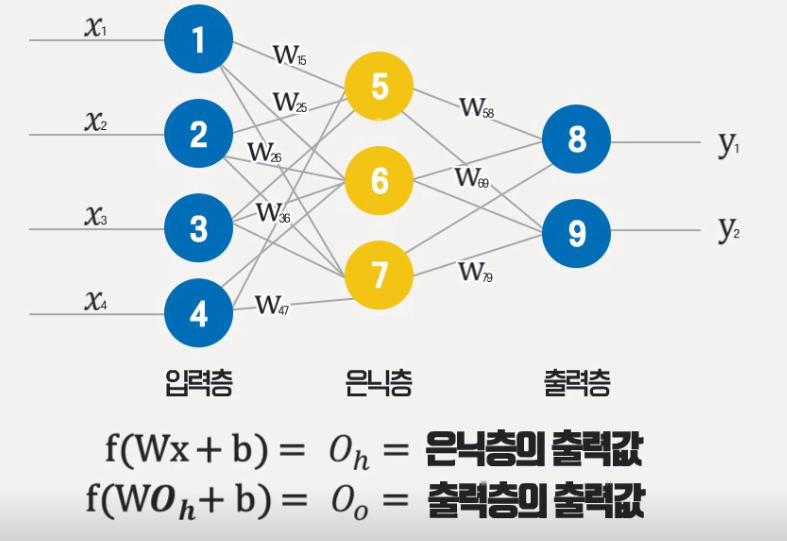

이론적으로 거의 모든 다항식으로 설명할 수 있게 됨

활성화 함수의 종류

-

사인 함수

-

스텝 함수

-

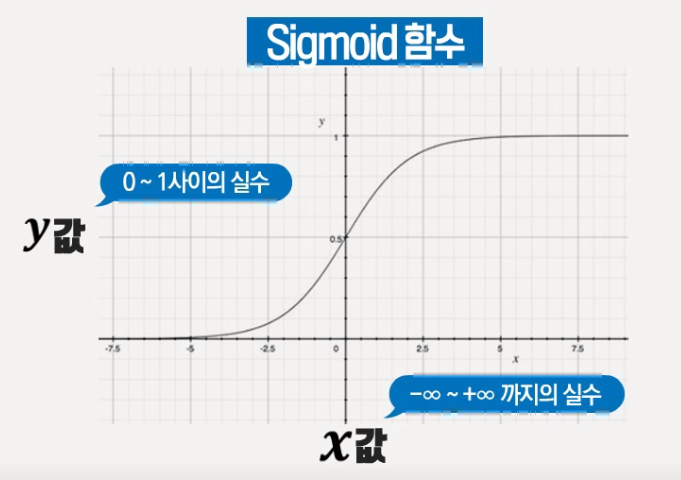

시그모이드 함수 : 신경망에서 사용

-

소프트 맥스 함수

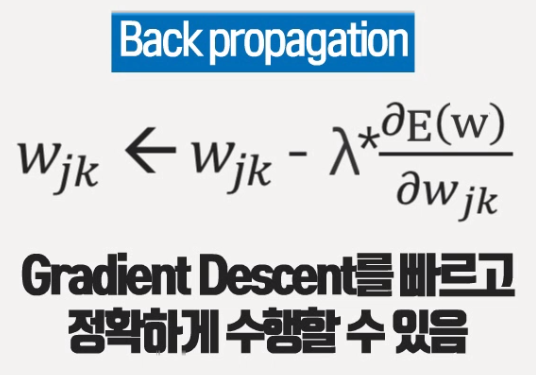

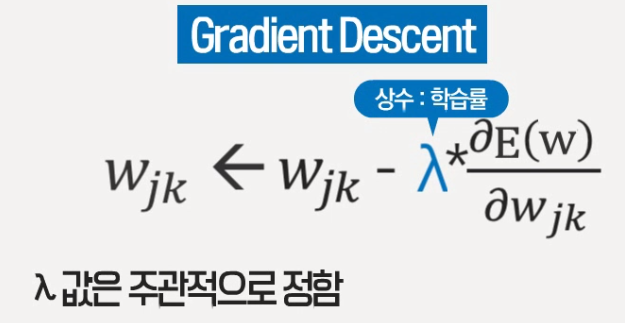

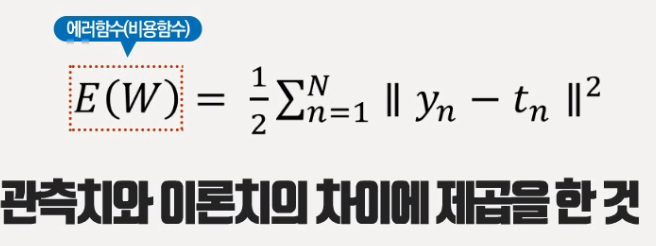

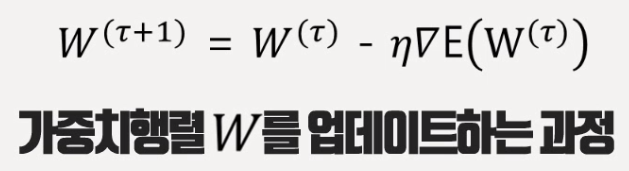

Gradient Descent

반복을 통해 w가 원하는 값으로 최적화 됨

에포크 (반복하는 개수)

: w가 점점 최적화가 되어서 에러함수가 점점 0에 가깝게 함

w에 대한 E의 기울기

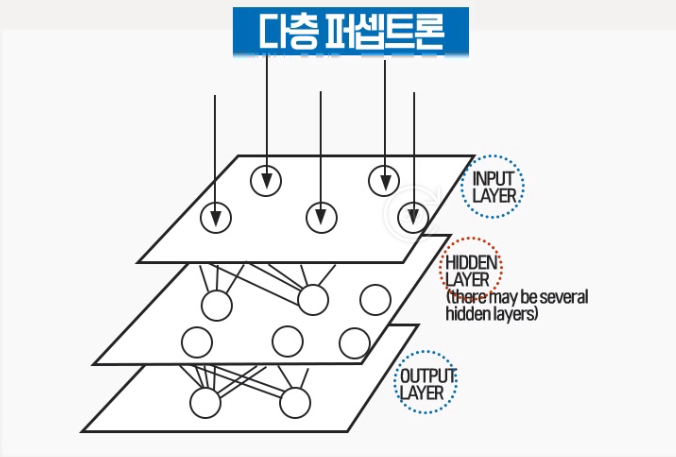

레이어가 여러개 있는 경우 속도가 느려짐. 이 문제를 해결하기 위해 Back Propagation이 있다.