순환신경망

- 순환신경망의 등장 배경

- 기울기 소실 문제

- 해결책으로서의 LSTM (Long short-term memory)

- 실제 직관 사례

- LSTM 변형 모델

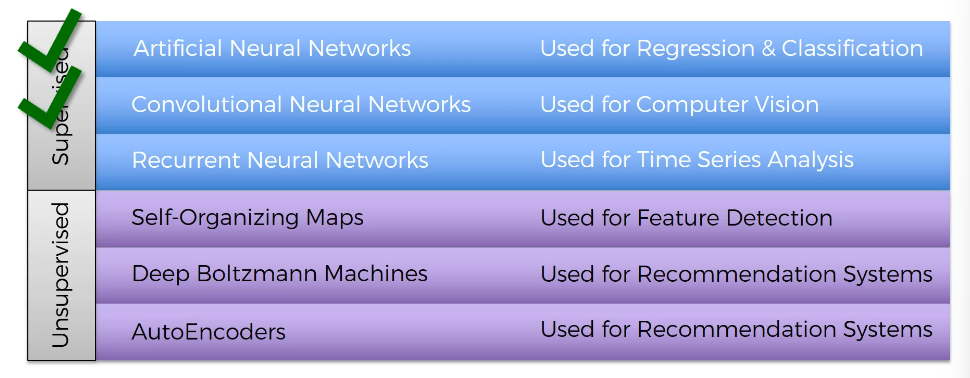

Recurrent Neural Networks

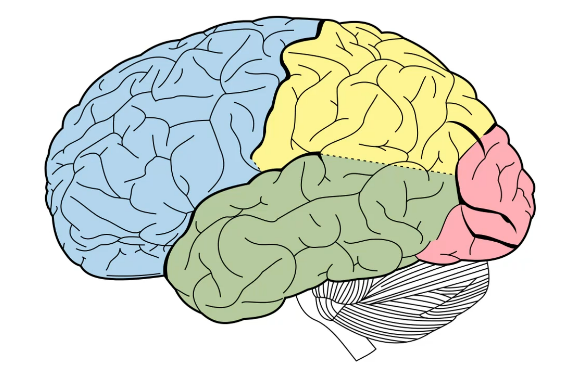

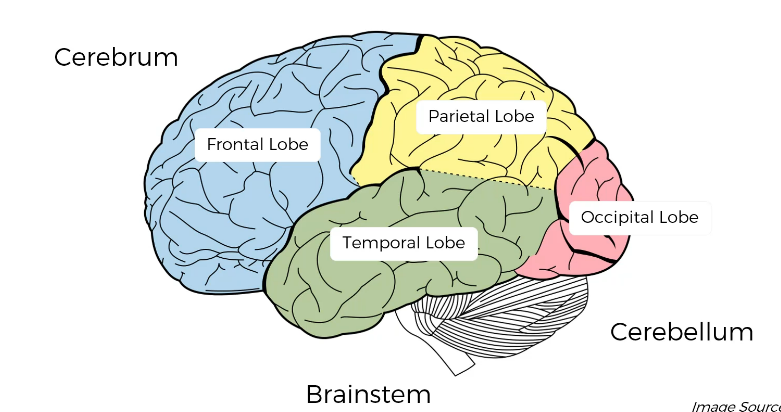

딥러닝은 당연히 인간 뇌가 진화해온 과정에서 착안하기도 했다.

- 대뇌

- 소뇌

- 뇌간이 있고 대뇌는 저 4부분 모두에 속한다.

ANN 에서 가장 중요한 것은 가중치이다. 이전 관측을 통해 학습할 수 있다는 사실이 중요한 것. 가중치는 장기기억을 나타낸다. 어떤 입력값을 넣어도 어제, 오늘, 내일 같은 방식으로 처리하는 것! 특히나 이러한 장기기억을 담당하는 것이 Temporal Lobe 측두엽이다. (ANN 이 측두엽과 유사하다는 결로)

CNN 은 이미지, 물체를 보고 인식하는 후두엽(occipital Lobe) 에 속한다.

RNN 은 단기기억에 속한다. Frontal Lobe 전두엽에 대부분이 들어있다.

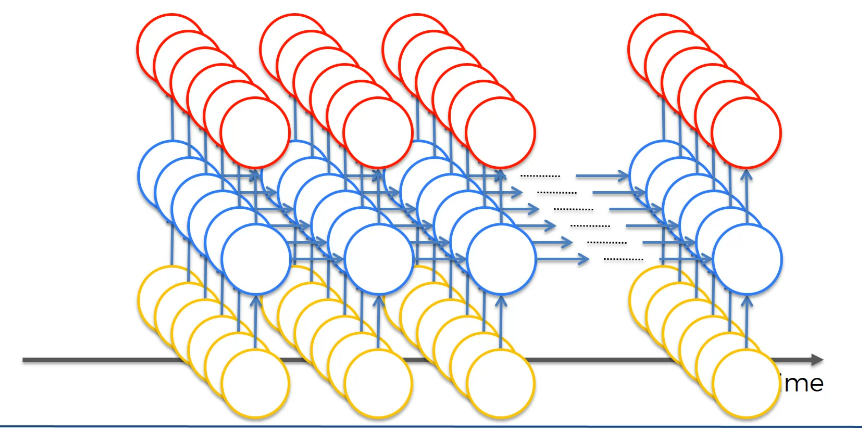

다시 단순한 NNs 로 넘어가보자. RNN 은 무슨 일을 하고 어떻게 재현할까?

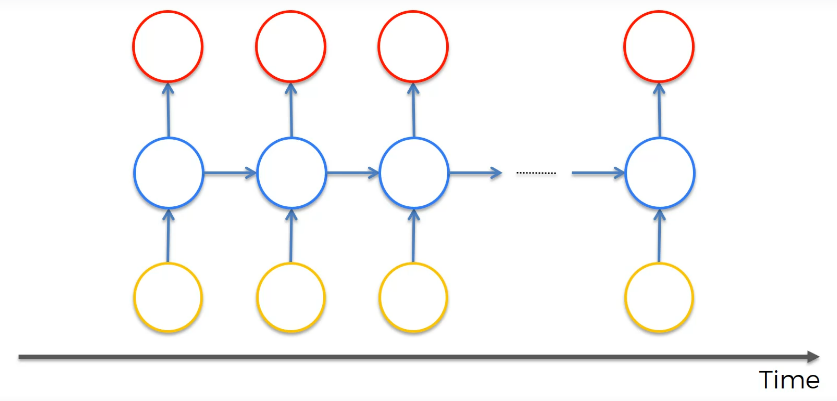

기본적인 신경망을 압축하자. (아래에서 본 모습처럼, 본래 신경망은 그대로이다.) 이를 세로로 돌리고, 은닉층(푸른색)에 타임루프를 추가한다. 은닉층이 출력값을 내고 자기 자신에게도 공급한다는 것. 그리고 이를 시간에 따라 펼친 것이 CNN 이다.

위에 해당하는 원은 한 개의 뉴런이 아닌 수많은 뉴런으로 이루어진 전체 층(1번째 사진이 원본이지만 간략화하여 두 번째로 다룬다.)이다. 위처럼 뉴런은 시간을 통해 자기 자신과 연결되어 있다. (= 단기기억, 미래에 정보를 스스로 전달하고 분석)

여기엔

-

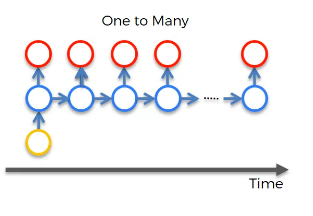

일대다 관계 (컴퓨터가 이미지를 설명하는 사례)

하나의 사진 인풋이 들어오면 가중치, 특성인식 시스템, 필터 등 CNN 에 필요한 모든 것을 도출하고 RNN이 문장을 다듬는 방식이다. -

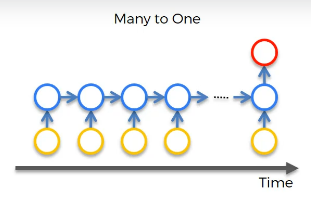

다대일 관계 (감성 분석)

텍스트의 분량이 많을 때 긍정, 부정, 어느 정도로 긍부정인지 나타낸다. -

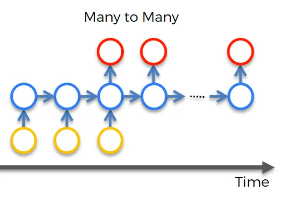

다대다 관계(번역,영화 프레임 설명)

다음에 오는 단어를 번역하려면 이전 단어에 대한 정보를 가져오는 것. (단어의 성별 정보) RNN 이 여기서 단기기억을 가지고 번역을 수행할 수 있다.

[Ars technica : Movie written by algorithm]

벤자민이 만든 자연스러운 문장을 감상해보자. (문장과 문장의 연결이 자연스럽지 못하다.)