Self-supervised learning (SSL) 을 공부하기 앞서, 큰 그림을 보려고 survey 논문을 가볍게 스키밍했다. SSL 에 크게 관심이 있지는 않았는데 친구들이랑 같이 공부하는게 좋아서 시작했다. 시작하고보니 연구 주제도 떠오르고, 잘한 것 같다.

1. Introduction

SSL 을 한 문장으로 정의하면, "인풋의 일부를 예측" 하는 것이다.

In the invited speech on AAAI 2020, The Turing award winner Yann Le Cun described self-supervised learning as ”the machine predicts any parts of its input for any observed part”.

2. Motivation of SSL

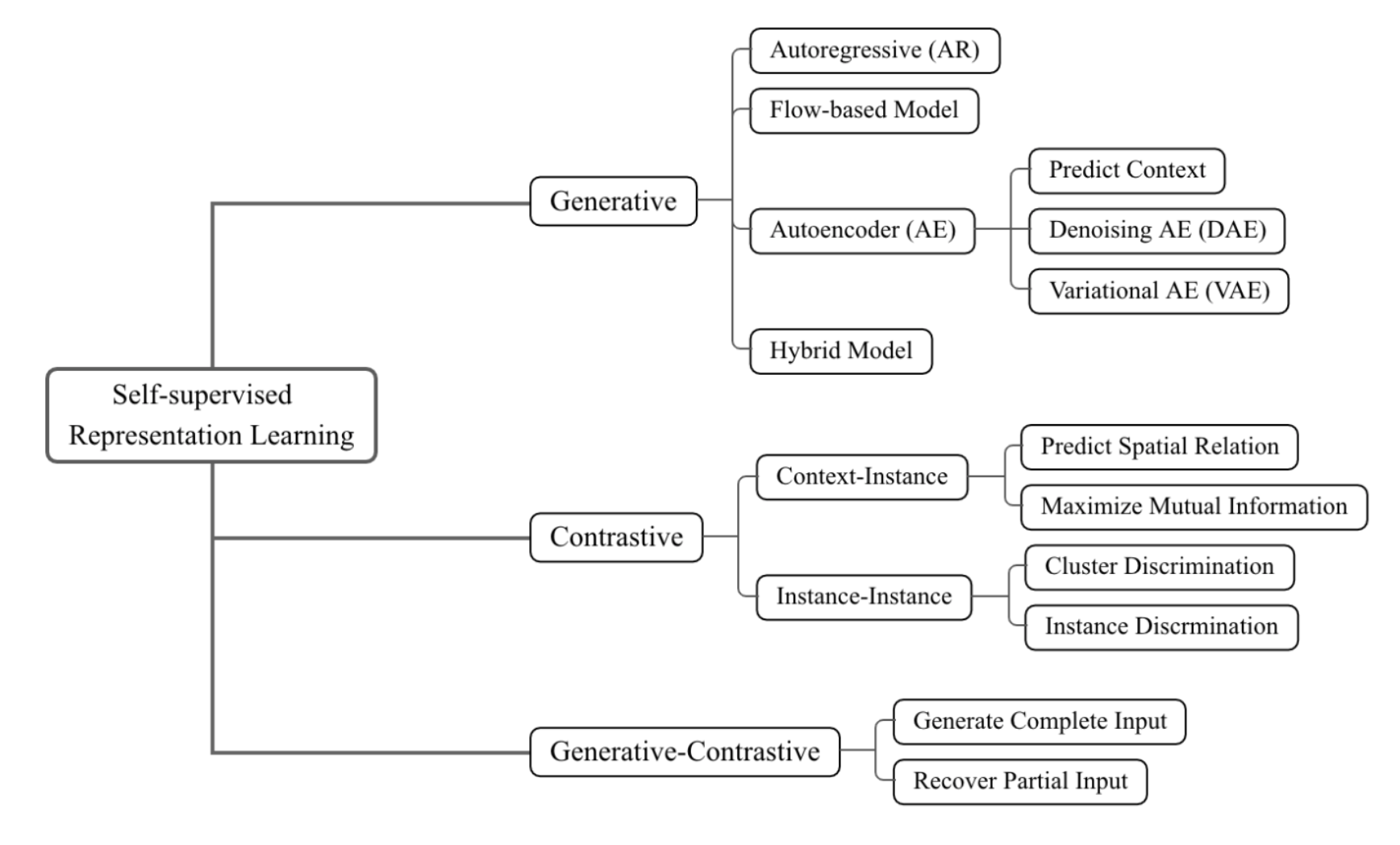

앞으로 크게 두 축을 볼 것이다.

Contrastive : SSL 하면 MoCo, SimCLR 가 바로 떠오를텐데 얘네는 SSL 중에서도 contrastive learning 에 속한다.

Generative : NLP 에서 BERT(AE), GPT(AR) 스타일을 생각하면 된다. 요새 비전 분야에서도 contrastive learning 에서 이쪽으로 넘어오고 있는 것으로 보인다. 차차 리뷰할 것이다.

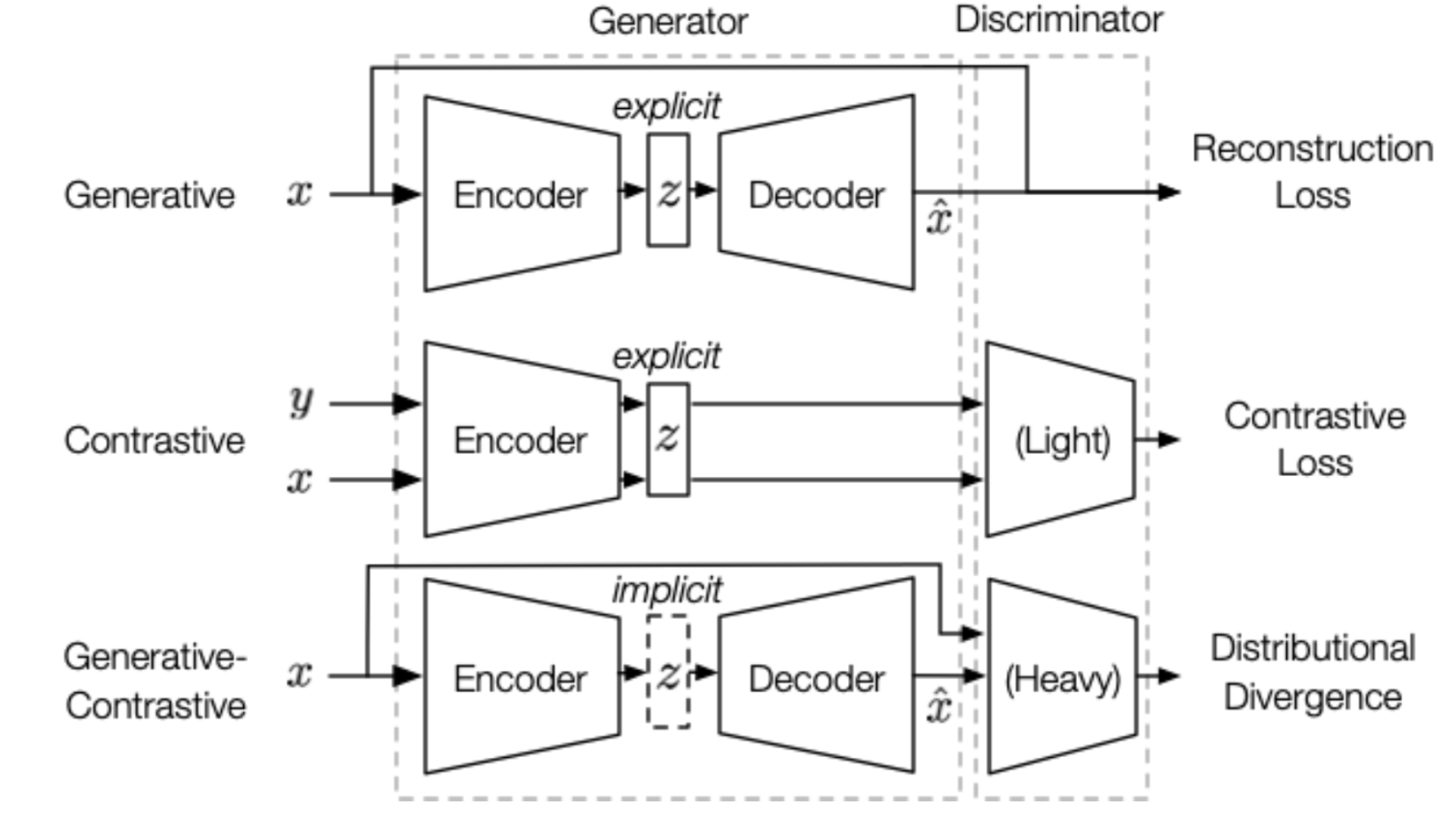

Contrastive vs Generative (vs Generative-Contrastive)

각각에 해당하는 예시 ({Moco, SimCLR} vs {BERT, GPT}) 만 봐도 contrastive 와 generative 가 어떻게 다른지 감이 올 것이다. 그래도 차이점을 formulation 하면 더 명확하고 직관적일 것이다.

| z | discriminator | objective | |

|---|---|---|---|

| Generative | explicit | X | reconstructino loss |

| Contrastive | explicit | O | contrastive similarity metric |

| Generative-Contrastive | implicit | O | distributional divergence |

- A properly designed training objective related to down-stream tasks could turn our randomly initialized models into excellent pre-trained feature extractors.

- ex) contrative learning - classification tasks- The art of self-supervised learning primarily lies in defining proper objectives for unlabeled data.

SSL 파트 논문 리뷰는 다음과 같이 진행될 것 같다.

- MoCO

- SimCLR

- BYOL

- SimSiam

- DINO

- iBOT

- BEiT

- MAE

- data2vec