Base model parameter Freeze vs Non-Freeze

distilation model에 대해 base의 parameter를 lr / 10의 비율로 추가 학습을 시켰을 때와, freeze 시켰을 때를 비교해 보았다.

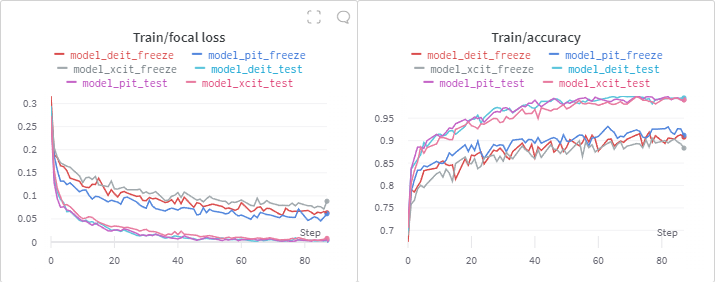

Train Loss / Accuracy

기본적으로 ImageNet accuracy를 위한 parameter여서 그런지,

우리의 classification문제에는 잘 수렴하지 못하는 모습을 보인다.

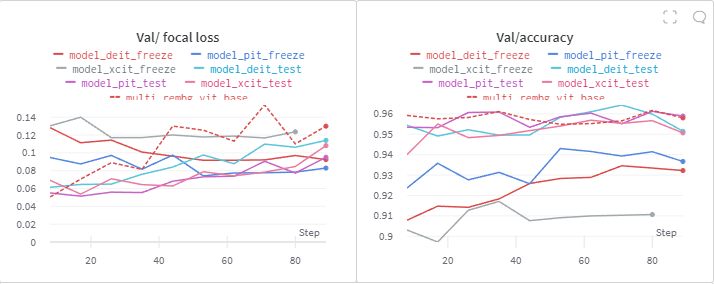

Validation Loss / Accuracy

대부분의 val accuracy가 감소한 모습을 볼 수 있다.

현재 Best Model과 비슷한 accuracy를 보이는 건 non-freeze model이라고 볼 수 있다.

당연하게도 Age 부분이 Freeze, Non-Freeze에 따라 다소 다른 양상을 보였는데

Freeze model일 수록 60대 이상의 데이터를 30~60대라고 잘못 판단한 경우가 많다고 결론지을 수 있다고 본다.

멘토님 피드백에 따라서 해당 현상의 이유를 잠깐 생각해보면, ImageNet Classification 대회를 위한 model이다 보니, 우리의 데이터 셋에 대해 '사람' label로 분류할 확률이 높다고 생각한다. 따라서 pretrained model의 마지막 layer의 1000개의 노드 중의 사람과 관련 있는 노드만 값이 높게 설정 되었을거라 생각한다. 그렇다면 사실상 뒤에 추가 시킨 fc layer만 대부분 학습이 되어 상대적으로 underfitting이 일어나는 것으로 예상이 된다.