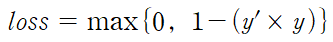

hinge loss : 힌지 손실

힌지 손실은 통계적 분류 훈련에 자주 사용되는 손실 함수입니다.

학습 데이터 각각의 범주를 구분하면서 데이터와의 거리가 가장 먼 결정 경계를 찾는 역할을 수행하기에, 특히 SVM에서 사용됩니다. 힌지 손실은 아래와 같습니다.

y' : 이진 분류 모델에서의 예측값

y : 학습 데이터의 실제값(-1 or 1)

둘의 부호가 다르면 loss값이 굉장히 크고, 같다면 y'에 따라 loss값이 달라집니다.이를 이해하기 위해 SVM의 가설 함수부터 살펴보겠습니다.

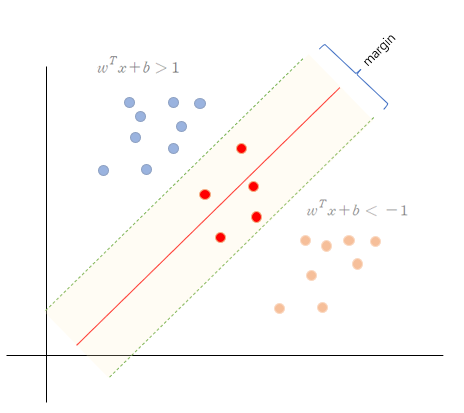

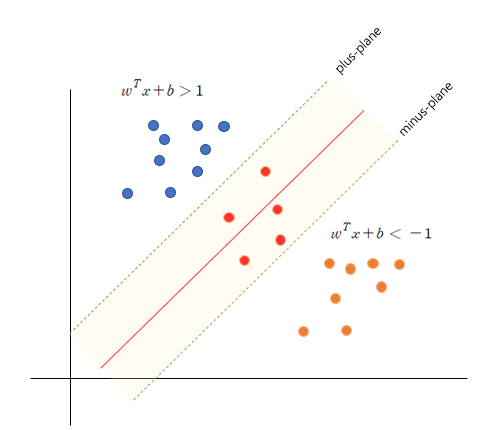

: plus-plane보다 위의 관측값들은 y=1이고, y'은 1보다 클 것이다.

: plus-plane보다 아래 관측값들은 y=-1이고, y'은 -1보다 작을 것이다.

그렇기에 위에서 살펴본 손실함수가 0이 되기 위해서는 y x y'이 1보다 크거나 같아야 할 것 입니다.

만약 y x y' 이 1 미만의 값을 갖는다면, 이는 각 plane 사이의 margin에 위치해 있는 것 입니다.

그러므로 분류가 잘 되는 margin 바깥 부분의 관측값이라면 loss=0으로 손실을 주지 않고, 분류가 잘 되지 않는 margin 내의 관측값은 loss값이 크도록 유도하는 것이 힌지 손실의 목적입니다.

정말 좋은 정보 감사합니다!