Drag-and-Drop LLMs: Zero-Shot Prompt-to-Weights

느낀점

- 예시 프롬프트 몇 개로 이렇게 좋은 성능?

- 대표 프롬프트로 LoRA 가중치를 끌어오는데 대표 프롬프트의 한계? 민감성이 문제일 듯

- 경사 하강법의 최종 결과를 예측해서 한 번에 가는데 이게 성능이 좋고 더 빠를 수가 있나? 테스트가 필요한 부분

Abstract

현대적인 PEFT(Parameter-Efficient Fine-Tuning) 방법인 LoRA(Low-Rank Adaptation)는 LLM을 사용자 맞춤형으로 만드는 비용을 줄여주지만 여전히 개별 다운스트림 데이터셋마다 별도의 최적화 과정을 거쳐야 합니다.

DnD(Drag-and-Drop LLM)를 소개합니다.

프롬프트 기반의 매개변수 생성기로 몇 개의 레이블이 없는 작업 프롬프트를 LoRA 가중치 업데이트에 직접 매핑함으로써 작업별 학습 과정을 없애줍니다.

경량 텍스트 인코더는 각 프롬프트 배치를 조건 임베딩으로 압축하고 이 임베딩은 계단식 하이퍼 컨볼루션 디코더에 의해 전체 LoRA 행렬 세트로 변환됩니다.

다양한 프롬프트-체크포인트 쌍으로 한 번 훈련되면 DnD는 몇 초 만에 작업별 매개변수를 생성하여 다음과 같은 결과를 제공합니다.

-

전체 파인튜닝 대비 최대 12,000배 낮은 오버헤드

-

새로운 상식 추론, 수학, 코딩 및 멀티모달 벤치마크에서 가장 강력한 훈련 LoRA 대비 최대 30%의 성능 향상

-

타겟 데이터나 레이블을 전혀 보지 않았음에도 불구하고 강력한 교차 도메인 일반화 능력

프롬프트 기반 매개변수 생성이 LLM을 빠르게 특화시키기 위한 그래디언트 기반 적응의 실행 가능한 대안임을 보여줍니다.

Introduction

GPT-4, Qwen2.5, DeepSeek과 같은 LLM은 인터넷 규모의 사전 학습과 트랜스포머 아키텍처 덕분에 현대 자연어 처리 및 광범위한 인공지능 분야의 중추가 되었습니다.

사전 학습을 통해 단일 모델은 수학, 코딩, 추론, 심지어 다중 모달 이해에 이르기까지 광범위한 제로샷 능력을 갖추게 됩니다.

그러나 제로샷 사용만으로는 충분하지 않으며 내부 데이터, 도메인 전문 용어 또는 맞춤형 응답 스타일에 맞춰 작업별 동작이 요구됩니다.

PEFT은 학습 가능한 가중치의 작은 세트를 가장 두드러지는 것이 LoRA입니다.

LoRA는 모델을 고정시켜 학습 가능한 매개변수 수와 스토리지 오버헤드를 작게 유지하지만 실제 시간 비용은 여전히 매우 높습니다.

예를 들어 가장 가벼운 0.5B 매개변수 Qwen2.5를 LoRA로 적용하는 데 여전히 4개의 A100 GPU를 반나절 동안 사용합니다.

각 다운스트림 사용자 또는 데이터셋은 자체적인 최적화 실행을 필요로 하므로 PEFT를 대규모로 배포할 때 이는 빠르게 계산 병목 현상이 됩니다.

LoRA 어댑터가 훈련 데이터의 함수에 불과하다는 것을 발견했습니다.

경사 하강법은 기본 가중치를 작업별 최적점으로 "끌어당깁니다".

만약 프롬프트에서 가중치로의 매핑을 직접 학습할 수 있다면 경사 하강법을 완전히 우회할 수 있습니다.

매개변수 생성에 대한 초기 연구는 하이퍼네트워크가 몇 분 만에 수십억 개의 가중치를 합성할 수 있음을 보여주었습니다.

최근의 발전으로 이러한 목표가 달성 가능해졌습니다.

RPG는 작업 정보에 조건화하고 단일 패스로 전체 분류기를 생성하는 최초의 접근 방식 중 하나이며 이전에 보지 못한 이미지 클래스에서 제로샷으로 처음부터 훈련하는 것과 일치합니다.

그러나 이러한 성공을 언어로 확장하는 것은 새로운 장애물을 야기합니다.

첫째, 언어적 프롬프트는 RPG에서 사용된 이진 임베딩보다 훨씬 더 많은 의미적 변동성을 가집니다.

따라서 실용적인 생성기는 풍부한 작업 기술자를 받아들이고 그 뉘앙스를 보존해야 합니다.

둘째, 프로덕션 환경의 LLM은 수백 가지의 이질적인 작업 부하에 직면할 수 있으므로 조건화 메커니즘은 높은 충실도로 작업별 단서를 주입하면서 원활하게 확장되어야 합니다.

이러한 과제들은 입력 텍스트의 중요한 특징을 포착하고 하이퍼네트워크를 LoRA 가중치 공간의 해당 영역으로 유도하는 압축적이면서도 표현력 있는 표현의 필요성을 야기합니다.

우리는 Drag-and-Drop LLMs (DnD)를 소개합니다.

프롬프트에 따라 조건화되는 하이퍼-생성기로 몇 개의 레이블 없는 작업 프롬프트를 완전한 LoRA 어댑터 세트로 단 몇 초 만에 변환하여 작업별 최적화를 제거합니다.

DnD는 기성품인 경량 텍스트 인코더를 사용하여 주어진 프롬프트 배치를 조건부 임베딩으로 압축한 다음 계단식 하이퍼-컨볼루션 디코더가 이를 모든 트랜스포머 레이어에 대한 LoRA 업데이트로 확장합니다.

일반 상식 추론, 수학, 코드 생성 및 다중 모달 벤치마크에서 DnD는 적응 오버헤드를 최대 12,000배까지 줄이면서, 가장 강력한 훈련 LoRA에 비해 보이지 않는 데이터셋에서 최대 30%의 성능 향상을 달성하며, 0.5B에서 7B 매개변수 백본으로 원활하게 전이됩니다.

고전적인 "데이터 → 기울기 → 가중치" 루프를 단일 순방향 단계로 축소함으로써 DnD는 경사 하강법이 모델 특수화에 필수적이라는 개념에 도전하고 가중치 자체가 간결한 작업 기술자에 조건화되는 새로운 데이터 모달리티 및 생성 목표가 되는 새로운 경로를 열었습니다.

우리의 주요 기여는 다음과 같습니다:

-

새로운 LLM 적응 패러다임. LoRA 적응을 새로운 데이터셋의 원시 프롬프트로부터 작업별 가중치를 직접 생성하는 것으로 보고 확장 가능한 하이퍼-생성기로 이 매핑을 구현합니다. 이는 전통적인 튜닝보다 훨씬 효율적입니다.

-

실용적인 아키텍처. 고정된 텍스트 인코더와 하이퍼-컨볼루션 디코더의 결합은 대규모 매개변수를 생성하면서 적응 오버헤드를 4자리 수 이상으로 줄일 수 있습니다.

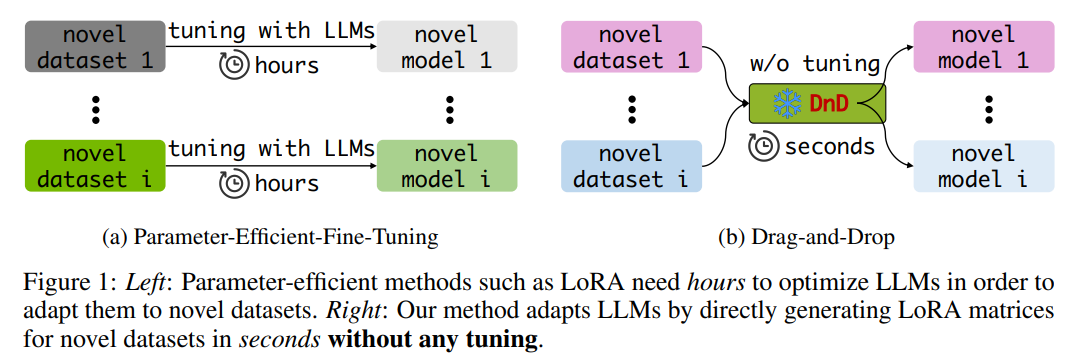

(a) Parameter-Efficient-Fine-Tuning (왼쪽)

-

"novel dataset 1"부터 "novel dataset i"까지 여러 개의 새로운 데이터셋

-

각 새로운 데이터셋은 LLM과 함께 "hours" 단위의 긴 튜닝 과정을 거칩니다.

-

튜닝 과정을 통해 각 데이터셋에 특화된 "novel model 1"부터 "novel model i"까지 새로운 모델들이 생성됩니다.

LoRA와 같은 기존의 미세 조정 방법을 나타내며 모델을 새로운 데이터셋에 맞게 최적화하는 데 수 시간이 걸린다는 것을 보여줍니다.

(b) Drag-and-Drop (DnD) (오른쪽)

-

여기도 "novel dataset 1"부터 "novel dataset i"까지 여러 개의 새로운 데이터셋이 있습니다.

-

각 새로운 데이터셋은 "w/o tuning" 바로 "DnD"라는 방식을 거칩니다.

-

"DnD" 과정은 단 "seconds" 단위의 매우 짧은 시간 안에 이루어집니다.

-

이 과정을 통해 각 데이터셋에 특화된 "novel model 1"부터 "novel model i"까지 새로운 모델들이 생성됩니다.

제안하는 새로운 방법인 "Drag-and-Drop"은 어떤 튜닝 과정도 없이 직접 LoRA 매트릭스를 생성하여 몇 초 만에 LLM을 새로운 데이터셋에 적응시킨다는 것을 보여줍니다.

Drag-and-Drop Your LLMs

Preliminary

한 가지 의문이 있습니다 파라미터 생성을 활용하여 LLM의 가중치를 주어진 새로운 작업에 더 적합한 구성으로 효과적으로 "드래그 앤 드롭"할 수 있을까요?

여기서 "드래그 앤 드롭"은 파일 끌어다 놓기와 유사하게 추가 구성 없이 특정 작업에 맞는 가중치를 직접 생성하는 간단하고 튜닝 없는 프로세스를 비유적으로 표현한 것입니다.

주요 과제

과제 1: 파라미터 생성기에 효과적인 "드래그 앤 드롭" 능력을 어떻게 부여할 것인가? 생성기는 LLM을 특정 작업에 효과적으로 적응시킬 수 있는 파라미터를 생성해야 합니다.

과제 2: 작업별 훈련 없이 적응을 어떻게 가능하게 할 것인가? 전통적인 PEFT 방법은 일반적으로 새로운 작업에 대한 훈련이 필요하지만, 대상 작업에 대한 미세 조정 없이 파라미터를 직접 생성하여 유사한 성능을 달성할 수 있을까요?

과제 3: 드래그 앤 드롭 기능을 사용자 친화적이고 접근 가능하게 만드는 방법은? 생성 메커니즘은 간단하고 직관적이어야 하며, 더 폭넓은 채택과 실제 배포를 가능하게 해야 합니다.

Overview of DnD

준비 과정으로 다양한 데이터셋에 대해 LoRA 어댑터를 학습하고 저장합니다.

"드래그 앤 드롭" 기능을 개발하기 위해 매개변수와 데이터셋 간의 상관관계를 인지해야 합니다.

결과적으로 수집된 체크포인트와 해당 학습 데이터의 프롬프트 배치를 무작위로 페어링합니다.

사전 학습된 텍스트 인코더는 프롬프트에서 임베딩을 추출하고 이를 매개변수 생성기에 공급합니다.

이 생성기는 계단식 순수 컨볼루션 디코더 블록으로 이루어진 간단한 아키텍처를 특징으로 합니다.

생성된 토큰화된 모델 가중치와 원본 가중치 간의 MSE 손실을 사용하여 이 생성기를 최적화합니다.

추론 단계에서는 in-domain 및 cross-domain 시나리오 모두에서 우리의 접근 방식을 평가합니다.

학습 중에는 보지 못했던 새로운 데이터셋의 프롬프트를 DnD에 단순히 공급하여 단 한 번의 순방향 패스만으로 맞춤형 모델 매개변수를 얻는 방식입니다.

Data Preparation of DnD

체크포인트 수집

다양한 데이터셋에 걸쳐 체크포인트를 수집하는데 DnD(Drag-and-Drop) 기능을 갖추기 위한 다양한 supervision 역할을 합니다.

수집 과정은 이전의 매개변수 생성 연구를 따릅니다. 지정된 epoch만큼 훈련한 다음 각 iteration마다 체크포인트를 보존하면서 iterative fine-tuning을 수행합니다.

프롬프트의 역할

최근 연구에 따르면 서로 다른 데이터셋의 샘플은 고유한 특징을 나타내며 샘플을 특정 데이터셋의 "fingerprints"으로 간주할 수 있습니다.

데이터 샘플(프롬프트)을 해당 데이터셋(작업)의 representative proxies로 활용합니다.

데이터-매개변수 매핑을 설정하기 위해 이러한 체크포인트를 훈련하는 데 사용된 데이터셋에서 프롬프트를 통합합니다.

이 프롬프트는 데이터셋별 특징을 포함하고 있어 생성기가 다양한 작업에서 모델에 대한 적절한 "dragging" 방향을 추론할 수 있도록 합니다.

프롬프트-체크포인트 페어링

다음으로 중요한 질문은 DnD에 훈련 중 "드래그 앤 드롭" 기능을 부여하기 위해 이러한 요소들을 어떻게 활용할 것인가입니다.

데이터셋 P가 주어졌을 때, 먼저 이를 겹치지 않는 프롬프트 배치 로 나눕니다.

이 데이터셋의 훈련된 LLM 체크포인트를 로 표기합니다.

무작위로 프롬프트 배치 하나와 해당 체크포인트 하나를 선택합니다. 이 과정은 다음과 같이 공식화할 수 있습니다.

(2)

여기서 는 매개변수 생성기 훈련을 위한 쌍으로 사용됩니다. 프롬프트 와 체크포인트 는 각각 입력과 supervision 역할을 합니다.

Prompt Embedding

각 프롬프트 배치에 대해 매개변수 생성기의 입력으로 사용될 임베딩(embeddings)을 추출하기 위해 오픈소스 텍스트 인코더를 사용합니다.

이 추출 과정은 공식적으로 다음과 같이 표현될 수 있습니다:

(3)

여기서 는 로 매개변수화된 임베딩 추출 함수를 나타내며, 는 프롬프트 에 해당하는 추출된 임베딩을 나타냅니다.

기본적으로 인코더 기반 언어 모델(encoder-based language model) 아키텍처를 프롬프트 임베딩에 활용합니다.

실험 섹션에서는 word2vec 표현(representations) , 인코더-디코더 아키텍처(encoder-decoder architecture), 디코더-온리 언어 모델(decoder-only language models)을 포함한 대체 임베딩 접근 방식을 추가로 탐색하고 정량적으로 평가합니다.

Training and Inference of DnD

Structure of parameter generator.

확산 기반 매개변수 생성과 달리 입력 프롬프트와 매개변수 간의 매핑(mapping)을 학습하기 위해 하이퍼-컨볼루션 디코더(hyper-convolutional decoder)를 사용합니다.

이러한 설계는 효율성을 주로 고려한 것으로 디코더-온리 구조가 LLM에서 우수성을 보여주었기 때문입니다.

입력 프롬프트 임베딩의 차원은 라고 가정합니다.

여기서 는 각각 배치 크기(batch size), 프롬프트 배치의 길이(length of prompt batch)(즉, 프롬프트 수), 시퀀스 길이(sequence length), 숨겨진 차원(hidden dimension)을 나타냅니다.

연속적인 컨볼루션 블록은 프롬프트 임베딩을 변환하여 토큰화된 가중치(tokenized weights)의 차원과 일치시킵니다. 여기서 우리는 마지막 블록의 출력을 로 지칭합니다.

학습 목표. 학습 목표는 간단합니다

매개변수 생성기의 마지막 블록 출력과 해당 토큰화된 체크포인트(tokenized checkpoints) 간의 평균 제곱 오차(Mean Squared Error, MSE) 손실을 계산합니다.

RPG와 유사하게 각 계층의 매개변수를 겹치지 않는 세그먼트(non-overlapping segments)로 토큰화하고 패딩(padding)을 적용하여 체크포인트가 의 일관된 형태를 갖도록 합니다. 공식적으로 MSE 손실은 다음과 같습니다

프롬프트 임베딩 매개변수 생성기

추론.

매개변수 생성기가 새로운 데이터셋이나 학습 중 접하지 않은 태스크(task)에 대해 효과적인 "드래그 앤 드롭(drag-and-drop)" 능력을 개발하기를 기대합니다.

따라서 우리의 평가는 주로 새로운 데이터셋에서의 성능에 초점을 맞춥니다.

추론 과정은 네 단계로 구성됩니다:

1) 새로운 데이터셋에서 프롬프트 샘플링

2) 이 프롬프트에서 임베딩 추출

3) 임베딩을 매개변수 생성기에 입력

4) 새로운 데이터셋에서 생성된 매개변수 평가.

"드래그 앤 드롭" 능력을 포괄적으로 입증하기 위해, 동일 도메인 시나리오(in-domain scenarios)(예: 상식-상식)와 교차 도메인 시나리오(cross-domain scenarios)(예: 상식-과학) 모두에서 성능을 검증합니다.