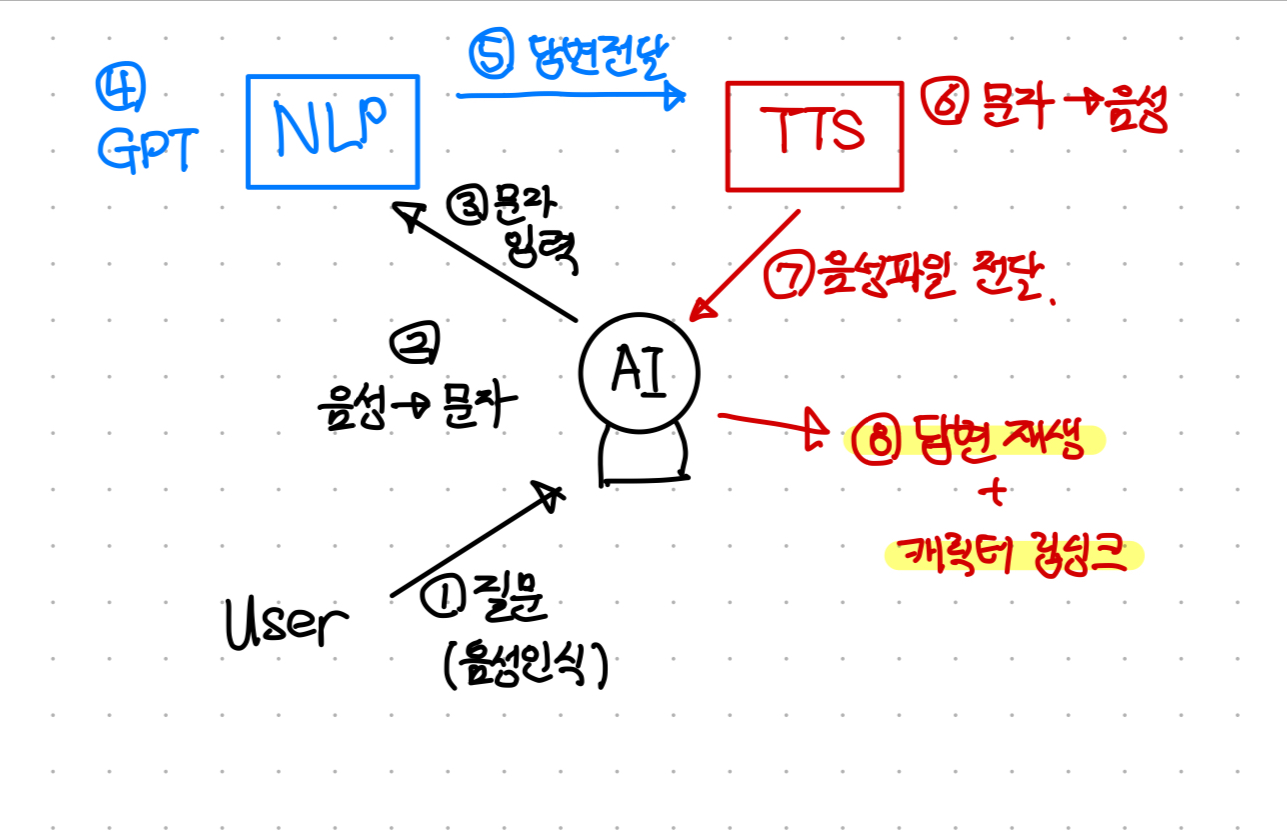

발음에 따라 입술의 키프레임이 지정되어있어 출력되는 사운드에 따라 입모양이 립싱크하듯 보여지는 플러그인인 Oculus VR Lip Sync다.

이를 활용해 지난 번에 구현했던 TTS 서버와 연동해 원하는 문장을 읽도록 .wav 파일을 스트리밍하는 기능 이후 해당 문장을 출력할 때 캐릭터가 문장에 맞게 입을 움직이는 기능을 추가하는 것이다.

1. 요구사항

출력된 음성에 맞게 캐릭터가 움직이면 된다. 제공받은 반실사 렌더링 아바타를 메타휴먼으로 변환한 뒤 위의 기술을 적용했다.

2. 플러그인 적용과 아바타 리깅

UE4에서 UE5로

해당 플러그인은 4.25 기준으로 작성되어있어 솔루션 파일을 삭제 뒤 버전 업그레이드를 통해 5.X 버전으로 업그레이드했다. 메타휴먼은 언리얼 5부터 지원하기에 이 과정을 거쳐야만 해당 플러그인을 사용할 수 있었다.

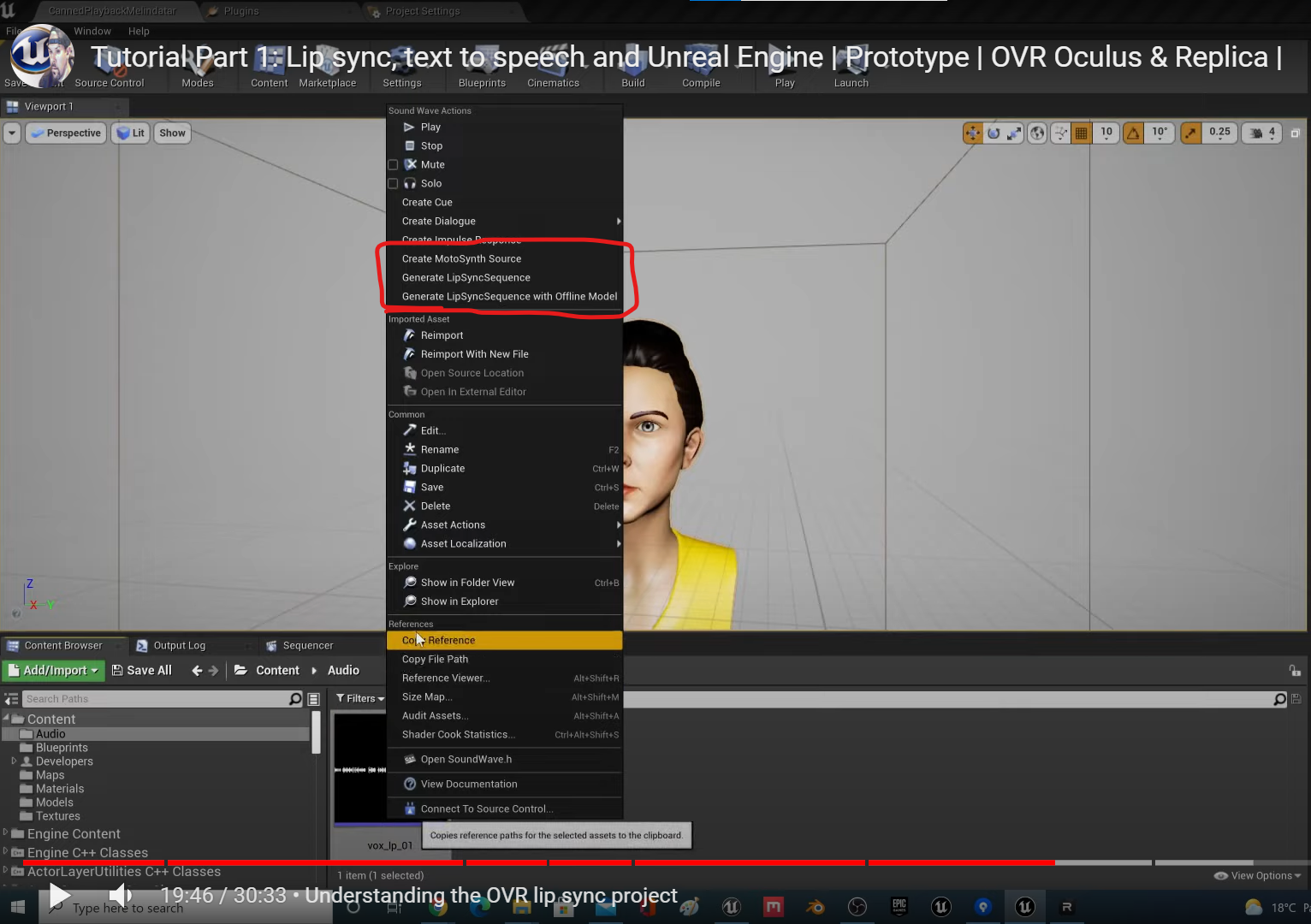

곧바로 4.25 버전의 데모 프로젝트를 5.1로 변환하면 저 립싱크 시퀀스를 생성할 수도, 제어할 수도 없게 된다.

빌드하기 전에 AndroidPermission 인터페이스를 build.cs 파일에 임포트해야 한다는 것을 잊지 말자.

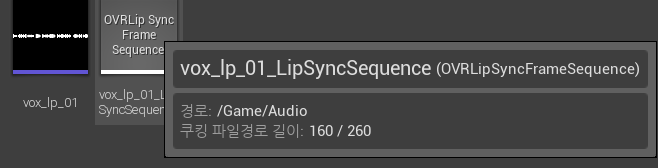

사운드 파일을 립싱크 시퀀스로 변환

립싱크 시퀀스는 음성 파일을 바탕으로 아바타의 얼굴 표정 키를 잡아주는 역할을 한다.

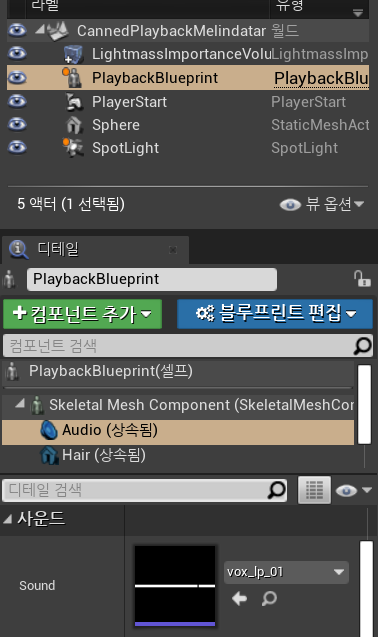

재생할 사운드와 립싱크 시퀀스를 설정해 놓으면 그에 맞게 캐릭터가 립싱크를 진행한다.

아바타 키프레임 작업

같이 실습을 나온 블렌더잘알 팀원이 작업한 것이기 때문에 간단하게 서술하자면, 위 플러그인은 메타휴먼을 기반으로 작동하기 때문에 전달받은 테스트용 아바타를 메타휴먼으로 변환해야 했다. 사용하는 부분이 입술 중심의 얼굴 본만 사용하기 때문에 이 부분만 키를 따로 잡아줬다고 한다.