MCP Inspector

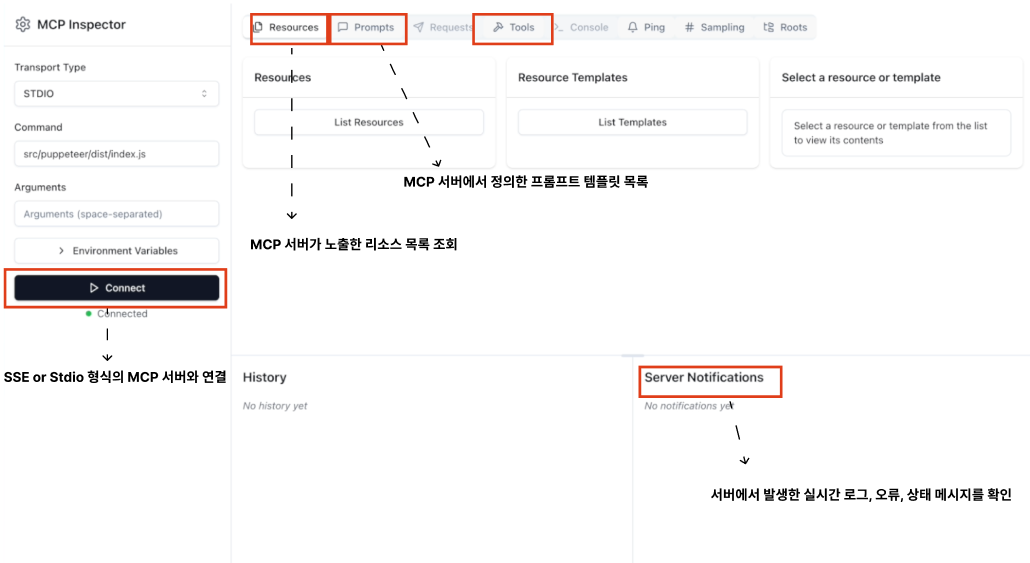

MCP Inspector 는 MCP Server를 개발하고 테스트할 때 사용하는 인터랙티브 디버깅 툴 오픈소스 개발 도구이다. (Anthropic 개발) 설치 없이 로컬환경에서 바로 실행할 수 있으며, SSE나 Stdio 기반 서버와 연결해 실시간으로 테스트 할 수 있다.

해당 툴은 MCP 서버에서 어떤 일이 일어나는지 직접 보고 상호작용하며 확인할 수 있도록 해주기 때문에, MCP 서버를 개발하거나 디버깅할 때 매우 유용하다.

주요기능:

-

서버 연결

- 로컬에서 실행중인 MCP 서버와 연결

- 연결 후 Inspector는 서버의 모든 공개도니 기능들을 탭별로 시각화하여 보여준다.

-

Resource

- MCP 서버가 노출한 리소스 목록 조회- PDF, txt, image, json등 AI가 접근할 수 잇도록 공개된 데이터 조회.

- 리소스마다 메타데이터를 볼 수 잇고, 해당 리소스의 실제 내용을 미리 확인 가능

-

Prompt

- MCP 서버에서 정의한 프롬프트 템플릿 목록을 보여줌.- 각 템플릿의 이름, 설명, 입력인자(argument) 구조 등을 확인 가능

- 프롬프트 디버깅시 유용

-

Tool

- AI가 호출 가능한 함수형 도구 (tool) 들의 목록을 확인가능- 각 도구는 Schema를 갖고 있기 때문에 Inspector는 이 구조를 시각화해 보여주며, 입력값을 커스터마이징해서 직접 실행해 볼 수도 있다.

-

Notifications 패널

- 서버에서 발생한 실시간 로그, 오류, 상태 메시지를 확인- MCP 서버의 상태를 추적하거나 디버깅할 때 필요한 정보를 실시간으로 제공

llm.txt

llm.txt는 LLM과 AI 에이전트가 웹사이트의 구조와 콘텐츠를 더 잘 이해하고 처리할 수 있도록 돕기 위해 고안된 비공식 표준 파일이다.

이 파일은 일반적으로 웹사이트의 루트 디렉토리에 위치하며, Markdown 형식으로 작성된다.

해당 파일은 웹사이트 내의 주요 페이지 URL과 그에 대한 간단한 설명 및 용도를 포함한다. 이 정보를 통해 AI는 어떤 페이지가 어떤 주제를 다루는지 빠르게 파악할 수 있다.

목적

llm.txt는 AI 시스템이 웹사이트의 콘텐츠를 더 정확하고 효율적으로 이해하고 탐색 할 수 있도록 돕는다. ChatGPT, Gemini, 혹은 커스텀 AI 에이전트 같은 시스템이 구조화된 사이트 맵 정보를 활용해 실시간으로 필요한 정보를 추출할 수 있게 한다.

형식과 예시

- 형식: Markdown

- 내용 : 중요한 페이지들의 URL + 간단한 설명

- 예시:

- /docs : 메인 문서페이지

- /docs/memory: 메모리 관련 문서 설명

- /about : 프로젝트 소개llm.full.txt

llm.full.txt는 llm.txt의 확장 버전으로, 페이지 링크와 설명만 포함하는 것이 아니라, 해당 페이지의 전체 텍스트 내용을 포함한다.

이 파일은 크기가 매우 크고, 모든 주요 문서 페이지의 실제 텍스트 데이터를 담고 있다.

llm.txt vs llm.full.txt

| 구분 | llm.txt | llm.full.txt |

|---|---|---|

| 목적 | 사이트 구조 및 요약 제공 | 전체 콘텐츠 제공 |

| 정보량 | 적음(요약) | 많음(전체텍스트) |

| 크기 | 작음 | 큼 |

| 활용방식 | 웹크롤러 + 실시간 정보수집 | 로컬 임베딩 + 벡터 DB 검색 |

| 대표 사용자 | 실시간 정보가 필요한 에이전트 | 빠른 질의 응답이 필요한 QA 시스템 |

llm.txt 사용 시점

-

에이전트가 fireCrawl 같은 웹 크롤링 도구를 통해 실시간으로 정보를 가져오는 경우

-

예 : AI 가 LinkChain 문서에서 "memory"관련 정보를 찾고 싶다면,

-llm.txt를 통해/docs/memory페이지가 관련 있다는걸 파악- 해당 URL을 웹 스크래퍼를 통해 실시간으로 다운로드

- 그 콘텐츠를 처리하고 사용함

이 방식은 최신 정보를 가져올 수 잇다는 점에서 매우 유리하지만, 여러단계(fetch -> process -> fetch again)가 필요해 지연(latency)이 다소 생긴다.

llm.full.txt 사용 시점

- 사이트 전체 정보를 한번에 가져와서 chunking 후 벡터 DB에 인덱싱 해두는 방식

- 질문이 들어오면 이미 인덱싱된 데이터를 바로 검색해서 빠르게 응답 가능

- 실시간성이 필요없는 정적 Q&A 시스템에 적합

이 방식은 빠르고 효율 적이지만, 실시간 업데이트 반영이 어렵다.

MCP와의 연계

MCP 서버에서 제공하는 tool(ex: fireCrawl, fetchDoc)과 함께 사용하면, llm.txt 정보를 기반으로 정확히 필요한 웹페이지만 실시간으로 가져올 수 있다.

MCP는 llm.txt를 파싱해서 도구에 정확한 URL을 넘기고, 그에 따라 도구가 페이지를 크롤링하고 결과를 AI에 전달하는 식으로 흐름이 구성된다.

이 방식은 웹사이트가 llm.txt를 갖고 있을 때, 에이전트가 탐색 경로를 추론하지 않고 명확히 인지한 뒤 빠르게 작동할 수 있게 도와준다.

| 항목 | 설명 |

|---|---|

llm.txt | 웹사이트 구조를 요약해서 AI가 탐색할 수 있게 해주는 경량 파일 |

llm.full.txt | 모든 콘텐츠를 담은 대용량 파일로 AI의 문맥 이해를 돕는다 |

| 주요 활용 | llm.txt: 실시간 크롤링 기반 MCP 에이전트 |

llm.full.txt: 오프라인 벡터 DB 기반 검색 | |

| MCP 연계 | MCP 서버에서 lm.txt 구조 기반으로 도구 호출 경로를 최적화할 수 있음 |