Part 4. 빅데이터 결과 해석

Chapter 01. 분석모형 평가 및 개선

Section 01. 분석모형 평가

1. 평가 지표

1-1. 지도학습 - 분류모델 평가 지표 : Classification

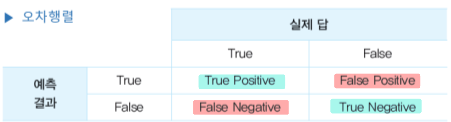

- 오차행렬

: 분석모형의 답과 실제 결과와의 관계

: 예측값과 실제값 비교를 통한 분류 성능 측정

-

정확도 : Accuracy

: 전체적인 분류 성능, 실제 데이터 = 예측 데이터

:TP + TN / TP + FP + FN + TN -

정밀도 : Precision

:Positive라고 예측한 값 중 실제Positive

:TP / TP + FP -

재현율(민감도) : Recall

: 실제Positive중Postive라고 예측에 성공한 비율

:TP / TP + FN -

F1-Score

: 정밀도 + 재현율의 조화평균 지표

:F1-Score∝ 모형의 정확도

:2 x Precision x recall / (Precision + recall) -

ROC 곡선

:FPR(FP / FP+TN)의 변화에 따른TPR(TP / TP+FN)의 변화

: 곡선 모양은 분류모델의 성능을 의미함, 곡률이 좌상단에 가까울 수록 성능 좋음

: 하단 면적 =AUC -

AUC

: ROC 곡선의 하단 면적,0~1

:AUC=1= 성능 우수함

1-2. 지도학습 - 회귀모델 평가 지표 : Regression

- 실제값과 회귀 예측값의 차이

-

SSE: 오차제곱합

: 실제값과 예측값의 차이를 제곱하여 더한 값

:∑(실제값 - 예측값)^2 -

MSE: 평균제곱오차

:SSE의 평균

:1/n * SSE -

RMSE: 평균제곱근오차

:√MSE -

MSPE

:MSE를%로 변환 -

RMSLE

:log RMSE, 이상치에 덜 민감함 -

MAE

: 실제값과 예측값의 차이의 절대값을 합한 평균값

:1/n * ∑|실제값 - 예측값| -

MAPE

:MAE를%로 변환 -

MPE

:실제값 - 예측값의 상대적 오차를 백분율로 표현

:100/n * ∑(실제값-예측값/실제값) -

결정계수

R^2

: 회귀모형이 실제에 적합한 비율

:R^2∝ 성능 -

Adjusted R^2

: 독립변수 개수 ∝ 결정계수의 문제를 보완

: 표본 크기n, 독립변수 개수p를 함께 고려해 결정계수 증가 보정

:1-(n-1)*MSE/SST) -

AIC

: 최대 우도(likelihood)에 독립변수의 개수에 대한 손실분 반영

: 모형과 데이터의 확률 분포 차이 측정

:AIC ∝ 1/모형의 적합도

:AIC = -2 log L + 2K(L: 모형 적합도 척도,K: 모형 파라미터 수) -

BIC

: 주어진 데이터에서 모형의 우도 측정

:BIC = -2 log L + k log nAIC,BIC

: 모형 비교 기준으로, 모형이 복잡할 수록 Penalty를 부과함

1-3. 비지도 학습 - 군집분석 평가 지표

- 모델 성능 평가가 어려움

- 실루엣 계수

:s(i) > 0.5= 적절한 군집 모델,s(i) = 0= 의미 없음

:s(i) = b(i) - a(i) / max(a(i), b(i))a(i): 군집 내 데이터 응집도b(i): 군집 간 분리도

Dunn Index

:군집 간 거리의 최소값 / 군집 내 요소 간 거리의 최대값

:Dunn Index ∝ 성능

: 군집 간 거리는 클수록, 군집 내 분산은 작을 수록 좋다.

2. 분석모형 진단

2-1. 정규성 가정

- 분석 진행 전, 데이터가 정규분포를 따르는지에 대한 검정

: 데이터 자체의 정규성 확인

중심극한정리

- 동일 확률분포의 독립확률변수

n개의 평균 분포

=n이 적당히 크다면, 정규분포에 가까워짐 표본분포평균 = 모평균표준편차 = 모표준편차 / √n정규성 검정 종류

- 샤피로-월크 검정 (

n < 2000) - 콜모고로프 스미르노프 검정 (

n > 2000) Q-Q Plot:n이 소규모, 시각화 도구 일종

- 샤피로-월크 검정 (

2-2. 잔차 진단

- 회귀분석에서 독립변수 ↔ 종속변수의 관계를 결정하는 최적의 회귀선

= 잔차(실측치 - 예측치)를 가장 작게 하는 선(잔차의 합 = 0)

-

잔차 정규성 진단

: 시각화도구(Q-Q Plot)을 통한 정규분포와 잔차분포의 비교

-

잔차 등분산성 진단

: 잔차 분산의 등분산성 진단 -

잔차 독립성 진단

: 자기상관여부 판단

: 독립성 위배 → 시계열 분석을 통한 회귀 분석 진행

3. k-폴드 교차검증

- 과적합을 방지하는 교차검증 기법

- 전체 데이터셋 →

k개의 subset +k-1개의 훈련데이터 +1개의 검증데이터 - 모든 데이터셋을 평가에 활용

- 모델 훈련 및 평가/검증에 대한 시간 소요↑

홀드아웃 기법 :

Hold Out

: 훈련/검증/테스트 데이터를 일정 비율로 지정

: 과적합 방지를 목적으로 함

: 데이터셋 크기가 작을수록 데이터를 나누는 방식에 따라 모델 성능 추정에 영향※ k-폴드 교차검증은

Hold Out보다 안정성이 높으나, 계산비용도 높음.

4. 적합도 검증

- 데이터 분포가 특정 분포함수와 일치하는 정도에 대한 검증

- 정규성 검정법 : 모집단 분포를 정규분포로 가정

t-검정ANOVA회귀분석

4-1. 카이제곱 검정

k개의 범주별로 구분된 관측치들과 동일한 범주의 가정된 분포 사이의 적합도 검정- 범주형 값

k가 나와야 할 횟수의 기댓값Mk, 실제값Xk의 차이

:∑{(Xk - Mk)^2 / Mk} - 검정통계량 + 자유도를 통한

p-value도출

→p-value < 유의수준= 귀무가설(Ho) 기각

4-2. 콜모고로프 스미르노프 검정 (K-S Test)

- 누적분포함수의 차이를 통해 실제 표본 분포 ↔ 가정 분포 사이의 적합도 검사

- 연속형 데이터에도 적용 가능

- 관측치의 누적확률, 가정된 분포의 누적확률 비교