Cameras and Aerial Photography

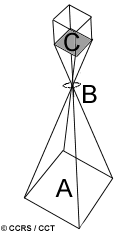

카메라와 aerial photography(이게뭔데)의 사용은 지구표면 원격탐사를 위한 가장 간단하고 오래된 것들이다. 카메라는 거의 한순간에 영역의 스냅샷을 획득하는 framing system이다.(A) 그리고 카메라는 렌즈를 사용하는 passive optical sensor이다.(B) focal plane에 이미지의 형태로 만드는(C).

Photographic film은 0.3μm부터 0.9μm 파장까지 민감하고 이 영역은 ultraviolet, visible, near-infrared 영역을 다 포함하고 있다. Panchromatic film은 UV영역과 visible 영역에 민감하다. Panchromatic film은 흑백이미지를 제공하고 aerial photogrphy에 쓰이는 필름의 타입 중 가장 흔한 플름이다. UV photography 또한 panchormatic film을 사용하지만 film에 닿기 전에 visible 영역을 흡수하는 필터가 카메라에 같이 사용된다. 결과적으로 UV 반사만 기록되게 된다. UV photography는 많이 사용되진 않는데 그 이유는 대기중의 산란과 흡수 과정에서 이 영역이 흡수되기 때문이다. Black and White photography는 0.3 ~ 0.9μm 전체 영역에 민감하고 IR 반사에 민감하기 때문에 vegetation cover(그냥 식생지역을 말하는건가?) 차이를 감지하는데 유용하다.

Colour와 false colour(or colour infrared, CIR) photography는 각각 다른 빛의 범위에 민감한 3개의 player를 사용한다. normal colour photograph에선 blue, green, red light에 민감한 총 3개의 layer를 사용하고 우리의 눈이 보는 것과 같은것을 보여준다. 왜냐하면 이 3개 색깔의 조합이 우리 눈에 정상적으로 보이기 때문이다. (실제로 우리 눈이 이 3개의 파장에 민감하기 때문)

colour ingrared(CIR) photography에선 green, red, near-infrared radiation 영역에 민감한 layer를 가지고 있고 각각은 blue, green, red로 취급되어 보여진다.

false colour photograph에선 높은 near-infrared 반사를 빨강색으로, 높은 red 반사를 초록으로, 높은 초록반사를 파랑으로 보여주고 그래서 우리 눈이 실제로 보는 색깔과 많이 달리지기 때문에 false라는 이름이 붙었다.

사진의 ground coverage는 렌즈의 focal length나 platform의 altitude(고도), 필름의 사이즈와 format에 따라 달라진다. focal length는 렌즈의 angular field of view(IFOV와 비슷한 거라고한다.)를 효과적으로 컨트롤하고 카메라가 보는 영역을 결정한다. 전통적인 focal length는 90mm, 210mm, 그리고 가장 일반적으로 152mm를 가진다. 저 긴 focal length는 더 작은 ground 영역을 커버하지만 훨씬 디테일해진다. (larger scale) 커버되는 area는 platform의 고도에 의해 달라진다. 높은 코도에선 카메라가 더 큰 영역을 보게되지만 덜 자세한 사진이 나온다.(smaller scale)(당연한 얘기) Aerial photo(비행기가 찍는 사진을 말하는 것 같다.)는 50cm 이하의 아주 높은 spatial resolution을 제공한다. 사진의 정확한 spatial resolution은 각 수집되는 데이터의 따라 달라지는 많은 요인들의 복잡한 function에 따라 달라진다. (...)

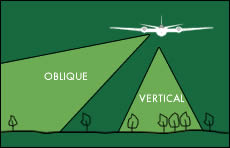

대부분의 aerial photograph는 수집되는 동안 땅의 대한 카메라의 방향에 따라 oblique(사선?) 혹은 vertical(수직)으로 구분된다. Oblique aerial photographs는 항공기의 옆에 달려있을 때 찍히는 이미지를 말한다. 높은 곳에서 찍힌 oblique photogrpah는 보통 지평선을 포함하고 있고 낮은 사진은 그렇지 않다. Oblique photogrpah는 매우 큰 지역은 한장의 사진으로 커버해서 지형의 relief and scale(높이와 규모?)를 묘사하는데 유용하다. 그러나 이것들은 mapping을 위한 용도로는 많이 쓰이지 않는데 왜냐하면 사진의 앞부분부터 뒷부분까지의 scale 왜곡 때문에 거리나 영역, 고도 등을 쉽게 측정하지 못하기 때문이다.

Vertical photogrpah는 single-lens frame camera로부터 찍히는 사진이고 remote sensing과 mapping 목적으로 가장 흔히 사용된다. 이 카메라는 특히 짧은 시간 동안 연속적으로 사진을 찍기 때문에 기하학적 왜곡이 적다. 이 센서들은 종종 정확한 지리적 좌표를 각 사진에 즉시 할당할 수 있도록 비행기에 탑재된 navigation system(항법장치?)에 쓰인다. (뭔말이야) 대부분의 카메라 시스템은 항공기가 여러 방향으로 흔들릴 수 있기 때문에 이 움직임의 영향을 보정해서 왜곡을 최대한 줄이는 매커니즘을 포함하고 있다.

vertical aerial photogrpah을 수집할 때 항공기는 flight line이라고 불리는 선들을 따라서 비행한다. 사진은 땅을 수직으로 똑바로 내려다보는 상태에서 빠르게 연속적으로 찍힌고 보통 두 연속된 사진은 50~60% 정도 영역이 겹친다. 이렇게 overlap이 되면 flight line을 따라 찍은 영역들의 전체적인 커버를 보장해주고 stereoscopic viewing(한 곳을 여러 시점으로 다르게 보는 것)을 가능하게한다. 연속된 두 장의 쌍이 다른 관점에서 지역을 보여주고 stereoscope라는 장치를 통해 stereo model이라 불리는 영역의 3차원 뷰를 볼 수 있다. 많은 항공사진이 stereoscopic과 stereo viewing을 사용한다.

항공사진은 일반적으로 electornic sensing device에서 찍힌 사진보다 더 spectral resolution이 안좋기 때문에 (반대로 spatial resolution이 좋음) sepctral information보다 spatial detail이 더 중요할 때 유용하게 쓰일 수 있다. vertical photogrpah에서 보이는 지형이 매우 잘 이해가 될 수 있고 매우 정확한 측정이 다양한 분야에서 가능하다. (지질학, forestry(산림), mapping etc) 사진으로부터 무언가를 측정하는 분야를 photogrammetry라고 부르고 aerial photograph의 시작부터 광범위하게 수행되어 왔다. 사진은 사람에 의해 해석되는게 대부분이다.(흔히 stereoscopically(입체적)으로 보는 경우)

Multiband photography는 다양한 spectral range에서 동시에 사진의 대한 정보를 얻기 위해 서로 다른 film-filter를 사용한다. 이런 카메라의 장점은 discrete(이산적인)한 파장 범위 안에서 에너지가 분리되어 기록될 수 있다는 것이고 때문에 다양한 특징을 식별하고 분리할 수 있다. 그러나 이러한 여러 사진(?)의 동시분석은 문제가 될 수 있다. electromagnetic radiation을 전기신호로 저장하는 Digital camera는 필름을 사용하는 카메라와 상당히 다르다. 필름을 사용하는 대신에 격자로된 CCD(charge-coupled devices) 배열을 사용하고 각각의 CCD는 electromagnetic radiation에 개별적으로 반응한다. (하나의 CCD에 여러 photosite가 들어있는거 아니었나?) CCD의 표면에 닿은 에너지는 전기적인 신호를 만들어내고 이것은 ground area의 brightness(밝기)의 양의 비율을 나타낸다. 각 spectral band에 있는 digital number는 전하의 크기에 기반하여 각 픽셀에 할당된다. 출력이미지의 디지털 형식은 컴퓨터 환경에서 분석 및 보관될 수 있고 일반적인 임지처럼 hard copy(인쇄)로 출력될 수 있다.

픽셀 사이즈는 보통 512x512sk 2048x2048이라고 한다.

TMI)

우주비행사들은 우리가 흔히 쓰는 카메라로 직접 사진을 찍기도하고 왕복선 화물칸(shuttle's cargo bay)에 탑재된 Large Format Camera(LFC)라는 세련된 카메라를 통해 찍기도 하였다. LFCs는 305mm의 긴 focal length를 가지고 있고 몇백미터의 영역을 커버할 수 있는 높은 퀄리티의 이미지를 찍었다. 이 센서는 passive이기 때문에 태양이 지구를 비출 때, 그리고 구름이나 대기의 다른 요인에 의해 가려지지 않는 상태일 때 촬영이 가능했다. 그리고 RADAR라고 불리는 특별한 active microwave sensor를 이용해 여러 지역을 촬영하기도 했다. RADAR 센서는 낮과 밤에 모두 디테일한 이미지를 찍는 것이 가능하고 그리고 긴 파장 덕분에 구름을 뚫고 보는 것이 가능하다.

uv 영역에서 사진을 찍는 것은 대기 중의 산란과 흡수에 의해 문제가 될 수 있지만 다른 유형의 사진이 그렇게 되지 않을 때(??) 매우 유용할 수 있다. 눈과 얼음 위에 있는 harp seal를 탐지하고 개체 수를 UV 사진을 통해 알아내는 연구를 예로 들어보자. 성체 harp sela은 어두운 털을 가지고 있는 반면에 새끼 harp seal들은 밝은 털을 가지고 있다. 일반적인 panchromatic 이미지에서 성체 seal의 어두운 털은 눈과 얼음을 배경으로 했을 때 눈에 쉽게 보일 수 있지만 어린 seal들은 그렇지 않다. 그러나 성체와 새끼의 털 모두 UV 영역의 에너지를 아주 강하게 흡수한다. 떄문에 두 seal들 모두 UV 이미지에선 매우 검게 보이고 쉽게 검출할 수 있다. 이것을 통해 쉽고 믿을 수 있는 seal 개채 수 모니터링을 매우 넓은 지역에 걸쳐 할 수 있다.

Multispectral Scanning

많은 remote sensor들은 사진을 찍는 방식과는 다르게 좁은 IFOV를 사용하는 센서를 사용하는 scanning system을 사용한다. 이 sensor는 지형을 쓸고 지나가서 표면의 2차원 이미지를 제공해준다. 이 scanning system은 항공기와 인공위성 둘 다 쓰일 수 있고 근본적으로 같은 동작원리를 가지고 있다. scanning system은 multispectral scanner(MSS)라고 불리는 센서를 통해 여러 파장대에서 다양하게 데이터를 수집할 수 있다. multispectral image data를 수집하기 위해 두가지 mode혹은 method를 사용하는데 accross-track scanning과 along-track scanning이다.

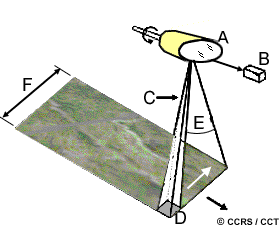

Across-track scanner는 한 줄을 scan한다. 이 line은 센서의 이동방향의 수직 방향으로 스캔한다. 센서에 있는 거울을 회전시켜서 한쪽에서 다른 쪽으로 이동하며 스캔하는 방식이다.(A) platform이 앞으로 나아가면서 연속적인 스캔 결과물들이 결국 2차원 지구표면 이미지를 만들게 된다. 또한 들어오는 반사되거나 방출된 radiation은 여러개의 spectral band로 나뉘어서 독립적으로 기록된다.

각각의 파장의 대한 detector(B)는 스펙트럼 대역의 에너지를 검출하고 전기신호로 바꿔서 디지털 데이터로 변환한다. 센서의 IFOV(C)가 ground resolution cell viewed(D)를 결정하고 이것이 결국 spatial resolution이 된다. angular field of view(E) scan line을 기록하기는데 쓰이고(뭔솔?) 거울의 sweep(?)이 되며 각도로 측정된다. 그리고 swath(F)를 결정한다. Airbone(항공?) scanner는 특히 인공위성과 다르게 큰 각도로(90~120도) 쓸고 지나가는데 왜냐하면 인공위성은 높은 고도에 있어서 조금만(10~20도) sweep해도 많은 지역을 커버할 수 있기 때문이다.

swath의 edge로 갈수록 target과 sensor의 거리가 멀어지기 때문에 ground resolution cell 또한 커지고 지리적 왜곡이 일어나게 된다. 또한 거울이 돌아가는 동안 IFOC가 ground resolution cell을 보는 시간 (dwell time이라고 함)이 짧기 때문에 spatial, spectral, radiometric resolution 설계에 영향을 준다.

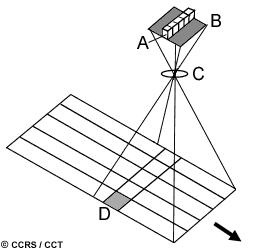

Along-track scanner 또한 날아가는 방향의 수직으로 스캔하면서 연속적인 scan line을 따라 2차원 이미지를 만들지만 scanning mirror을 사용하는 대신 dector의 linear array가 focal plane에 위치하여 렌즈를 통해 데이터를 수집한다. 그리고 비행방향을 따라 밀려진다(??) 이 시스템은 detector의 움직임이 바닥을 따라 밀리는 빗자루의 털과 유사하기 때문에 pushbroom scanner라고 부른다.

각각의 detector는 하나의 ground resolution cell(D)의 에너지를 측정하고 detector들의 IFOV의 크기가 spatial resolution cell의 크기를 결정한다. (하나의 detector가 보는 IFOV와 고도를 곱해서 spatial resolution이 되는건가? -> 그럴듯) 각각의 spectral band를 측정하기 위해서 seperate liner array가 필요하다. (무슨말?) 매 scan line 때마다 각 linear array에 있는 각각의 detector가 에너지를 검출하고 전기적 신호로 샘플링된다.

Along-track scanner는 across-track mirror scanne보다 몇가지 좋은 장점이 있다. detector의 배열은 각각의 detector가 각 ground resolution cell을 더 오랜 기간 동안 바라보도록 해준다. (dwell time) 이것은 더 많은 에너지가 검출될 수 있게 해주고 결국 radiometric resolution을 향상시켜준다. (방사해상도를 bit수가 많아서 좋다고만 생각할게 아니라 그냥 에너지가 많이 들어와도 좋아진다고 외워야 할 것 같다.) dwell tiem의 상승은 더 작은 IFOV와 좁은 bandwidth를 detector가 가질 수 있게 해준다. 그러므로 rediometric resolution의 하락 없이 더 좋은 spatial, spectral resolution을 가질 수 있게 된다. detector들은 보통 solid-state microelectronic device이기 때문에(움직이는 않는 고체?) 더 작고 가볍고 전기가 덜 든다. 또한 움직이지 않기 때문에 더 안정적이고 오래 지속된다. 하지만 array 전체에 걸쳐 균일한 sensitivity(감지정확도? 민감도?)를 달성하기 위해 수천개의 detector를 보정하는 것은 필수적이고 복잡하다.

사용된 스캐닝 시스템이 이 두가지 타입인지 아닌지 여부에 상관없이, 이것은 photographic system에 비해 몇가지 좋은 장점이 있다. photographic system의 spectral range는 visible과 near-infrared 영역으로 제한되는 반면에 MSS system은 thermal infrared 영역까지 확장할 수 있다. 그리고 훨씬 높은 spectral resolution을 가지는 것이 가능하다. Multi-band photographic system은 각각의 spectral band를 위해 여러개의 lens를 사용하고 이것은 This may cause problems in ensuring that the different bands are comparable both spatially and radiometrically and with registration of the multiple images.라는데 뭔소린지 모르겠다. -> 아무튼 안 좋음

Photographic system 광화학?적인 처리를 거친 뒤 평균을 검출하지만 이것은 측정이 어렵고 지속되기도 힘들다. MSS는 전기적으로 기록하기 때문에 에너지 측정도 쉽고 훨씬 큰 숫자도 저장가능. Photographic은 film 보충도 필요하고 사진이 찍힌뒤 뭔가 처리도 필요함. 아 아무튼 안좋음

Thermal Imaging

많은 MSS system이 thermal infrared뿐 아니라 visible과 infrared 영역까지 감지한다. 하지만 지구 표면에서 방출되는 thermal infrared(3μm ~ 15μm)영역의 에너지는 반사되는 에너지를 감지하는 것과는 다르다.

Thermal sensor는 방출된 thermal radiation을 검출하기 위해 표면의 광자와 직접적으로 닿는 것에 민감한 광자 검출기를 사용한다. 검출기는 자체적인 열 방출을 제한하기 위해서 절대 0도에 가깝게 냉각된다. Thermal sensor는 기본적으로 표면의 온도나 target의 열을 측정하기 위해 사용된다.

Thermal imagers는 일반적으로 accross-track scanner이고(왜?) 오직 thermal 영역만 검출한다. Thermal sensor는 하나 이상의 내부 온도 기준을 사용하므로 검출 된 radiion비교가 가능하고 absolute radiant temperature와 연관지을 수 있다. (뭔소리야)

데이터는 일반적으로 film이나 magnetic tape에 기록되고 요즘 sensor의 temperature resolution은 0.1°C이다. 분석을 위해 열영상은 높은 온도는 밝게 낮은 온도는 밝게하는 식의 흑백으로 나타낸다. (아닌데) 해당 지역에서 상대적인 온도차이를 보여주는 이미지로도 대부분의 application에서 충분하다. 절대온도 측정은 계산될 수 있지만 온도 기준의 정확한 보정과 측정과 암튼 뭔가 많은 지식이 필요함

Thermal radiation이 다른 visible radiation 같은 파장보다 파장의 길이가 길기 때문에 대기 중 산란이 적다. 하지만 대기 중 가스의 의한 흡수가 일반적으로 3~5μm와 8~14μm 이렇게 두 영역의 감지를 제한한다. 파장의 길이가 늘어남에 따른 에너지 감소 때문에 thermal sensor는 일반적으로 많은 에너지어서 믿을 만한 측정치를 얻기 위해 높은 IFOV를 가진다. 그러므로 thermal sensor의 spatial resolution은 보통 거칠다.(낮다.) Thermal imagery는 낮이나 밤 모두 얻어질 수 있다.(반사되는게 아니라 지구표면으로부터 방출되기 때문에) 그리고 군사목적의 정찰, 재난 관리, 열손실 모니터링 등 다양하게 사용된다.