Spatial Resolution, Pixel Size, and Scale

원격탐사기구에게 target과의 거리는 얻어지는 정보의 디테일을 결정하고 센서에 의해 이미지화되는 영역의 총 영역을 결정하기 떄문에 중요한 역할을 한다. target으로부터 멀리 떨어질수록 일반적으로 더 많은 영역을 볼 수 있지만 영역의 대한 자세한 정보를 주진 못한다. 우주 왕복선에 있는 우주비행사가 지구를 바라보는 것과 비행기에 있는 내가 지구를 보는 것을 비교해보자. 우주비행사는 한번 눈을 흘깃하기만해도 하나의 주나 나라를 볼 수 있다. 하지만 각각의 집을 구분할 순 없다. 도시 위를 날고 있으면 각각의 빌딩이나 차들을 구분해서 볼 수 있지만 우주비행사보단 훨씬 적은 영역을 보게 될 것이다. 위성 사진과 항공사진은 비슷한 차이가 있다.

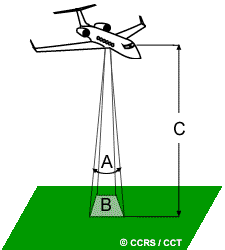

이미지에서 무언가를 구분할 수 있는지 없는지는 spatial resolution에 따라 달라진다. 이것은 발견될 수 있는 가장 작은 물체의 크기를 말한다. passive sensor의 spatial resolution은 주로 Instantaneous Field of View(IFOV)에 의존한다. IFOV는 센서가 지표면을 바라볼 때 생기는 angular cone(각뿔)모양의 영역(A)을 말하고 주어진 고도에서 특정 순간에 센서가 지구표면을 바라볼 때 볼 수 있는 영역의 크기(B)를 결정한다. 보여지는 영역의 크기는 IFOV와 target과의 거리(C)를 곱해서 결졍된다. 땅에서 이 영역을 resolution cell이라고 부르고 센서의 최대 spatial resolution을 결정한다. 물체가 균일하게 잘 검출되려면 물체가 이 resolution cell 크기와 같거나 더 커야 한다. 만약 물체가 resolution cell보다 작다면 cell 안에 있는 모든 객체들의 밝기가 합쳐져 평균이 내져버리므로 해당 물체를 구분할 수 없게 된다. 그러나 작은 물체가 해당 셀 내에서 전체적인 반사도를 지배하고 있는 경우엔 작은 물체도 검출될 수 있다.

이미지는 결국 픽셀단위로 표현되는데 이 픽셀과 spatial resolution을 구분하는 것이 중요하다. 만약 센서가 20m x 20m의 spatial resolution을 가지고 있고 이미지가 full resolution으로 표현된다면 한 픽셀이 20m x 20m을 표현하게 되지만 픽셀 size와 spatial resolution의 크기를 다르게 할 수도 있는데 센서가 20m x 20m로 찍었어도 이 셀 4개를 합쳐 평균내서 한 픽셀로 표현하면 같은 이미지 사이즈 내에서도 더 큰 영역들을 표현할 수 있다. (용량을 줄이기 위해서 이렇게 하는걸수도 있지만 물어보니까 이렇게 하는 이유는 만약 구름이나 다른 것에 의해 지표면이 가려졌을 때 그 부분을 smoothing 해주기 위해 하는걸수도 있다고 해주셨다.) 많은 지구 사진들이 이런 방식으로 되어있다. 오로지 큰 물체만 볼 수 있는 이미지들을 coarse or low resolution이라고 부른다. (그럼 단위가 커질수록 해상도는 낮다고 표현하는 건가?) fine or high resolution 이미지는 작은 객체들도 검출할 수 있다. 군용센서를 예로 들면 매우 작은 객체들도 검출이 가능하게 디자인 되고 그러므로 very fine resolution을 가지고 있다고 볼 수 있다. 일반적으로 질이 좋은 resolution을 가질수록 더 작은 total ground area를 볼 수 있다.

The ratio of distance on an image or map을 축척이라고 한다. 만약 1:100000 비율의 축척이라면 지도의 1cm가 실제로 100000cm를 뜻하는 것이다. small "map-to-ground ratios"를 가지면 small scale이라고 부르고 (1:100000), larger ratios는 large scale이라고 부른다.(1:5000)

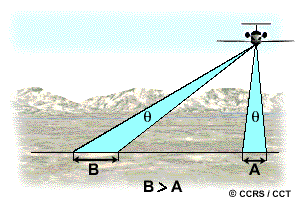

만약 IFOV가 모든 픽셀에 대해서 동일하다면 nadir 포인트가 아닌 곳의 scale을 비교했을 때 nadir 포인트가 더 큰 scale을 가지게 된다. 이것은 spatial resolution이 swath의 중심부터 edge까지 달라진다는 것을 의미한다.

https://natural-resources.canada.ca/maps-tools-and-publications/satellite-imagery-and-air-photos/tutorial-fundamentals-remote-sensing/satellites-and-sensors/spatial-resolution-pixel-size-and-scale/9407#answer2

이 링크에 있는 연습문제를 한번 읽어보는 것을 추천

Spectural Resolution (분광해상도)

물체의 종류와 디테일들은 종종 다른 파장 범위에 대한 반응을 비교해봄으로써 구별될 수 있다. 물과 식물처럼 광범위한 클래스는 매우 넓은 파장 범위를 사용하여 분리될 수 있다. (visible and near infrared) 암석의 종류와 같이 디테일하게 클래스를 구분해야할 땐 이런 broad wavelength range로는 쉽게 구분하지 못할 수 있고 훨씬 좁은 범위의 파장에서 이것들을 구분해야한다. 그러므로 센서는 더 높은 spectral resolution(분광 해상도)을 가져야한다. Spectral resolution은 센서가 얼마나 좁은 범위로 파장을 방출할 수 있는지를 뜻한다. 흑백필름은 거의 모든 visible portion을 하나의 band에 기록하고 이것을 spectral resolution is fairly coarse라고 말한다. 컬러 필름 또한 visible portion에 민감하지만 RGB에 해당하는 파장을 서로 다른 band로 취급하여 기록하기 때문에 spectral resolution이 높다고 할 수 있다. 많은 remote sensing system은 몇개의 wavelength range를 분리해서 에너지를 기록하고 이것을 multi-spectral sensor라고 부른다. 여기서 더 발전된 sensor를 hyperspectral sensor라고 부르는데 이 센서는 visible, near-infrared, mid-infrared 영역을 매우 좁은 수백개의 밴드로 나누어 에너지를 검출한다. 이것은 각각의 좁은 밴드 내에서 서로 다른 객체의 다른 반응을 검출할 수 있게 해준다.

hyperspectral sensor의 단점은 데이터의 용량이 커지고 다루기 힘들어 지고 분석과 설명이 어려워진다는 것이다. (별로 단점은 아닌 것 같은데)

Radiometic Resolution (방사해상도)

픽셀의 배열이 이미지의 구조를 설명하는 것이라면 radiometric characteristics는 이미지에 담기는 실제 정보를 말하는 것이다. 센서나 필름에 의해 이미지가 수집될 떄마다 전지기파 에너지의 양의 대한 민감도가 radiometric resolution을 결정한다. imaging system에서 radiometric resolution이 의미하는 것은 에너지의 매우 작은 변화를 구분할 수 있는 능력을 말하는 것이다. 더 질 좋은 센서일수록 반사되거나 방출된 이미지의 조그마한 변화도 잘 감지할 수 있다.

위 사진에서 왼쪽은 2bit로 에너지를 기록했을 때 사진이고 오른쪽 사진은 8bit로 에너지를 기록했을 떄의 사진이다. 쉽게 설명하면 그냥 값의 표현 범위가 작냐 크냐이다. 이미지 데이터는 양수로 표현되고 의 범위를 가진다. (영어로 2^n을 selected power of 2라고 하네.)

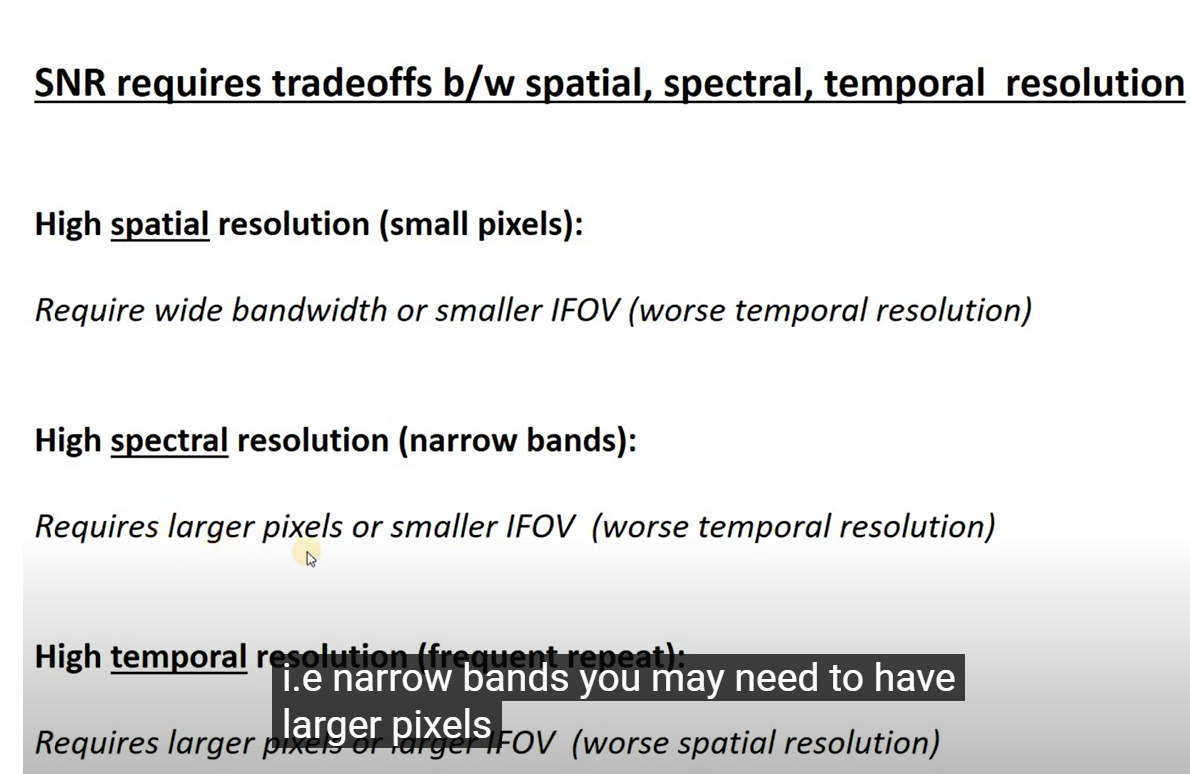

spatial, spectral, radiometric resolutoin은 서로 trade-off 관계라고 한다. (왜지?) 높은 spatial resolution을 가지려면 센서는 낮은 IFOV를 가져야한다. 그러나 이것은 IFOV에 속한 ground resolution cell이 작아짐에 따라 검출되는 에너지의 양을 감소시킨다. 이것은 radiometric resolution 감소를 일으킨다. 검출되는 에너지의 양을 spatial resolution의 감소 없이 증가시키려면 특정 채널 혹은 band의 범위를 더 넓게 해야한다. 하지만 안타깝게도 이것은 sepctral resolution 감소를 일으킨다. 반대로 더 거친(낮은해상도의)spatial resolution을 사용하면 더 좋은 radiometric과 spectral resolution을 가질 수 있게 된다. 그러므로 이 세가지 타입의 해상도는 요구되는 기능과 목적에 따라 균형을 이뤄야한다. -> radiometric resolution이 감소하는 이유는 그냥 외워야 될 것 같다. 잘 이해가 안간다.

-> 생각해보면 검출되는 에너지의 양이 절대적으로 적어지면 0,1,2,3 이렇게 검출하는 센서가 있다고 했을 때 0.1, 0.2 이런 변화를 그냥 0으로 퉁치기 때문에 radiometric resolution이 낮아진다는 의미인듯

밴드가 가지는 파장의 범위가 작을수록 받는 에너지의 양이 줄어들어서 공간해상도가 낮아진다. (공간 해상도와 분광해상도의 trade-off)

이것을 아래 링크의 내용대로 좀 더 자세히 설명해보자면 결국 signal to noise ratio 때문이다. 더 많은 photosite를 넣으면 각각의 photosite에 들어가는 에너지의 양은 계속해서 줄어들것이다. 또한 하나의 photosite에서 에너지는 각 band에 맞게 또 쪼개져야 하기 때문에 에너지는 더더욱 줄어든다. 그리고 sensor 주변에는 계속해서 dark noise(암전류)라는 노이즈가 계속 들어오고 있는데 이것은 어쩔 수 없는 물리적 현상이다. 때문에 이 noise의 에너지보다 더 많은 양의 반사되는 에너지가 들어와야 이것이 noise가 아닌 우리가 원하는 에너지라는 것을 알 수 있다. 이런 이유 때문에 photo-site의 양을 무한정 늘릴 수 없는 것이다. 만약 그럼에도 늘리고 싶다면 가능한 방법 중 하나는 band의 개수를 줄이고 각 band가 갖는 spectrum 범위를 늘려서 하나의 밴드가 갖는 에너지의 크기를 늘리는 것이다. 이렇게 하면 결과적으로 Spectral resolution을 낮추는 것이 되기 떄문에 trade-off가 있다고 하는 것이다.

signal to noise를 높이고 싶다면 더 큰 photosite를 만들어 더 많은 photons(광자?)를 각 photosite가 받게 하면 된다. 이 방법이 아마 제일 좋아보이긴한다. 왜냐하면 다른 resolution에 영향을 주지 않기 때문이다.(아마?) 센서의 크기가 좀 커질 것 같다.

두번째 방법은 더 큰 ground pixel을 가지는 것이다. ground pixel은 하나의 photosite(pixel)이 바라보는 지구 표면의 영역이다. 이걸 크게 한다는건 결국 한 픽셀이 더 크게 한 영역을 뭉쳐서 보므로 spatial resolution의 하락을 의미한다.

그리고 위에서 말한 bandwidth를 늘리는 것도 방법이다.

https://www.youtube.com/watch?v=kY7wsSeIkMY

IFOV가 작아질 때 temporal resolution이 작아지는 이유는 단위 시간 당 살펴보는 영역이 작기 때문에 모든 영역을 훑고 다시 오기까지(극궤도 위성일때) 오래걸린다는 말인 것 같다.

Temporal Resolution

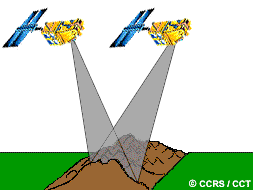

Temporal Resolution은 revisit period와 같은 의미이다. 똑같은 지역을 똑같은 앵글에서 다시 찍는데 걸리는 시간을 말한다. 하지만 인접한 orbit(pass를 뜻하는듯?)에서 swaths가 어느정도 겹치고 이 겹치는 영역은 위도가 올라갈수록 커진다. 그래서 어떤 인공위성은 두 pass가 1일에서 5일 사이 정도일 때 서로 다른 pass일지라도 똑같은 영역을 찍는 것이 가능하다. 따라서 실질적인 temporal resolution은 인공위성/센서의 능력과 swath overlap, 위도를 포함한 다양한 요소에 의해 달라질 수 있다.

다른 시간대에서 동일한 지역의 사진을 수집하는 능력은 remote sensing data를 적용하는데 중요한 요소 중 하나다. target의 대한 스펙트럼 반응이 시간에 따라 달라질 수 있기 때문이다. 그리고 이러한 변화는 multi-temporal image를 비교하고 수집함으로써 발견될 수 있다. 예를 들어 growing season(식물들이 왕성하게 자라는 시기)에는 모든 식물종들이 계속해서 자라는 상태이다. 식물들의 감지하기 힘든 변화를 잘 모니터링하기 위한 능력은 언제 그리고 얼마나 자주 이미지를 찍느냐에 달려있다. 계속해서 이미지를 다른 시간대에 찍음으로써 자연적으로 발생하는 식생의 변화나 홍수인지 아니면 인간의 의해 유발됐는지(도시개발이나 사막화)등 지구표면에서 일어나는 변화를 모니터링할 수 있다.

time factor는 다음과 같은 상황에서 중요하다.

- 지속적인 구름으로 인해 지구표현이 unclear할 때 (종종 열대지방에서 일어남)

- 짧은 시간 동안 갑자기 일어나는 현상들 (홍수, oil slicks(기름유출인가?))

- 다양한 시간대의 비교가 필요한 경우 (산림병(?)이 올해에서 내년으로 확산되는지)

- 유사한 target들을 구분할 수 있는 시간의 따른 the changing appearance(형상의 변화)를 구별해야할 때