지도학습 중에 앙상블(Ensemble)의 기본 알고리즘으로 사용하는 일반적인 ML 모델은 결정 트리이다. 앙상블은 예측성능이 떨어지는 알고리즘을 결합해 확률적 보완과 오류가 발생한 부분에 가중치를 계속 업데이트하면서 예측 성능을 향상시킨다. 이에 결정트리가 약한 학습기에 적합하다.

결정 트리란??

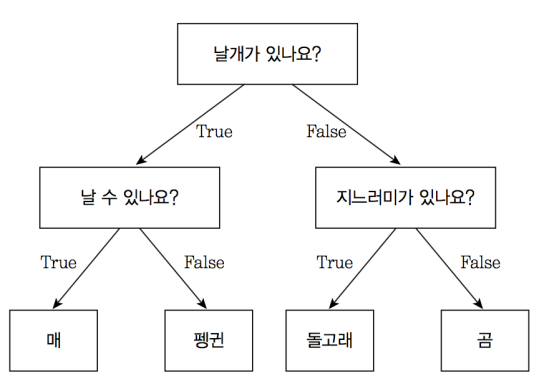

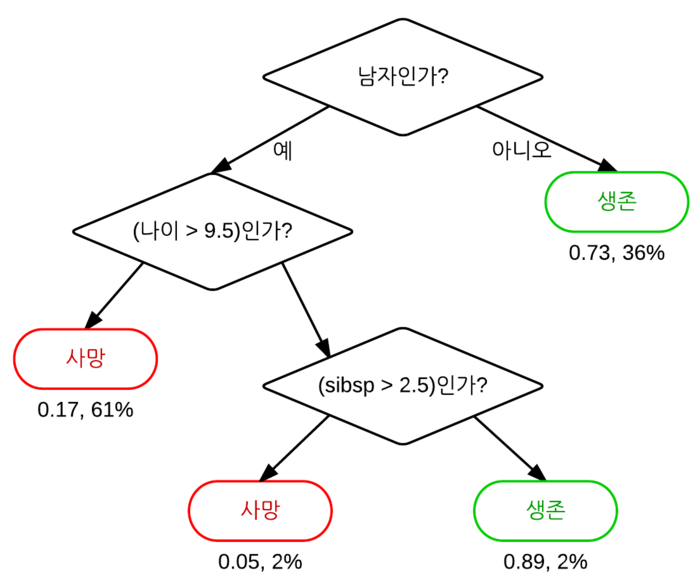

ML 알고리즘 중 직관적으로 이해하기 쉬운 알고리즘이다. 위에 그림만 봐도(가장 간단한 예시지만) 어떻게 알고리즘이 진행되는지 한눈에 알기 쉽다. 위 그림처럼 결정 트리는 특정 규칙을 따라서 레이블을 분류하는 모델이다. 이 규칙을 어떤 기준으로 만들어야 가장 효율적인 분류가 될 것인가가 이 모델의 성능을 좌우한다.

만약 규칙이 많아지고 모델이 복잡해진다면(트리의 깊이가 깊어진다면) 과적합이 발생하기 쉽다.

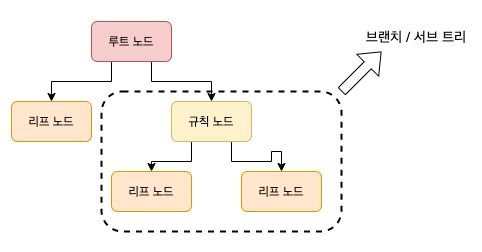

구조

- 루트 노드 : 가장 최상단 노드.

- 규칙 노드 : 레이블을 분류하기 위한 규칙 노드. 가능한 적은 리프 노드로 높은 예측 정확도를 가지려면 데이터를 분류할 때 최대란 많은 데이터 세트가 해당 분류에 속하게 규칙이 정해져야 한다.

- 리프 노드 : 말단 노드. 여기에 결정된 분류값이 존재.

- 브랜치/서브 트리 : 새로운 규칙 조건마다 규칙 노드 기반의 서브 트리 생성.

정보의 균일도

- 정보 이득 :

엔트로피를 기반으로 한다.엔트로피는열역학에서 배웠듯이 혼잡도를 의미한다. 만약 특정 집합 안에 서로 다른 값이 섞여 있으면 엔트로피가 높고, 아니라면 낮다.정보 이득은 1-엔트로피이다.

결정트리는 정보 이득이 높은 속성을 기준으로 분할한다. - 지니 계수 : 경제학에서 불평등 지수를 나타낼 때 사용하는 계수. 머신러닝에서 지니계수가 낮을수록 데이터 균일도가 높다고 해석한다. 사이킷런의

DecisionTreeClassifier은 지니계수를 이용하여 데이터 세트를 분할한다.

결정 트리 과정

.jpg)

결정 트리 특징

- 정보의

균일도를 기반으로 하여 알고리즘이 쉽고 직관적이다. - 규칙이 명확하고, 알고리즘 과정을

시각화로도 표현이 가능하다. - 정보의

균일도만 신경쓰면 되므로 특별한 경우를 제외하고 feature의 스케일링, 정규화 같은 전처리 작업이 필요 없다. 아마 인코딩은 해야할 듯. - 과적합으로 정확도가 급격히 덜어진다. 피처가 많고 균일도가 다양하게 존재할수록 트리의 깊이가 커지고 복잡해진다.

하이퍼 파라미터

min_samples_split

- 노드를 분할하기 위한 최소한의 샘플 데이터 수로 과적합 제어에 사용.

- default는 2이다. 작게 설정할수록 분할되는 노드가 많아져 과적합 가능성 증가.

min_samples_leaf

- 말단 노드가 되기위한 최소한의 샘플 수

- 과적합 제어 용도. 비대칭적 데이터의 경우 특정 클래스의 데이터가 극도로 작을 수 있어 이 경우에는 작게 설정.

max_features

- 최적의 분할을 위해 고려할 최대 feature 개수. default는 None으로 데이터 세트의 모든 feature을 사용하여 분할.

- int로 지정 시 대상 feature 개수, float로 지정 시 전체 feature중 대상 feature의 퍼센트

- sqrt는 전체 feature중 제곱근 값.

- auto는 sqrt와 동일

- log는 전체 featur을 log2()로 선정

max_depth

- 트리의 최대 깊이 지정

- default는 None. 이는 완벽히 클래스 결정값이 될때 까지 깊이를 계속 키우거나 노드가 가지는 데이터 개수가

min_samples_split보다 작아질 때 까지 계속 분할 - 깊이가 깊어지면

min_samples_split설정대로 최대 분할하여 과적합할 수 있으므로 적당한 값으로 제어.

max_leaf_nodes

- 말단 노드 최대 개수

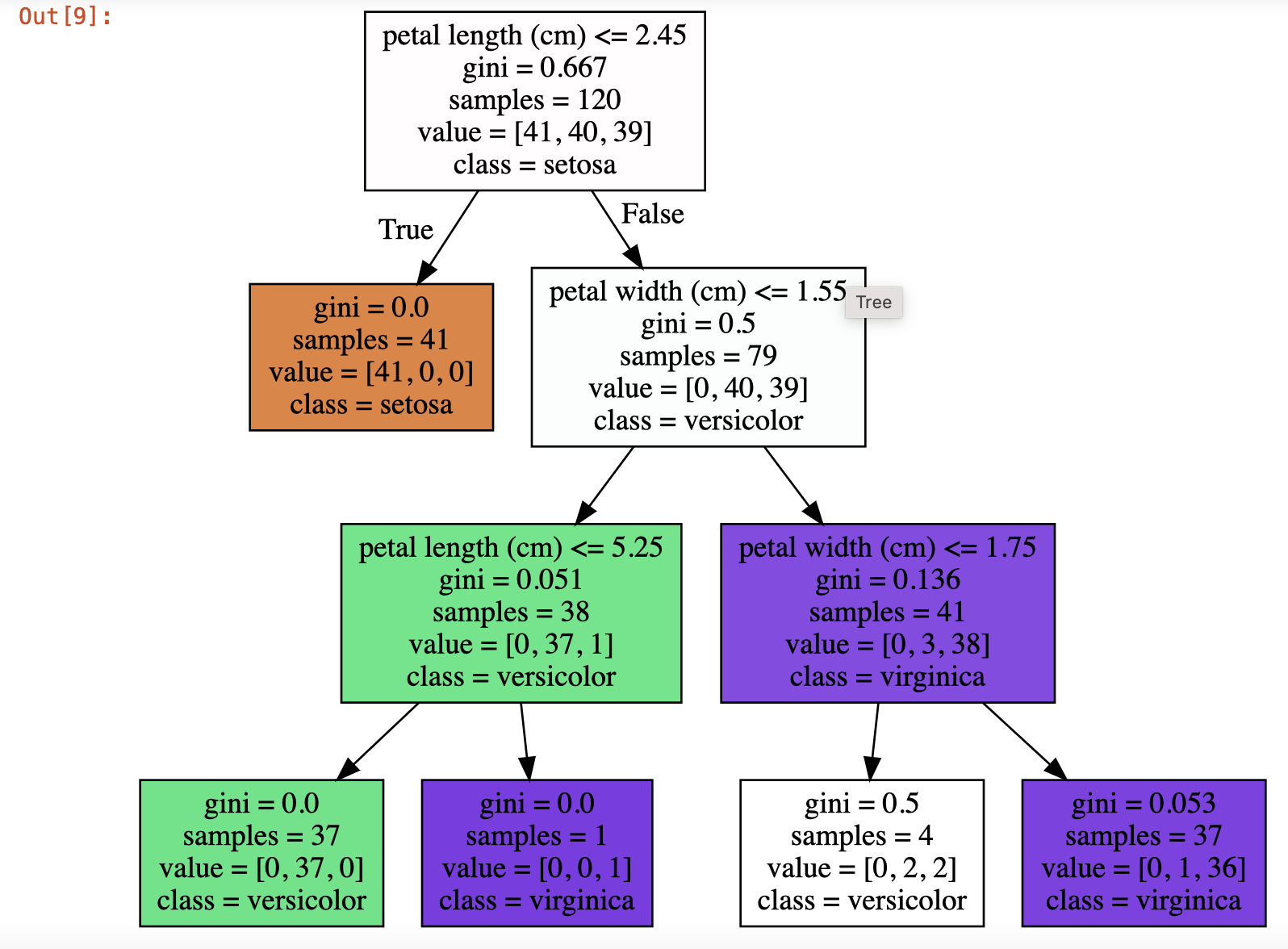

결정 트리 시각화

결정 트리를 시각화하기 위해 Graphviz를 사용한다. 이 애플리케이션은 결정 트리 시각화 외에 Process Mining을 통해 찾은 workflow를 방향성 있는 네트워크 형태를 시각화할 수 있다.

윈도우 환경에서 설치는 좀 복잡한데, 맥북에서는 일단 간단하게

pip install graphviz

brew install graphviz를 통해 설치한다.

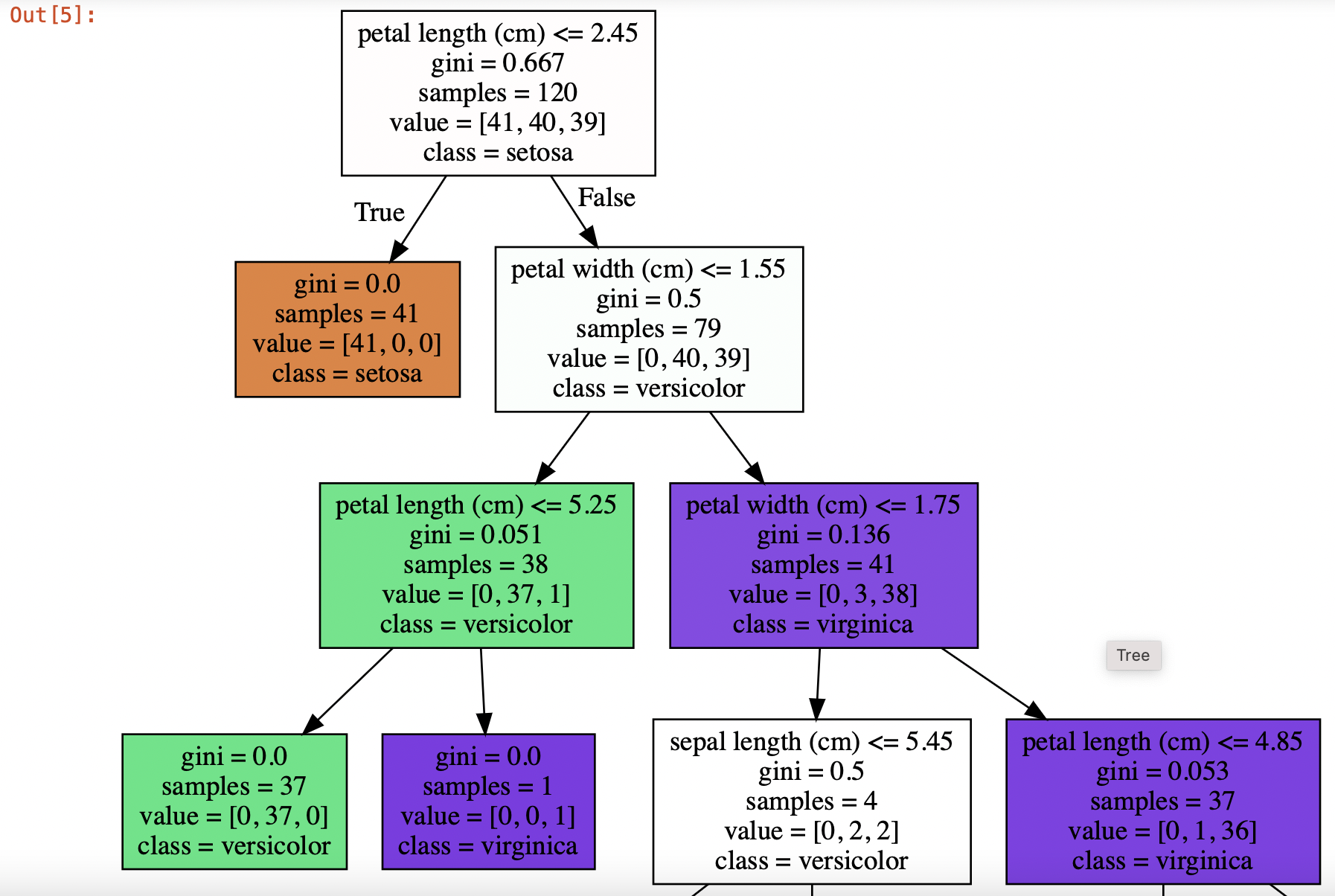

이제 설치가 끝났으면 본격적으로 iris 데이터로 시각화를 해보자!

from sklearn.tree import DecisionTreeClassifier

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

import warnings

warnings.filterwarnings('ignore')

import numpy as np

import pandas as pd

dt_clf = DecisionTreeClassifier(random_state=156)

iris_data=load_iris()

x_train, x_test, y_train, y_test = train_test_split(iris_data.data, iris_data.target, test_size=0.2, random_state=11)

dt_clf.fit(x_train, y_train)우선 iris데이터를 생성하고 DecisionTreeClassifier객체를 생성, 그리고 데이터 세트를 train, test 세트로 분리한다.

from sklearn.tree import export_graphviz

export_graphviz(dt_clf, out_file="tree.dot", class_names=iris_data.target_names,\

feature_names=iris_data.feature_names, impurity=True, filled=True)export_graphviz를 통해 tree.dot이라는 출력파일을 만든다. 그리고 이제 이 출력파일을 불러와 시각화로 나타내면 끝!

import graphviz

with open("tree.dot") as f:

dot_graph = f.read()

graphviz.Source(dot_graph)

(맥 화면이 시각화가 작아서 짤렸다...)

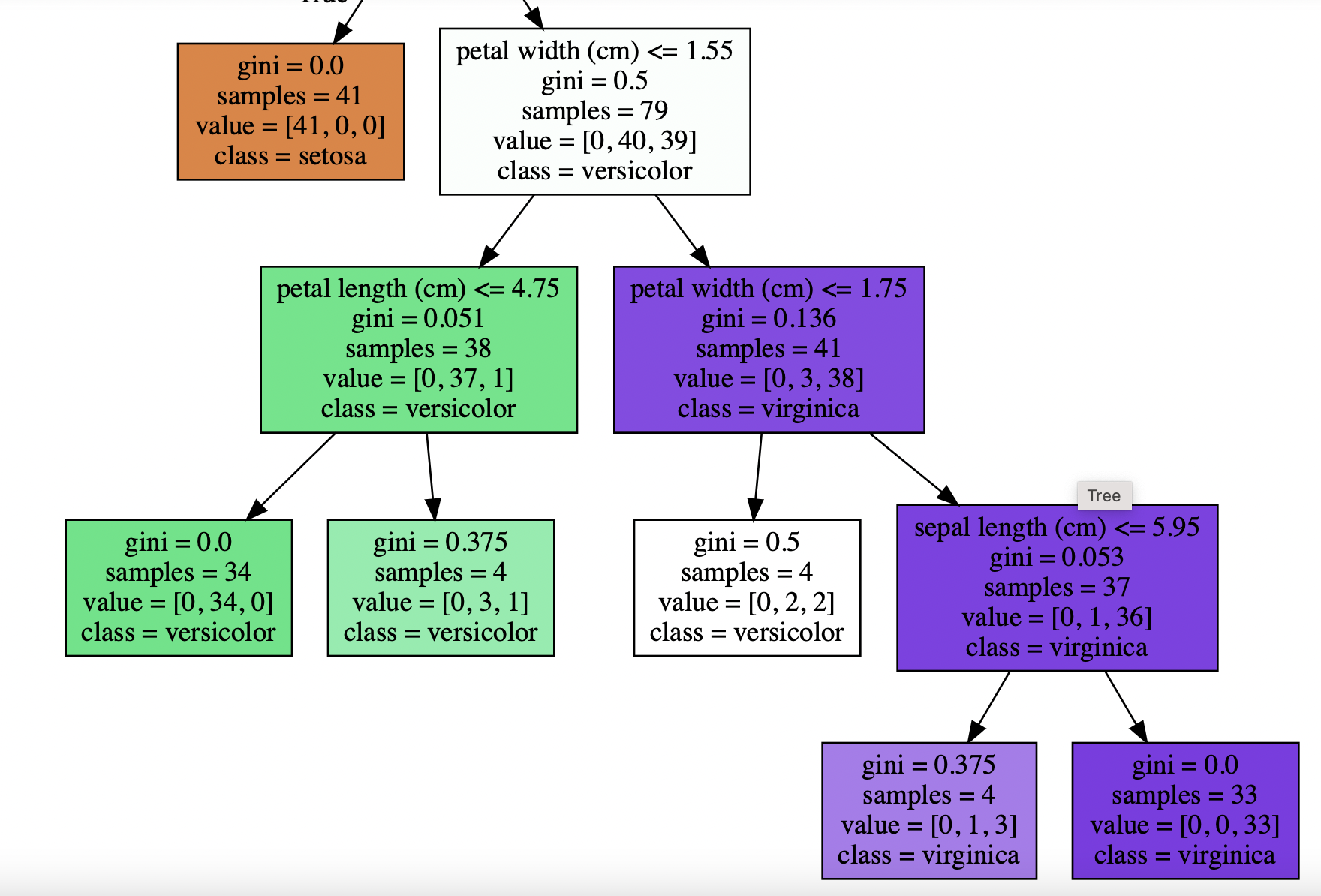

max_depth 설정

max_depth = 3로 의사결정분류를 재설정해봤다.

(엄청 간단해졌다.)

min_sample_split 설정

이번엔 min_sample_split = 4이다.

.jpg)

붉은 상자를 자세히 보면 Sample가 3개이므로 서로 다른 값이 있어도 분리되지 않는다.

min_samples_leaf 설정

이번엔 min_sample_leaf = 4이다.

Sample이 4이하면 리프노드가 되어 지니계수가 크더라도 더이상 분류가 되지 않아 브랜치 노드가 줄어들고 결정트리 모델이 간결해진다.

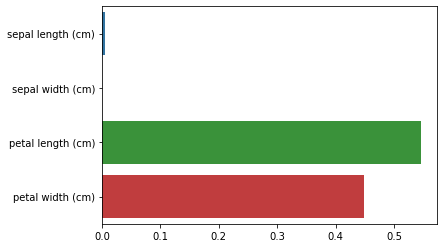

feature_importances

결정 트리는 균일도에 기반해 어떠한 속성을 어떤 규칙 조건으로 선택하느냐가 중요하다. 중요한 몇 개의 feature가 명확한 규칙 드리를 만드는데 크게 기여하며, 모델을 좀 더 간결하고 이상치에 강한 모델을 만들 수 있다.

feature_importances는 ndarray 형태로 값을 반환하며 feature 순서대로 값이 할당된다.

import seaborn as sns

%matplotlib inline

print('Feature importances:\n{0}'.format(np.round(dt_clf.feature_importances_, 3)))

for name, value in zip(iris_data.feature_names, dt_clf.feature_importances_):

print('{0} : {1:.3f}'.format(name, value))

sns.barplot(x=dt_clf.feature_importances_, y=iris_data.feature_names)

그래프를 보았을 때 Petal length(cm)이 가장 중요한 feature이다.

결정 트리 Overfitting

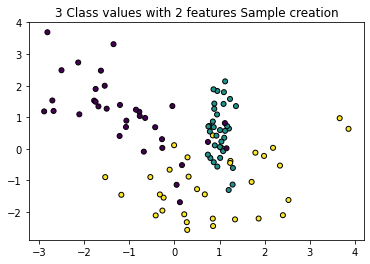

시각화를 통해 결정트리가 데이터를 분류할 때 일으키는 과적합을 직접 봐보자. 이번엔 임의의 데이터를 가지고 코드를 짜보려고 한다.

from sklearn.datasets import make_classification

import matplotlib.pyplot as plt

%matplotlib inline

# 임의 데이터 생성(features : 2개, classes : 3가지)

plt.title("3 Class values with 2 features Sample creation")

x_features, y_labels = make_classification(n_features=2, n_redundant=0, n_informative=2, \

n_classes=3, n_clusters_per_class=1, random_state=0)

# x축은 첫번째 feature, y축은 두번째 feature로 시각화

plt.scatter(x_features[:, 0], x_features[:,1], marker='o', c=y_labels, s=25, edgecolor='k')

- feature : 2개

- class : 3가지

의 임의의 랜덤 데이터를 생성해보았다. 결정 트리의 과적합을 알아보기 위해 처음엔 하이퍼 파라미터 튜닝없이 순수 결정 트리로 분류해보자.

from sklearn.tree import DecisionTreeClassifier

dt_clf = DecisionTreeClassifier().fit(x_features, y_labels)결정 트리 모델에 해당 데이터를 학습시켰다. 그러면 이번엔 등고선 시각화를 통해 위의 데이터가 어떻게 분류되는지 직접 눈으로 볼것이다.

def visualize_boundary(model, x, y):

fig, ax = plt.subplots()

ax.scatter(x[:,0], x[:,1], c=y, s=25, cmap='rainbow', edgecolor='k',

clim=(y.min(), y.max()), zorder=3)

ax.axis('tight') # tight : 모든 데이터를 볼 수 있도록 축의 범위를 크게 설정

ax.axis('off') # off : 축과 라벨을 끈다.

xlim_start, xlim_end = ax.get_xlim() # 축의 범위를 추출

ylim_start, ylim_end = ax.get_ylim()

model.fit(x, y)

# 격자행렬 생성

xx, yy = np.meshgrid(np.linspace(xlim_start, xlim_end, num=200), np.linspace(ylim_start, ylim_end, num=200))

# 모델 예측, 격자 행렬 좌표값을 모델로 예측하여 contourf의 높이에 해당하는 z 구한다.

z = model.predict(np.c_[xx.ravel(), yy.ravel()]).reshape(xx.shape)

n_classes = len(np.unique(y))

# 등고선 그리기 함수

contours = ax.contourf(xx, yy, z, alpha=0.3,

level=np.arange(n_classes + 1) - 0.5,

cmap='rainbow', clim=(y.min(), y.max()),

zorder=1)

visualize_boundary(dt_clf, x_features, y_labels)

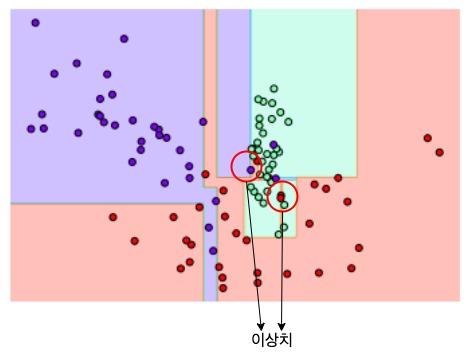

하이퍼 파라미터 튜닝없이 분류 결과 이상치까지 분류하기 위해 결정 기준이 많아졌다. 결국 모델이 복잡해졌다는 결과이다. 이런 복잡한 모델은 학습 데이터와 특성이 조금만 다른 데이터 세트로 예측을 하면 정확도가 떨어진다.

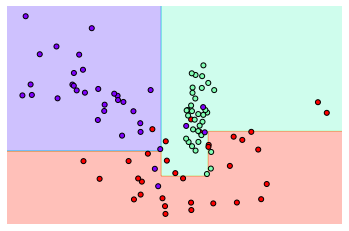

이번엔 min_samples_leaf=6으로 설정하여 기준 경계를 살펴보자.

하이퍼 파라미터를 튜닝하니 이상치에 크게 반응하지 않는 것으로 밝혀졌다. 이런 모델이 복잡한 모델보다 더 성능이 뛰어나다.